LMQL

Übersicht von LMQL

Was ist LMQL?

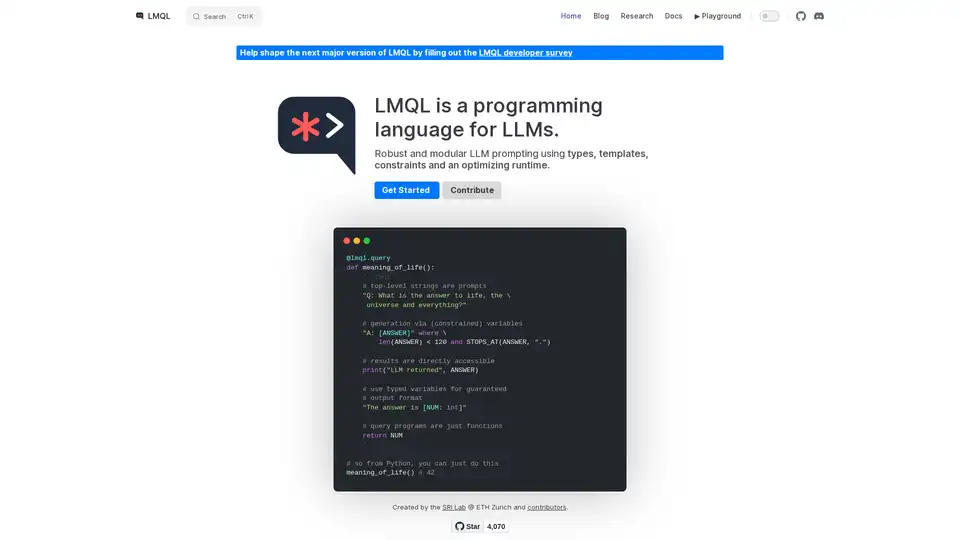

LMQL (Language Model Query Language) ist eine Programmiersprache, die speziell für die Interaktion mit großen Sprachmodellen (LLMs) entwickelt wurde. Sie bietet einen robusten und modularen Ansatz für das LLM-Prompting, der Typen, Vorlagen, Constraints und eine optimierende Laufzeit nutzt, um zuverlässige und kontrollierbare Ergebnisse zu gewährleisten. LMQL zielt darauf ab, die Lücke zwischen traditionellen Programmierparadigmen und der probabilistischen Natur von LLMs zu schließen und Entwicklern so zu ermöglichen, anspruchsvollere und besser vorhersagbare AI-Anwendungen zu erstellen.

Wie funktioniert LMQL?

LMQL funktioniert, indem es Entwicklern ermöglicht, Prompts als Code zu definieren, wobei Variablen, Constraints und Kontrollfluss einbezogen werden. Dieser Ansatz steht im Gegensatz zum traditionellen String-basierten Prompting, das weniger strukturiert und schwieriger zu verwalten sein kann. Hier ist eine Aufschlüsselung der wichtigsten LMQL-Funktionen:

- Typisierte Variablen: Mit LMQL können Sie Variablen mit bestimmten Datentypen (z. B.

int,str) definieren, um sicherzustellen, dass die Ausgabe des LLM dem erwarteten Format entspricht. Diese Funktion ist entscheidend für die Erstellung von Anwendungen, die strukturierte Daten benötigen. - Vorlagen: LMQL unterstützt Vorlagen und ermöglicht so die Erstellung wiederverwendbarer Prompt-Komponenten. Vorlagen können mit Variablen parametrisiert werden, wodurch die Generierung dynamischer Prompts vereinfacht wird.

- Constraints: Mit LMQL können Sie Constraints für die Ausgabe des LLM festlegen, z. B. eine maximale Länge oder bestimmte Schlüsselwörter. Diese Constraints werden von der LMQL-Laufzeit erzwungen, um sicherzustellen, dass die Antwort des LLM Ihren Anforderungen entspricht.

- Verschachtelte Abfragen: LMQL unterstützt verschachtelte Abfragen, sodass Sie Ihre Prompts modularisieren und Prompt-Komponenten wiederverwenden können. Diese Funktion ist besonders nützlich für komplexe Aufgaben, die mehrere Interaktionsschritte mit dem LLM erfordern.

- Mehrere Backends: LMQL kann Ihren LLM-Code automatisch über mehrere Backends portierbar machen. Sie können mit einer einzigen Codezeile zwischen ihnen wechseln.

Beispiel

@lmql.query

def meaning_of_life():

'''lmql

# top-level strings are prompts

"Q: What is the answer to life, the \

universe and everything?"

# generation via (constrained) variables

"A: [ANSWER]" where \

len(ANSWER) < 120 and STOPS_AT(ANSWER, ".")

# results are directly accessible

print("LLM returned", ANSWER)

# use typed variables for guaranteed

# output format

"The answer is [NUM: int]"

# query programs are just functions

return NUM

'''

## so from Python, you can just do this

meaning_of_life() # 42

Wie verwende ich LMQL?

Installation:

Installieren Sie LMQL mit pip:

pip install lmqlAbfragen definieren:

Schreiben Sie LMQL-Abfragen mit dem

@lmql.query-Decorator. Diese Abfragen können Prompts, Variablen und Constraints enthalten.Abfragen ausführen:

Führen Sie LMQL-Abfragen wie reguläre Python-Funktionen aus. Die LMQL-Laufzeit übernimmt die Interaktion mit dem LLM und erzwingt die angegebenen Constraints.

Auf Ergebnisse zugreifen:

Greifen Sie über die in Ihrer LMQL-Abfrage definierten Variablen auf die Ausgabe des LLM zu.

Warum LMQL wählen?

- Robustheit: Die Typen und Constraints von LMQL tragen dazu bei, dass die Ausgabe des LLM zuverlässig und konsistent ist.

- Modularität: Die Vorlagen und verschachtelten Abfragen von LMQL fördern die Wiederverwendung von Code und die Modularität.

- Portabilität: LMQL funktioniert mit mehreren LLM-Backends, sodass Sie problemlos zwischen verschiedenen Modellen wechseln können.

- Ausdrucksstärke: Die Python-Integration von LMQL ermöglicht es Ihnen, die volle Leistung von Python für die Prompt-Erstellung und die Nachbearbeitung zu nutzen.

Für wen ist LMQL geeignet?

LMQL eignet sich für Entwickler, die AI-Anwendungen erstellen möchten, die eine präzise Kontrolle über das LLM-Verhalten erfordern. Es ist besonders nützlich für Aufgaben wie:

- Datenextraktion: Extrahieren strukturierter Daten aus Text.

- Codegenerierung: Generieren von Code basierend auf Beschreibungen in natürlicher Sprache.

- Chatbots: Erstellen von Chatbots mit vorhersagbaren und konsistenten Antworten.

- Frage beantworten: Beantworten von Fragen auf der Grundlage von strukturiertem Wissen.

Durch die Verwendung von LMQL können Entwickler zuverlässigere, modularere und portablere AI-Anwendungen erstellen, die die Leistungsfähigkeit von LLMs nutzen.

Der beste Weg, LMQL zu verwenden, ist, die Dokumentation zu lesen und mit einem einfachen Beispiel zu beginnen, dann die Komplexität der Prompts schrittweise zu erhöhen, um sie an Ihre Bedürfnisse anzupassen.

Mit LMQL Verwandte Tags