DeepSeek v3

Übersicht von DeepSeek v3

DeepSeek v3: Ein fortschrittliches KI-Sprachmodell

Was ist DeepSeek v3?

DeepSeek v3 stellt einen bedeutenden Fortschritt im Bereich der KI-Sprachmodelle dar. Mit beeindruckenden 671 Milliarden Gesamtparametern, von denen 37 Milliarden für jedes Token aktiviert werden, nutzt es eine innovative Mixture-of-Experts (MoE)-Architektur, um in einer Vielzahl von Benchmarks eine erstklassige Leistung zu erzielen und gleichzeitig eine effiziente Inferenz zu gewährleisten.

Hauptmerkmale von DeepSeek v3

- Fortschrittliche MoE-Architektur: DeepSeek v3 verwendet eine innovative Mixture-of-Experts-Architektur mit insgesamt 671 Milliarden Parametern, wobei 37 Milliarden Parameter für jedes Token aktiviert werden, um eine optimale Leistung zu erzielen.

- Umfangreiches Training: DeepSeek v3 wurde mit 14,8 Billionen hochwertigen Token vortrainiert und demonstriert umfassendes Wissen in verschiedenen Bereichen.

- Überlegene Leistung: DeepSeek v3 erzielt in mehreren Benchmarks erstklassige Ergebnisse, darunter Mathematik, Programmierung und mehrsprachige Aufgaben.

- Effiziente Inferenz: Trotz seiner Größe verfügt DeepSeek v3 dank innovativem Architekturdesign über effiziente Inferenzfähigkeiten.

- Langes Kontextfenster: Mit einem 128K-Kontextfenster kann DeepSeek v3 umfangreiche Eingabesequenzen effektiv verarbeiten und verstehen.

- Multi-Token-Vorhersage: DeepSeek v3 verwendet eine fortschrittliche Multi-Token-Vorhersage für verbesserte Leistung und Inferenzbeschleunigung.

Wie funktioniert DeepSeek v3?

DeepSeek v3 verwendet eine Mixture-of-Experts (MoE)-Architektur. Das bedeutet, dass nicht alle 671 Milliarden Parameter für jede Aufgabe verwendet werden, sondern intelligent nur die relevantesten 37 Milliarden Parameter für jedes Eingabe-Token aktiviert werden. Dieser Ansatz ermöglicht es dem Modell, hohe Genauigkeit und Leistung zu erzielen und gleichzeitig recheneffizient zu bleiben.

Wie man DeepSeek v3 verwendet

- Wählen Sie Ihre Aufgabe: Wählen Sie aus verschiedenen Aufgaben, darunter Texterstellung, Codevervollständigung und mathematisches Denken. DeepSeek v3 zeichnet sich in mehreren Bereichen aus.

- Geben Sie Ihre Anfrage ein: Geben Sie Ihre Eingabeaufforderung oder Frage ein. Die fortschrittliche Architektur von DeepSeek v3 gewährleistet qualitativ hochwertige Antworten mit seinem 671B-Parametermodell.

- Erhalten Sie KI-gestützte Ergebnisse: Erleben Sie die überlegene Leistung von DeepSeek v3 mit Antworten, die fortschrittliches Denken und Verständnis demonstrieren.

Leistung und Benchmarks

DeepSeek v3 erzielt in mehreren Benchmarks erstklassige Ergebnisse und demonstriert seine überlegenen Fähigkeiten in verschiedenen Bereichen. Es zeichnet sich aus in:

- Mathematik: Lösen komplexer mathematischer Probleme.

- Programmierung: Generieren und Verstehen von Code.

- Argumentation: Demonstrieren fortgeschrittener logischer Denkfähigkeiten.

- Mehrsprachige Aufgaben: Verarbeiten und Generieren von Texten in mehreren Sprachen.

DeepSeek v3 übertrifft andere Open-Source-Modelle und erzielt eine Leistung, die mit führenden Closed-Source-Modellen in verschiedenen Benchmarks vergleichbar ist.

Technische Details

- Architektur: Mixture-of-Experts (MoE)

- Gesamtparameter: 671B

- Aktivierte Parameter pro Token: 37B

- Kontextfenster: 128K

- Trainingsdaten: 14,8 Billionen Token

Bereitstellungsoptionen

DeepSeek v3 unterstützt verschiedene Bereitstellungsoptionen, darunter:

- NVIDIA GPUs

- AMD GPUs

- Huawei Ascend NPUs

Es unterstützt auch mehrere Frameworks, darunter:

- SGLang

- LMDeploy

- TensorRT-LLM

- vLLM

DeepSeek v3 unterstützt sowohl FP8- als auch BF16-Inferenzmodi und ermöglicht so eine optimale Leistung auf verschiedenen Hardwarekonfigurationen.

FAQ

- Was macht DeepSeek v3 einzigartig? DeepSeek v3 kombiniert eine massive 671B-Parameter-MoE-Architektur mit innovativen Funktionen wie Multi-Token Prediction und Auxiliary-Loss-Free Load Balancing und bietet so eine außergewöhnliche Leistung bei verschiedenen Aufgaben.

- Wie kann ich auf DeepSeek v3 zugreifen? DeepSeek v3 ist über unsere Online-Demo-Plattform und API-Dienste verfügbar. Sie können die Modellgewichte auch für die lokale Bereitstellung herunterladen.

- Bei welchen Aufgaben zeichnet sich DeepSeek v3 aus? DeepSeek v3 demonstriert überlegene Leistung in Mathematik, Programmierung, Argumentation und mehrsprachigen Aufgaben und erzielt in Benchmark-Bewertungen stets Top-Ergebnisse.

- Ist DeepSeek v3 für die kommerzielle Nutzung verfügbar? Ja, DeepSeek v3 unterstützt die kommerzielle Nutzung gemäß den Modelllizenzbedingungen.

- Wie groß ist das Kontextfenster von DeepSeek v3? DeepSeek v3 verfügt über ein 128K-Kontextfenster, sodass umfangreiche Eingabesequenzen für komplexe Aufgaben und Langformatinhalte effektiv verarbeitet und verstanden werden können.

- Wie wurde DeepSeek v3 trainiert? DeepSeek v3 wurde auf 14,8 Billionen vielfältiger und hochwertiger Token vortrainiert, gefolgt von Supervised Fine-Tuning- und Reinforcement Learning-Phasen.

Fazit

DeepSeek v3 stellt einen bedeutenden Fortschritt im Bereich der KI-Sprachmodelle dar und bietet in einer Vielzahl von Aufgaben eine erstklassige Leistung. Mit seiner innovativen Mixture-of-Experts-Architektur, umfangreichen Trainingsdaten und effizienten Inferenzfähigkeiten ist DeepSeek v3 gut positioniert, um Innovationen in verschiedenen Branchen und Anwendungen voranzutreiben. Ob Sie an Codegenerierung, mathematischem Denken oder mehrsprachigen Aufgaben arbeiten, DeepSeek v3 bietet die Leistung und Flexibilität, die Sie für den Erfolg benötigen. Greifen Sie noch heute auf die Online-Demo oder API zu und erleben Sie die Zukunft der KI-Sprachmodelle.

Beste Alternativwerkzeuge zu "DeepSeek v3"

Deep Infra ist eine kostengünstige, skalierbare AI-Inferenz-Plattform mit +100 ML-Modellen wie DeepSeek-V3.2, Qwen und OCR-Tools. Entwicklerfreundliche APIs, GPU-Vermietung und Null-Datenretention.

Testen Sie DeepSeek V3 kostenlos online ohne Registrierung. Dieses leistungsstarke Open-Source-KI-Modell umfasst 671B Parameter, unterstützt kommerzielle Nutzung und bietet unbegrenzten Zugriff über Browser-Demo oder lokale Installation auf GitHub.

mistral.rs ist eine blitzschnelle LLM-Inferenz-Engine, geschrieben in Rust, die multimodale Workflows und Quantisierung unterstützt. Bietet Rust-, Python- und OpenAI-kompatible HTTP-Server-APIs.

Friendli Inference ist die schnellste LLM-Inferenz-Engine, optimiert für Geschwindigkeit und Kosteneffizienz, die GPU-Kosten um 50-90 % senkt und gleichzeitig einen hohen Durchsatz und eine geringe Latenz bietet.

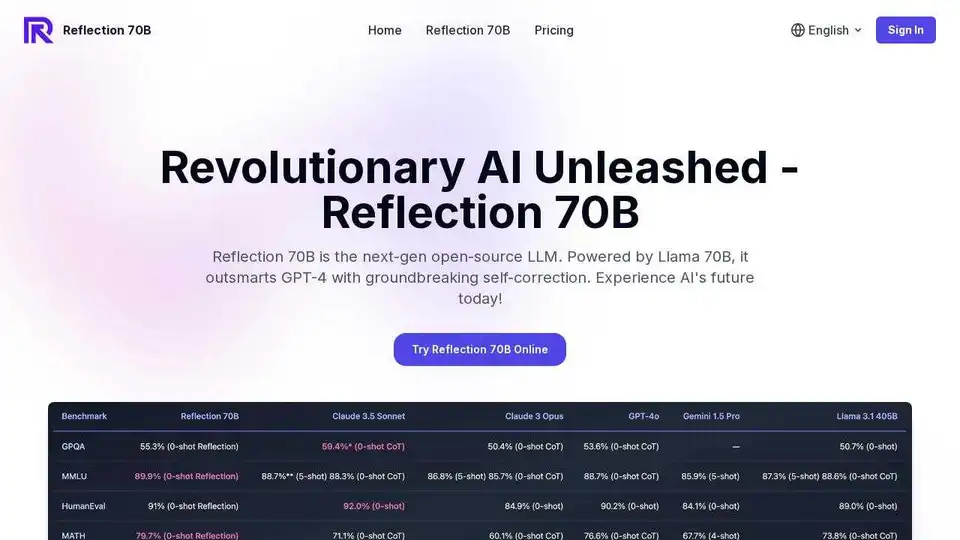

Testen Sie Reflection 70B online, ein Open-Source-LLM, das auf Llama 70B basiert. Übertrifft GPT-4 mit innovativer Selbstkorrektur. Online-Gratis-Testversion verfügbar.

EssayAI ist ein nicht nachweisbarer KI-Essay-Autor, der menschenähnliche Essays generiert und KI-Detektoren umgeht. Es verwendet ein Sprachmodell, das mit Millionen von Essays trainiert wurde, um qualitativ hochwertige, originelle Inhalte bereitzustellen.

Kostenloser Online-Chat Llama 4 Maverick, powered by Meta AI. Entdecken Sie KI-Bildung und laden Sie große Modellcodes herunter. Keine Anmeldung erforderlich.

DeepSeek konzentriert sich auf führende AGI-Modelle. Sie haben mehrere Modelle mit Milliarden von Parametern wie DeepSeek-LLM und DeepSeek-Coder veröffentlicht.

Fetch.ai ist eine Plattform, die die Agentenökonomie ermöglicht und es Benutzern ermöglicht, KI-Agenten zu erstellen, zu entdecken und mit ihnen zu handeln. Sie bietet Tools wie Agentverse zum Erstellen und Erkunden von Agenten und ASI Wallet für den Zugriff auf das ASI-Ökosystem.

punchlines.ai ist ein KI-Comedy-Writing-Partner. Stellen Sie einen Witzaufbau bereit und er generiert die Pointen mithilfe von GPT-Sprachmodellen, die mit Late-Night-Comedy-Monolog-Witzen verfeinert wurden.

Namify ist ein KI-gestützter Business-Name-Generator, der in Sekundenschnelle einzigartige Markennamen und ein kostenloses Logo bietet. Finden Sie einprägsame Namen und prüfen Sie die Domainverfügbarkeit.

EssayAI ist ein unauffindbarer KI-Essay-Schreiber, der zu 100 % menschenähnliche Essays generiert. Umgehen Sie KI-Detektoren wie Turnitin mit Leichtigkeit und steigern Sie die Qualität Ihres Schreibens.

Kostenloser KI-Videochat mit einem lebensechten Avatar. Echtzeit-Videoantworten mit einem realistischen sprechenden Gesicht und natürlicher Stimme. Treffen Sie Ihren KI-Begleiter auf TalkPersona.

Entdecken Sie Vibe Coding, eine Plattform mit KI-Codierungswerkzeugen zur Generierung von Code mithilfe natürlicher Sprache. Erkunden Sie Top-KI-Tools und Expertenanleitungen, um Projekte schneller zu erstellen.