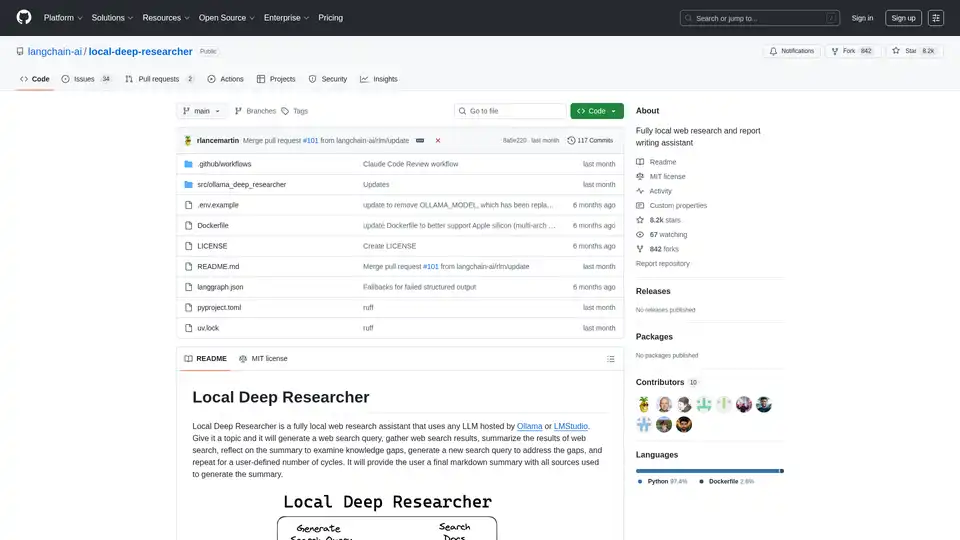

Local Deep Researcher

Übersicht von Local Deep Researcher

Was ist Local Deep Researcher?

Local Deep Researcher ist ein innovativer Open-Source-Web-Forschungsassistent, der vollständig lokal auf Ihrem Gerät läuft. Dieses leistungsstarke Tool nutzt große Sprachmodelle (LLMs) über Ollama oder LMStudio, um umfassende Web-Recherchen durchzuführen und detaillierte Berichte mit korrekten Quellenangaben zu erstellen.

Wie funktioniert Local Deep Researcher?

Das System folgt einem intelligenten iterativen Forschungsprozess:

Forschungszyklus-Prozess:

- Abfrageerstellung: Basierend auf einem vom Benutzer angegebenen Thema generiert das lokale LLM eine optimierte Web-Suchabfrage

- Quellenabruf: Verwendet konfigurierte Suchtools (DuckDuckGo, SearXNG, Tavily oder Perplexity), um relevante Online-Quellen zu finden

- Inhaltszusammenfassung: Das LLM analysiert und fasst die Ergebnisse der Web-Suche zusammen

- Lückenanalyse: Das System reflektiert über die Zusammenfassung, um Wissenslücken und fehlende Informationen zu identifizieren

- Iterative Verfeinerung: Generiert neue Suchabfragen, um identifizierte Lücken zu schließen, und wiederholt den Prozess

- Erstellung des Abschlussberichts: Nach mehreren Zyklen (konfigurierbar durch den Benutzer) erstellt es einen umfassenden Markdown-Bericht mit allen Quellen korrekt zitiert

Kernfunktionen und Fähigkeiten

- Vollständig lokale Ausführung: Alle Verarbeitungen erfolgen lokal, um Datenschutz und Sicherheit zu gewährleisten

- Unterstützung mehrerer LLMs: Kompatibel mit jedem LLM, das über Ollama oder LMStudio gehostet wird

- Flexible Suchintegration: Unterstützt DuckDuckGo (Standard), SearXNG, Tavily und Perplexity-Such-APIs

- Konfigurierbare ForschungsTiefe: Benutzer können die Anzahl der Forschungszyklen festlegen (Standard: 3 Iterationen)

- Strukturierte Ausgabe: Generiert gut formatierte Markdown-Berichte mit korrekten Quellenangaben

- Visuelle Workflow-Überwachung: Integriert mit LangGraph Studio für Echtzeit-Prozessvisualisierung

Technische Anforderungen und Einrichtung

Unterstützte Plattformen:

- macOS (empfohlen)

- Windows

- Linux über Docker

Erforderliche Komponenten:

- Python 3.11+

- Ollama oder LMStudio für lokale LLM-Hosting

- Optionale API-Schlüssel für Premium-Suchdienste

Installation und Konfiguration

Schneller Einrichtungsprozess:

- Klone das Repository von GitHub

- Konfiguriere Umgebungsvariablen in der .env-Datei

- Wähle deinen bevorzugten LLM-Anbieter (Ollama oder LMStudio)

- Wähle die Such-API-Konfiguration

- Starte über LangGraph Studio

Docker-Bereitstellung: Das Projekt umfasst Docker-Unterstützung für containerisierte Bereitstellung, wobei Ollama separat mit korrekter Netzwerkkonfiguration laufen muss.

Kompatibilitätsüberlegungen für Modelle

Das System erfordert LLMs, die strukturierte JSON-Ausgaben erzeugen können. Einige Modelle wie DeepSeek R1 (7B und 1.5B) könnten Einschränkungen im JSON-Modus haben, aber der Assistent enthält Fallback-Mechanismen, um diese Fälle zu handhaben.

Wer sollte Local Deep Researcher nutzen?

Ideale Benutzer umfassen:

- Forscher und Akademiker, die umfassende Literaturübersichten benötigen

- Content-Creator, die gut recherchierte Hintergrundinformationen benötigen

- Studenten, die an Forschungsarbeiten und Aufgaben arbeiten

- Journalisten, die investigative Recherchen durchführen

- Geschäftsfachleute, die Marktforschung und Wettbewerbsanalysen benötigen

- Datenschutzbewusste Benutzer, die lokale Verarbeitung Cloud-basierten Lösungen vorziehen

Praktische Anwendungen und Anwendungsfälle

- Akademische Forschung: Führe Literaturübersichten durch und sammle Quellen für Aufsätze

- Marktanalyse: Recherchiere Wettbewerber und Branchentrends

- Content-Recherche: Sammle Informationen für Blog-Beiträge, Artikel und Berichte

- Due Diligence: Untersuche Themen gründlich mit korrekter Quellen-Dokumentation

- Lernen und Bildung: Erkunde Themen in der Tiefe mit automatisierter Forschungsunterstützung

Warum Local Deep Researcher wählen?

Wichtige Vorteile:

- Vollständiger Datenschutz: Deine Recherchethemen und Daten verlassen nie dein lokales Gerät

- Kosteneffizient: Keine API-Kosten für grundlegende Suchfunktionen

- Anpassbar: Passe ForschungsTiefe und Quellen an deine spezifischen Bedürfnisse an

- Transparent: Volle Sichtbarkeit in den Forschungsprozess und genutzte Quellen

- Open Source: Community-getriebene Entwicklung und kontinuierliche Verbesserungen

So erzielen Sie die besten Ergebnisse

Für optimale Leistung:

- Verwende größere, leistungsfähigere LLM-Modelle, wenn möglich

- Konfiguriere passende Such-APIs für deine spezifischen Bedürfnisse

- Passe die Anzahl der Forschungszyklen basierend auf der Komplexität des Themas an

- Überprüfe und verifiziere wichtige Quellen manuell für kritische Recherchen

Local Deep Researcher stellt einen bedeutenden Fortschritt in lokalen KI-gestützten Forschungs-Tools dar und kombiniert die Kraft großer Sprachmodelle mit praktischen Web-Recherchefähigkeiten, während vollständiger Datenschutz und Kontrolle gewahrt bleiben.

Beste Alternativwerkzeuge zu "Local Deep Researcher"

GPT Researcher ist ein Open-Source-KI-Forschungsassistent, der die Tiefenrecherche automatisiert. Es sammelt Informationen aus vertrauenswürdigen Quellen, aggregiert Ergebnisse und generiert schnell umfassende Berichte. Ideal für Einzelpersonen und Teams, die unvoreingenommene Einblicke suchen.

Artisan ist eine KI-gestützte Plattform, die Outbound-Verkäufe mit KI-Mitarbeitern wie Ava, einem KI-BDR, automatisiert und Tools für Leadgenerierung, E-Mail-Outreach und mehr konsolidiert.

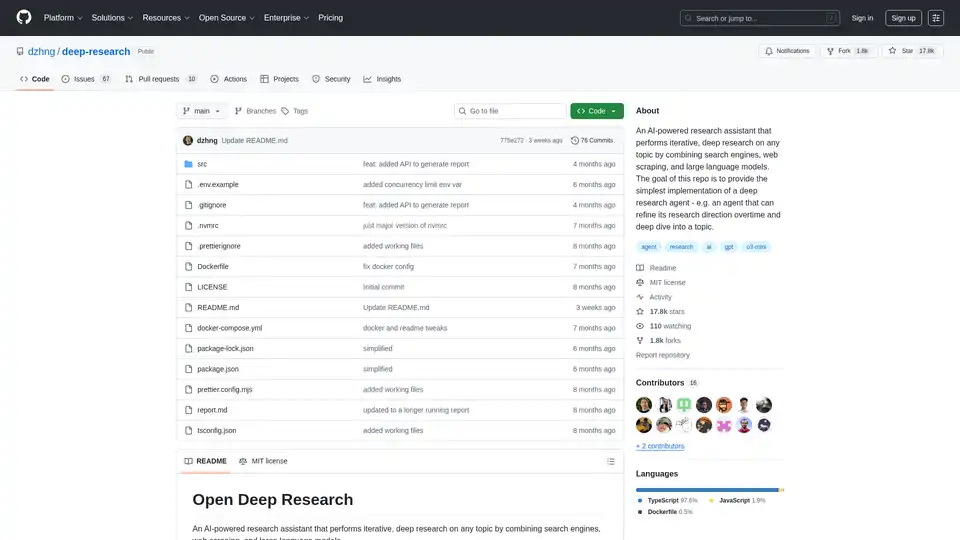

Deep Research ist ein KI-gestützter Forschungsassistent, der Suchmaschinen, Web Scraping und LLMs für iterative, eingehende Recherchen zu jedem Thema kombiniert. Vereinfacht Deep Dives mit intelligenter Abfrageerstellung und umfassenden Berichten.

Wandeln Sie Ihren Workflow mit BrainSoup um! Erstellen Sie benutzerdefinierte KI-Agenten, um Aufgaben zu handhaben und Prozesse durch natürliche Sprache zu automatisieren. Verbessern Sie KI mit Ihren Daten, während Sie Datenschutz und Sicherheit priorisieren.

Learnitive Notepad ist eine KI-gestützte All-in-One-Notiz-App zum Erstellen von Markdown-Notizen, Code, Fotos, Webseiten und mehr. Steigern Sie die Produktivität mit 50 GB Speicher, unbegrenzter KI-Unterstützung und Geräteübergreifender Kompatibilität.

Page Assist ist eine Chrome-Erweiterung, die eine Seitenleisten-Schnittstelle für die Verwendung lokal ausgeführter KI-Modelle während des Web-Browsings bereitstellt und Ollama, Chrome AI und OpenAI-kompatible APIs unterstützt.

CSV laden und in einer visuellen schrittweisen Oberfläche analysieren. Bereinigen, extrahieren, zusammenfassen oder Stimmungsanalyse mit Ihrem persönlichen AI-Agenten durchführen.

PayPerQ (PPQ.AI) bietet sofortigen Zugriff auf führende KI-Modelle wie GPT-4o mit Bitcoin und Crypto. Bezahlen pro Abfrage ohne Abonnements oder Registrierung, unterstützt Text-, Bild- und Videogenerierung.

Pop-Plan ist ein KI-gestützter Itinerar-Ersteller mit Assistentin Poppy, die personalisierte Tagespläne für Abenteuer erstellt – von lokalen Erkundungen bis Reisezielen – und Zeit beim Planen spart.

AI-Website-Builder, dem über 10 Millionen Nutzer vertrauen, um Traffic zu steigern und Konkurrenz zu überholen. Erstellen Sie professionelle Websites mit automatisierter SEO, Copywriting und Sicherheit in Minuten.

YouTube Summary mit ChatGPT & Claude ist eine kostenlose Browser-Erweiterung, die KI-gestützte Zusammenfassungen und Transkripte für YouTube-Videos, PDFs und Web-Artikel mit Modellen wie ChatGPT und Gemini bietet. Sparen Sie Zeit und steigern Sie Ihre Produktivität.

Entdecken Sie Enigma, den AI-agentischen Browser für iPhone, der Web-Recherche, Vergleichseinkäufe und Datensammlung automatisiert. Steigern Sie die Produktivität 8-mal schneller mit datenschutzorientierten Funktionen—ohne Cloud-Speicher.

Devika AI ist ein Open-Source-KI-Softwareentwickler, der High-Level-Anweisungen versteht, sie aufschlüsselt, relevante Informationen recherchiert und Code mithilfe von Claude 3, GPT-4, GPT-3.5 und lokalen LLMs generiert.

ParasiteSEO.com ist ein KI-gestütztes Tool, das entwickelt wurde, um Parasite-SEO-Strategien zu automatisieren und zu optimieren, damit Benutzer schnell wertvolle Rankings stehlen und traditionelle SEO-Herausforderungen umgehen können.