Mercury

Übersicht von Mercury

Mercury: Revolutionierung der KI mit Diffusion LLMs

Was ist Mercury? Mercury, entwickelt von Inception, repräsentiert eine neue Ära in Large Language Models (LLMs) durch die Nutzung der Diffusionstechnologie. Diese Diffusion LLMs (dLLMs) bieten signifikante Vorteile in Bezug auf Geschwindigkeit, Effizienz, Genauigkeit und Steuerbarkeit im Vergleich zu traditionellen autoregressiven LLMs.

Wie funktioniert Mercury?

Im Gegensatz zu herkömmlichen LLMs, die Text sequentiell erzeugen, Token für Token, erzeugen Mercurys dLLMs Token parallel. Diese parallele Verarbeitung erhöht die Geschwindigkeit dramatisch und optimiert die GPU-Effizienz, wodurch es ideal für KI-Anwendungen in Echtzeit ist.

Hauptmerkmale und Vorteile:

- Blitzschnelle Inferenz: Erleben Sie ultraniedrige Latenzzeiten, die reaktionsschnelle KI-Interaktionen ermöglichen.

- Grenzwertige Qualität: Profitieren Sie von hoher Genauigkeit und steuerbarer Textgenerierung.

- Kosteneffektiv: Reduzieren Sie die Betriebskosten mit maximaler GPU-Effizienz.

- OpenAI API-kompatibel: Integrieren Sie Mercury nahtlos in bestehende Workflows als Drop-in-Ersatz für traditionelle LLMs.

- Großes Kontextfenster: Sowohl Mercury Coder als auch Mercury unterstützen ein 128K-Kontextfenster.

KI-Anwendungen, die von Mercury unterstützt werden:

Mercurys Geschwindigkeit und Effizienz eröffnen eine breite Palette von KI-Anwendungen:

- Codierung: Beschleunigen Sie Codierungs-Workflows mit blitzschneller Autovervollständigung, Tab-Vorschlägen und Bearbeitung.

- Sprache: Bieten Sie reaktionsschnelle Spracherlebnisse im Kundenservice, bei Übersetzungen und im Vertrieb.

- Suche: Stellen Sie sofort relevante Daten aus jeder Wissensbasis bereit und minimieren Sie die Recherchezeit.

- Agenten: Führen Sie komplexe Multi-Turn-Systeme mit geringer Latenz aus.

Mercury Modelle:

- Mercury Coder: Optimiert für Codierungs-Workflows, unterstützt Streaming, Tool-Nutzung und strukturierte Ausgabe. Preise: Eingabe $0.25 | Ausgabe $1 pro 1M Token.

- Mercury: Universelles dLLM, das extrem niedrige Latenzzeiten bietet und ebenfalls Streaming, Tool-Nutzung und strukturierte Ausgabe unterstützt. Preise: Eingabe $0.25 | Ausgabe $1 pro 1M Token.

Warum Mercury wählen?

Testimonials von Branchenexperten heben Mercurys außergewöhnliche Geschwindigkeit und Wirkung hervor:

- Jacob Kim, Software Engineer: "Ich war erstaunt, wie schnell es war. Die mehreren tausend Token pro Sekunde waren absolut verrückt, so etwas habe ich noch nie gesehen."

- Oliver Silverstein, CEO: "Nachdem ich Mercury ausprobiert habe, ist es schwer, zurückzugehen. Wir freuen uns darauf, Mercury einzuführen, um alle unsere Sprachagenten zu unterstützen."

- Damian Tran, CEO: "Wir haben die Routing- und Klassifizierungs-Overheads selbst bei komplexen Agent-Traces auf subsekündliche Latenzen reduziert."

Für wen ist Mercury geeignet?

Mercury wurde für Unternehmen entwickelt, die:

- Die Leistung von KI-Anwendungen verbessern möchten.

- Die Kosten für die KI-Infrastruktur senken möchten.

- Sich mit modernster KI-Technologie einen Wettbewerbsvorteil verschaffen möchten.

Wie man Mercury integriert:

Mercury ist über große Cloud-Anbieter wie AWS Bedrock und Azure Foundry verfügbar. Es ist auch über Plattformen wie OpenRouter und Quora zugänglich. Sie können mit ihrer API beginnen.

Um Fine-Tuning, private Deployments und Forward-Deployed Engineering Support zu erkunden, wenden Sie sich an Inception.

Mercury bietet einen transformativen Ansatz für KI, der sie schneller, effizienter und für eine breite Palette von Anwendungen zugänglicher macht. Testen Sie die Mercury API noch heute und erleben Sie die nächste Generation der KI.

Beste Alternativwerkzeuge zu "Mercury"

Entdecken Sie AI Library, den umfassenden Katalog mit über 2150 neuronalen Netzen und KI-Tools für generative Inhaltscreation. Finden Sie die besten KI-Kunstmodelle, Tools für Text-zu-Bild, Videogenerierung und mehr, um Ihre kreativen Projekte zu fördern.

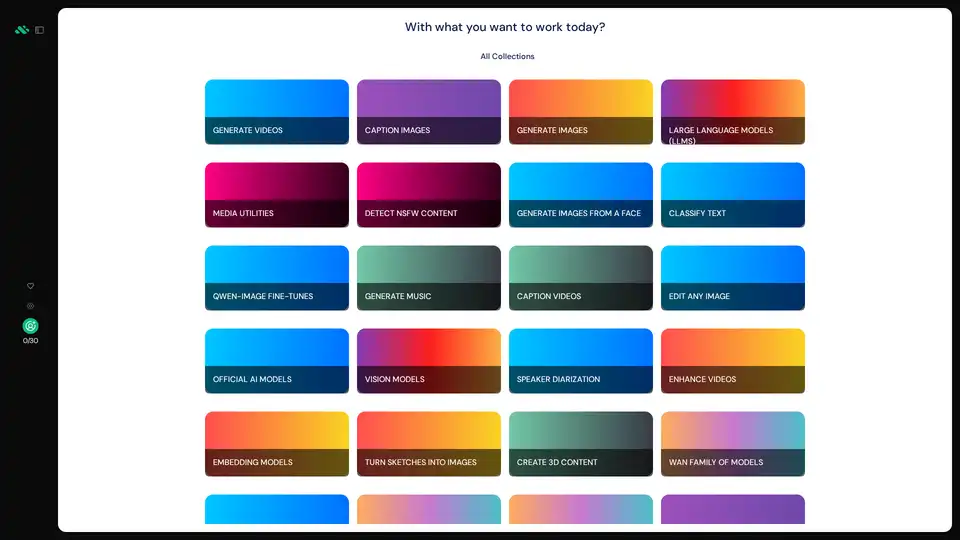

AIverse ist eine All-in-One-Plattform mit Zugriff auf Tausende KI-Modelle für Bild-/Videogenerierung, LLMs, Sprache-zu-Text, Musikschöpfung u.v.m. Unbegrenzte Nutzung für 20 $/Monat.

Meteron AI ist ein All-in-One-KI-Toolset, das LLM- und generative KI-Messung, Load-Balancing und Speicherung übernimmt, sodass sich Entwickler auf die Entwicklung von KI-gestützten Produkten konzentrieren können.

Chatten Sie mit KI unter Verwendung Ihrer API-Schlüssel. Zahlen Sie nur für das, was Sie nutzen. Unterstützt GPT-4, Gemini, Claude und andere LLMs. Die beste Chat-LLM-Frontend-OI für alle KI-Modelle.

AI Runner ist eine Offline-KI-Inferenz-Engine für Kunst, Echtzeit-Sprachkonversationen, LLM-gestützte Chatbots und automatisierte Arbeitsabläufe. Führen Sie Bilderzeugung, Voice-Chat und mehr lokal aus!

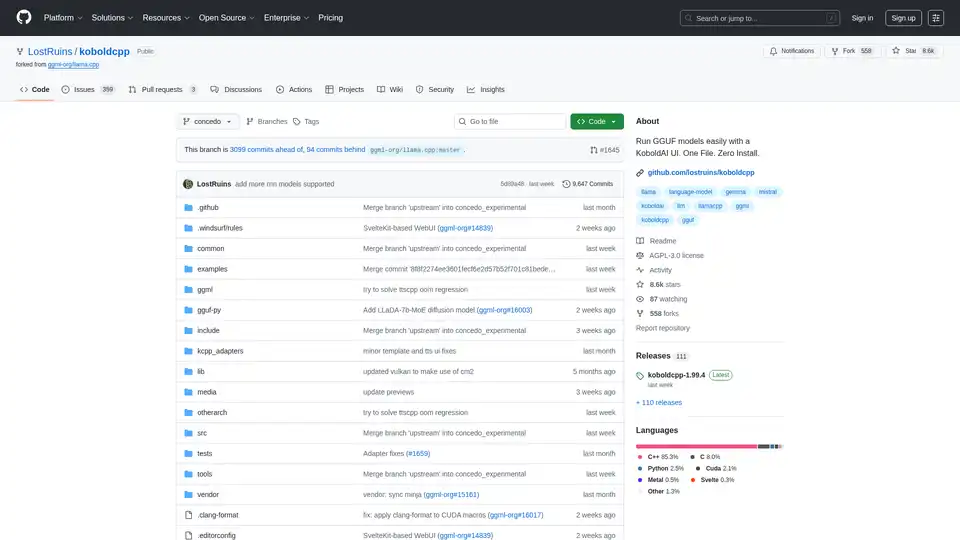

KoboldCpp: Führen Sie GGUF-Modelle einfach zur KI-Text- und Bildgenerierung mit einer KoboldAI-UI aus. Einzelne Datei, keine Installation. Unterstützt CPU/GPU, STT, TTS & Stable Diffusion.

Mit MultiChat AI können Sie mit Top-LLMs wie GPT-4, Claude-3, Gemini 1.5 Pro und mehr an einem Ort chatten. Bietet auch KI-gestützte Bildgenerierungs- und Bearbeitungstools.

MotionAgent ist ein Open-Source-KI-Tool, das Ideen in Bewegungsfilme umwandelt, indem es Skripte, Filmstills, hochauflösende Videos und benutzerdefinierte Hintergrundmusik mit Modellen wie Qwen-7B-Chat und SDXL generiert.

Nebius ist eine KI-Cloud-Plattform, die entwickelt wurde, um die KI-Infrastruktur zu demokratisieren und eine flexible Architektur, getestete Leistung und langfristigen Wert mit NVIDIA-GPUs und optimierten Clustern für Training und Inferenz bietet.

PromptBuilder ist eine KI-Prompt-Engineering-Plattform, die entwickelt wurde, um Benutzern zu helfen, qualitativ hochwertige Prompts für verschiedene KI-Modelle wie ChatGPT, Claude und Gemini zu generieren, zu optimieren und zu organisieren, um konsistente und effektive KI-Ausgaben zu gewährleisten.

What-A-Prompt ist ein benutzerfreundlicher Prompt-Optimierer zur Verbesserung von Eingaben in AI-Modelle wie ChatGPT und Gemini. Wählen Sie Verbesserer aus, geben Sie Ihren Prompt ein und erzeugen Sie kreative, detaillierte Ergebnisse, um LLM-Ausgaben zu steigern. Greifen Sie auf eine umfangreiche Bibliothek optimierter Prompts zu.

TemplateAI ist die führende NextJS-Vorlage für AI-Apps mit Supabase-Authentifizierung, Stripe-Zahlungen, OpenAI/Claude-Integration und einsatzbereiten AI-Komponenten für schnelle Full-Stack-Entwicklung.

Freshly.ai bietet KI-Tools und Einblicke für die KI-App-Entwicklung, Prompt-Engineering und KI-Kunst. Entdecken Sie innovative KI-Anwendungen und -Techniken, um Kreativität und Produktivität zu steigern.

Verbessern Sie APM mit OpenLIT, einer Open-Source-Plattform auf OpenTelemetry. Vereinfachen Sie die KI-Entwicklung mit einheitlichen Traces und Metriken in einer leistungsstarken Schnittstelle und optimieren Sie die Observability von LLM und GenAI.