Mirai

Übersicht von Mirai

Mirai: Die Zukunft der On-Device AI

Was ist Mirai?

Mirai ist eine Plattform, die entwickelt wurde, um hochleistungsfähige AI direkt in Ihre Anwendungen zu bringen. Sie konzentriert sich auf die On-Device AI-Bereitstellung und bietet Lösungen mit null Latenz, vollständiger Datensicherheit und ohne Inferenzkosten. Das bedeutet, dass Ihre AI direkt auf dem Gerät des Benutzers läuft, wodurch die Notwendigkeit einer ständigen Cloud-Kommunikation entfällt.

Wie funktioniert Mirai?

Mirai bietet ein Inference SDK für Apple-Plattformen, das die branchenweit schnellste Inference Engine enthält. Es nutzt spekulative Dekodierung und intelligentes Routing, um Leistung, Datenschutz und Kosten zu optimieren. Die Plattform unterstützt eine Familie von AI-Modellen mit einem Umfang von 0,3B bis 7B Parametern, sodass Sie das beste Modell für Ihre spezifischen Anforderungen auswählen und gleichzeitig bis zu 40 % der AI-Kosten sparen können.

Hauptmerkmale und Vorteile:

- Null Latenz: Die On-Device-Verarbeitung gewährleistet sofortige Reaktionen und verbessert so die Benutzererfahrung.

- Vollständiger Datenschutz: Es werden keine Benutzerdaten an Dritte gesendet, wodurch die Benutzer die vollständige Kontrolle über ihre Daten erhalten.

- Kosteneffizient: Eliminiert die Cloud-Abhängigkeit und senkt die AI-Nutzungskosten erheblich.

- Hohe Leistung: Die optimierte Inference Engine bietet eine bis zu 3-fache Leistungssteigerung.

- Intelligentes Routing: Bietet vollständige Kontrolle über Leistung, Datenschutz und Preis, sodass Sie bis zu 50 % der Kosten sparen können.

Warum On-Device AI mit Mirai wählen?

On-Device AI bietet mehrere Vorteile gegenüber Cloud-basierten Lösungen:

- Niedrigere Kosten: Reduziert den Bedarf an teuren Cloud-Ressourcen.

- Konstante Leistung: Gewährleistet eine stabile Leistung unabhängig von den Netzwerkbedingungen.

- Verbesserter Datenschutz: Schützt Benutzerdaten und hält sie privat.

- Reduzierte Komplexität: Vereinfacht die AI-Integration, sodass nur ein Entwickler Inferenz, Routing und Optimierung handhaben muss.

Verfügbar und demnächst verfügbar:

- Inference SDK für Apple: Die branchenweit schnellste Inference Engine für Apple-Plattformen.

- Intelligentes Routing: Eine Routing Engine, die Ihnen die volle Kontrolle über Leistung, Datenschutz und Preis gibt.

- On Device AI Models: Eine Familie von AI-Modellen (0,3B - 7B Parameter).

- Inference SDK für Android: (Demnächst).

- Cloud Inference: (Demnächst).

- Camera & Voice Processing: (Demnächst).

Anwendungsfälle:

Die On-Device AI von Mirai kann in verschiedenen Anwendungen eingesetzt werden:

- Allgemeiner Chat: Konversationelle AI, die direkt auf dem Gerät läuft.

- Klassifizierung: Kennzeichnung von Texten nach Thema, Absicht oder Stimmung.

- Zusammenfassung: Schnelle Erstellung leicht lesbarer Zusammenfassungen aus langen Texten.

- Benutzerdefinierte Anwendungsfälle: Erstellung Ihrer eigenen AI-gestützten Anwendungen.

Für wen ist Mirai geeignet?

Mirai ist ideal für Entwickler und Unternehmen, die:

- AI schnell und einfach in ihre Produkte integrieren möchten.

- AI-Kosten senken möchten, ohne die Leistung zu beeinträchtigen.

- Datenschutz und Sicherheit der Benutzer gewährleisten möchten.

- Innovative On-Device AI-Anwendungen erstellen möchten.

Erste Schritte:

Das Einrichten eines AI-Projekts mit Mirai dauert nur 10 Minuten. Die Plattform abstrahiert von der Komplexität der AI, sodass ein Entwickler AI in sein Produkt integrieren kann. Starten Sie kostenlos und erkunden Sie die Möglichkeiten von On-Device AI.

Was ist [Mirai]?

Mirai ist eine Plattform, die es Entwicklern ermöglicht, hochleistungsfähige AI-Modelle direkt auf den Geräten der Benutzer bereitzustellen und so niedrige Latenzzeiten, vollständigen Datenschutz und reduzierte Kosten zu gewährleisten. Es bietet eine Suite von Tools und Modellen, die für On-Device Inference optimiert sind.

Wie funktioniert [Mirai]?

Mirai funktioniert, indem es Entwicklern ein SDK zur Verfügung stellt, das sich nahtlos in Apple-Plattformen integrieren lässt. Dieses SDK enthält eine schnelle Inference Engine mit spekulativer Dekodierung, intelligentem Routing und strukturierten Ausgabefunktionen. Durch die Verarbeitung von AI-Aufgaben direkt auf dem Gerät entfällt die Notwendigkeit einer ständigen Cloud-Kommunikation, wodurch die Geschwindigkeit und Sicherheit verbessert werden.

Wie verwende ich [Mirai]?

Um Mirai zu verwenden, können Entwickler das Inference SDK für Apple in ihre Anwendungen integrieren. Das SDK ermöglicht einfaches Laden, Ausführen und Routing von Modellen. Mirai bietet außerdem eine Bibliothek mit vortrainierten Modellen, die für verschiedene Aufgaben wie allgemeiner Chat, Textklassifizierung und Zusammenfassung geeignet sind.

Warum [Mirai] wählen?

Die Wahl von Mirai bedeutet, sich für eine Lösung zu entscheiden, die Geschwindigkeit, Datenschutz und Kosteneffizienz priorisiert. Die On-Device-Verarbeitungsfunktionen gewährleisten eine konsistente Leistung, während die intelligente Routing Engine es Entwicklern ermöglicht, die Ressourcennutzung zu optimieren und Kosten zu senken. Mirai vereinfacht die AI-Integration und macht sie auch für kleine Entwicklungsteams zugänglich.

Für wen ist [Mirai] geeignet?

Mirai wurde für Entwickler, Startups und Unternehmen entwickelt, die die Leistungsfähigkeit von AI ohne die Nachteile Cloud-basierter Lösungen nutzen möchten. Es eignet sich besonders für Anwendungen, bei denen geringe Latenzzeiten, Datenschutz und Kosteneinsparungen entscheidend sind.

Beste Alternativwerkzeuge zu "Mirai"

Nexa SDK ermöglicht schnelle und private KI-Inferenz auf dem Gerät für LLMs, multimodale, ASR- und TTS-Modelle. Stellen Sie auf Mobilgeräten, PCs, in der Automobilindustrie und auf IoT-Geräten mit produktionsbereiter Leistung auf NPU, GPU und CPU bereit.

PERSYS ist eine private KI-Konsole mit On-Device-KI, die sichere lokale Speicherung und Dokumenteneinbettung für mehr Datenschutz bietet. Entdecken Sie die Zukunft der persönlichen KI.

On-Device AI: Verwandeln Sie Sprache in Text, natürlichen Text in Sprache und chatten Sie offline und sicher mit LLMs auf Ihrem iPhone, iPad und Mac. Privat und leistungsstark!

Cheetah ist eine Open-Source-macOS-App mit KI, die Whisper für Echtzeit-Transkription und GPT-4 für Interview-Hinweise nutzt und Benutzer mit Live-Coaching bei Tech-Interviews unterstützt.

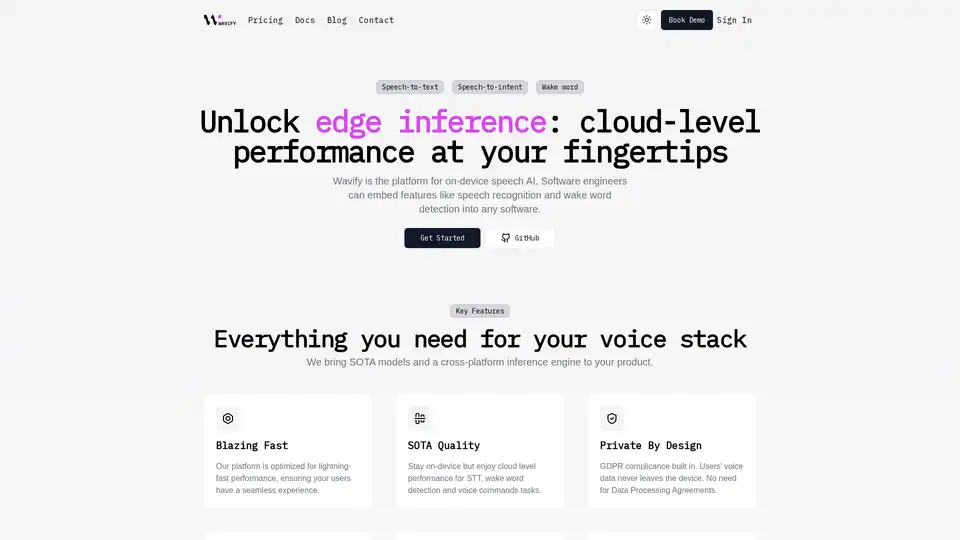

Wavify ist die ultimative Plattform für On-Device-Sprach-KI, die eine nahtlose Integration von Spracherkennung, Wake-Word-Erkennung und Sprachbefehlen mit erstklassiger Leistung und Datenschutz ermöglicht.

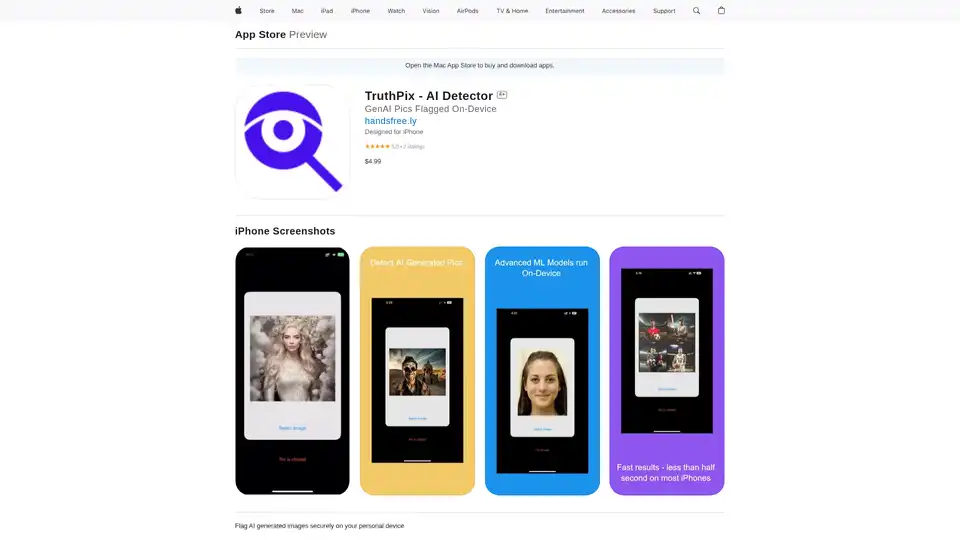

TruthPix ist eine sichere iPhone-App, die AI-generierte Bilder und Deepfakes auf dem Gerät erkennt und hilft, Desinformation in Werbung, Betrug und sozialen Medien mit schneller, privater Analyse zu bekämpfen.

Verbessern Sie Ihren Arbeitstag mit der AI-Haltungserinnerungs-App auf Mac. Sie überwacht die Haltung mit fortschrittlicher KI, sendet Echtzeit-Alarme bei Buckeln und fördert bessere Gesundheit – alles mit Fokus auf Datenschutz durch On-Device-Verarbeitung.

Brilliant Labs Halo ist eine Open-Source-AI-Brillenplattform mit Echtzeit-Multimodal-Gesprächen, On-Device-AI-Verarbeitung und 14-Stunden-Akku für Entwickler und Kreative.

Privacy AI ist ein Offline-KI-Chatbot-Hub, der ultimativen Datenschutz gewährleistet. Führen Sie Sprachmodelle lokal auf Ihrem Gerät ohne Internet aus, um sichere Gespräche zu führen.

Sentiance bietet On-Device-Bewegungserkenntnisse zur Verbesserung der Verkehrssicherheit und Mobilität. KI-gestützte Lösungen für Fahrersicherheit, Risikoreduzierung und Analyse von Mobilitätsmustern.

Neuron AI Pro ist ein privates und sicheres KI-Chat- und Produktivitätstool, das für Apple Silicon optimiert ist. Nutzen Sie die KI-Verarbeitung auf dem Gerät für eine sichere Audiozusammenfassung und mehr.

Skribr ist eine private On-Device-KI-Chat-App mit Tools, die lokal auf Ihrem iPhone, iPad und Mac ausgeführt werden und Datensicherheit und Offline-Zugriff gewährleisten.

Pico Library verwendet On-Device-KI, um personalisierte Geschichten für Kinder zu erstellen, auch offline. Ein sicheres und lehrreiches Werkzeug für Kinder.

ZETIC.ai ermöglicht die Erstellung kostengünstiger On-Device-KI-Apps durch die direkte Bereitstellung von Modellen auf Geräten. Reduzieren Sie die KI-Servicekosten und sichern Sie Daten mit Serverless-KI mithilfe von ZETIC.MLange.