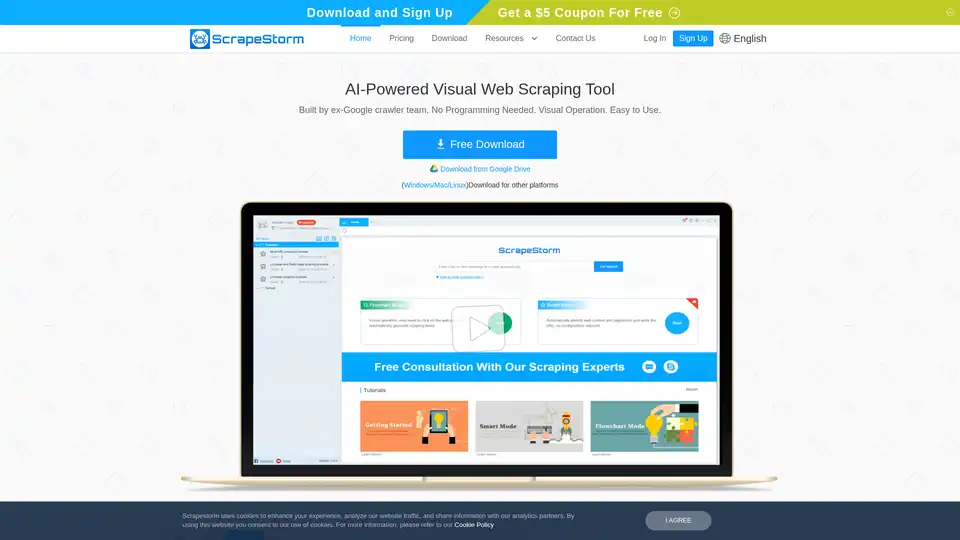

ScrapeStorm

Übersicht von ScrapeStorm

Was ist ScrapeStorm?

ScrapeStorm ist ein KI-gestütztes, visuelles Web-Scraping-Tool, das entwickelt wurde, um Daten von nahezu jeder Website zu extrahieren, ohne dass Programmierkenntnisse erforderlich sind. Es wurde von einem Team ehemaliger Google-Crawler-Experten entwickelt und bietet eine intuitive, benutzerfreundliche Oberfläche, die für Einzelpersonen, Teams und Unternehmen geeignet ist.

Wie funktioniert ScrapeStorm?

ScrapeStorm verwendet eine Kombination aus intelligenten KI-Algorithmen und visueller Bedienung, um den Web-Scraping-Prozess zu vereinfachen. Es verfügt über zwei Hauptmodi: Smart Mode und Flowchart Mode.

Smart Mode

Im Smart Mode identifiziert ScrapeStorm auf intelligente Weise Listendaten, Tabellendaten und Paginierungs-Buttons ohne manuelle Konfiguration. Benutzer geben einfach die URLs ein, und die Software erkennt und extrahiert automatisch Daten wie Listen, Formulare, Links, Bilder, Preise, Telefonnummern und E-Mails.

Flowchart Mode

Der Flowchart Mode ahmt manuelles Web-Browsen nach und führt Benutzer durch eine visuelle Klick-Bedienung. Durch das Klicken auf Webseitenelemente, wie von der Software vorgegeben, können Benutzer in wenigen Schritten komplexe Scraping-Regeln erstellen. Dieser Modus unterstützt Simulationsoperationen wie Texteingabe, Klicken auf Buttons, Bewegen der Maus, Interaktion mit Dropdown-Boxen, Scrollen von Seiten, Warten auf das Laden, Schleifenoperationen und Auswerten von Bedingungen.

Hauptmerkmale von ScrapeStorm

- KI-gestützte intelligente Identifizierung: Erkennt automatisch Datentypen und -strukturen auf Webseiten.

- Visuelle Klick-Bedienung: Vereinfacht die Erstellung von Scraping-Regeln durch eine intuitive visuelle Oberfläche.

- Mehrere Datenexportmethoden: Unterstützt den Export von gescrapten Daten in verschiedene Formate, darunter Excel, CSV, TXT, HTML, MySQL, MongoDB, SQL Server, PostgreSQL, WordPress und Google Sheets.

- Enterprise Scraping Services: Bietet leistungsstarke Scraping-Funktionen, hohe Effizienz und professionelle Dienstleistungen, die für Einzelpersonen, Teams und Unternehmensbedürfnisse geeignet sind.

- Cloud Account: Speichert Scraping-Aufgaben automatisch in der Cloud, auf die von jedem Computer mit Ihrem ScrapeStorm-Konto zugegriffen werden kann.

- Cross-Platform Support: Kompatibel mit Windows-, Mac- und Linux-Betriebssystemen.

Warum ScrapeStorm wählen?

- Keine Programmierung erforderlich: Extrahieren Sie Daten von Websites, ohne Code zu schreiben.

- Einfach zu bedienen: Visuelle Bedienung und intelligente Identifizierung erleichtern die Erstellung von Scraping-Regeln.

- Vielseitiger Datenexport: Unterstützt mehrere Datenexportformate und Cloud-Speicher.

- Leistungsstarke Funktionen: Beinhaltet Zeitplanung, IP-Rotation, automatischen Export und mehr.

- Cross-Platform Compatibility: Funktioniert unter Windows, Mac und Linux.

Für wen ist ScrapeStorm geeignet?

ScrapeStorm ist konzipiert für:

- Einzelpersonen: Jeder, der Daten von Websites für persönliche oder Forschungszwecke extrahieren muss.

- Teams: Datenanalysten, Marketer und andere Fachleute, die Web-Scraping für Business Intelligence benötigen.

- Unternehmen: Unternehmen, die große Mengen an Webdaten für Marktforschung, Wettbewerbsanalyse und andere Anwendungen sammeln und analysieren müssen.

Bester Weg, um Webdaten zu extrahieren?

ScrapeStorm bietet eine optimierte und effiziente Möglichkeit, Webdaten zu extrahieren, indem es KI-gesteuerte Automatisierung mit einer benutzerfreundlichen visuellen Oberfläche kombiniert. Egal, ob Sie ein Anfänger oder ein erfahrener Datenexperte sind, ScrapeStorm kann Ihnen helfen, die benötigten Daten schnell und einfach zu sammeln.

ScrapeStorm Anwendungsfälle

- E-Commerce-Datenextraktion: Scrapen Sie Produktpreise, Beschreibungen und Bewertungen von Online-Shops.

- Marktforschung: Sammeln Sie Daten zu Markttrends, Wettbewerbspreisen und Kundenstimmungen.

- Lead-Generierung: Extrahieren Sie Kontaktinformationen von Websites, um Lead-Listen zu erstellen.

- Immobilien-Data-Mining: Scrapen Sie Immobilienangebote, Preise und andere Details von Immobilien-Websites.

- Nachrichtenaggregation: Sammeln Sie Nachrichtenartikel und Schlagzeilen aus verschiedenen Nachrichtenquellen.

ScrapeStorm vereinfacht die Webdatenextraktion mit seinen KI-gestützten Funktionen und der benutzerfreundlichen Oberfläche und ist somit ein wertvolles Tool für alle, die Daten aus dem Web sammeln müssen.

Beste Alternativwerkzeuge zu "ScrapeStorm"

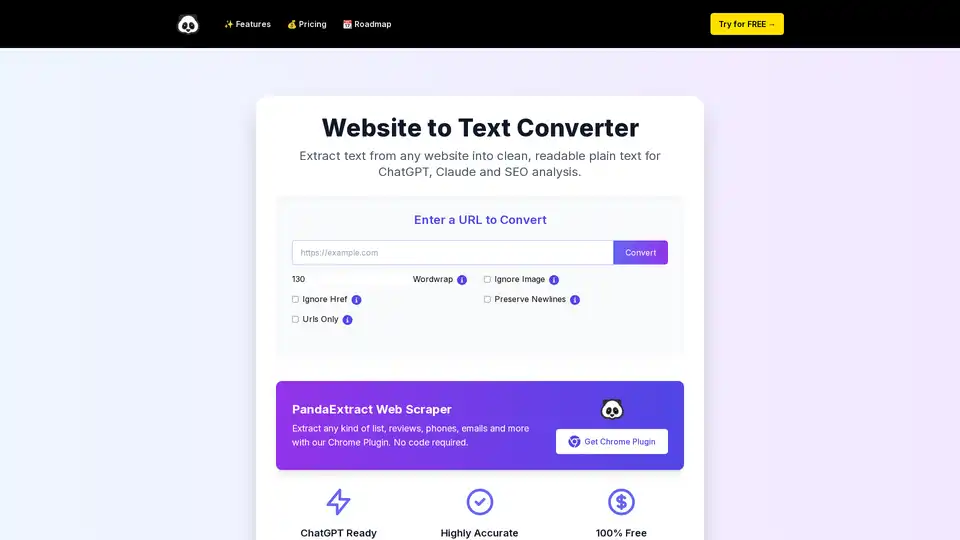

Extrahieren Sie Text von jeder Website in sauberen, lesbaren Klartext. Ideal für ChatGPT-Prompts, AI-Analyse, SEO und Forschung ohne Installation.

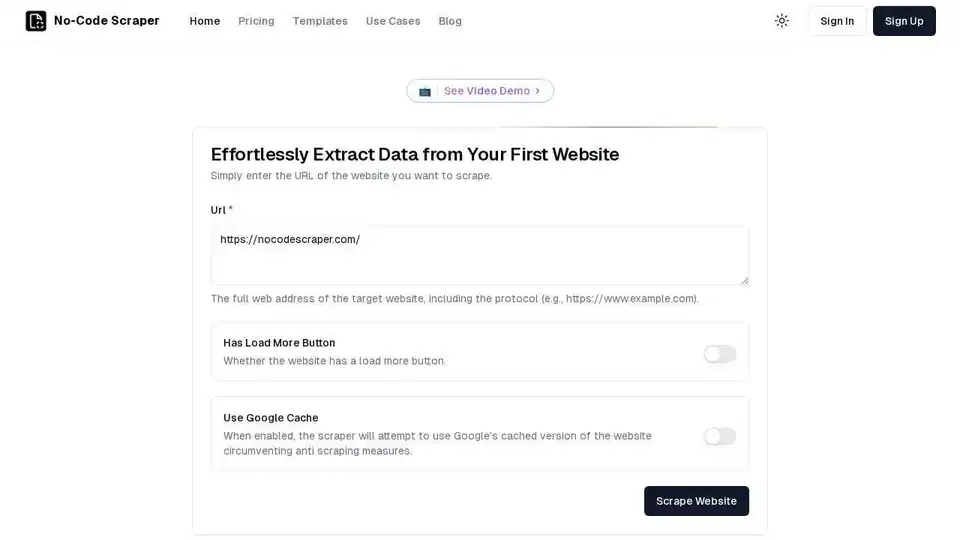

No-Code Scraper ist ein KI-gestütztes Web-Scraping-Tool, mit dem Sie Daten von jeder Website ohne Programmierung extrahieren können. Automatisieren Sie die Datenerfassung mühelos mit der benutzerfreundlichen Oberfläche.

MrScraper ist ein KI-gestützter Web Scraper, der Daten einfach und ohne Blockierung von Websites extrahiert. Er vereinfacht das Data Scraping und die Automatisierung und macht Daten für jeden zugänglich.

Thunderbit ist eine AI Web Scraper Chrome-Erweiterung, mit der Sie jede Website mit 2 Klicks scrapen können. Es verwendet KI, um Daten zu extrahieren und bietet vorgefertigte Vorlagen. Kostenlose Stufe verfügbar.

BrowserAct ist ein KI-gestützter Web Scraper und ein Automatisierungstool, mit dem Sie Daten von jeder beliebigen Website ohne Programmierung extrahieren können. Automatisieren Sie Arbeitsabläufe und integrieren Sie sich in Tools wie n8n und Make.

Octoparse ist ein No-Code-Web-Scraping-Tool, das die Datenextraktion von jeder Website vereinfacht. Sammeln Sie Daten in wenigen Minuten und treiben Sie Ihr Geschäft mit den richtigen Daten voran.

Apify ist eine Full-Stack-Cloud-Plattform für Web Scraping, Browserautomatisierung und KI-Agenten. Verwenden Sie vorgefertigte Tools oder erstellen Sie Ihre eigenen Actors für Datenextraktion und Workflow-Automatisierung.

UseScraper ist eine superschnelle Web Scraping und Crawling API. Scrapen Sie jede URL sofort, crawlen Sie ganze Websites und geben Sie Daten in Klartext, HTML oder Markdown aus. Die ersten 1.000 Seiten sind kostenlos.

Webscrape AI ist ein No-Code-Tool zur Automatisierung der Web-Datenerfassung mithilfe von KI. Extrahieren Sie einfach Daten, indem Sie URLs und die gewünschten Elemente eingeben; es sind keine Programmierkenntnisse erforderlich.

Octoparse ist ein No-Code-Web-Scraping-Tool, das Webseiten mit wenigen Klicks in strukturierte Daten umwandelt. Es bietet KI-Unterstützung, eine 24/7-Cloud-Lösung, voreingestellte Vorlagen und flexible Konfigurationsoptionen.

Thunderbit ist eine AI Web Scraper Chrome-Erweiterung. Die KI liest Webseiteninhalte und gibt eine Tabelle für Sie aus. Kostenlose Stufe verfügbar.

Crawl AI: Erstellen Sie benutzerdefinierte KI-Assistenten, -Agenten und Web Scraper einfach. Scrapen Sie Websites, extrahieren Sie Daten und fördern Sie die tiefgreifende Forschung.

ProNoto ist eine KI-gestützte Browsererweiterung, die KI-Notizen, KI-Assistenten, Datenextraktion, Teleprompter und Bilderfassung in einem Tool vereint. Steigern Sie Ihre Produktivität im Web mit dieser All-in-One-Lösung.

SkuGrid wird am 28. Juli 2025 eingestellt. Finden Sie empfohlene Alternativen für Einzelhandelsarbitrage, Preisänderung, Bestandsverwaltung und Produktbeschaffung, um Ihr Geschäft fortzusetzen.