UseScraper

Übersicht von UseScraper

UseScraper: Schnelle Web Scraping und Crawling API

Was ist UseScraper? UseScraper ist eine leistungsstarke und effiziente Web Scraping und Crawling API, die entwickelt wurde, um Daten schnell und zuverlässig von Websites zu extrahieren. Sie ermöglicht es Benutzern, jede URL sofort zu scrapen, ganze Websites zu crawlen und Daten in verschiedenen Formaten auszugeben, die für vielfältige Anwendungen geeignet sind.

Wie funktioniert UseScraper? UseScraper verwendet eine robuste Architektur, die auf Geschwindigkeit und Skalierbarkeit ausgelegt ist. Sie verwendet einen echten Chrome-Browser mit JavaScript-Rendering, um auch die komplexesten Webseiten zu verarbeiten. Der Inhalt wird dann extrahiert und in HTML-, Klartext- oder Markdown-Formaten gespeichert.

Hauptmerkmale:

- Sofortiges Scraping: Scraping jeder URL in Sekunden.

- Umfassendes Crawling: Crawlen aller Seiten einer Website.

- Flexible Ausgabe: Ausgabe von Daten in Klartext, HTML oder Markdown.

- JavaScript-Rendering: Verwendet einen echten Chrome-Browser für genaues Scraping.

- Automatische Proxys: Verhindert Ratenbegrenzung durch automatisch rotierende Proxys.

- Multi-Site-Crawling: Fügen Sie mehrere Websites in eine Crawl-Job-Anfrage ein.

- Seiten ausschließen: Schließen Sie bestimmte URLs mit Glob-Mustern von einem Crawl aus.

- Site-Elemente ausschließen: Verwenden Sie CSS-Selektoren, um sich wiederholende Inhalte auszuschließen.

- Webhook-Updates: Erhalten Sie Benachrichtigungen über den Status und den Abschluss von Crawl-Jobs.

- Ausgabe-Datenspeicher: Crawler-Ergebnisse werden gespeichert und über die API zugänglich.

- Automatische Datenablauf: Legen Sie eine automatische Ablaufzeit für gespeicherte Daten fest.

Anwendungsfälle:

- Datenextraktion für AI Modelle: Perfekt, um AI Systemen saubere, strukturierte Daten im Markdown-Format bereitzustellen.

- Marktforschung: Sammeln Sie Daten über Wettbewerber, Produkte und Markttrends.

- Content-Aggregation: Sammeln Sie Artikel, Nachrichten und Blog-Posts aus verschiedenen Quellen.

- SEO Monitoring: Verfolgen Sie Website-Rankings und identifizieren Sie Bereiche für Verbesserungen.

- Lead-Generierung: Extrahieren Sie Kontaktinformationen von Websites.

Preisgestaltung:

UseScraper bietet flexible Preispläne für unterschiedliche Bedürfnisse:

- Pay as you go: 0 $/Monat + 1 $ pro 1.000 Webseiten. Beinhaltet Scraper & Crawler APIs, JavaScript-Rendering und superschnelles paralleles Scraping & Crawling.

- Pro: 99 $/Monat + 1 $ pro 1.000 Webseiten. Beinhaltet alle kostenlosen Funktionen sowie erweiterte Proxys, unbegrenzte gleichzeitige Jobs, unbegrenztes Seitencrawling und Priority Support.

Kostenloser Tarif:

- Starten Sie mit einem kostenlosen Konto und Ihre ersten 1.000 Seiten sind kostenlos.

So verwenden Sie UseScraper:

- Anmelden: Erstellen Sie ein kostenloses Konto auf der UseScraper-Website.

- URL eingeben: Geben Sie die URL ein, die Sie scrapen oder crawlen möchten.

- Einstellungen konfigurieren: Wählen Sie Ihr gewünschtes Ausgabeformat (Markdown, Klartext oder HTML) und alle spezifischen Crawling-Regeln.

- Job ausführen: Starten Sie den Scraping- oder Crawling-Job.

- Auf Daten zugreifen: Rufen Sie die extrahierten Daten über die API oder die Dashboard-UI ab.

Warum ist UseScraper wichtig?

In der heutigen datengesteuerten Welt ist der Zugang zu genauen und zeitnahen Informationen von entscheidender Bedeutung. UseScraper vereinfacht den Prozess des Web Scraping und Crawling und ermöglicht es Unternehmen und Einzelpersonen, die Daten zu sammeln, die sie benötigen, um fundierte Entscheidungen zu treffen.

Bester Weg, um Daten von Websites zu extrahieren?

UseScraper bietet eine benutzerfreundliche Oberfläche und eine leistungsstarke API und ist somit der beste Weg, um Daten von Websites zu extrahieren, unabhängig von ihrer Komplexität. Die automatischen Proxys, das JavaScript-Rendering und die verschiedenen Ausgabeformate gewährleisten eine nahtlose und effiziente Datenerfassung.

Beste Alternativwerkzeuge zu "UseScraper"

Firecrawl ist die führende Web-Crawling-, Scraping- und Such-API für KI-Anwendungen. Sie verwandelt Websites in saubere, strukturierte, LLM-bereite Daten im großen Maßstab und versorgt KI-Agenten mit zuverlässiger Web-Extraktion ohne Proxys oder Kopfschmerzen.

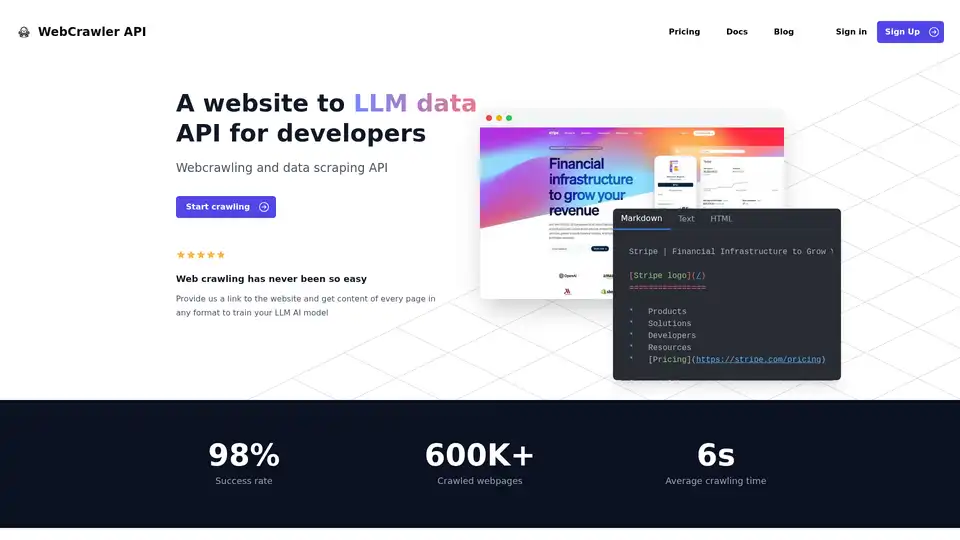

WebCrawler API vereinfacht die Extraktion von Website-Daten für KI-Training. Crawlen und scrapen Sie Inhalte in verschiedenen Formaten mit Leichtigkeit. Verarbeitet Proxys, Wiederholungen und Headless-Browser.

SingleAPI wandelt Websites mit GPT-4 in Sekundenschnelle in APIs um. Extrahieren Sie Daten, reichern Sie sie an und automatisieren Sie Web Scraping ohne Programmierung. Ideal für datengesteuerte Aufgaben.

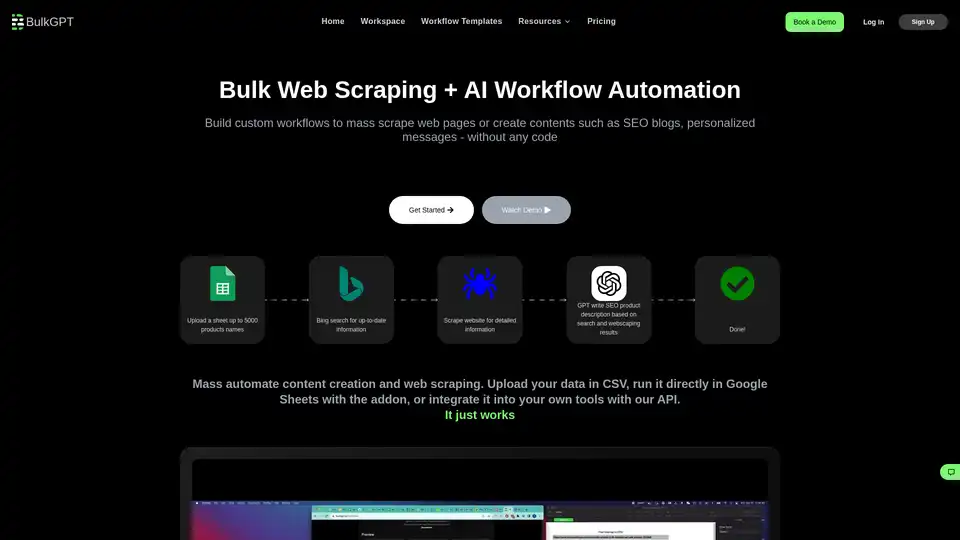

BulkGPT ist ein No-Code-Tool für die Bulk-AI-Workflow-Automatisierung, das schnelles Web-Scraping und ChatGPT-Batch-Verarbeitung ermöglicht, um SEO-Inhalte, Produktbeschreibungen und Marketingmaterialien mühelos zu erstellen.

Octoparse ist ein No-Code-Web-Scraping-Tool, das die Datenextraktion von jeder Website vereinfacht. Sammeln Sie Daten in wenigen Minuten und treiben Sie Ihr Geschäft mit den richtigen Daten voran.

Octoparse ist ein No-Code-Web-Scraping-Tool, das Webseiten mit wenigen Klicks in strukturierte Daten umwandelt. Es bietet KI-Unterstützung, eine 24/7-Cloud-Lösung, voreingestellte Vorlagen und flexible Konfigurationsoptionen.

Apify ist eine Full-Stack-Cloud-Plattform für Web Scraping, Browserautomatisierung und KI-Agenten. Verwenden Sie vorgefertigte Tools oder erstellen Sie Ihre eigenen Actors für Datenextraktion und Workflow-Automatisierung.

ScrapeStorm ist ein KI-gestütztes visuelles Web Scraping Tool, mit dem Benutzer Daten von Websites ohne Programmierung extrahieren können. Es bietet intelligente Datenerkennung, mehrere Exportoptionen und unterstützt verschiedene Betriebssysteme.

Automatisieren Sie Web Scraping, WordPress-Datenmigration, E-Commerce-Produktimporte und Buchungsautomatisierung mit Firecrawl. Nutzen Sie KI-gestützte Lösungen, um Zeit zu sparen, Fehler zu reduzieren und Ihr Geschäft mühelos zu skalieren!

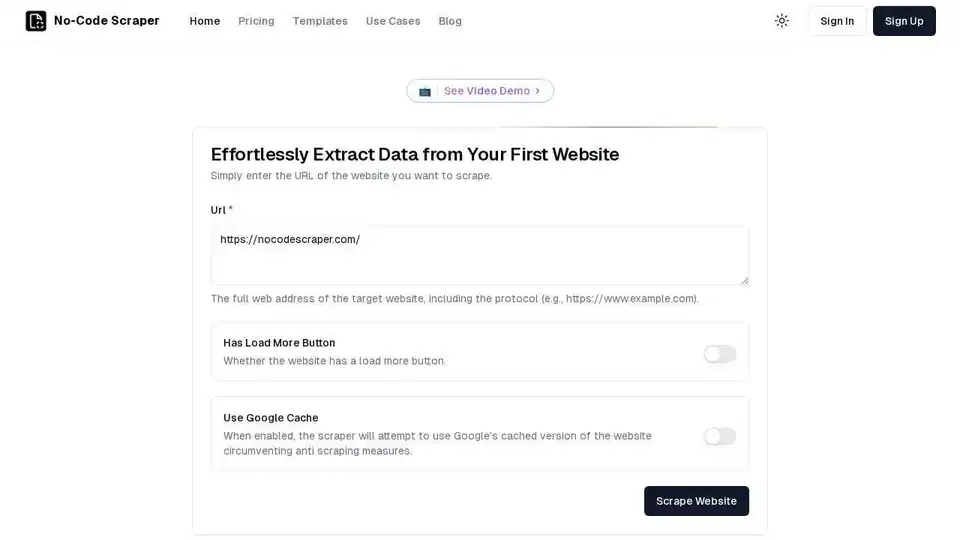

No-Code Scraper ist ein KI-gestütztes Web-Scraping-Tool, mit dem Sie Daten von jeder Website ohne Programmierung extrahieren können. Automatisieren Sie die Datenerfassung mühelos mit der benutzerfreundlichen Oberfläche.

MrScraper ist ein KI-gestützter Web Scraper, der Daten einfach und ohne Blockierung von Websites extrahiert. Er vereinfacht das Data Scraping und die Automatisierung und macht Daten für jeden zugänglich.

BrowserAct ist ein KI-gestützter Web Scraper und ein Automatisierungstool, mit dem Sie Daten von jeder beliebigen Website ohne Programmierung extrahieren können. Automatisieren Sie Arbeitsabläufe und integrieren Sie sich in Tools wie n8n und Make.

Thunderbit ist eine AI Web Scraper Chrome-Erweiterung, mit der Sie jede Website mit 2 Klicks scrapen können. Es verwendet KI, um Daten zu extrahieren und bietet vorgefertigte Vorlagen. Kostenlose Stufe verfügbar.

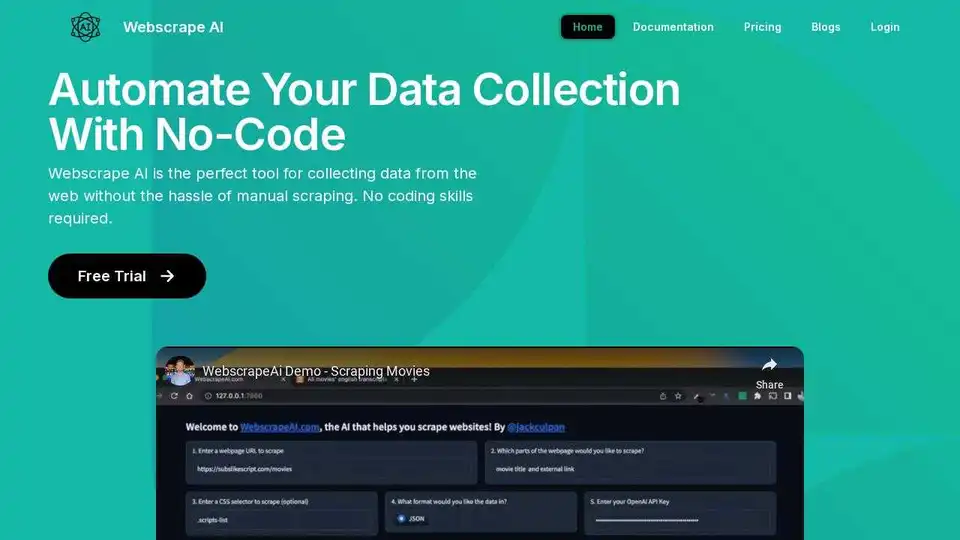

Webscrape AI ist ein No-Code-Tool zur Automatisierung der Web-Datenerfassung mithilfe von KI. Extrahieren Sie einfach Daten, indem Sie URLs und die gewünschten Elemente eingeben; es sind keine Programmierkenntnisse erforderlich.