Arquitectura y Principios de Funcionamiento del Servidor MCP: Del Protocolo al Flujo de Ejecución

A medida que los sistemas de IA evolucionan, se vuelven cada vez más complejos. Los paradigmas tradicionales de llamada a API (como solicitudes HTTP independientes y SDKs específicos del proveedor) enfrentan desafíos como baja eficiencia de desarrollo, altos riesgos de seguridad y poca mantenibilidad al construir sistemas sofisticados de Agentes de IA. Por ejemplo, las definiciones de API independientes carecen de un estándar unificado; diferentes modelos proporcionan especificaciones de llamada a funciones variadas; y hay una falta de mecanismos eficientes de descubrimiento de capacidades e integración dinámica.

El Protocolo de Contexto del Modelo (MCP) surgió para resolver estos problemas. A través de la estandarización a nivel de protocolo, introduce un mecanismo extensible y transversal para la llamada de herramientas y recursos, permitiendo a los agentes de IA colaborar de manera robusta con sistemas externos. La filosofía de diseño central de MCP radica en la abstracción del protocolo y la separación de responsabilidades. No dicta implementaciones específicas, sino que define un lenguaje universal para la interacción entre aplicaciones de IA y capacidades externas.

Este artículo ofrece una explicación autorizada de la arquitectura del Servidor MCP, los principios del protocolo y el flujo de ejecución, destacando por qué se prefiere una capa de protocolo sobre un SDK y cómo MCP soporta la llamada escalable de herramientas requerida por los sistemas inteligentes modernos.

Audiencia Objetivo:

- Entusiastas de la tecnología y estudiantes principiantes

- Profesionales y gerentes que buscan mejoras de eficiencia

- Tomadores de decisiones empresariales y jefes de departamento de negocios

- Usuarios generales interesados en las futuras tendencias de la IA

Contenidos:

- 1. Filosofía de Diseño Central del Protocolo MCP

- 2. Componentes Clave de MCP

- 3. MCP vs. Integración Tradicional de API: Paradigmas Arquitectónicos

- 4. Cómo Colaboran los Servidores MCP con los Agentes de IA

- 5. Las Tres Primitivas de Capacidad Central de MCP

- 6. Relación de Comunicación: Cliente MCP, Servidor y LLM

- 7. Proceso Completo de Llamada del Servidor MCP

- 8. MCP vs. Llamada a API / Función Tradicional: Diferencias en la Capa de Interfaz del Modelo

- 9. Limitaciones y Desafíos de MCP

- Conclusión

- Preguntas Frecuentes (FAQ) de MCP

1. Filosofía de Diseño Central del Protocolo MCP

MCP elige la abstracción a nivel de protocolo, ofreciendo ventajas clave como la estandarización, independencia del lenguaje y una gran universalidad, en lugar de proporcionar un SDK unificado. Esto significa que cualquier programa que implemente la especificación del protocolo MCP —independientemente del lenguaje de programación o framework utilizado— puede comunicarse con otros. Este diseño maximiza la apertura ecológica y la interoperabilidad. La comunicación se basa en JSON-RPC 2.0, un protocolo ligero de llamada a procedimiento remoto cuyos formatos estructurados de solicitud y respuesta son ideales para la interacción automatizada entre máquinas.

Formato de Mensaje de Comunicación

MCP utiliza JSON-RPC 2.0 como su formato de mensaje fundamental y estándar de comunicación.

JSON-RPC es un protocolo de llamada a procedimiento remoto (RPC) ligero y sin estado. Utiliza JSON como su formato de datos y puede ser transportado sobre diferentes capas de transporte como STDIO o HTTP.

En MCP, JSON-RPC es responsable de:

- Definir estructuras de mensajes de solicitud/respuesta;

- Estandarizar llamadas a métodos (por ejemplo,

initialize,tools/list,tools/call); - Proporcionar mecanismos extensibles de manejo de errores y procesamiento por lotes.

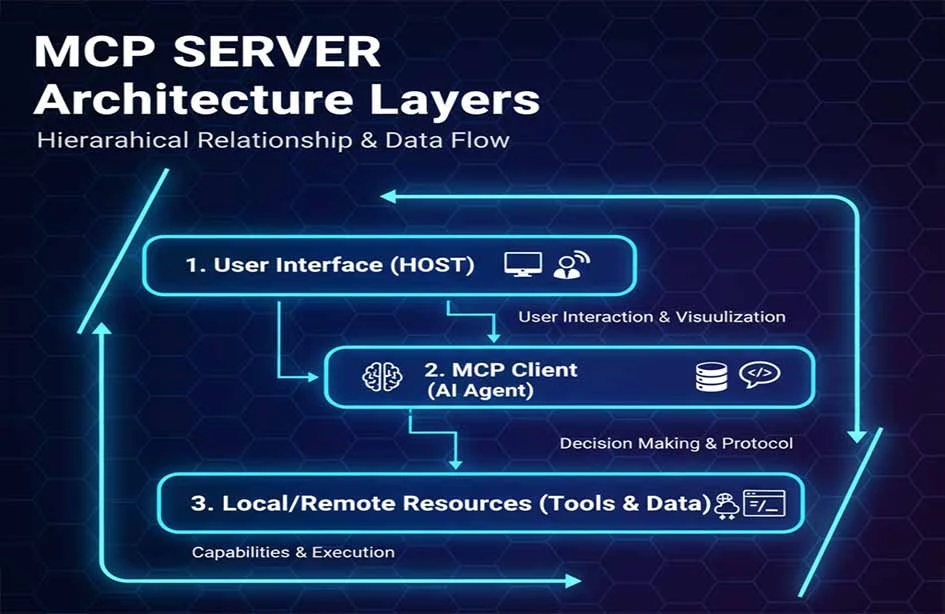

Modelo de Arquitectura de Tres Capas

MCP adopta un modelo de arquitectura de tres capas: Cliente MCP, Servidor MCP y Recurso/Herramienta.

| Hosts MCP |

|---|

| Clientes MCP |

| Servidores MCP |

- Hosts MCP: La aplicación LLM que inicia la solicitud (por ejemplo, Claude Desktop, un IDE o una herramienta de IA).

- Clientes MCP: Ubicados dentro del programa host, manteniendo una conexión 1:1 con el servidor MCP.

- Servidores MCP: Proporcionando contexto, herramientas e información de

promptal cliente MCP.

Este diseño en capas reduce significativamente el acoplamiento entre módulos y mejora la escalabilidad del Servidor MCP.

2. Componentes Clave de MCP

Capa de Transporte El transporte estándar de MCP incluye STDIO y HTTP + Server-Sent Events (SSE), donde SSE proporciona capacidades de transmisión de mensajes del servidor al cliente. Actualmente, MCP define dos mecanismos de transporte estándar para la comunicación cliente-servidor:

- STDIO: Seguridad y Rendimiento Primero. El Servidor MCP se inicia como un proceso hijo y se ejecuta localmente con la aplicación de IA. Utiliza la comunicación interprocesos (IPC) local, ofreciendo baja latencia y fácil implementación. Dado que toda la comunicación permanece local, evita riesgos de red para credenciales y datos. Este es el método preferido para integrar capacidades locales en herramientas de productividad personal como Claude Desktop.

- HTTP with Server-Sent Events (SSE): Accesibilidad y Escalabilidad Primero. El Servidor MCP se implementa como un servicio de red accesible por múltiples clientes remotos. Utiliza HTTP/POST combinado con JSON-RPC para la transmisión de mensajes. Esto es adecuado para centros de capacidades compartidas dentro de empresas o servicios SaaS. HTTPS y la autenticación HTTP estándar proporcionan la base de seguridad.

Este mecanismo permite a MCP soportar tanto llamadas de herramientas simples como servidores distribuidos a gran escala. La elección depende del escenario: STDIO es más eficiente para la comunicación de procesos locales, mientras que HTTP ofrece una mejor escalabilidad para implementaciones de clústeres remotos.

Capa de Protocolo

En la capa de protocolo, MCP utiliza la especificación JSON-RPC 2.0 para definir métodos estándar, como:

- Inicializar conexiones (

initialize); - Descubrimiento de capacidades (

tools/list); - Ejecución de herramientas (

tools/call).

Este diseño variante mantiene la estructura del protocolo central de JSON-RPC al tiempo que introduce semánticas de comunicación específicas de MCP. Herramientas JSON-RPC

Seguridad y Autenticación

MCP no proporciona mecanismos de seguridad directamente. El diseño de seguridad se basa en la implementación específica del Servidor MCP utilizando soluciones establecidas, como:

- Transmisión cifrada HTTPS/TLS;

- Autenticación vía OAuth2, API Keys o mTLS;

- Control de autorización de menor privilegio.

Esto significa que el protocolo MCP en sí no contiene especificaciones de seguridad; en cambio, los implementadores del servidor son responsables de diseñar e integrar sistemas de seguridad de terceros. Por ejemplo, las plataformas empresariales pueden integrar MCP con sistemas de gestión de identidades para un control de acceso seguro, gobernanza y auditoría.

Extensibilidad y Arquitectura de Plugins

La extensibilidad de MCP surge naturalmente de su diseño de protocolo. Desarrollar una "herramienta personalizada" implica crear un programa servidor que implemente el protocolo MCP. Cuando este servidor se inicia y se conecta a la aplicación de IA (Cliente MCP), registra dinámicamente sus herramientas a través del método estándar tools/list. La aplicación de IA descubre y utiliza estas nuevas capacidades sin preconfiguración ni recompilación, logrando una verdadera funcionalidad plug-and-play.

Los Servidores MCP suelen incluir mecanismos para:

- Desarrollo de herramientas personalizadas;

- Registro/descubrimiento dinámico de herramientas y capacidades;

- Soporte de plugins para extender el comportamiento sin modificar el núcleo del protocolo.

Ciclo de Vida de las Herramientas y Gestión de Sesiones

El ciclo de vida de una conexión MCP comienza con el handshake de initialize y termina cuando se cierra la conexión. Durante este período, todas las llamadas a herramientas y lecturas de recursos comparten una sesión lógica. Para los Servidores MCP que necesitan atender a múltiples usuarios o sesiones independientes (especialmente en modo HTTP), la implementación debe gestionar el aislamiento de estado entre diferentes clientes o solicitudes.

El Servidor MCP gestiona:

- Contexto de sesión: Guardar el estado a lo largo de múltiples llamadas;

- Mecanismos de aislamiento: Asegurar que las sesiones entre diferentes clientes estén aisladas para evitar fugas de datos o contaminación del estado.

Esta gestión soporta casos de uso avanzados como sesiones largas y operaciones de varios pasos.

Diseño de Rendimiento y Fiabilidad del Sistema

Como protocolo ligero, el rendimiento de MCP depende en gran medida de la eficiencia de implementación del servidor y la latencia de la red. Para requisitos de alta disponibilidad, se pueden implementar múltiples instancias de Servidor MCP detrás de un balanceador de carga. El protocolo define una interfaz de logging que permite a los servidores enviar registros de ejecución al cliente, lo que constituye la base para la auditoría.

Los diseños de Servidor MCP a menudo incluyen:

- Balanceo de carga para despliegue multi-réplica;

- Recuperación de fallos para asegurar alta disponibilidad;

- Registro y auditoría para rastrear el historial de llamadas y diagnósticos.

Estos mecanismos mejoran la estabilidad para casos de uso a nivel empresarial.

Integración con Ecosistemas Modernos

Para adaptarse a entornos nativos de la nube, los Servidores MCP a menudo colaboran con Kubernetes y balanceadores de carga en la nube para el autoescalado y despliegue elástico. Los Servidores MCP pueden ser containerizados y desplegados en plataformas como Kubernetes, permitiendo comprobaciones de salud y gestión centralizada dentro de las pilas de infraestructura empresarial modernas.

3. MCP vs. Integración Tradicional de API: Paradigmas Arquitectónicos

Comparado con la integración independiente de API, MCP utiliza la abstracción del protocolo para mejorar la seguridad, la mantenibilidad y las capacidades multiplataforma.

| Característica | Servidor MCP | Integración Tradicional de API | Sistemas de Plugins | Modo SDK |

|---|---|---|---|---|

| Estandarización | Estándar de la Industria | Varía por API | Específico de la Plataforma | Específico del Proveedor |

| Costo de Desarrollo | Bajo (Implementar una vez) | Alto | Medio | Alto |

| Complejidad de Mantenimiento | Baja | Muy Alta | Media | Alta |

| Capacidad Multiplataforma | Excelente | Pobre | Pobre | Pobre |

| Modelo de Seguridad | Control Unificado | Fragmentado | Controlado por la Plataforma | Fragmentado |

| Soporte en Tiempo Real | Soporte Nativo | Sondeo/Webhooks | Limitado | Personalizado |

| Ecosistema Comunitario | Crecimiento Rápido | Fragmentado | Cerrado | Bloqueo del Proveedor |

4. Cómo Colaboran los Servidores MCP con los Agentes de IA

En una arquitectura típica de Agente de IA basada en planificación, los componentes incluyen un Planificador, un Ejecutor y una Memoria. El Servidor MCP actúa como el backend de ejecución estandarizado en esta arquitectura.

- Planificador: (Generalmente el LLM) formula estrategias basadas en la entrada. Recupera la lista actual de

Toolsdisponibles y sus descripciones del Cliente MCP. El Planificador luego esquematiza una secuencia de pasos (por ejemplo, "Usar la herramienta A para consultar datos, luego la herramienta B para procesar resultados"). - Ejecutor: (Generalmente el Cliente MCP) emite solicitudes de

tools/callal Servidor MCP correspondiente basándose en el plan. - Memoria: Almacena el estado y el contexto. Los resultados de la ejecución se devuelven al Agente, se almacenan en la Memoria y se utilizan para la planificación posterior. Además, los

Resourcespueden proporcionar de manera proactiva conocimientos de fondo relevantes para la tarea.

El Servidor MCP sirve como proveedor de capacidades para el Ejecutor, permitiendo al Planificador acceder a herramientas y recursos a través de un protocolo estándar.

La posición de MCP en una arquitectura de Agente de IA es similar a la interfaz de un sistema operativo para servicios externos, unificando y estandarizando la ejecución de capacidades.

MCP es complementario a frameworks como LangChain y AutoGen. Mientras que estos frameworks proporcionan abstracción de alto nivel y orquestación para los flujos de trabajo de Agentes de IA, MCP sirve como la capa de ejecución de herramientas estandarizada. Resuelve los problemas de "código pegamento" y fragmentación que estos frameworks enfrentan al integrar herramientas específicas.

5. Las Tres Primitivas de Capacidad Central de MCP

Estas primitivas definen el modelo de datos del protocolo MCP y cómo las aplicaciones de IA interactúan con el servidor.

- Herramientas (Tools): Funciones invocables como operaciones de búsqueda o base de datos. Cada herramienta tiene un nombre, descripción claros y un JSON Schema de parámetros de entrada. El modelo de IA las activa cuando es necesario (por ejemplo, una herramienta

send_email). - Recursos (Resources): Fuentes de datos accesibles como sistemas de archivos o almacenamiento de objetos. Cada recurso tiene un URI y un tipo MIME. Las aplicaciones de IA leen estos contenidos para inyectar contexto en los

prompts(por ejemplo, un recursofile:///reports/weekly.md). - Prompts: Plantillas o contextos predefinidos utilizados para ayudar a la toma de decisiones del LLM. Estos proporcionan una forma estructurada para que los usuarios inicien tareas específicas (por ejemplo, un

prompt"Planificar Viaje de Fin de Semana" que guía al modelo para usar herramientas relevantes).

Este diseño de tres capas permite al Servidor MCP expresar claramente sus funciones ejecutables mientras soporta el descubrimiento dinámico. Además, el protocolo permite a los servidores solicitar la generación del modelo (muestreo de LLM) desde el cliente. Esto permite al servidor usar el LLM del cliente para el razonamiento durante su propia lógica de ejecución. Los clientes deben declarar esta capacidad durante la inicialización para soportarla.

6. Relación de Comunicación: Cliente MCP, Servidor y LLM

Comprender la relación entre estos tres es clave para entender el flujo de trabajo de MCP:

- ¿Quién inicia la conexión? El Cliente MCP (integrado en la aplicación de IA) inicia activamente la conexión con el Servidor MCP.

- ¿Quién decide llamar a una herramienta? El LLM (dentro de la aplicación de IA) toma decisiones basándose en la lógica interna. El Cliente MCP proporciona la lista de herramientas disponibles como contexto, y el LLM decide si llama a una herramienta, cuál y con qué parámetros.

- ¿Quién ejecuta la operación? El Servidor MCP llama al servicio o recurso real. Recibe la solicitud estandarizada

tools/calldel cliente, la traduce en acciones para el sistema subyacente (base de datos, API, archivo) y devuelve el resultado estandarizado.

7. Proceso Completo de Llamada del Servidor MCP

Un flujo de trabajo típico incluye:

- Inicialización: Cliente y Servidor establecen una conexión e intercambian versiones de protocolo y capacidades.

- Descubrimiento de Capacidades: El Cliente recupera la lista de Herramientas y Recursos del Servidor a través de

tools/list. - Llamada a Herramientas: Después de que el LLM toma una decisión, el Cliente emite una solicitud

tools/call. El Servidor ejecuta la operación real. - Inyección de Resultados: El Servidor devuelve resultados estructurados, que el Cliente proporciona de nuevo al LLM para la generación de la respuesta final o para una planificación posterior.

Diagrama de tiempos típico para un protocolo de llamada:

A continuación se muestra un diagrama de tiempos simplificado para un caso de reserva de sala de conferencias, que muestra la interacción del protocolo central desde la inicialización hasta la ejecución:

8. MCP vs. Llamada a API / Función Tradicional: Diferencias en la Capa de Interfaz del Modelo

La integración tradicional de API depende de las especificaciones y SDKs definidos por el proveedor. MCP abstrae el comportamiento de llamada en métodos JSON-RPC, manteniendo una interfaz estándar que es independiente de los SDKs específicos.

- Llamada a Funciones Tradicional: Esta es una capacidad proporcionada por proveedores de modelos específicos. Los desarrolladores definen funciones en el formato del proveedor, y el modelo aprende a generar solicitudes en ese formato. Está ligada a la interfaz propietaria del proveedor.

- Arquitectura MCP: MCP es un protocolo abierto agnóstico al modelo. Define formatos universales y estandarizados para la descripción y llamada de capacidades. Cualquier aplicación de IA que soporte MCP (independientemente del modelo subyacente) puede interactuar con cualquier Servidor MCP. Libera la integración de herramientas del "vendor lock-in" del proveedor del modelo.

MCP es más adecuado para el mantenimiento a largo plazo y la construcción de ecosistemas en entornos de gran escala y multi-modelo.

Límites de Casos de Uso: Si utiliza un único modelo con requisitos de herramientas simples y fijos, la Llamada a Funciones puede ser suficiente. Si está construyendo un sistema de Agente complejo que involucra múltiples modelos y herramientas que requieren escalabilidad a largo plazo, la estandarización y el desacoplamiento proporcionados por MCP son esenciales.

9. Limitaciones y Desafíos de MCP

Aunque el Servidor MCP proporciona una forma estandarizada para que los Agentes de IA interactúen con las herramientas, no es una "bala mágica". Comprender lo que MCP no resuelve y los desafíos en entornos de ingeniería reales es crucial.

1. Conflicto de Capacidades y Gobernanza con Múltiples Servidores MCP

En sistemas complejos, a menudo se conectan múltiples Servidores MCP. Diferentes servidores pueden exponer herramientas con semánticas similares o funciones superpuestas. El protocolo MCP maneja las especificaciones de declaración y llamada, pero no incluye:

- Clasificación de prioridad de herramientas

- Detección o resolución de conflictos

- Estrategia para la selección óptima de herramientas basada en el contexto

Esto significa: La responsabilidad de la toma de decisiones recae completamente en la capa del Cliente MCP o del Agente de IA. El Planificador o módulo de estrategia debe implementar su propia lógica de selección de herramientas. Por lo tanto, MCP es una "capa de exposición y comunicación de capacidades", no un "sistema de programación inteligente".

2. Presión de Contexto por Llamadas a Largo Plazo y Multi-turno

En escenarios de Agentes, las tareas implican múltiples pasos:

- Planificación

- Múltiples llamadas a herramientas (

tools/call) - Inyección de resultados

- Re-razonamiento y toma de decisiones

Este proceso adjunta continuamente información a la ventana de contexto del LLM. Es importante destacar:

- MCP no es responsable de la poda, compresión o resumen del contexto.

- No tiene gestión de memoria o optimización de contexto incorporada.

En tareas largas, esto puede llevar a:

- Aumento rápido de los costos de tokens

- Acercamiento a los límites de contexto del modelo

- Información clave siendo "ahogada"

La gestión del contexto sigue siendo un desafío que debe resolver la capa de arquitectura del Agente, no el protocolo MCP.

3. Diferencias en la Madurez de las Implementaciones por Lenguaje

Aunque el protocolo es agnóstico al lenguaje, la madurez varía en la práctica:

- Los ecosistemas de JavaScript/Node.js y Python son los más maduros.

- Las implementaciones para Rust, Go y Java aún están evolucionando.

- El soporte para las últimas especificaciones puede variar entre implementaciones.

Los equipos de ingeniería deben:

- Asegurar la coherencia entre las implementaciones y las especificaciones.

- Evaluar la estabilidad y el mantenimiento de las implementaciones del Servidor MCP para entornos de producción.

Esto es común para cualquier protocolo emergente en sus etapas iniciales.

4. La Seguridad y los Permisos Dependen de Sistemas Externos

MCP está diseñado para ser "neutral al protocolo" y no incluye un sistema de seguridad incorporado. Específicamente:

- MCP define límites de capacidad (Herramientas / Recursos).

- No impone mecanismos específicos de autenticación, autorización o auditoría.

En un despliegue en el mundo real, la seguridad debe implementarse a través de sistemas externos como:

- OAuth / OIDC

- API Gateways

- Arquitecturas de Confianza Cero (Zero Trust)

- Sistemas IAM empresariales

Un Servidor MCP debe ser visto como:

Un servicio de capacidades envuelto en un sistema de seguridad, en lugar del propio centro de control de seguridad.

Esta es una razón clave por la que MCP puede adaptarse de forma flexible a diferentes empresas y entornos de nube, pero también aumenta la complejidad del diseño del sistema.

5. Rápida Evolución del Protocolo y el Ecosistema

Como nuevo protocolo para Agentes de IA, MCP está evolucionando rápidamente:

- Los detalles del protocolo y las primitivas están siendo refinados.

- Existe un decalaje temporal para que las diferentes implementaciones soporten nuevas características.

- Las mejores prácticas para casos de uso avanzados aún se están estableciendo.

MCP debe ser visto como un protocolo de infraestructura a largo plazo en lugar de un estándar finalizado y estático.

Los Servidores MCP se centran en proporcionar una forma estandarizada de descubrir, llamar y combinar herramientas. Comprender estas limitaciones ayuda a los desarrolladores a:

- Definir límites claros de responsabilidad.

- Evitar la dependencia excesiva del protocolo en sí.

- Resolver la complejidad en la capa arquitectónica apropiada.

Conclusión

En la ingeniería práctica, MCP actúa como una "fundación de protocolo de capacidades", cuyo valor se hace más evidente a medida que crece la complejidad del sistema. El Servidor MCP no reemplaza las API tradicionales o la Llamada a Funciones; en cambio, proporciona una capa de protocolo estandarizada, extensible y segura para los Agentes de IA. Al introducir esta capa, aborda los desafíos de ingeniería centrales de la escalabilidad de los Agentes de IA: reduciendo la complejidad de integración de N×M a N+M, proporcionando un marco para el descubrimiento dinámico y la ejecución segura, y desacoplando el ecosistema de herramientas de los modelos de IA. Esto permite a los agentes inteligentes:

- Acceder a capacidades sistemáticamente;

- Descubrir y llamar dinámicamente herramientas/recursos;

- Interoperar entre modelos y plataformas.

MCP sienta las bases para un ecosistema de herramientas de IA rico y componible. Marca un cambio de la "integración manual" a la "infraestructura estandarizada", proporcionando una base para construir sistemas de IA empresariales interoperables, escalables y seguros.

Preguntas Frecuentes (FAQ) de MCP

1. ¿Reemplazará MCP a las API tradicionales o a la Llamada a Funciones?

No. MCP no es un reemplazo, sino que actúa a un nivel superior, permitiendo al Cliente MCP descubrir dinámicamente capacidades de un Servidor MCP a través del método list.

- Para escenarios simples, fijos y de un solo modelo, la Llamada a Funciones es eficiente.

- Para sistemas de Agentes multi-modelo, multi-herramienta y en evolución, MCP ofrece un mejor desacoplamiento y mantenibilidad.

En sistemas del mundo real, los dos a menudo tienen una relación complementaria.

2. ¿Requiere MCP un LLM específico?

No. MCP es agnóstico al modelo. Regula la comunicación entre el Cliente y el Servidor y no le importa si el modelo subyacente es de OpenAI, Anthropic, Google o un modelo de código abierto local. Mientras la aplicación de IA pueda exponer el contexto de la herramienta e iniciar llamadas según el protocolo MCP, puede usar el Servidor MCP.

3. ¿Tiene MCP seguridad incorporada?

No. Es neutral al protocolo. La seguridad (HTTPS, OAuth2, IAM) debe ser proporcionada por el entorno de despliegue y los sistemas externos.

4. ¿Cómo se manejan los conflictos de herramientas con múltiples Servidores MCP?

MCP no resuelve conflictos. Si varios servidores ofrecen herramientas similares, la responsabilidad de la selección y prioridad de las herramientas recae en el Cliente o en la capa de Planificación del Agente.

5. ¿Causa MCP el inflado de la ventana de contexto?

Puede hacerlo, pero este es un desafío inherente de los Agentes LLM. MCP no gestiona el contexto; el resumen y la gestión de la memoria son responsabilidad de la arquitectura del Agente.

6. ¿Es MCP adecuado para uso empresarial de alta concurrencia?

Sí, siempre que la implementación sea robusta. La alta concurrencia depende de la calidad del servidor, el despliegue multi-instancia y arquitecturas nativas de la nube como Kubernetes.

7. ¿Es alto el costo de adoptar MCP?

La codificación es relativamente simple, pero requiere una comprensión arquitectónica de los sistemas de Agentes y la gobernanza de herramientas. Es más adecuado para equipos que construyen aplicaciones de IA de tamaño medio a grande.

8. ¿Es MCP "estable"?

El diseño central es estable, pero el ecosistema aún está evolucionando. Es un protocolo de infraestructura con visión de futuro más que una solución "única y terminada".

9. ¿Es MCP adecuado para desarrolladores individuales?

Sí, si hay una necesidad de escalabilidad. Para proyectos muy simples, podría ser "excesivo", pero evita altos costos de refactorización a medida que un sistema crece.

10. ¿Qué problema resuelve MCP mejor?

Sobresale en la estandarización del acceso a múltiples herramientas/servicios, desacoplando el descubrimiento de capacidades de la ejecución y permitiendo la reutilización de capacidades entre diferentes modelos y equipos.

Serie de artículos de MCP:

- Análisis Integral del Servidor MCP: El Centro de Comunicación de Contexto y Herramientas en la Era de los Agentes de IA

- ¿Qué Problemas Clave Resuelve el Servidor MCP? Por Qué los Agentes IA lo Necesitan

- Arquitectura y Principios de Funcionamiento del Servidor MCP: Del Protocolo al Flujo de Ejecución

- Guía Práctica de MCP Server: Construcción, Pruebas y Despliegue de 0 a 1

- Guía de Evaluación y Selección Técnica de Escenarios de Aplicación del Servidor MCP

Sobre el Autor

Este contenido es compilado y publicado por el Equipo Editorial de Contenido de NavGood. NavGood es una plataforma centrada en herramientas de IA y ecosistemas de aplicaciones, que rastrea el desarrollo e implementación de Agentes de IA, flujos de trabajo automatizados e IA Generativa.

Descargo de responsabilidad: Este artículo representa el entendimiento y la experiencia personal del autor. No representa la posición oficial de ningún framework o empresa y no constituye asesoramiento comercial o de inversión.

Referencias: [1]: https://json-rpc.dev/learn/mcp-basics "Entendiendo JSON-RPC para la Integración de IA" [2]: https://modelcontextprotocol.io/docs/learn/architecture "Visión general de la arquitectura - Model Context Protocol" [3]: https://json-rpc.org/specification "Especificación JSON-RPC 2.0" [4]: https://modelcontextprotocol.io/docs/learn/architecture "Sobre MCP: Visión general de la arquitectura"