DeepSeek V3

Descripción general de DeepSeek V3

¿Qué es DeepSeek V3?

DeepSeek V3 es un innovador modelo de lenguaje de gran escala de código abierto que cuenta con impresionantes 671 mil millones de parámetros, con 37 mil millones activados por token para un procesamiento eficiente. Desarrollado como una solución de IA de vanguardia, permite a los usuarios aprovechar la comprensión y generación avanzada de lenguaje natural sin las barreras de coste o restricciones propietarias. Ya sea que estés explorando la IA para investigación, desarrollo o proyectos comerciales, DeepSeek V3 destaca por su accesibilidad y rendimiento, convirtiéndolo en una opción principal entre los modelos de IA gratuitos en el panorama en rápida evolución de las herramientas de aprendizaje automático.

Este modelo no es solo otra iteración: está diseñado para rivalizar con los sistemas propietarios líderes mientras permanece completamente de código abierto. Lanzado con un enfoque en escalabilidad y usabilidad, DeepSeek V3 admite una generosa longitud de contexto de 128K, permitiendo manejar entradas extensas como documentos largos o conversaciones complejas. Su arquitectura optimiza tanto la profundidad como la eficiencia, garantizando salidas de alta calidad incluso en hardware modesto cuando se ejecuta localmente.

¿Cómo funciona DeepSeek V3?

En su núcleo, DeepSeek V3 opera con una arquitectura basada en transformadores, un elemento básico en los modelos de lenguaje de gran escala modernos. Los 671B parámetros del modelo le permiten capturar patrones intrincados en vastos conjuntos de datos, desde tareas de procesamiento de lenguaje natural hasta generación de contenido creativo. Por cada token procesado, solo se activan 37B parámetros, lo cual es un enfoque inteligente de mezcla de expertos (MoE) que reduce la sobrecarga computacional sin sacrificar capacidad. Esto significa tiempos de inferencia más rápidos y menores demandas de recursos en comparación con modelos densos de escala similar.

Los usuarios pueden interactuar con DeepSeek V3 de dos formas principales: a través de una demostración en línea intuitiva o descargando el código fuente completo para implementación local. La versión en línea se ejecuta directamente en tu navegador, aprovechando la infraestructura en la nube para acceso instantáneo—sin configuración requerida. En el lado local, la implementación de código abierto en GitHub proporciona todo lo necesario: pesos del modelo, código y documentación. La integración es sencilla a través de endpoints de API, compatible con frameworks populares como la biblioteca Hugging Face Transformers de Python. Por ejemplo, los desarrolladores pueden cargar el modelo con un comando simple y comenzar a generar texto, asistencia de codificación o incluso traducciones.

El entrenamiento del modelo enfatiza diversas fuentes de datos, incluyendo textos multilingües, repositorios de código y literatura científica, resultando en un rendimiento robusto en todos los dominios. Su naturaleza de código abierto también invita a contribuciones de la comunidad, fomentando mejoras continuas a través de forks y pull requests en GitHub.

¿Cómo usar DeepSeek V3?

Comenzar con DeepSeek V3 es notablemente simple, alineándose con su ethos de acceso a IA sin barreras.

Demostración en línea: Dirígete a la plataforma DeepSeek Online y haz clic en 'Probar ahora'. No se necesita registro ni tarjeta de crédito—solo escribe tu prompt y recibe respuestas en segundos. Esto es ideal para pruebas rápidas, lluvia de ideas o evaluar las fortalezas del modelo en tiempo real.

Instalación local: Visita el repositorio de GitHub para descargar los modelos DeepSeek-V3-Base o DeepSeek-V3 completos. Los requisitos del sistema varían: se recomienda una GPU con al menos 24GB de VRAM para un rendimiento óptimo, aunque el modo solo CPU funciona para tareas más ligeras. La instalación implica clonar el repo, instalar dependencias via pip y ejecutar scripts de inferencia. Documentos completos te guían a través de técnicas de cuantización para adaptar el modelo a hardware de consumo.

Integración API: Para aplicaciones de producción, usa los wrappers de API proporcionados. Integra DeepSeek V3 en chatbots, herramientas de contenido o pipelines de análisis. Ejemplos de fragmentos de código en el repo demuestran cómo manejar solicitudes, gestionar contextos y ajustar para casos de uso específicos.

El acceso ilimitado significa que puedes experimentar libremente, sin límites de tasa en la demostración en línea. Para uso comercial, la licencia permisiva permite redistribución y modificación, siempre que se atribuya.

¿Por qué elegir DeepSeek V3?

En un mercado inundado de servicios de IA pagados, DeepSeek V3 destaca por su modelo de costo cero y una apertura sin igual. He aquí por qué es un cambio de juego:

Poder inigualable sin costo: Con 671B parámetros, ofrece salidas comparables a modelos de primer nivel como GPT-4 en benchmarks de razonamiento, codificación y tareas multilingües. Sin embargo, es completamente gratuito, incluso para empresas que escalan soluciones de IA.

Libertad comercial: A diferencia de muchos niveles gratuitos que restringen el uso, DeepSeek V3 permite aplicación comercial completa. Startups y empresas pueden construir productos generadores de ingresos sin tarifas de licencia.

Excelencia impulsada por la comunidad: Respaldado por una vibrante comunidad de GitHub, el modelo se beneficia de actualizaciones rápidas, correcciones de errores y extensiones. Las contribuciones de los usuarios ya han mejorado sus capacidades de ajuste fino para dominios especializados como texto legal o médico.

Versátil y eficiente: La ventana de contexto de 128K admite generación de formato largo, mientras que la activación MoE mantiene bajo el uso de energía—crucial para el desarrollo sostenible de IA.

En comparación con los competidores, DeepSeek V3 a menudo supera en métricas de eficiencia. Por ejemplo, en benchmarks de codificación, genera scripts de Python funcionales con menos errores que modelos abiertos más pequeños, y su soporte multilingüe supera a alternativas centradas en inglés.

¿Para quién es DeepSeek V3?

DeepSeek V3 satisface a una amplia audiencia en el ecosistema de IA:

Desarrolladores e investigadores: Ideal para prototipar aplicaciones de IA, experimentar con ajuste fino o avanzar proyectos de aprendizaje automático. Su código de código abierto acelera la innovación sin bloqueo de proveedor.

Empresas y startups: Perfecto para integración de IA rentable en bots de servicio al cliente, automatización de contenido o herramientas de análisis de datos. La licencia comercial elimina obstáculos legales para monetización.

Educadores y estudiantes: Usa la demostración en línea para aprendizaje práctico sobre modelos de lenguaje de gran escala. Es una forma práctica de enseñar conceptos de PLN sin suscripciones costosas.

Creadores de contenido y aficionados: Genera artículos, fragmentos de código o escritura creativa sin esfuerzo. El acceso gratuito ilimitado lo hace accesible para usuarios casuales que exploran el potencial de la IA.

Si buscas el mejor modelo de IA gratuito para tareas como escritura automatizada de informes, depuración de código o traducción multilingüe, DeepSeek V3 encaja perfectamente.

Casos de uso principales y valor práctico

La versatilidad de DeepSeek V3 desbloquea numerosas aplicaciones:

Generación de lenguaje natural: Redacta correos, blogs o copia de marketing con precisión consciente del contexto. Por ejemplo, ingresa un esquema de tema y obtén un artículo pulido de 1000 palabras.

Asistencia de codificación: Actúa como un compañero de programación de IA, sugiriendo completados, revisando código o explicando algoritmos. Los desarrolladores reportan flujos de trabajo 30-50% más rápidos al usarlo junto con IDEs.

Investigación y análisis: Resume papers, genera hipótesis o analiza conjuntos de datos. Su contexto largo maneja documentos de investigación completos, ayudando a académicos en revisiones de literatura.

Aplicaciones multilingües: Soporta más de 20 idiomas, haciéndolo valioso para equipos globales en traducción, localización o soporte al cliente internacional.

El valor práctico radica en democratizar la IA de gama alta. Al eliminar muros de pago, nivela el campo de juego, permitiendo a equipos pequeños competir con gigantes tecnológicos. Los usuarios elogian su confiabilidad en FAQs, notando configuración rápida y resultados consistentes. Una consulta común: "¿Es realmente gratuito para uso comercial?" Sí—descarga e implementa sin condiciones.

Para requisitos del sistema, las ejecuciones locales necesitan hardware robusto (por ejemplo, GPUs NVIDIA A100 para velocidad completa), pero las versiones cuantizadas se ejecutan en laptops. Las FAQs de integración cubren solución de problemas, como manejar claves de API u optimizar para dispositivos edge.

Preguntas frecuentes

¿Cuáles son los requisitos del sistema para ejecutar DeepSeek V3?

Para uso local, una máquina con 80+ GB de RAM y una GPU de gama alta es ideal. Las opciones en la nube a través de la demostración en línea evitan esto.

¿Puedo integrar DeepSeek V3 en mis aplicaciones existentes?

Absolutamente—usa la documentación de GitHub para configuración de API. Es compatible con los principales frameworks de ML.

¿Cómo se compara DeepSeek V3 con otros modelos de IA?

Iguala o supera a muchos en benchmarks de eficiencia y calidad de salida, todo mientras es gratuito y abierto.

En resumen, DeepSeek V3 representa el futuro de la IA accesible, combinando poder bruto con diseño amigable para el usuario. Ya seas un ingeniero de IA experimentado o un principiante curioso, este modelo ofrece valor tangible al simplificar capacidades avanzadas. Descarga hoy desde GitHub o prueba la demostración en línea para ver por qué es aclamado como el modelo de IA gratuito más potente disponible.

Mejores herramientas alternativas a "DeepSeek V3"

Lunary es una plataforma de ingeniería LLM de código abierto que proporciona observabilidad, gestión de prompts y análisis para construir aplicaciones de IA confiables. Ofrece herramientas para la depuración, el seguimiento del rendimiento y la garantía de la seguridad de los datos.

MemoriPy es una capa de memoria AI de código abierto que equipa a los agentes de AI con memoria similar a la humana, lo que permite conversaciones ricas en contexto y una mayor precisión. Ideal para bots de soporte, asistentes personales y agentes de aprendizaje.

Defog.ai proporciona análisis de datos impulsado por IA mediante LLM ajustados, lo que permite a los usuarios obtener rápidamente información de los datos empresariales a través de SQLCoder. Ideal para organizaciones basadas en datos.

FinGPT: Un modelo de lenguaje grande financiero de código abierto para democratizar los datos financieros, el análisis de sentimientos y la previsión. Ajuste fino rápidamente para obtener información oportuna del mercado.

Stable Code Alpha es el primer producto de IA generativa LLM de Stability AI para la codificación, diseñado para ayudar a los programadores y proporcionar una herramienta de aprendizaje para los nuevos desarrolladores.

CrewAI es una plataforma multi-agente de código abierto que permite construir y orquestar flujos de trabajo de automatización IA con cualquier LLM y plataforma en la nube para aplicaciones empresariales.

ChatTTS es un modelo de texto a voz de código abierto optimizado para escenarios conversacionales, compatible con chino e inglés con síntesis de voz de alta calidad entrenada con 100,000 horas de datos.

vLLM es un motor de inferencia y servicio de alto rendimiento y eficiencia de memoria para LLM, que presenta PagedAttention y procesamiento por lotes continuo para un rendimiento optimizado.

Explora Qwen3 Coder, el avanzado modelo de generación de código IA de Alibaba Cloud. Aprende sobre sus características, benchmarks de rendimiento y cómo usar esta herramienta open-source poderosa para el desarrollo.

Acuration IQ es un decodificador de mercado impulsado por IA que transforma datos complejos en información útil para sinergias B2B, investigación de mercado y toma de decisiones basada en datos.

Predibase es una plataforma de desarrolladores para ajustar y servir LLM de código abierto. Logre una precisión y velocidad inigualables con la infraestructura de entrenamiento y servicio de extremo a extremo, que incluye el ajuste fino de refuerzo.

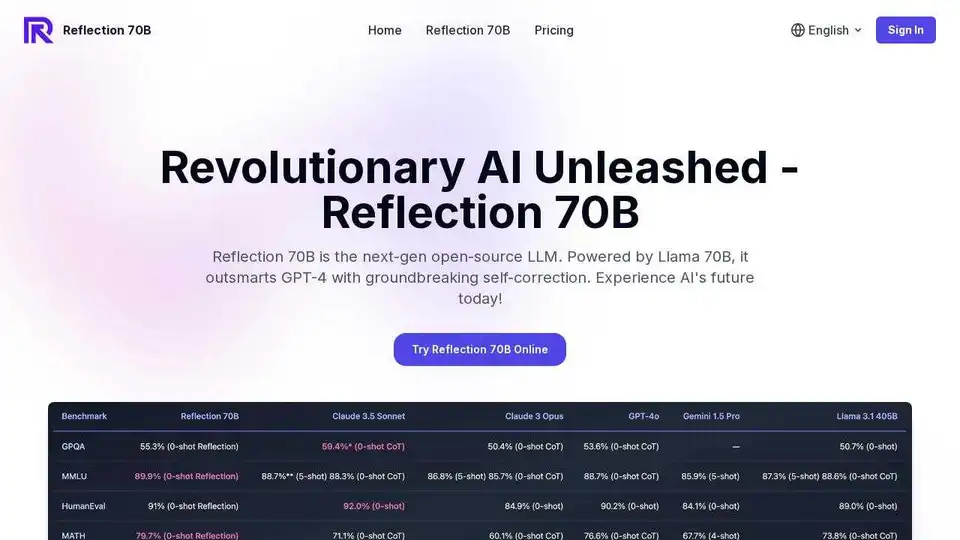

Experimente Reflection 70B, el modelo de IA de código abierto líder en el mundo. Entrenado con Reflection-Tuning, detecta y corrige errores de razonamiento en tiempo real, lo que lo hace perfecto para tareas complejas.

Pruebe Reflection 70B en línea, un LLM de código abierto basado en Llama 70B. Supera a GPT-4 con una innovadora autocorrección. Prueba gratuita en línea disponible.

DeepSeek v3 es un potente LLM impulsado por IA con 671B parámetros, que ofrece acceso a la API y un artículo de investigación. Pruebe nuestra demostración en línea para obtener un rendimiento de última generación.