Robots.txt Generator

Descripción general de Robots.txt Generator

Generador de Robots.txt: Crea el archivo robots.txt perfecto

¿Qué es un archivo robots.txt?

Un archivo robots.txt es un archivo de texto que indica a los rastreadores de los motores de búsqueda qué páginas o archivos pueden o no solicitar a tu sitio. Es importante para el SEO porque te ayuda a controlar qué partes de tu sitio web se indexan, evitando que los rastreadores accedan a contenido sensible o duplicado.

¿Cómo funciona el Generador de Robots.txt?

Esta herramienta gratuita de Generador y validador de Robots.txt ayuda a webmasters, expertos en SEO y marketers a crear rápida y fácilmente este archivo requerido. Puedes personalizar el archivo configurando directivas (permitir o no permitir el rastreo), la ruta (páginas y archivos específicos) y los bots que deben seguir las directivas. O puedes elegir una plantilla de robots.txt ya hecha que contenga un conjunto de las directivas generales y de CMS más comunes. También puedes agregar un mapa del sitio al archivo.

Características Clave:

- Configuraciones Predeterminadas:

- Permitir que todos los robots accedan a todo el sitio.

- Bloquear que todos los robots accedan a todo el sitio.

- Bloquear un directorio o archivo específico.

- Permitir solo un robot específico (por ejemplo, Googlebot) y bloquear a todos los demás.

- Bloquear parámetros de URL específicos.

- Permitir el rastreo de un directorio específico y bloquear todo lo demás.

- Bloquear imágenes de un directorio específico.

- Bloquear el acceso a archivos CSS y JS.

- Plantillas de CMS: Plantillas de robots.txt ya hechas para plataformas de CMS populares, incluyendo:

- WordPress

- Shopify

- Magento

- Drupal

- Joomla

- PrestaShop

- Wix

- BigCommerce

- Squarespace

- Weebly

- Bloqueo de Bots de AI: Configuraciones opcionales para bloquear o permitir bots de AI específicos, como:

- GPTBot

- ChatGPT-User

- Google-Extended

- PerplexityBot

- Amazonbot

- ClaudeBot

- Omgilibot

- FacebookBot

- Applebot

- y muchos más.

- Integración del Mapa del Sitio: Opción para agregar la URL de tu mapa del sitio al archivo robots.txt.

Cómo usar el Generador de Robots.txt:

- Comienza con una Configuración Predeterminada: Elige una configuración base que coincida con tus requisitos. Las opciones incluyen permitir todos los robots, bloquear todos los robots o bloquear directorios o archivos específicos.

- Personaliza las Directivas: Configura las directivas para permitir o no permitir el rastreo, especifica las rutas (páginas y archivos específicos) e identifica los bots que deben seguir las directivas.

- Selecciona una Plantilla: Elige una plantilla de robots.txt ya hecha para plataformas de CMS comunes.

- Agrega un Mapa del Sitio: Incluye la URL de tu mapa del sitio para ayudar a los bots a rastrear el contenido de tu sitio web de manera más eficiente.

- Descarga e Implementa: Descarga el archivo robots.txt generado y agrégalo a la carpeta raíz de tu sitio web.

¿Cómo agregar el archivo robots.txt generado a tu sitio web?

Los motores de búsqueda y otros bots de rastreo buscan un archivo robots.txt en el directorio principal de tu sitio web. Después de generar el archivo robots.txt, agrégalo a la carpeta raíz de tu sitio web, que se puede encontrar en https://yoursite.com/robots.txt.

El método para agregar un archivo robots.txt depende del servidor y del CMS que estés utilizando. Si no puedes acceder al directorio raíz, contacta con tu proveedor de alojamiento web.

Beneficios de Usar el Generador de Robots.txt:

- Optimización SEO: Controla qué partes de tu sitio web se indexan por los motores de búsqueda, mejorando el rendimiento SEO de tu sitio.

- Personalización: Adapta el archivo robots.txt a tus necesidades específicas con varias directivas y plantillas.

- Control de Bots de AI: Bloquea o permite que bots de AI específicos rastreen tu sitio.

- Fácil Integración del Mapa del Sitio: Agrega la URL de tu mapa del sitio para ayudar a los bots a rastrear el contenido de tu sitio web de manera eficiente.

- Contribución de Código Abierto: Contribuye al proyecto en GitHub para agregar nuevas funciones, corregir errores o mejorar el código existente.

Contribuyendo al Proyecto:

Este es un proyecto de código abierto y todos son bienvenidos a participar. Puedes contribuir a este proyecto agregando nuevas funciones, corrigiendo errores o mejorando el código existente creando una solicitud de extracción o un problema en nuestro repositorio de GitHub.

Preguntas Frecuentes

¿Cómo envío un archivo robots.txt a los motores de búsqueda?

No necesitas enviar un archivo robots.txt a los motores de búsqueda. Los rastreadores buscan un archivo robots.txt antes de rastrear un sitio. Si encuentran uno, lo leen primero antes de escanear tu sitio.

Si realizas cambios en tu archivo robots.txt y deseas notificar a Google, puedes enviarlo a Google Search Console. Usa el Probador de Robots.txt para pegar el archivo de texto y haz clic en Enviar.

Mejores herramientas alternativas a "Robots.txt Generator"

Rush Analytics: plataforma SEO con seguimiento de排名, investigación de palabras clave, auditoría del sitio y herramientas PBN. Monitorea, descubre y optimiza para un mejor ranking.

Firecrawl es la API líder de rastreo, raspado y búsqueda web diseñada para aplicaciones de IA. Convierte sitios web en datos limpios, estructurados y listos para LLM a escala, impulsando agentes de IA con extracción web confiable sin proxies ni complicaciones.

Flexbe.AI es un creador de sitios web impulsado por IA que genera sitios web en menos de 60 segundos. Ofrece investigación de mercado, diseño y creación de contenido impulsados por IA, junto con un editor profesional y herramientas de comercio electrónico.

Skills.ai: Motor de análisis de datos de IA sin código para líderes empresariales y creadores de contenido. Genere artículos y presentaciones basados en datos al instante para reuniones con clientes y redes sociales.

Transforme cualquier sitio web en datos limpios y estructurados con Skrape.ai. Nuestra API impulsada por IA extrae datos en su formato preferido para el entrenamiento de IA.

ScrapeStorm es una herramienta de web scraping visual impulsada por IA que permite a los usuarios extraer datos de sitios web sin necesidad de codificación. Ofrece identificación inteligente de datos, múltiples opciones de exportación y es compatible con varios sistemas operativos.

FYRAN es un creador de chatbots de IA gratuito que admite respuestas humanas digitales. Cree chatbots personalizados utilizando archivos PDF, texto, MP3 y docx. Intégrelo fácilmente a través de la web, API, JS o HTML.

CoverLetterAI es una herramienta impulsada por IA que genera cartas de presentación personalizadas y optimizadas para ATS en segundos por solo $5 por carta. Sube tu currículum y detalles del puesto para obtener cartas profesionales a medida que ayudan a los buscadores de empleo a conseguir entrevistas.

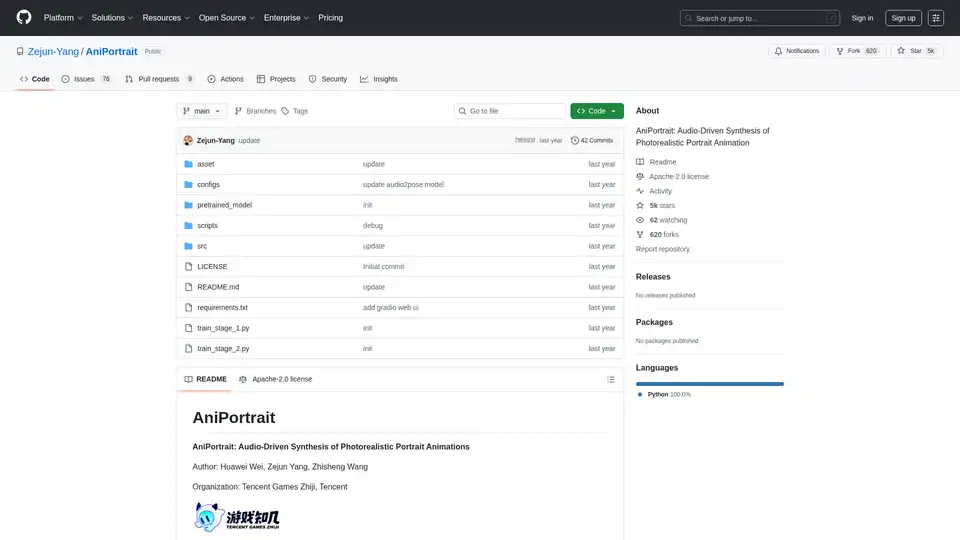

AniPortrait es un marco de IA de código abierto para generar animaciones de retrato fotorrealistas impulsadas por audio o video. Soporta modos autoimpulsados, recreación facial y por audio para síntesis de video de alta calidad.

Explora robótica e IA: descubre robots, herramientas de IA, eventos y trabajos en robótica e IA. Aumenta la productividad y la creatividad con herramientas de IA de primer nivel.

Mejora las conversaciones de Telegram con Bots y Agentes de IA. Invocálos para responder preguntas, ayudar con tareas o crear contenido sin salir de Telegram. Descubre AI Inline Assistant, Llama 3.1, DALL·E, Gemini y más.

Teragon Robotics está desarrollando robots humanoides autorreplicantes utilizando la planificación de IA y hardware modular. Estos robots fabrican componentes de forma autónoma y ensamblan nuevas unidades, abordando los cuellos de botella de fabricación en áreas remotas y devastadas por desastres.

Lucky Robots genera datos sintéticos infinitos para el entrenamiento de modelos de IA robótica. Entrena más rápido y barato con simulaciones realistas. Itera, entrena y prueba antes de la implementación en el mundo real.

Starving Robots ofrece impresión de arte de IA personalizada e impresiones de arte de IA personalizadas. Crea carteles y lienzos únicos con IA.