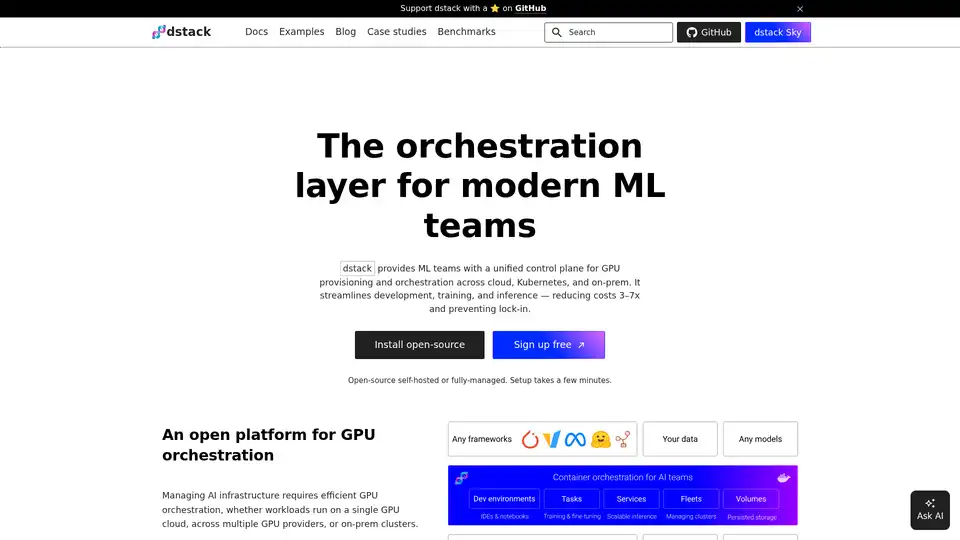

dstack

Descripción general de dstack

¿Qué es dstack?

dstack es un motor de orquestación de contenedores de AI de código abierto diseñado para optimizar los procesos de desarrollo, entrenamiento e inferencia para los equipos de aprendizaje automático (ML). Ofrece un plano de control unificado para el aprovisionamiento y la orquestación de GPU en varios entornos, incluyendo la nube, Kubernetes y la infraestructura local. Al reducir los costos y prevenir el bloqueo del proveedor, dstack permite a los equipos de ML centrarse en la investigación y el desarrollo en lugar de la gestión de la infraestructura.

¿Cómo funciona dstack?

dstack opera como una capa de orquestación que simplifica la gestión de la infraestructura de AI. Se integra de forma nativa con las principales nubes de GPU, automatizando el aprovisionamiento de clústeres y la orquestación de cargas de trabajo. También es compatible con Kubernetes y flotas SSH para la conexión a clústeres locales. Las funcionalidades clave incluyen:

- Orquestación de GPU: Gestiona eficientemente los recursos de GPU en diferentes entornos.

- Entornos de desarrollo: Permite una fácil conexión de los IDE de escritorio a potentes GPU en la nube o locales.

- Puntos de conexión de servicio escalables: Facilita el despliegue de modelos como puntos de conexión seguros, de escalado automático y compatibles con OpenAI.

dstack es compatible con cualquier hardware, herramientas de código abierto y frameworks, ofreciendo flexibilidad y evitando el bloqueo del proveedor.

Características clave de dstack

- Plano de control unificado: Proporciona una única interfaz para gestionar los recursos de GPU en diferentes entornos.

- Integración nativa con nubes de GPU: Automatiza el aprovisionamiento de clústeres y la orquestación de cargas de trabajo con los principales proveedores de nubes de GPU.

- Soporte de Kubernetes y flotas SSH: Se conecta a clústeres locales utilizando Kubernetes o flotas SSH.

- Entornos de desarrollo: Simplifica el bucle de desarrollo permitiendo la conexión a GPU en la nube o locales.

- Puntos de conexión de servicio escalables: Despliega modelos como puntos de conexión seguros, de escalado automático compatibles con OpenAI.

- Tareas de un solo nodo y distribuidas: Soporta tanto experimentos de instancia única como entrenamiento distribuido de múltiples nodos.

¿Por qué elegir dstack?

dstack ofrece varios beneficios convincentes para los equipos de ML:

- Reducción de costos: Reduce los costos de infraestructura en 3-7 veces a través de la utilización eficiente de los recursos.

- Prevención del bloqueo del proveedor: Funciona con cualquier hardware, herramientas de código abierto y frameworks.

- Gestión simplificada de la infraestructura: Automatiza el aprovisionamiento de clústeres y la orquestación de cargas de trabajo.

- Flujo de trabajo de desarrollo mejorado: Simplifica el bucle de desarrollo con entornos de desarrollo fáciles de usar.

Según los testimonios de los usuarios:

- Wah Loon Keng, Sr. AI Engineer @Electronic Arts: "Con dstack, los investigadores de AI de EA pueden iniciar y escalar experimentos sin tocar la infraestructura."

- Aleksandr Movchan, ML Engineer @Mobius Labs: "Gracias a dstack, mi equipo puede acceder rápidamente a GPU asequibles y optimizar nuestros flujos de trabajo desde las pruebas y el desarrollo hasta el despliegue de aplicaciones a gran escala."

¿Cómo usar dstack?

- Instalación: Instale dstack a través de

uv tool install "dstack[all]". - Configuración: Configure backends o flotas SSH.

- Adición de equipo: Agregue a su equipo al entorno de dstack.

dstack se puede implementar en cualquier lugar con la imagen de Docker dstackai/dstack.

¿Para quién es dstack?

dstack es ideal para:

- Equipos de ML que buscan optimizar la utilización de los recursos de GPU.

- Organizaciones que buscan reducir los costos de infraestructura.

- Investigadores de AI que requieren entornos escalables y flexibles para la experimentación.

- Ingenieros que buscan optimizar su flujo de trabajo de desarrollo de ML.

¿Cuál es la mejor manera de orquestar contenedores de AI?

dstack destaca como una solución de primer nivel para la orquestación de contenedores de AI, ofreciendo un enfoque perfecto, eficiente y rentable para la gestión de los recursos de GPU en diversos entornos. Su compatibilidad con Kubernetes, flotas SSH y la integración nativa con las principales nubes de GPU lo convierte en una opción versátil para cualquier equipo de ML que busque mejorar la productividad y reducir los gastos generales de la infraestructura.

Mejores herramientas alternativas a "dstack"

SaladCloud ofrece una nube GPU distribuida, asequible, segura e impulsada por la comunidad para la inferencia de AI/ML. Ahorre hasta un 90 % en costos de computación. Ideal para inferencia de IA, procesamiento por lotes y más.

ClawCloud Run es una plataforma de implementación cloud-native de alto rendimiento con flujos de trabajo GitOps integrados, soporte Docker/Kubernetes, integración GitHub y herramientas de automatización IA.

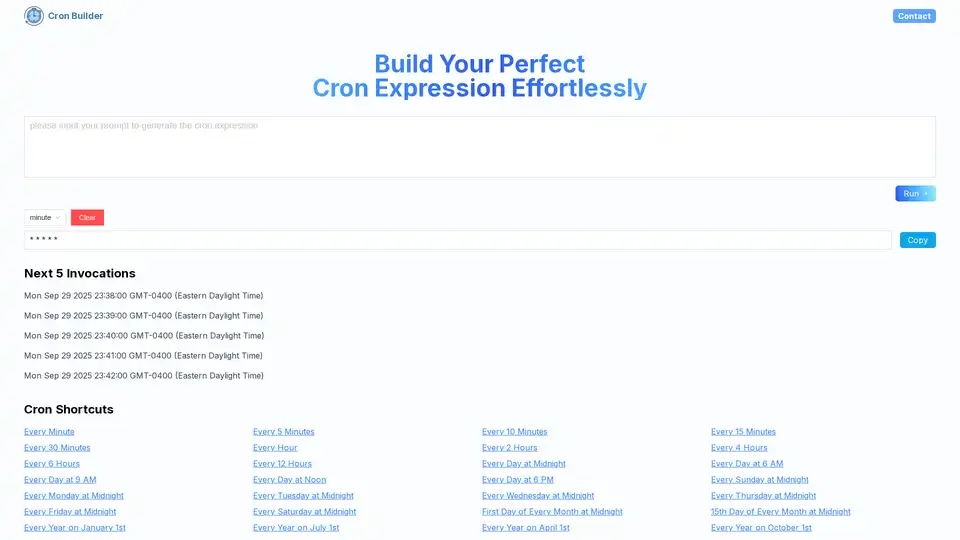

Cron AI Builder es una herramienta en línea que ayuda a los usuarios a generar expresiones cron fácilmente usando descripciones de lenguaje natural y tecnología de IA para la automatización de programación de tareas.

GreetAI ofrece agentes de voz impulsados por IA para cribado eficiente de candidatos, formación de equipos y evaluación de rendimiento en contratación, salud y educación.

Flyte orquesta flujos de trabajo de IA/ML duraderos, flexibles y nativos de Kubernetes. Con la confianza de más de 3000 equipos para la creación e implementación de pipelines escalables.

Union.ai agiliza su ciclo de vida de desarrollo de IA al orquestar flujos de trabajo, optimizar costos y administrar datos no estructurados a escala. Construido sobre Flyte, lo ayuda a construir sistemas de IA listos para producción.

Denvr Dataworks proporciona servicios de computación de IA de alto rendimiento, incluyendo nube GPU bajo demanda, inferencia de IA y una plataforma de IA privada. Acelere su desarrollo de IA con NVIDIA H100, A100 e Intel Gaudi HPU.

Momentum es una plataforma de orquestación de ingresos de IA que captura datos estructurados de las interacciones con los clientes, automatiza la ejecución en los sistemas de ingresos e impulsa ingresos predecibles.

Vellum AI es una plataforma empresarial para la orquestación, evaluación y monitorización de agentes de IA. Construye flujos de trabajo de IA más rápido con un constructor visual y SDK.

Swarm, un marco educativo de OpenAI, facilita la orquestación multiagente ligera. Reemplazado por Agents SDK, está diseñado para flujos de trabajo de IA escalables y coordinación de agentes.

Clari es una plataforma de orquestación de ingresos impulsada por IA que ayuda a las empresas a gestionar sus procesos de ingresos con mayor predictibilidad, eficiencia y crecimiento. Gestiona 5 billones de dólares en ingresos para más de 1.500 clientes.

Vellum AI es una plataforma de orquestación y observabilidad LLM para construir, evaluar y producir flujos de trabajo y agentes de IA empresarial con un constructor visual y SDK.

Tovie AI ofrece una plataforma de nivel empresarial para la orquestación de agentes de IA, búsqueda basada en LLM y consultoría de IA generativa. Agilice la adopción de la IA en los flujos de trabajo empresariales con soluciones escalables y seguras.

Momentum es una plataforma de orquestación de ingresos con IA que transforma las interacciones con los clientes en datos estructurados, automatizando la ejecución en los sistemas de ingresos y proporcionando información en tiempo real para impulsar ingresos predecibles.