Fireworks AI

Descripción general de Fireworks AI

Fireworks AI: El motor de inferencia más rápido para la IA generativa

¿Qué es Fireworks AI? Fireworks AI es una plataforma diseñada para proporcionar las velocidades de inferencia más rápidas para los modelos de IA generativa. Permite a los usuarios construir, ajustar y escalar aplicaciones de IA con facilidad, aprovechando los modelos de código abierto optimizados para diversos casos de uso.

¿Cómo funciona Fireworks AI? Fireworks AI logra un alto rendimiento a través de su motor de inferencia, que está optimizado para baja latencia, alto rendimiento y concurrencia. La plataforma es compatible con modelos populares como DeepSeek, Llama, Qwen y Mistral, lo que permite a los desarrolladores experimentar e iterar rápidamente utilizando los SDK de Fireworks.

Características y beneficios clave

- Inferencia ultrarrápida: Ofrece rendimiento en tiempo real con una latencia mínima, adecuado para aplicaciones de misión crítica.

- Ajuste avanzado: Proporciona herramientas para maximizar la calidad del modelo a través de técnicas como el aprendizaje por refuerzo y el ajuste con reconocimiento de cuantificación.

- Escalado perfecto: Aprovisiona automáticamente las GPU más recientes en múltiples nubes y regiones, lo que garantiza una alta disponibilidad y un rendimiento constante.

- Modelos de código abierto: Admite una amplia gama de modelos de código abierto, que ofrecen flexibilidad y opciones de personalización.

- Listo para la empresa: Incluye características para la colaboración segura en equipo, el monitoreo y el cumplimiento (SOC2 Type II, GDPR, HIPAA).

Casos de uso

Fireworks AI es adecuado para una variedad de aplicaciones, que incluyen:

- Agentes de voz: Potenciando las interacciones de voz en tiempo real con baja latencia.

- Asistentes de código: Mejorando la generación y finalización de código con velocidades de inferencia rápidas.

- Herramientas de desarrollo de IA: Permitiendo el ajuste fino, la búsqueda de código impulsada por IA y el contexto de código profundo para flujos de trabajo de desarrollo mejorados.

¿Por qué es importante Fireworks AI?

Fireworks AI aborda la necesidad de velocidad y escalabilidad en las aplicaciones de IA generativa. Al optimizar la inferencia y proporcionar una escalabilidad perfecta, permite a las empresas implementar funciones de IA a escala sin sacrificar el rendimiento ni la rentabilidad.

¿Para quién es Fireworks AI?

Fireworks AI es ideal para:

- Empresas: Que buscan implementar soluciones de IA con seguridad y cumplimiento de nivel empresarial.

- Desarrolladores: Que buscan una plataforma rápida y flexible para experimentar con modelos de código abierto.

- Investigadores de IA: Que necesitan una infraestructura robusta para entrenar e implementar modelos de IA.

Testimonios de clientes

Varias empresas han tenido éxito con Fireworks AI:

- Cursor: Sualeh Asif, CPO, elogió a Fireworks por su rendimiento y la mínima degradación en la calidad del modelo cuantificado.

- Quora: Spencer Chan, Product Lead, destacó a Fireworks como la mejor plataforma para servir LLM de código abierto y escalar adaptadores LoRA.

- Sourcegraph: Beyang Liu, CTO, señaló la inferencia de modelos rápida y confiable de Fireworks para construir herramientas de desarrollo de IA como Cody.

- Notion: Sarah Sachs, AI Lead, informó una reducción significativa de la latencia al asociarse con Fireworks para ajustar los modelos.

Precios

Fireworks AI ofrece opciones de precios flexibles para adaptarse a diferentes necesidades. Los detalles se pueden encontrar en su página de Precios.

Empezando

Para comenzar a construir con Fireworks AI, visite su sitio web y explore los modelos y la documentación disponibles. También puede ponerse en contacto con su equipo de ventas para obtener soluciones empresariales.

¿Cuál es la mejor manera de aprovechar Fireworks AI? Para maximizar los beneficios de Fireworks AI, comience por identificar su caso de uso específico y seleccionar el modelo de código abierto apropiado. Utilice los SDK de Fireworks para ajustar el modelo y optimizarlo para su aplicación. Aproveche las capacidades de escalado de la plataforma para implementar sus funciones de IA a nivel mundial sin administrar la infraestructura.

Al proporcionar un motor de inferencia robusto y escalable, Fireworks AI permite a los desarrolladores y a las empresas aprovechar el poder de la IA generativa con una velocidad y eficiencia sin precedentes.

Mejores herramientas alternativas a "Fireworks AI"

Plataforma de IA ultrarrápida para desarrolladores. Implementa, ajusta y ejecuta más de 200 LLMs y modelos multimodales optimizados con APIs simples - SiliconFlow.

Xander es una plataforma de escritorio de código abierto que permite el entrenamiento de modelos de IA sin código. Describe tareas en lenguaje natural para pipelines automatizados en clasificación de texto, análisis de imágenes y ajuste fino de LLM, garantizando privacidad y rendimiento en tu máquina local.

vLLM es un motor de inferencia y servicio de alto rendimiento y eficiencia de memoria para LLM, que presenta PagedAttention y procesamiento por lotes continuo para un rendimiento optimizado.

Friendli Inference es el motor de inferencia LLM más rápido, optimizado para la velocidad y la rentabilidad, reduciendo los costos de GPU en un 50-90% al tiempo que ofrece un alto rendimiento y baja latencia.

AI Runner es un motor de inferencia de IA sin conexión para arte, conversaciones de voz en tiempo real, chatbots impulsados por LLM y flujos de trabajo automatizados. ¡Ejecute la generación de imágenes, el chat de voz y más localmente!

Spice.ai es un motor de inferencia de datos e IA de código abierto para construir aplicaciones de IA con federación de consultas SQL, aceleración, búsqueda y recuperación basadas en datos empresariales.

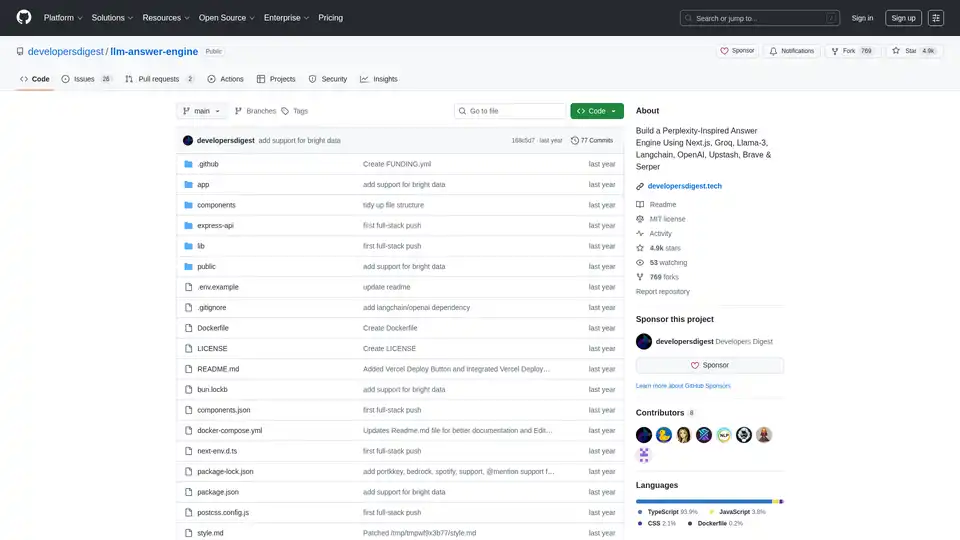

Construye un motor de respuestas de IA inspirado en Perplexity utilizando Next.js, Groq, Llama-3 y Langchain. Obtén fuentes, respuestas, imágenes y preguntas de seguimiento de manera eficiente.

Botpress es una plataforma completa de agentes de IA impulsada por los últimos LLM. Le permite construir, implementar y administrar agentes de IA para atención al cliente, automatización interna y más, con capacidades de integración perfectas.

Rierino es una potente plataforma low-code que acelera el ecommerce y la transformación digital con agentes IA, comercio componible e integraciones fluidas para innovación escalable.

UsageGuard ofrece una plataforma unificada de IA para acceso seguro a LLMs de OpenAI, Anthropic y más, con salvaguardas integradas, optimización de costos, monitoreo en tiempo real y seguridad de grado empresarial para agilizar el desarrollo de IA.

mistral.rs es un motor de inferencia LLM increíblemente rápido escrito en Rust, que admite flujos de trabajo multimodales y cuantización. Ofrece API de Rust, Python y servidor HTTP compatible con OpenAI.

PocketLLM es un motor de búsqueda de conocimiento de IA privado de ThirdAI. Busca en PDFs, documentos y URLs localmente en tu dispositivo. Afina los resultados y resume para facilitar la comprensión.

Mirai es una plataforma de IA en el dispositivo que permite a los desarrolladores implementar IA de alto rendimiento directamente en sus aplicaciones con latencia cero, total privacidad de datos y sin costos de inferencia. Ofrece un motor de inferencia rápido y un enrutamiento inteligente para un rendimiento optimizado.

Groq ofrece una plataforma de hardware y software (LPU Inference Engine) para una inferencia de IA rápida, de alta calidad y de bajo consumo. GroqCloud ofrece soluciones en la nube y on-premise para aplicaciones de IA.