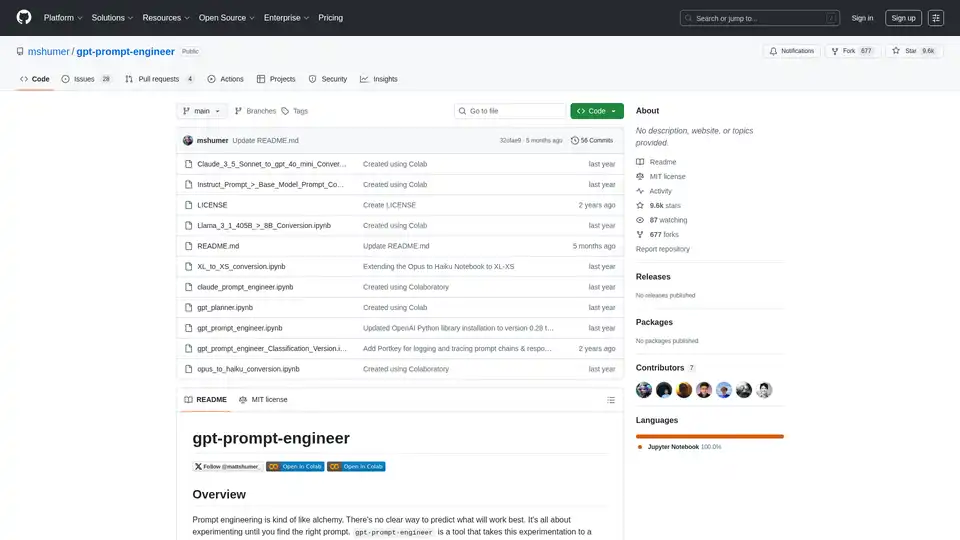

gpt-prompt-engineer

Descripción general de gpt-prompt-engineer

¿Qué es gpt-prompt-engineer?

gpt-prompt-engineer es una herramienta de código abierto diseñada para automatizar el proceso de ingeniería de prompts para modelos de lenguaje grandes (LLMs) como GPT-4, GPT-3.5-Turbo y Claude 3. Ayuda a los usuarios a descubrir prompts óptimos al generar, probar y clasificar múltiples prompts basados en casos de prueba definidos por el usuario.

¿Cómo funciona gpt-prompt-engineer?

- Generación de Prompts: La herramienta utiliza LLMs para generar una amplia gama de prompts basados en una descripción del caso de uso proporcionada y en los casos de prueba asociados.

- Prueba de Prompts: Cada prompt generado se prueba con los casos de prueba proporcionados para evaluar su rendimiento.

- Sistema de Clasificación ELO: Se emplea un sistema de clasificación ELO para clasificar los prompts en función de su rendimiento. Cada prompt comienza con una clasificación ELO inicial, y las clasificaciones se ajustan en función del rendimiento del prompt con respecto a los casos de prueba. Esto permite a los usuarios identificar fácilmente los prompts más eficaces.

Características clave de gpt-prompt-engineer

- Generación Automatizada de Prompts: Genera automáticamente una multitud de prompts potenciales basados en un caso de uso dado y casos de prueba.

- Prueba y Clasificación de Prompts: Prueba sistemáticamente cada prompt con los casos de prueba y los clasifica utilizando un sistema de clasificación ELO para identificar los más eficaces.

- Soporte para Claude 3 Opus: Una versión especializada aprovecha al máximo el modelo Claude 3 Opus de Anthropic, lo que permite la generación automatizada de casos de prueba y múltiples variables de entrada.

- Conversión Claude 3 Opus → Haiku: Esta función permite a los usuarios aprovechar Claude 3 Opus para definir el espacio latente y Claude 3 Haiku para la generación eficiente de resultados, reduciendo la latencia y el coste.

- Versión de Clasificación: Diseñada para tareas de clasificación, esta versión evalúa la corrección de un caso de prueba haciéndolo coincidir con el resultado esperado ('verdadero' o 'falso') y proporciona una tabla con las puntuaciones de cada prompt.

- Registro de Pesos y Sesgos: Registro opcional en Weights & Biases para el seguimiento de las configuraciones, los prompts del sistema y del usuario, los casos de prueba y las clasificaciones ELO finales.

- Integración con Portkey: Ofrece una integración opcional con Portkey para el registro y el seguimiento de las cadenas de prompts y sus respuestas.

¿Cómo se usa gpt-prompt-engineer?

- Configuración: Abra el cuaderno deseado en Google Colab o en un cuaderno Jupyter local. Elija entre la versión estándar, la versión de clasificación o la versión de Claude 3 dependiendo de su caso de uso.

- Configuración de la Clave API: Agregue su clave API de OpenAI o su clave API de Anthropic a la línea designada en el cuaderno.

- Defina el Caso de Uso y los Casos de Prueba: Para la versión GPT-4, defina su caso de uso y sus casos de prueba. El caso de uso es una descripción de lo que quiere que haga la IA, y los casos de prueba son prompts específicos a los que le gustaría que la IA respondiera.

- Configure las Variables de Entrada (para la versión Claude 3): Defina las variables de entrada además de la descripción del caso de uso, especificando el nombre de la variable y su descripción.

- Genere Prompts Óptimos: Llame a la función

generate_optimal_promptcon la descripción del caso de uso, los casos de prueba y el número deseado de prompts a generar. - Evalúe los Resultados: La clasificación ELO final se imprimirá en una tabla, ordenada en orden descendente. Cuanto mayor sea la clasificación, mejor será el prompt. Para la versión de clasificación, las puntuaciones de cada prompt se imprimirán en una tabla.

¿Para quién es gpt-prompt-engineer?

gpt-prompt-engineer es ideal para:

- Desarrolladores e investigadores de IA que buscan optimizar los prompts para LLMs.

- Empresas que buscan mejorar el rendimiento de las aplicaciones impulsadas por la IA.

- Individuos interesados en explorar técnicas de ingeniería de prompts.

- Cualquiera que busque reducir el coste y la latencia de las aplicaciones basadas en LLM.

Casos de Uso:

- Automatización de la generación de titulares de páginas de aterrizaje.

- Creación de respuestas de correo electrónico personalizadas.

- Optimización de los prompts para la generación de contenido.

- Construcción de sistemas de IA rentables utilizando Claude 3 Opus y Haiku.

¿Por qué elegir gpt-prompt-engineer?

- Ahorro de Tiempo: Automatiza el proceso de ingeniería de prompts, ahorrando tiempo y esfuerzo significativos.

- Rendimiento Mejorado: Ayuda a descubrir prompts óptimos que conducen a un rendimiento mejorado de los LLMs.

- Reducción de Costes: Permite la creación de sistemas de IA rentables aprovechando modelos eficientes como Claude 3 Haiku.

- Flexibilidad: Soporta varios LLMs y casos de uso, incluyendo tareas de clasificación.

Licencia

gpt-prompt-engineer tiene licencia MIT.

Enlace del Proyecto

Mejores herramientas alternativas a "gpt-prompt-engineer"

Prompt Genie es una herramienta impulsada por IA que crea instantáneamente super prompts optimizados para LLMs como ChatGPT y Claude, eliminando las complicaciones de la ingeniería de prompts. Prueba, guarda y comparte a través de la extensión de Chrome para resultados 10 veces mejores.

Promptimize AI es una extensión de navegador que mejora los prompts de IA, facilitando que cualquiera use la IA de manera confiable para aumentar la productividad. Ofrece mejoras con un solo clic, variables personalizadas e integración en todas las plataformas de IA.

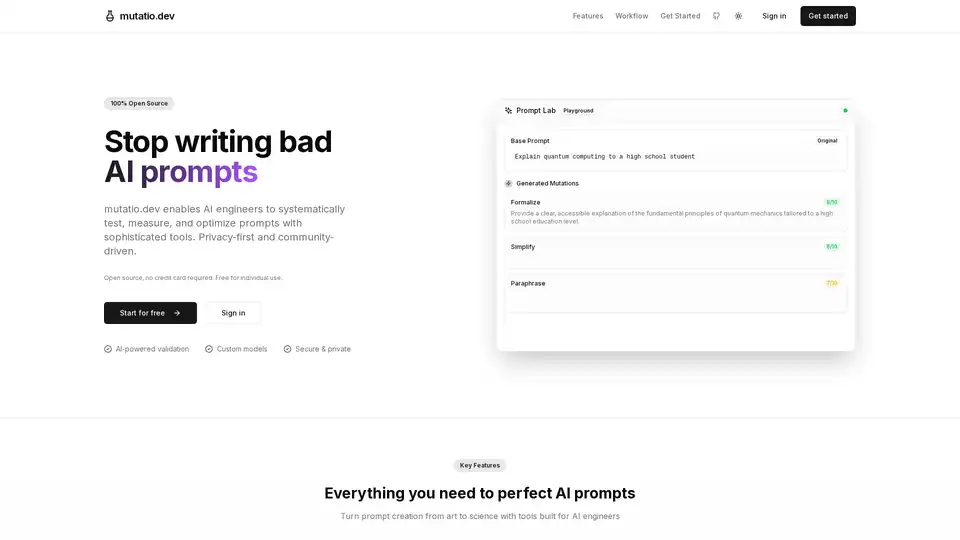

Mutatio.dev es una herramienta AI de código abierto para ingeniería de prompts, que permite la mutación, validación y optimización sistemática de prompts con LLMs personalizados. Enfocada en privacidad, basada en navegador, con flexibilidad de modelos.

Entrega software impulsado por IA impactante en minutos, sin comprometer la calidad. Envía, monitorea, prueba e itera sin perder el enfoque.

Infrabase.ai es el directorio para descubrir herramientas y servicios de infraestructura de IA. Encuentra bases de datos vectoriales, herramientas de ingeniería de prompts, APIs de inferencia y más para construir productos de IA de clase mundial.

GPT Prompt Lab es un generador de prompts AI gratuito que ayuda a los creadores de contenido a elaborar prompts de alta calidad para ChatGPT, Gemini y más a partir de cualquier tema. Genera, prueba y optimiza prompts para blogs, correos, código y contenido SEO en segundos.

PromptLayer es una plataforma de ingeniería de IA para la gestión de prompts, la evaluación y la observabilidad de LLM. Colabore con expertos, supervise agentes de IA y mejore la calidad de los prompts con herramientas potentes.

What-A-Prompt es un optimizador de prompts fácil de usar para mejorar entradas en modelos de IA como ChatGPT y Gemini. Selecciona potenciadores, ingresa tu prompt y genera resultados creativos y detallados para mejorar las salidas de LLM. Accede a una vasta biblioteca de prompts optimizados.

Compara y comparte prompts lado a lado con Google's Gemini Pro vs OpenAI's ChatGPT para encontrar el mejor modelo AI para tus necesidades.

Prompt Engine es una herramienta impulsada por IA que transforma ideas simples en indicaciones de nivel profesional para obtener resultados consistentemente de alta calidad de LLM como ChatGPT y Gemini, ahorrando tiempo y maximizando el valor de la IA.

Langtail es una plataforma de bajo código para probar y depurar aplicaciones de IA con confianza. Pruebe los prompts LLM con datos del mundo real, detecte errores y garantice la seguridad de la IA. ¡Pruébelo gratis!

GeneratedBy simplifica la creación, prueba y compartición de prompts de IA. Aumente la productividad con edición intuitiva, implementación flexible e integración de GPT-4 para aplicaciones basadas en prompts.

Parea AI es la plataforma definitiva de experimentación y anotación humana para equipos de IA, que permite una evaluación fluida de LLM, pruebas de prompts y despliegue en producción para construir aplicaciones de IA confiables.

Maxim AI es una plataforma integral de evaluación y observabilidad que ayuda a los equipos a implementar agentes de IA de manera confiable y 5 veces más rápido con herramientas completas de prueba, monitoreo y garantía de calidad.