Nexa SDK

Descripción general de Nexa SDK

Nexa SDK: Implemente modelos de IA en cualquier dispositivo en minutos

Nexa SDK es un kit de desarrollo de software diseñado para agilizar la implementación de modelos de IA en diversos dispositivos, incluidos teléfonos móviles, PC, sistemas automotrices y dispositivos IoT. Se centra en proporcionar una inferencia en el dispositivo rápida, privada y lista para producción en diferentes backends, como NPU (Unidad de procesamiento neuronal), GPU (Unidad de procesamiento gráfico) y CPU (Unidad central de procesamiento).

¿Qué es Nexa SDK?

Nexa SDK es una herramienta que simplifica el complejo proceso de implementación de modelos de IA en dispositivos periféricos. Permite a los desarrolladores ejecutar modelos sofisticados, incluidos Large Language Models (LLMs), modelos multimodales, Automatic Speech Recognition (ASR) y modelos Text-to-Speech (TTS), directamente en el dispositivo, lo que garantiza tanto la velocidad como la privacidad.

¿Cómo funciona Nexa SDK?

Nexa SDK funciona proporcionando a los desarrolladores las herramientas e infraestructura necesarias para convertir, optimizar e implementar modelos de IA en varias plataformas de hardware. Aprovecha tecnologías como NexaQuant para comprimir modelos sin una pérdida significativa de precisión, lo que les permite ejecutarse de manera eficiente en dispositivos con recursos limitados.

El SDK incluye funciones como:

- Model Hub: Acceso a una variedad de modelos de IA preentrenados y optimizados.

- Nexa CLI: Una interfaz de línea de comandos para probar modelos y crear prototipos rápidamente utilizando una API local compatible con OpenAI.

- Deployment SDK: Herramientas para integrar modelos en aplicaciones en diferentes sistemas operativos como Windows, macOS, Linux, Android e iOS.

Características y beneficios clave

- Compatibilidad multiplataforma: Implemente modelos de IA en varios dispositivos y sistemas operativos.

- Rendimiento optimizado: Logre una inferencia de IA más rápida y eficiente energéticamente en las NPU.

- Compresión de modelos: Reduzca los modelos sin sacrificar la precisión utilizando la tecnología NexaQuant.

- Privacidad: Ejecute modelos de IA en el dispositivo, lo que garantiza que los datos del usuario permanezcan privados.

- Facilidad de uso: Implemente modelos en tan solo unas pocas líneas de código.

Modelos de IA SOTA en el dispositivo

Nexa SDK admite varios modelos de IA de última generación (SOTA) que están optimizados para la inferencia en el dispositivo. Estos modelos cubren una variedad de aplicaciones, que incluyen:

- Large Language Models:

- Llama3.2-3B-NPU-Turbo

- Llama3.2-3B-Intel-NPU

- Llama3.2-1B-Intel-NPU

- Llama-3.1-8B-Intel-NPU

- Granite-4-Micro

- Multimodal Models:

- Qwen3-VL-8B-Thinking

- Qwen3-VL-8B-Instruct

- Qwen3-VL-4B-Thinking

- Qwen3-VL-4B-Instruct

- Gemma3n-E4B

- OmniNeural-4B

- Automatic Speech Recognition (ASR):

- parakeet-v3-ane

- parakeet-v3-npu

- Text-to-Image Generation:

- SDXL-turbo

- SDXL-Base

- Prefect-illustrious-XL-v2.0p

- Object Detection:

- YOLOv12‑N

- Other Models:

- Jina-reranker-v2

- DeepSeek-R1-Distill-Qwen-7B-Intel-NPU

- embeddinggemma-300m-npu

- DeepSeek-R1-Distill-Qwen-1.5B-Intel-NPU

- phi4-mini-npu-turbo

- phi3.5-mini-npu

- Qwen3-4B-Instruct-2507

- PaddleOCR v4

- Qwen3-4B-Thinking-2507

- Jan-v1-4B

- Qwen3-4B

- LFM2-1.2B

NexaQuant: Tecnología de compresión de modelos

NexaQuant es un método de compresión patentado desarrollado por Nexa AI que permite que los modelos de vanguardia se ajusten a la RAM móvil/periférica manteniendo la precisión de precisión completa. Esta tecnología es crucial para implementar grandes modelos de IA en dispositivos con recursos limitados, lo que permite aplicaciones más ligeras con menor uso de memoria.

¿Para quién es Nexa SDK?

Nexa SDK es ideal para:

- Desarrolladores de IA: Que desean implementar sus modelos en una amplia gama de dispositivos.

- Desarrolladores de aplicaciones móviles: Que desean integrar funciones de IA en sus aplicaciones sin comprometer el rendimiento ni la privacidad.

- Ingenieros automotrices: Que desean desarrollar experiencias avanzadas en el automóvil impulsadas por IA.

- Fabricantes de dispositivos IoT: Que desean habilitar funciones inteligentes en sus dispositivos.

¿Cómo empezar con Nexa SDK?

- Descargue Nexa CLI de GitHub.

- Implemente el SDK e intégrelo en sus aplicaciones en Windows, macOS, Linux, Android e iOS.

- Empiece a crear con los modelos y herramientas disponibles.

Al utilizar Nexa SDK, los desarrolladores pueden llevar capacidades avanzadas de IA a una amplia gama de dispositivos, lo que permite aplicaciones nuevas e innovadoras. Ya sea que se trate de ejecutar modelos de lenguaje grandes en un teléfono inteligente o habilitar la detección de objetos en tiempo real en un dispositivo IoT, Nexa SDK proporciona las herramientas y la infraestructura para hacerlo posible.

Asistente de Programación con IA Autocompletado de Código Revisión y Optimización de Código con IA Desarrollo de Bajo Código y Sin Código con IA

Mejores herramientas alternativas a "Nexa SDK"

Habilite la inferencia LLM eficiente con llama.cpp, una biblioteca C/C++ optimizada para diversos hardware, que admite cuantificación, CUDA y modelos GGUF. Ideal para implementación local y en la nube.

Explore el UP AI Development Kit, diseñado para computación perimetral, automatización industrial y soluciones de IA. Impulsado por Hailo-8 para un rendimiento avanzado.

MindSpore es un framework de IA de código abierto desarrollado por Huawei que soporta entrenamiento e inferencia de aprendizaje profundo en todos los escenarios. Cuenta con diferenciación automática, entrenamiento distribuido y despliegue flexible.

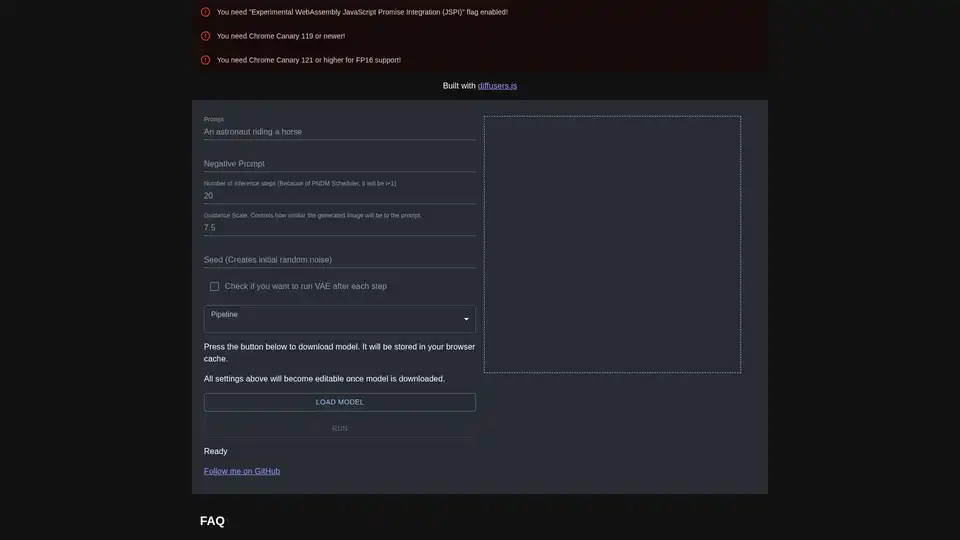

diffusers.js es una biblioteca JavaScript que permite la generación de imágenes AI con Stable Diffusion en el navegador mediante WebGPU. Descarga modelos, ingresa prompts y crea visuales impresionantes directamente en Chrome Canary con configuraciones personalizables como escala de guía y pasos de inferencia.