Runpod

Descripción general de Runpod

Runpod: La Nube Construida para la IA

Runpod es una plataforma en la nube todo en uno diseñada para optimizar el proceso de entrenamiento, ajuste y despliegue de modelos de AI. Atiende a los desarrolladores de AI proporcionando una infraestructura de GPU simplificada y una solución de nube de AI de extremo a extremo.

¿Qué es Runpod?

Runpod es una plataforma en la nube integral que simplifica las complejidades de la construcción y el despliegue de modelos de AI. Ofrece una gama de recursos de GPU y herramientas que permiten a los desarrolladores centrarse en la innovación en lugar de en la gestión de la infraestructura.

¿Cómo funciona Runpod?

Runpod simplifica el flujo de trabajo de AI en un único flujo cohesivo, permitiendo a los usuarios pasar de la idea al despliegue sin problemas. Así es como funciona:

- Spin Up: Lanza un pod de GPU en segundos, eliminando los retrasos de aprovisionamiento.

- Build: Entrena modelos, renderiza simulaciones o procesa datos sin limitaciones.

- Iterate: Experimenta con confianza utilizando retroalimentación instantánea y reversiones seguras.

- Deploy: Auto-escala a través de regiones con cero costes de inactividad y tiempo de inactividad.

Características y Beneficios Clave:

- Recursos de GPU Bajo Demanda:

- Soporta más de 30 SKUs de GPU, desde B200s hasta RTX 4090s.

- Proporciona entornos totalmente cargados y habilitados para GPU en menos de un minuto.

- Despliegue Global:

- Ejecuta cargas de trabajo en más de 8 regiones en todo el mundo.

- Garantiza un rendimiento de baja latencia y una fiabilidad global.

- Escalado Sin Servidor:

- Se adapta a tu carga de trabajo en tiempo real, escalando de 0 a 100 trabajadores de computación.

- Paga solo por lo que usas.

- Tiempo de Actividad de Grado Empresarial:

- Gestiona las conmutaciones por error, garantizando que las cargas de trabajo se ejecuten sin problemas.

- Orquestación Gestionada:

- Las colas sin servidor distribuyen las tareas sin problemas.

- Registros en Tiempo Real:

- Proporciona registros, monitorización y métricas en tiempo real.

¿Por qué elegir Runpod?

- Rentable:

- Runpod está diseñado para maximizar el rendimiento, acelerar el escalado y aumentar la eficiencia, asegurando que cada dólar trabaje más.

- Flexibilidad y Escalabilidad:

- La infraestructura de GPU escalable de Runpod proporciona la flexibilidad necesaria para igualar el tráfico de clientes y la complejidad del modelo.

- Fácil de Usar para Desarrolladores:

- Runpod simplifica cada paso del flujo de trabajo de AI, permitiendo a los desarrolladores centrarse en la construcción y la innovación.

- Fiabilidad:

- Ofrece un tiempo de actividad de grado empresarial y garantiza que las cargas de trabajo se ejecuten sin problemas, incluso cuando los recursos no lo hacen.

¿Para quién es Runpod?

Runpod está diseñado para:

- Desarrolladores de AI

- Ingenieros de aprendizaje automático

- Científicos de datos

- Investigadores

- Startups

- Empresas

¿Cómo usar Runpod?

- Regístrate: Crea una cuenta en la plataforma Runpod.

- Lanza un Pod de GPU: Elige entre una variedad de SKUs de GPU y lanza un entorno totalmente cargado en segundos.

- Construye y Entrena: Utiliza el entorno para entrenar modelos, renderizar simulaciones o procesar datos.

- Despliega: Escala tus cargas de trabajo a través de múltiples regiones con cero tiempo de inactividad.

Historias de Éxito de Clientes:

Muchos desarrolladores y empresas han encontrado el éxito usando Runpod. Aquí hay algunos ejemplos:

- InstaHeadshots: Ahorró un 90% en su factura de infraestructura utilizando computación bursty siempre que fue necesario.

- Coframe: Escaló sin esfuerzo para satisfacer la demanda en el lanzamiento, gracias a la flexibilidad ofrecida por Runpod.

Aplicaciones en el Mundo Real

Runpod es versátil y soporta varias aplicaciones, incluyendo:

- Inferencia

- Ajuste fino

- Agentes de AI

- Tareas de computación pesada

Al elegir Runpod, las organizaciones pueden:

- Reducir la sobrecarga de la gestión de la infraestructura.

- Acelerar los ciclos de desarrollo de AI.

- Lograr un escalado rentable.

- Garantizar un rendimiento fiable.

Runpod hace de la gestión de la infraestructura su trabajo, permitiéndote centrarte en la construcción de lo que sigue. Ya seas una startup o una empresa, la plataforma en la nube de AI de Runpod proporciona los recursos y el soporte necesarios para dar vida a tus proyectos de AI.

En resumen, Runpod ofrece una solución integral, rentable y escalable para el desarrollo y despliegue de AI. Es una plataforma ideal para los desarrolladores que buscan construir, entrenar y escalar modelos de aprendizaje automático de forma eficiente.

Mejores herramientas alternativas a "Runpod"

SaladCloud ofrece una nube GPU distribuida, asequible, segura e impulsada por la comunidad para la inferencia de AI/ML. Ahorre hasta un 90 % en costos de computación. Ideal para inferencia de IA, procesamiento por lotes y más.

Nebius es una plataforma de nube de IA diseñada para democratizar la infraestructura de IA, que ofrece una arquitectura flexible, rendimiento probado y valor a largo plazo con GPU NVIDIA y clústeres optimizados para el entrenamiento y la inferencia.

ChatLLaMA es un asistente de IA entrenado con LoRA basado en modelos LLaMA, que permite conversaciones personalizadas en tu GPU local. Incluye GUI de escritorio, entrenado en el conjunto de datos HH de Anthropic, disponible para modelos de 7B, 13B y 30B.

Massed Compute ofrece infraestructura de computación en la nube GPU y CPU bajo demanda para IA, aprendizaje automático y análisis de datos. Acceda a GPU NVIDIA de alto rendimiento con planes flexibles y asequibles.

Runpod es una plataforma de nube de IA todo en uno que simplifica la creación e implementación de modelos de IA. Entrena, ajusta e implementa IA sin esfuerzo con una computación potente y escalado automático.

eeat es una herramienta analítica impulsada por IA con GPT-3.5 y GPT-4 que recopila datos profundos sobre palabras clave comerciales y competidores para crear contenido experto conforme a EEAT, mejorando el ranking en motores de búsqueda y la competitividad empresarial.

Novita AI ofrece más de 200 API de modelos, implementación personalizada, instancias GPU y GPUs sin servidor. Escala la IA, optimiza el rendimiento e innova con facilidad y eficiencia.

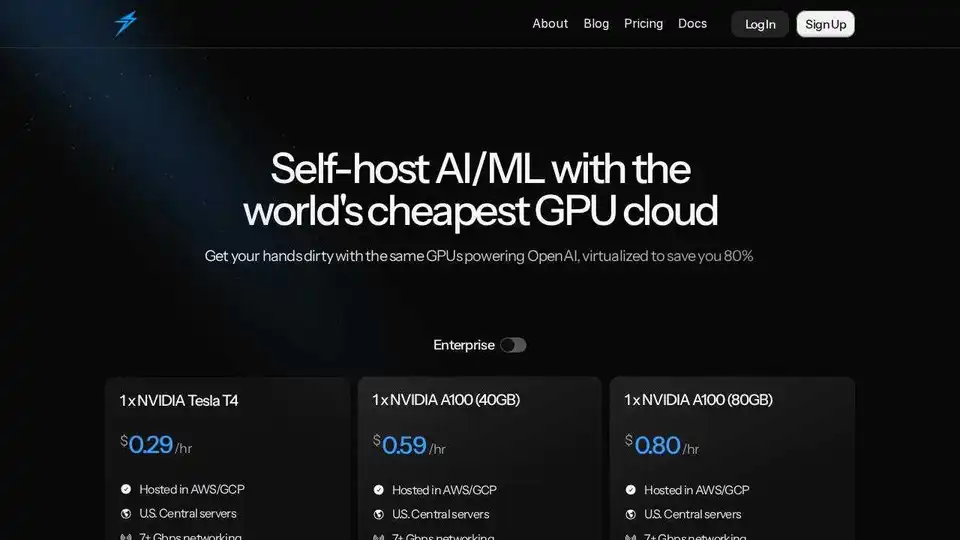

Thunder Compute es una plataforma de nube GPU para IA/ML que ofrece instancias GPU de un clic en VSCode a precios 80% más bajos que la competencia. Perfecto para investigadores, startups y científicos de datos.

GreenNode ofrece una infraestructura completa lista para IA y soluciones en la nube con GPU H100, desde $2.34/hora. Acceda a instancias preconfiguradas y a una plataforma de IA de pila completa para su viaje de IA.

Coder: Un entorno de desarrollo en la nube autohospedado para tiempos de construcción más rápidos y costos de nube reducidos. Entornos seguros para desarrolladores y agentes de IA.

Vocareum proporciona soluciones de educación en IA con laboratorios en la nube, cuadernos de IA y puertas de enlace de IA para el aprendizaje práctico y la investigación.

Phala Cloud ofrece una infraestructura de nube de código abierto y sin confianza para implementar agentes de IA y aplicaciones Web3, impulsada por TEE. Garantiza la privacidad, la escalabilidad y se rige por el código.

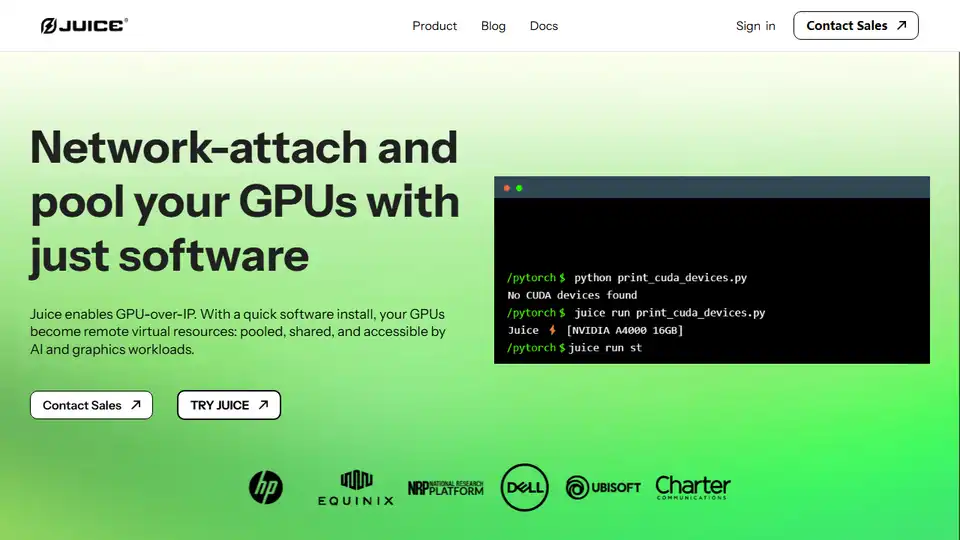

Juice permite GPU sobre IP, lo que le permite conectar en red y agrupar sus GPU con software para cargas de trabajo de IA y gráficos.

Alquile GPUs de alto rendimiento a bajo costo con Vast.ai. Implemente instantáneamente alquileres de GPU para IA, aprendizaje automático, aprendizaje profundo y renderización. Precios flexibles y configuración rápida.