Inferless

Descripción general de Inferless

¿Qué es Inferless?

Inferless es una plataforma de vanguardia diseñada para desplegar modelos de machine learning de manera rápida y eficiente utilizando inferencia GPU sin servidor. Elimina la necesidad de gestionar infraestructura, permitiendo a los desarrolladores y científicos de datos concentrarse en construir y refinar sus modelos en lugar de lidiar con complejidades operativas.

¿Cómo funciona Inferless?

Inferless simplifica el proceso de despliegue al soportar múltiples fuentes, incluyendo Hugging Face, Git, Docker y CLI. Los usuarios pueden elegir el redepliegue automático, lo que permite actualizaciones fluidas sin intervención manual. El balanceador de carga interno de la plataforma asegura un rendimiento óptimo escalando de cero a cientos de GPUs instantáneamente, manejando cargas de trabajo pico e impredecibles con un overhead mínimo.

Características clave

- Runtime personalizado: Personaliza contenedores con el software y dependencias necesarias para la ejecución de modelos.

- Volúmenes: Utiliza volúmenes escribibles similares a NFS que soportan conexiones simultáneas en réplicas.

- CI/CD automatizado: Habilita la reconstrucción automática para modelos, eliminando reimportaciones manuales y agilizando la integración continua.

- Monitoreo: Accede a registros detallados de llamadas y construcciones para monitorear y refinar modelos durante el desarrollo.

- Batching dinámico: Aumenta el throughput habilitando la combinación de solicitudes en el lado del servidor, optimizando el uso de recursos.

- Endpoints privados: Personaliza endpoints con configuraciones para escala, timeout, concurrencia, pruebas y webhooks.

Funcionalidad principal

Inferless destaca en proporcionar inferencia GPU escalable y sin servidor, asegurando que los modelos se ejecuten de manera eficiente independientemente de su tamaño o complejidad. Soporta varios frameworks y modelos de machine learning, lo que lo hace versátil para diversos casos de uso.

Aplicaciones prácticas

- Cargas de trabajo de producción: Ideal para empresas que necesitan despliegue de modelos confiable y de alto rendimiento.

- Cargas de trabajo pico: Maneja picos repentinos de tráfico sin pre-provisionamiento, reduciendo costos y mejorando la capacidad de respuesta.

- Desarrollo y pruebas: Facilita la iteración rápida con herramientas automatizadas y monitoreo detallado.

Público objetivo

Inferless está diseñado para:

- Científicos de datos que buscan un despliegue de modelos sin esfuerzo.

- Ingenieros de software que gestionan infraestructura de ML.

- Empresas que requieren soluciones escalables y seguras para aplicaciones de AI.

- Startups que buscan reducir costos de GPU y acelerar el tiempo de llegada al mercado.

¿Por qué elegir Inferless?

- Gestión cero de infraestructura: Sin configuración ni mantenimiento de clústeres de GPU.

- Eficiencia de costos: Paga solo por uso, sin costos de inactividad, ahorrando hasta un 90% en facturas de GPU.

- Arranques en frío rápidos: Respuestas en subsegundos incluso para modelos grandes, evitando retrasos de calentamiento.

- Seguridad empresarial: Certificación SOC-2 Type II, pruebas de penetración y escaneos regulares de vulnerabilidades.

Testimonios de usuarios

- Ryan Singman (Cleanlab): "Ahorramos casi un 90% en facturas de nube de GPU y nos pusimos en vivo en menos de un día."

- Kartikeya Bhardwaj (Spoofsense): "Simplificó el despliegue y mejoró el rendimiento con batching dinámico."

- Prasann Pandya (Myreader.ai): "Funciona perfectamente con cientos de libros procesados diariamente a un costo mínimo."

Inferless se destaca como una solución robusta para desplegar modelos de machine learning, combinando velocidad, escalabilidad y seguridad para satisfacer las demandas de AI modernas.

Mejores herramientas alternativas a "Inferless"

AIMLAPI proporciona una única API para acceder a más de 300 modelos de IA para chat, razonamiento, imagen, video, audio, voz, búsqueda y 3D. Ofrece inferencia rápida, infraestructura sin servidor de primer nivel y seguridad de datos robusta, ahorrando hasta un 80% en comparación con OpenAI.

Baseten es una plataforma para implementar y escalar modelos de IA en producción. Ofrece tiempos de ejecución de modelos de alto rendimiento, alta disponibilidad entre nubes y flujos de trabajo de desarrollador fluidos, impulsados por Baseten Inference Stack.

Cloudflare Workers AI le permite ejecutar tareas de inferencia de IA sin servidor en modelos de aprendizaje automático preentrenados en la red global de Cloudflare, ofreciendo una variedad de modelos y una integración perfecta con otros servicios de Cloudflare.

BrainHost VPS ofrece servidores virtuales KVM de alto rendimiento con almacenamiento NVMe, ideal para inferencia de IA, sitios web y comercio electrónico. Implementación rápida en 30s en Hong Kong y US West para acceso global confiable.

Explore las API de NVIDIA NIM para la inferencia optimizada y la implementación de modelos de IA líderes. Cree aplicaciones de IA generativa empresarial con API sin servidor o autohospedaje en su infraestructura de GPU.

Runpod es una plataforma de nube de IA que simplifica la construcción y el despliegue de modelos de IA. Ofrece recursos de GPU bajo demanda, escalado sin servidor y tiempo de actividad de nivel empresarial para desarrolladores de IA.

GPUX es una plataforma de inferencia GPU sin servidor que permite arranques en frío de 1 segundo para modelos de IA como StableDiffusionXL, ESRGAN y AlpacaLLM con rendimiento optimizado y capacidades P2P.

Plataforma de IA ultrarrápida para desarrolladores. Implementa, ajusta y ejecuta más de 200 LLMs y modelos multimodales optimizados con APIs simples - SiliconFlow.

Promptitude.io permite a los equipos integrar GPT en apps y flujos de trabajo sin problemas. Prueba, gestiona y optimiza prompts con una sola llamada API para resultados AI personalizados en resumen de documentos, revisión de código y más.

PremAI es un laboratorio de investigación de IA aplicada que proporciona modelos de IA seguros y personalizados, inferencia encriptada con TrustML™ y herramientas de código abierto como LocalAI para ejecutar LLM localmente.

SaladCloud ofrece una nube GPU distribuida, asequible, segura e impulsada por la comunidad para la inferencia de AI/ML. Ahorre hasta un 90 % en costos de computación. Ideal para inferencia de IA, procesamiento por lotes y más.

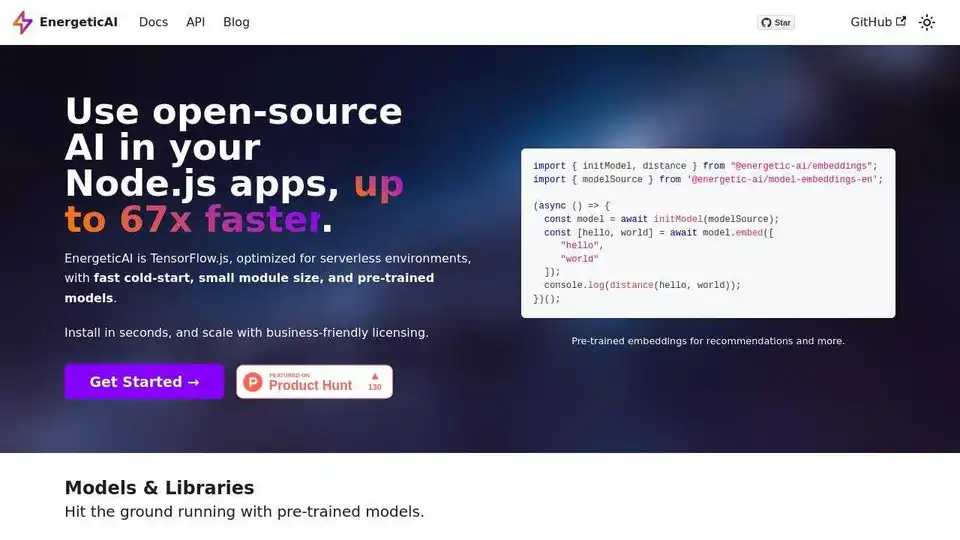

EnergeticAI es TensorFlow.js optimizado para funciones sin servidor, que ofrece un inicio en frío rápido, un tamaño de módulo pequeño y modelos preentrenados, lo que hace que la IA sea accesible en aplicaciones Node.js hasta 67 veces más rápido.

Modal: Plataforma sin servidor para equipos de IA y datos. Ejecute cómputo intensivo de CPU, GPU y datos a escala con su propio código.

Ejecute instantáneamente cualquier modelo Llama desde HuggingFace sin configurar ningún servidor. Más de 11,900 modelos disponibles. A partir de $10/mes para acceso ilimitado.