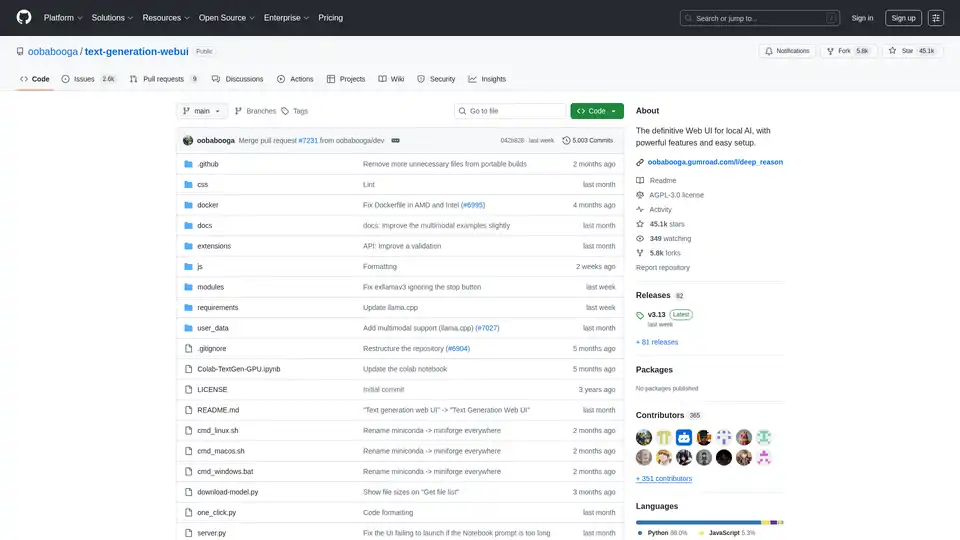

Text Generation Web UI

Descripción general de Text Generation Web UI

Interfaz Web de Generación de Texto: La Interfaz Web Definitiva para la IA Local

¿Qué es la Interfaz Web de Generación de Texto?

La Interfaz Web de Generación de Texto, también conocida como oobabooga/text-generation-webui, es una interfaz web Gradio fácil de usar y rica en funciones diseñada para interactuar con Modelos de Lenguaje Grande (LLMs) localmente. Proporciona un conjunto completo de herramientas y funcionalidades para aprovechar el poder de la generación de texto con IA en tu propia máquina, garantizando la privacidad y el control.

¿Cómo funciona la Interfaz Web de Generación de Texto?

Esta interfaz web actúa como un puente entre tú y varios backends de generación de texto local. Soporta múltiples backends como llama.cpp, Transformers, ExLlamaV3, ExLlamaV2 y TensorRT-LLM. La UI te permite:

- Seleccionar tu backend preferido: Elige el backend que mejor se adapte a tus requisitos de hardware y modelo.

- Cargar y gestionar modelos: Carga fácilmente diferentes LLMs y cambia entre ellos sin reiniciar la aplicación.

- Configurar parámetros de generación: Ajusta el proceso de generación de texto con varios parámetros de muestreo y opciones de generación.

- Interactuar con el modelo: Utiliza la interfaz de chat intuitiva o la pestaña de cuaderno de forma libre para interactuar con el modelo.

¿Por qué elegir la Interfaz Web de Generación de Texto?

- Privacidad: Todo el procesamiento se realiza localmente, garantizando que tus datos permanezcan privados.

- Funcionalidad sin conexión: No se requiere conexión a Internet, lo que te permite utilizar la herramienta en cualquier momento y en cualquier lugar.

- Versatilidad: Soporta múltiples backends y tipos de modelos, proporcionando flexibilidad y personalización.

- Extensibilidad: Ofrece soporte de extensión para añadir nuevas características y funcionalidades.

- Facilidad de uso: Interfaz fácil de usar con temas oscuros y claros, resaltado de sintaxis y renderizado de LaTeX.

Características Clave:

- Soporte para Múltiples Backends: Se integra perfectamente con

llama.cpp,Transformers,ExLlamaV3,ExLlamaV2yTensorRT-LLM. - Fácil Configuración: Ofrece compilaciones portátiles para Windows/Linux/macOS, que no requieren configuración, y un instalador de un solo clic para un entorno autocontenido.

- Sin Conexión y Privado: Funciona 100% sin conexión sin telemetría, recursos externos o solicitudes de actualización remota.

- Archivos Adjuntos: Permite cargar archivos de texto, documentos PDF y archivos .docx para discutir su contenido con la IA.

- Visión (Modelos Multimodales): Soporta adjuntar imágenes a los mensajes para la comprensión visual (tutorial).

- Búsqueda Web: Puede buscar opcionalmente en Internet con consultas generadas por LLM para añadir contexto a las conversaciones.

- UI Estética: Presenta una interfaz de usuario limpia y atractiva con temas oscuros y claros.

- Resaltado de Sintaxis y Renderizado de LaTeX: Proporciona resaltado de sintaxis para bloques de código y renderizado de LaTeX para expresiones matemáticas.

- Modos de Instrucción y Chat: Incluye el modo de instrucción para el seguimiento de instrucciones y los modos de chat para interactuar con personajes personalizados.

- Formato Automático de Prompts: Utiliza plantillas Jinja2 para el formato automático de prompts.

- Edición de Mensajes y Ramificación de Conversaciones: Permite editar mensajes, navegar entre versiones y ramificar conversaciones.

- Múltiples Parámetros de Muestreo: Ofrece un control sofisticado sobre la generación de texto con varios parámetros de muestreo y opciones de generación.

- Cambio de Modelo: Permite cambiar entre diferentes modelos en la UI sin reiniciar.

- Capas de GPU Automáticas: Configura automáticamente las capas de GPU para los modelos GGUF en GPUs NVIDIA.

- Generación de Texto de Forma Libre: Proporciona una pestaña de Cuaderno para la generación de texto de forma libre sin limitaciones de turno de chat.

- API Compatible con OpenAI: Incluye una API compatible con OpenAI con puntos finales de Chat y Completions, incluyendo soporte para la llamada de herramientas.

- Soporte de Extensiones: Soporta numerosas extensiones integradas y contribuidas por usuarios.

Cómo Instalar la Interfaz Web de Generación de Texto:

- Compilaciones Portátiles (Recomendado para Inicio Rápido):

- Descarga la compilación portátil de la página de lanzamientos.

- Descomprime el archivo descargado.

- Ejecuta el ejecutable.

- Instalación Portátil Manual con venv:

git clone https://github.com/oobabooga/text-generation-webui cd text-generation-webui python -m venv venv

On Windows:

venv\Scripts\activate

On macOS/Linux:

source venv/bin/activate

pip install -r requirements/portable/requirements.txt --upgrade

python server.py --portable --api --auto-launch

deactivate

```

3. Instalador de un Solo Clic (Para usuarios avanzados):

* Clona el repositorio o descarga el código fuente.

* Ejecuta el script de inicio para tu SO (start_windows.bat, start_linux.sh, o start_macos.sh).

* Selecciona tu proveedor de GPU cuando se te solicite.

* Después de la instalación, abre http://127.0.0.1:7860 en tu navegador.

Descarga de Modelos:

Los modelos deben colocarse en la carpeta text-generation-webui/user_data/models. Los modelos GGUF deben colocarse directamente en esta carpeta, mientras que otros tipos de modelos deben colocarse en una subcarpeta.

Ejemplo:

text-generation-webui

└── user_data

└── models

└── llama-2-13b-chat.Q4_K_M.gguf

text-generation-webui

└── user_data

└── models

└── lmsys_vicuna-33b-v1.3

├── config.json

├── generation_config.json

├── pytorch_model-00001-of-00007.bin

...

También puedes utilizar la UI para descargar modelos automáticamente desde Hugging Face o utilizar la herramienta de línea de comandos:

python download-model.py organization/model

Ejecuta python download-model.py --help para ver todas las opciones.

¿Para quién es la Interfaz Web de Generación de Texto?

La Interfaz Web de Generación de Texto es ideal para:

- Investigadores y desarrolladores que trabajan con LLMs.

- Entusiastas de la IA que quieren experimentar con la generación de texto.

- Usuarios que priorizan la privacidad y quieren ejecutar LLMs localmente.

Recursos Útiles:

La Interfaz Web de Generación de Texto proporciona una plataforma potente y versátil para explorar las capacidades de la generación de texto con IA local. Su facilidad de uso, sus amplias funciones y su compromiso con la privacidad la convierten en una excelente opción para cualquier persona interesada en trabajar con Modelos de Lenguaje Grande en sus propios términos.

Mejores herramientas alternativas a "Text Generation Web UI"

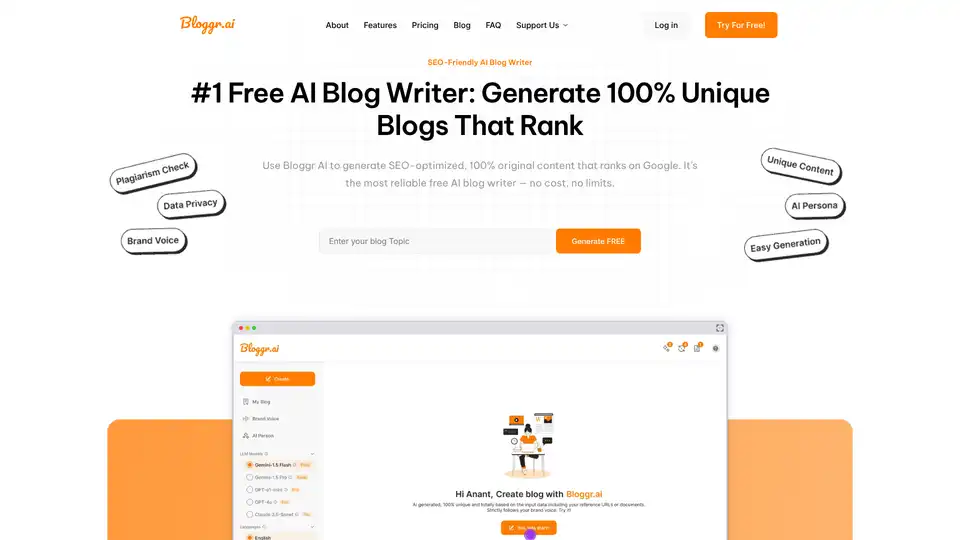

El Escritor de Blog AI de Bloggr.AI te ayuda a generar publicaciones de blog optimizadas para SEO y libres de plagio rápidamente—gratuito con voz de marca, esquemas e inserción de enlaces.

AI Runner es un motor de inferencia de IA sin conexión para arte, conversaciones de voz en tiempo real, chatbots impulsados por LLM y flujos de trabajo automatizados. ¡Ejecute la generación de imágenes, el chat de voz y más localmente!

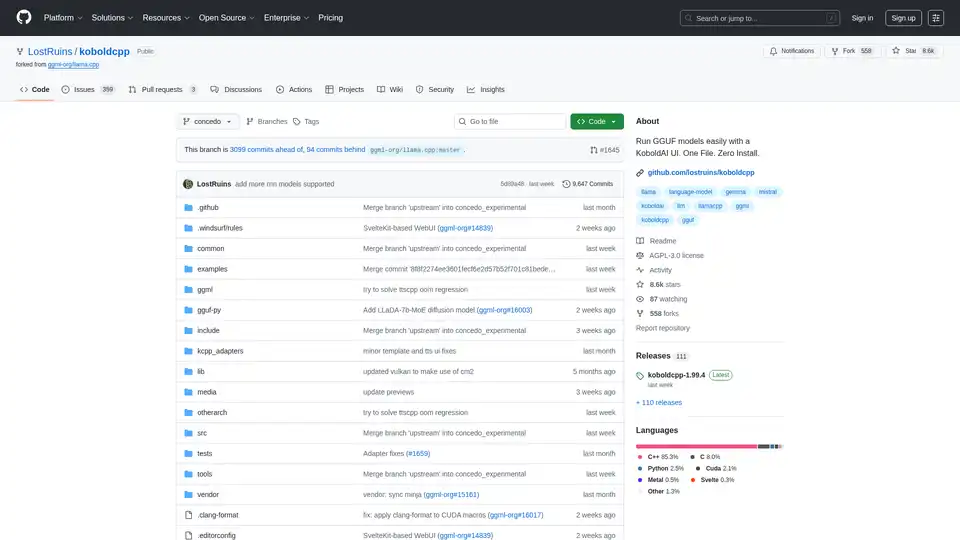

KoboldCpp: Ejecuta modelos GGUF fácilmente para generación de texto e imágenes con IA usando una interfaz de KoboldAI. Un solo archivo, sin instalación. Compatible con CPU/GPU, STT, TTS y Stable Diffusion.

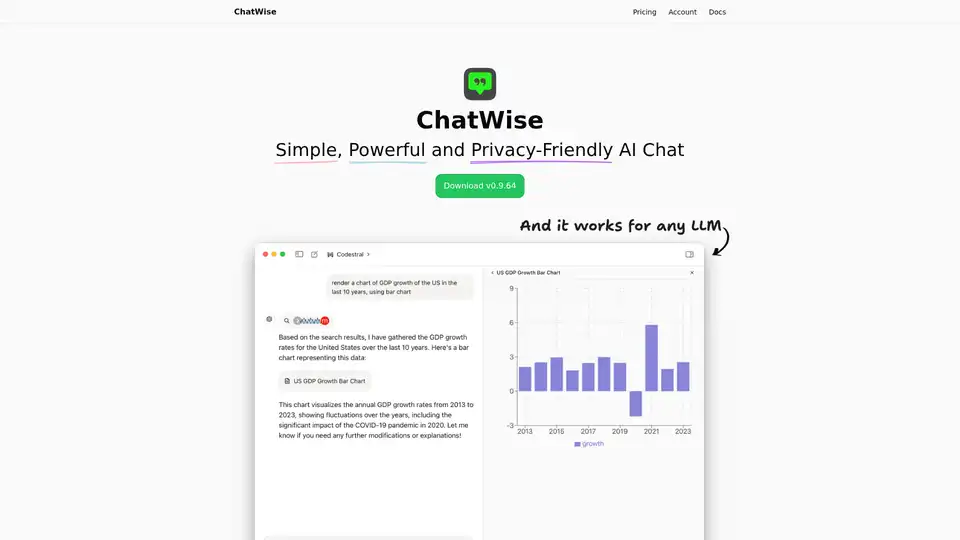

ChatWise es un chatbot de IA de escritorio de alto rendimiento y centrado en la privacidad que soporta GPT-4, Claude, Gemini, Llama y más. Incluye almacenamiento local de datos, chats multimodales (audio, PDF, imágenes), búsqueda web, integración de claves API y renderizado de artefactos.

Floneum es un editor de gráficos que le permite construir visualmente flujos de trabajo impulsados por IA con modelos de lenguaje grandes locales. Se extiende de forma segura con complementos WASM aislados y admite varios idiomas.

TypingMind es una interfaz de usuario de chat de IA que admite GPT-4, Gemini, Claude y otros LLM. Utiliza tus claves API y paga solo por lo que usas. La mejor interfaz de usuario frontend LLM de chat para todos los modelos de IA.

Chatea con IA usando tus claves API. Paga solo por lo que uses. Soporta GPT-4, Gemini, Claude y otros LLMs. La mejor interfaz de chat frontend LLM para todos los modelos de IA.

Amuse es un generador de arte con IA gratuito que utiliza modelos Stable Diffusion optimizados para hardware AMD, permitiendo la generación de imágenes y videos en PC personales sin conexión a internet.

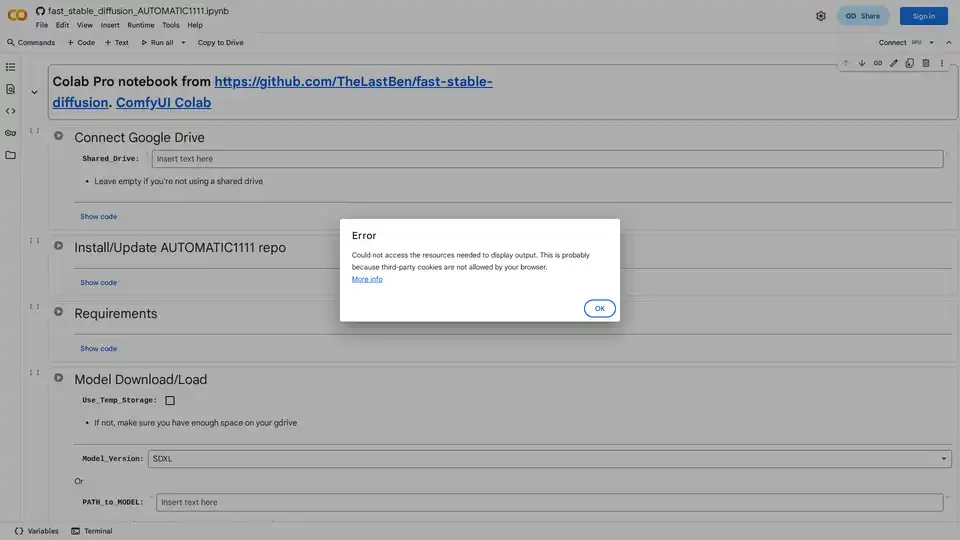

Descubre cómo ejecutar Stable Diffusion usando la interfaz web de AUTOMATIC1111 en Google Colab. Instala modelos, LoRAs y ControlNet para una generación rápida de imágenes con IA sin hardware local.

Explora Stable Diffusion, un generador de imágenes AI de código abierto para crear imágenes realistas a partir de indicaciones de texto. Accede vía Stablediffusionai.ai o instalación local para arte, diseño y proyectos creativos con alta personalización.

Crea el sitio web de tus sueños con IA usando Readdy, sin necesidad de arrastrar y soltar. Perfecto para equipos pequeños y agencias, publica al instante o exporta como archivos de código/Figma.

Flying Dog es un plugin de IA para Photoshop que integra Stable Diffusion y DALL-E para generación de imágenes avanzada, inpainting, outpainting y más. Impulsa tu flujo de edición con herramientas de IA potentes.

OpenDream AI transforma el texto en impresionantes obras de arte de IA en segundos. Genere imágenes de alta calidad con múltiples modelos de IA. Nivel gratuito disponible. ¡Empieza a crear ahora!

InfernoAI es una potente interfaz de chat IA basada en navegador que admite modelos ChatGPT, Claude, Gemini y OpenRouter con funciones avanzadas como texto a voz, generación de imágenes y chats ilimitados.