Architecture et principes de fonctionnement du serveur MCP : Du protocole au flux d'exécution

À mesure que les systèmes d'IA évoluent, ils deviennent de plus en plus complexes. Les paradigmes d'appels d'API traditionnels (tels que les requêtes HTTP indépendantes et les SDK spécifiques aux fournisseurs) sont confrontés à des défis comme une faible efficacité de développement, des risques de sécurité élevés et une maintenabilité médiocre lors de la construction de systèmes d'agents IA sophistiqués. Par exemple, les définitions d'API indépendantes manquent de standard unifié ; différents modèles fournissent des spécifications d'appel de fonction variées ; et il y a un manque de mécanismes efficaces de découverte de capacités et d'intégration dynamique.

Le Model Context Protocol (MCP) est apparu pour résoudre ces problèmes. Grâce à une standardisation au niveau du protocole, il introduit un mécanisme d'appel d'outils et de ressources extensible et inter-services, permettant aux agents IA de collaborer de manière robuste avec des systèmes externes. La philosophie de conception fondamentale du MCP réside dans l'abstraction du protocole et la séparation des préoccupations. Il ne dicte pas d'implémentations spécifiques mais définit un langage universel pour l'interaction entre les applications IA et les capacités externes.

Cet article fournit une explication faisant autorité de l'architecture du serveur MCP, des principes du protocole et du flux d'exécution, soulignant pourquoi une couche de protocole est préférée à un SDK et comment le MCP prend en charge les appels d'outils évolutifs requis par les systèmes intelligents modernes.

Public cible :

- Passionnés de technologie et apprenants débutants

- Professionnels et managers cherchant des améliorations d'efficacité

- Décideurs d'entreprise et chefs de département commercial

- Utilisateurs généraux intéressés par les tendances futures de l'IA

Contenu :

- 1. Philosophie de conception fondamentale du protocole MCP

- 2. Composants fondamentaux du MCP

- 3. MCP vs. Intégration API traditionnelle : Paradigmes architecturaux

- 4. Comment les serveurs MCP collaborent avec les agents IA

- 5. Les trois primitives de capacité fondamentales du MCP

- 6. Relation de communication : Client MCP, Serveur et LLM

- 7. Processus complet d'appel du serveur MCP

- 8. MCP vs. API traditionnelle / Appel de fonction : Différences au niveau de la couche d'interface du modèle

- 9. Limites et défis du MCP

- Conclusion

- Questions Fréquemment Posées (FAQ) sur le MCP

1. Philosophie de conception fondamentale du protocole MCP

Le MCP choisit l'abstraction au niveau du protocole, offrant des avantages fondamentaux tels que la standardisation, l'indépendance linguistique et une forte universalité, plutôt que de fournir un SDK unifié. Cela signifie que tout programme implémentant la spécification du protocole MCP — quelle que soit la langue de programmation ou le framework utilisé — peut communiquer avec d'autres. Cette conception maximise l'ouverture et l'interopérabilité écologiques. La communication est basée sur JSON-RPC 2.0, un protocole léger d'appel de procédure à distance dont les formats de requête et de réponse structurés sont idéaux pour l'interaction automatisée de machine à machine.

Format des messages de communication

Le MCP utilise JSON-RPC 2.0 comme format de message et standard de communication fondamental.

JSON-RPC est un protocole d'appel de procédure à distance (RPC) sans état et léger. Il utilise JSON comme format de données et peut être transporté sur différentes couches de transport telles que STDIO ou HTTP.

Dans le MCP, JSON-RPC est responsable de :

- Définir les structures de message de requête/réponse ;

- Standardiser les appels de méthode (par exemple,

initialize,tools/list,tools/call) ; - Fournir des mécanismes d'erreur et de traitement par lots extensibles.

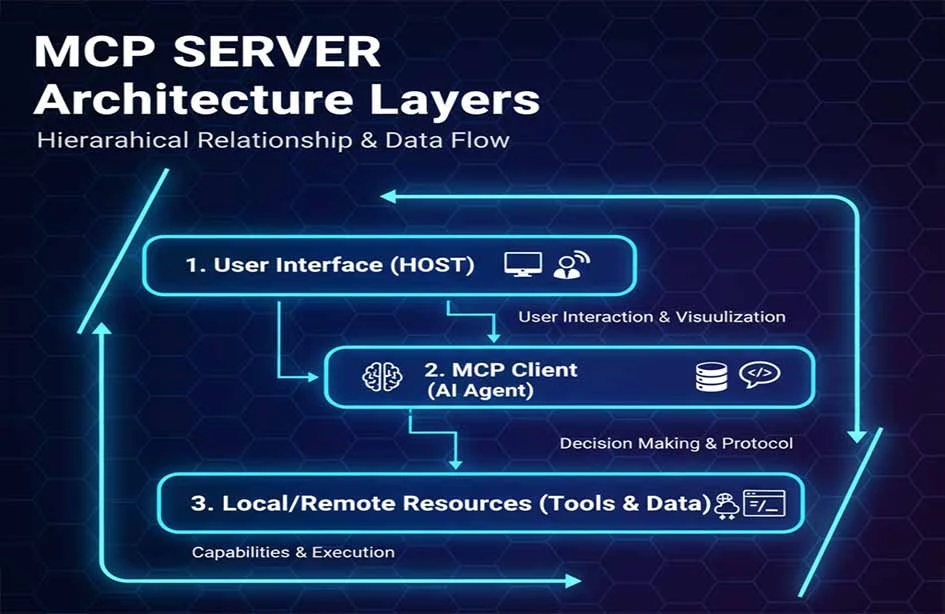

Modèle d'architecture à trois couches

Le MCP adopte un modèle d'architecture à trois couches : Client MCP, Serveur MCP et Ressource/Outil.

| Hôtes MCP |

|---|

| Clients MCP |

| Serveurs MCP |

- Hôtes MCP : L'application LLM initiant la requête (par exemple, Claude Desktop, un IDE ou un outil IA).

- Clients MCP : Situés au sein du programme hôte, maintenant une connexion 1:1 avec le serveur MCP.

- Serveurs MCP : Fournissant le contexte, les outils et les informations d'invite au client MCP.

Cette conception en couches réduit considérablement le couplage entre les modules et améliore l'évolutivité du serveur MCP.

2. Composants fondamentaux du MCP

Couche de transport Les transports standard MCP incluent STDIO et HTTP + Server-Sent Events (SSE), où SSE fournit des capacités de messages en streaming du serveur au client. Le MCP définit actuellement deux mécanismes de transport standard pour la communication client-serveur :

- STDIO : Sécurité et performances d'abord. Le serveur MCP démarre en tant que processus enfant et s'exécute localement avec l'application IA. Il utilise la communication inter-processus (IPC) locale, offrant une faible latence et un déploiement simple. Étant donné que toute la communication reste locale, elle évite les risques réseau pour les informations d'identification et les données. C'est la méthode préférée pour intégrer des capacités locales dans des outils de productivité personnelle comme Claude Desktop.

- HTTP with Server-Sent Events (SSE) : Accessibilité et évolutivité d'abord. Le serveur MCP est déployé en tant que service réseau accessible par plusieurs clients distants. Il utilise HTTP/POST combiné avec JSON-RPC pour la transmission des messages. Cela convient aux centres de capacités partagées au sein des entreprises ou aux services SaaS. HTTPS et l'authentification HTTP standard fournissent la base de sécurité.

Ce mécanisme permet au MCP de prendre en charge à la fois des appels d'outils simples et des serveurs distribués à grande échelle. Le choix dépend du scénario : STDIO est plus efficace pour la communication de processus locaux, tandis que HTTP offre une meilleure évolutivité pour les déploiements de clusters distants.

Couche de protocole

Au niveau de la couche de protocole, le MCP utilise la spécification JSON-RPC 2.0 pour définir des méthodes standard, telles que :

- L'initialisation des connexions (

initialize) ; - La découverte de capacités (

tools/list) ; - L'exécution d'outils (

tools/call).

Cette conception variante maintient la structure de protocole fondamentale de JSON-RPC tout en introduisant des sémantiques de communication spécifiques au MCP. Outils JSON-RPC

Sécurité et authentification

Le MCP ne fournit pas directement de mécanismes de sécurité. La conception de la sécurité repose sur l'implémentation spécifique du serveur MCP utilisant des solutions établies, telles que :

- Transmission chiffrée HTTPS/TLS ;

- Authentification via OAuth2, Clés API ou mTLS ;

- Contrôle d'autorisation du moindre privilège.

Cela signifie que le protocole MCP lui-même ne contient pas de spécifications de sécurité ; au lieu de cela, les implémenteurs de serveurs sont responsables de la conception et de l'intégration de systèmes de sécurité tiers. Par exemple, les plateformes d'entreprise peuvent intégrer le MCP avec des systèmes de gestion d'identité pour un contrôle d'accès, une gouvernance et un audit sécurisés.

Extensibilité et architecture de plugin

L'extensibilité du MCP découle naturellement de sa conception protocolaire. Développer un "outil personnalisé" implique de créer un programme serveur qui implémente le protocole MCP. Lorsque ce serveur démarre et se connecte à l'application IA (Client MCP), il enregistre dynamiquement ses outils via la méthode standard tools/list. L'application IA découvre et utilise ces nouvelles capacités sans pré-configuration ni recompilation, réalisant ainsi une véritable fonctionnalité plug-and-play.

Les serveurs MCP incluent généralement des mécanismes pour :

- Le développement d'outils personnalisés ;

- L'enregistrement/découverte dynamique d'outils et de capacités ;

- Le support de plugins pour étendre le comportement sans modifier le cœur du protocole.

Cycle de vie des outils et gestion de session

Le cycle de vie d'une connexion MCP commence par la poignée de main initialize et se termine lorsque la connexion se ferme. Pendant cette période, tous les appels d'outils et les lectures de ressources partagent une session logique. Pour les serveurs MCP qui doivent servir plusieurs utilisateurs ou sessions indépendants (en particulier en mode HTTP), l'implémentation doit gérer l'isolation d'état entre les différents clients ou requêtes.

Le serveur MCP gère :

- Le contexte de session : Enregistrement de l'état sur plusieurs appels ;

- Les mécanismes d'isolation : Assurer que les sessions entre différents clients sont isolées pour éviter les fuites de données ou la pollution d'état.

Cette gestion prend en charge des cas d'utilisation avancés comme les sessions longues et les opérations en plusieurs étapes.

Conception de la performance et de la fiabilité du système

En tant que protocole léger, la performance du MCP dépend fortement de l'efficacité de l'implémentation du serveur et de la latence du réseau. Pour les exigences de haute disponibilité, plusieurs instances de serveur MCP peuvent être déployées derrière un équilibreur de charge. Le protocole définit une interface de logging, permettant aux serveurs d'envoyer des journaux d'exécution au client, ce qui constitue la base de l'audit.

Les conceptions de serveur MCP incluent souvent :

- L'équilibrage de charge pour le déploiement multi-réplique ;

- La récupération après panne pour assurer une haute disponibilité ;

- La journalisation et l'audit pour le suivi de l'historique des appels et des diagnostics.

Ces mécanismes améliorent la stabilité pour les cas d'utilisation de niveau entreprise.

Intégration avec les écosystèmes modernes

Pour s'adapter aux environnements cloud-native, les serveurs MCP collaborent souvent avec Kubernetes et les équilibreurs de charge cloud pour l'auto-scaling et le déploiement élastique. Les serveurs MCP peuvent être conteneurisés et déployés sur des plateformes comme Kubernetes, permettant des vérifications de santé et une gestion centralisée au sein des piles d'infrastructure d'entreprise modernes.

3. MCP vs. Intégration API traditionnelle : Paradigmes architecturaux

Comparé à l'intégration API indépendante, le MCP utilise l'abstraction du protocole pour améliorer la sécurité, la maintenabilité et les capacités multiplateformes.

| Caractéristique | Serveur MCP | Intégration API traditionnelle | Systèmes de plugins | Mode SDK |

|---|---|---|---|---|

| Standardisation | Standard industriel | Varie par API | Spécifique à la plateforme | Spécifique au fournisseur |

| Coût de développement | Faible (implémenter une fois) | Élevé | Moyen | Élevé |

| Complexité de maintenance | Faible | Très élevée | Moyen | Élevée |

| Capacité multiplateforme | Excellente | Médiocre | Médiocre | Médiocre |

| Modèle de sécurité | Contrôle unifié | Fragmenté | Contrôlé par la plateforme | Fragmenté |

| Support en temps réel | Support natif | Polling/Webhooks | Limité | Personnalisé |

| Écosystème communautaire | Croissance rapide | Fragmenté | Fermé | Verrouillage fournisseur |

4. Comment les serveurs MCP collaborent avec les agents IA

Dans une architecture typique d'agent IA basée sur la planification, les composants incluent un Planificateur, un Exécuteur et une Mémoire. Le serveur MCP agit comme le backend d'exécution standardisé dans cette architecture.

- Planificateur : (Généralement le LLM) formule des stratégies basées sur l'entrée. Il récupère la liste actuelle des

Toolsdisponibles et leurs descriptions du Client MCP. Le Planificateur esquisse ensuite une séquence d'étapes (par exemple, "Utiliser l'outil A pour interroger des données, puis l'outil B pour traiter les résultats"). - Exécuteur : (Généralement le Client MCP) émet des requêtes

tools/callau serveur MCP correspondant en fonction du plan. - Mémoire : Stocke l'état et le contexte. Les résultats d'exécution sont renvoyés à l'Agent, stockés dans la Mémoire et utilisés pour la planification ultérieure. De plus, les

Resourcespeuvent fournir proactivement des connaissances de base pertinentes pour la tâche.

Le serveur MCP sert de fournisseur de capacités pour l'Exécuteur, permettant au Planificateur d'accéder aux outils et aux ressources via un protocole standard.

La position du MCP dans une architecture d'agent IA est similaire à l'interface d'un système d'exploitation pour les services externes, unifiant et standardisant l'exécution des capacités.

Le MCP est complémentaire aux frameworks comme LangChain et AutoGen. Alors que ces frameworks fournissent une abstraction de haut niveau et une orchestration pour les workflows d'agents IA, le MCP sert de couche d'exécution d'outils standardisée. Il résout les problèmes de "code de liaison" et de fragmentation auxquels ces frameworks sont confrontés lors de l'intégration d'outils spécifiques.

5. Les trois primitives de capacité fondamentales du MCP

Ces primitives définissent le modèle de données du protocole MCP et la manière dont les applications IA interagissent avec le serveur.

- Tools (Outils) : Fonctions appelables comme la recherche ou les opérations de base de données. Chaque outil a un nom, une description clairs et un JSON Schema de paramètres d'entrée. Le modèle IA les déclenche si nécessaire (par exemple, un outil

send_email). - Resources (Ressources) : Sources de données accessibles telles que les systèmes de fichiers ou le stockage d'objets. Chaque ressource a un URI et un type MIME. Les applications IA lisent ces contenus pour injecter du contexte dans les invites (par exemple, une ressource

file:///reports/weekly.md). - Prompts (Invites) : Modèles ou contextes prédéfinis utilisés pour aider la prise de décision du LLM. Ceux-ci offrent un moyen structuré aux utilisateurs de lancer des tâches spécifiques (par exemple, une invite "Planifier un voyage de week-end" qui guide le modèle à utiliser les outils pertinents).

Cette conception à trois niveaux permet au serveur MCP d'exprimer clairement ses fonctions exécutables tout en prenant en charge la découverte dynamique. De plus, le protocole permet aux serveurs de demander la génération de modèle (échantillonnage LLM) au client. Cela permet au serveur d'utiliser le LLM du client pour le raisonnement pendant sa propre logique d'exécution. Les clients doivent déclarer cette capacité lors de l'initialisation pour la prendre en charge.

6. Relation de communication : Client MCP, Serveur et LLM

Comprendre la relation entre ces trois est essentiel pour comprendre le flux de travail du MCP :

- Qui initie la connexion ? Le Client MCP (intégré dans l'application IA) initie activement la connexion au Serveur MCP.

- Qui décide d'appeler un outil ? Le LLM (au sein de l'application IA) prend des décisions basées sur une logique interne. Le Client MCP fournit la liste des outils disponibles comme contexte, et le LLM décide s'il doit appeler un outil, lequel, et avec quels paramètres.

- Qui exécute l'opération ? Le Serveur MCP appelle le service ou la ressource réelle. Il reçoit la requête

tools/callstandardisée du client, la traduit en actions pour le système sous-jacent (base de données, API, fichier) et renvoie le résultat standardisé.

7. Processus complet d'appel du serveur MCP

Un flux de travail typique comprend :

- Initialisation : Le client et le serveur établissent une connexion et échangent les versions de protocole et les capacités.

- Découverte de capacités : Le client récupère la liste des

Toolset desResourcesdu serveur viatools/list. - Appel d'outils : Après que le LLM a pris une décision, le client émet une requête

tools/call. Le serveur exécute l'opération réelle. - Injection de résultats : Le serveur renvoie des résultats structurés, que le client fournit au LLM pour la génération de la réponse finale ou une planification ultérieure.

Diagramme de synchronisation typique pour un protocole d'appel :

Vous trouverez ci-dessous un diagramme de synchronisation simplifié pour un cas de réservation de salle de conférence, montrant l'interaction protocolaire fondamentale de l'initialisation à l'exécution :

8. MCP vs. API traditionnelle / Appel de fonction : Différences au niveau de la couche d'interface du modèle

L'intégration API traditionnelle dépend des spécifications et des SDK définis par le fournisseur. Le MCP abstrait le comportement d'appel en méthodes JSON-RPC, maintenant une interface standard indépendante des SDK spécifiques.

- Appel de fonction traditionnel Il s'agit d'une capacité fournie par des fournisseurs de modèles spécifiques. Les développeurs définissent des fonctions au format du fournisseur, et le modèle apprend à produire des requêtes dans ce format. Il est lié à l'interface propriétaire du fournisseur.

- Architecture MCP Le MCP est un protocole ouvert agnostique au modèle. Il définit des formats universels et standardisés pour la description et l'appel de capacités. Toute application IA prenant en charge le MCP (quel que soit le modèle sous-jacent) peut interagir avec n'importe quel serveur MCP. Il libère l'intégration d'outils du verrouillage fournisseur de modèle.

Le MCP est mieux adapté pour la maintenance à long terme et la construction d'écosystèmes dans des environnements multi-modèles à grande échelle.

Limites des cas d'utilisation : Si vous utilisez un seul modèle avec des exigences d'outils simples et fixes, l'Appel de fonction peut suffire. Si vous construisez un système d'agent complexe impliquant plusieurs modèles et outils nécessitant une évolutivité à long terme, la standardisation et le découplage fournis par le MCP sont essentiels.

9. Limites et défis du MCP

Bien que le serveur MCP offre un moyen standardisé aux agents IA d'interagir avec les outils, ce n'est pas une "solution miracle". Comprendre ce que le MCP ne résout pas et les défis dans les environnements d'ingénierie réels est crucial.

1. Conflit de capacités et gouvernance avec plusieurs serveurs MCP

Dans les systèmes complexes, plusieurs serveurs MCP sont souvent connectés. Différents serveurs peuvent exposer des outils avec des sémantiques similaires ou des fonctions qui se chevauchent. Le protocole MCP gère les spécifications de déclaration et d'appel mais n'inclut pas :

- Le classement des priorités des outils

- La détection ou la résolution des conflits

- La stratégie de sélection optimale des outils en fonction du contexte

Cela signifie : La responsabilité de la prise de décision incombe entièrement au Client MCP ou à la couche de l'Agent IA. Le Planificateur ou le module de stratégie doit implémenter sa propre logique de sélection d'outils. Par conséquent, le MCP est une "couche d'exposition et de communication de capacités", pas un "système d'ordonnancement intelligent".

2. Pression contextuelle due aux appels à long terme et multi-tours

Dans les scénarios d'agents, les tâches impliquent plusieurs étapes :

- Planification

- Plusieurs appels d'outils (

tools/call) - Injection de résultats

- Re-raisonnement et prise de décision

Ce processus ajoute continuellement des informations à la fenêtre de contexte du LLM. Il est important de noter :

- Le MCP n'est pas responsable de l'élagage, de la compression ou de la synthèse du contexte.

- Il ne dispose pas de gestion de mémoire intégrée ni d'optimisation contextuelle.

Dans les tâches longues, cela peut entraîner :

- Une augmentation rapide des coûts de

Token - L'approche des limites de contexte du modèle

- L'"noyade" des informations clés

La gestion du contexte reste un défi que la couche d'architecture de l'Agent doit résoudre, et non le protocole MCP.

3. Différences de maturité entre les implémentations linguistiques

Bien que le protocole soit agnostique au langage, la maturité varie en pratique :

- Les écosystèmes

JavaScript/Node.jsetPythonsont les plus matures. - Les implémentations pour

Rust,GoetJavasont encore en évolution. - Le support des dernières spécifications peut varier entre les implémentations.

Les équipes d'ingénierie doivent :

- Assurer la cohérence entre les implémentations et les spécifications.

- Évaluer la stabilité et la maintenance des implémentations de serveur MCP pour les environnements de production.

Ceci est courant pour tout protocole émergent à ses débuts.

4. La sécurité et les permissions dépendent des systèmes externes

Le MCP est conçu pour être "neutre au protocole" et n'inclut pas de système de sécurité intégré. Plus précisément :

- Le MCP définit les limites des capacités (

Tools/Resources). - Il n'impose pas de mécanismes spécifiques d'authentification, d'autorisation ou d'audit.

Dans un déploiement réel, la sécurité doit être implémentée via des systèmes externes tels que :

OAuth/OIDC- Passerelles API

- Architectures Zero Trust

- Systèmes IAM d'entreprise

Un serveur MCP doit être considéré comme :

Un service de capacités enveloppé dans un système de sécurité, plutôt que le centre de contrôle de la sécurité lui-même.

C'est une raison clé pour laquelle le MCP peut s'adapter avec souplesse à différentes entreprises et environnements cloud, mais cela augmente également la complexité de la conception du système.

5. Évolution rapide du protocole et de l'écosystème

En tant que nouveau protocole pour les agents IA, le MCP évolue rapidement :

- Les détails et primitives du protocole sont en cours d'affinage.

- Il y a un décalage pour que les différentes implémentations prennent en charge les nouvelles fonctionnalités.

- Les meilleures pratiques pour les cas d'utilisation avancés sont encore en cours d'établissement.

Le MCP doit être considéré comme un protocole d'infrastructure à long terme plutôt que comme une norme finalisée et statique.

Les serveurs MCP se concentrent sur la fourniture d'un moyen standardisé de découvrir, d'appeler et de combiner des outils. Comprendre ces limitations aide les développeurs à :

- Définir des limites de responsabilité claires.

- Éviter une dépendance excessive au protocole lui-même.

- Résoudre la complexité au niveau architectural approprié.

Conclusion

En ingénierie pratique, le MCP agit comme une "fondation de protocole de capacité", dont la valeur devient plus évidente à mesure que la complexité du système augmente. Le serveur MCP ne remplace pas les API traditionnelles ou l'Appel de fonction ; au lieu de cela, il fournit une couche de protocole standardisée, extensible et sécurisée pour les agents IA. En introduisant cette couche, il répond aux défis d'ingénierie fondamentaux de la mise à l'échelle des agents IA : réduire la complexité d'intégration de N×M à N+M, fournir un cadre pour la découverte dynamique et l'exécution sécurisée, et découpler l'écosystème d'outils des modèles IA. Cela permet aux agents intelligents de :

- Accéder systématiquement aux capacités ;

- Découvrir et appeler dynamiquement des outils/ressources ;

- Interopérer sur différents modèles et plateformes.

Le MCP jette les bases d'un écosystème d'outils IA riche et composable. Il marque un passage de l'"intégration manuelle" à l'"infrastructure standardisée", fournissant une base pour la construction de systèmes IA d'entreprise interopérables, évolutifs et sécurisés.

Questions Fréquemment Posées (FAQ) sur le MCP

1. Le MCP remplacera-t-il les API traditionnelles ou l'Appel de fonction ?

Non. Le MCP n'est pas un remplacement mais agit à un niveau supérieur, permettant au Client MCP de découvrir dynamiquement des capacités d'un serveur MCP via la méthode list.

- Pour les scénarios simples, fixes, à modèle unique, l'Appel de fonction est efficace.

- Pour les systèmes d'Agent multi-modèles, multi-outils, évolutifs, le MCP offre un meilleur découplage et une meilleure maintenabilité.

Dans les systèmes du monde réel, les deux ont souvent une relation complémentaire.

2. Le MCP nécessite-t-il un LLM spécifique ?

Non. Le MCP est agnostique au modèle. Il régule la communication entre le Client et le Serveur et ne se soucie pas de savoir si le modèle sous-jacent provient d'OpenAI, d'Anthropic, de Google ou d'un modèle open-source local. Tant que l'application IA peut exposer le contexte de l'outil et initier des appels selon le protocole MCP, elle peut utiliser le serveur MCP.

3. Le MCP a-t-il une sécurité intégrée ?

Non. Il est neutre au protocole. La sécurité (HTTPS, OAuth2, IAM) doit être fournie par l'environnement de déploiement et les systèmes externes.

4. Comment les conflits d'outils sont-ils gérés avec plusieurs serveurs MCP ?

Le MCP ne résout pas les conflits. Si plusieurs serveurs offrent des outils similaires, la responsabilité de la sélection et de la priorité des outils incombe au Client ou à la couche du Planificateur de l'Agent.

5. Le MCP provoque-t-il une surcharge de la fenêtre de contexte ?

Oui, cela peut arriver, mais c'est un défi inhérent aux agents LLM. Le MCP ne gère pas le contexte ; la synthèse et la gestion de la mémoire sont de la responsabilité de l'architecture de l'Agent.

6. Le MCP convient-il à une utilisation en entreprise à haute concurrence ?

Oui, à condition que l'implémentation soit robuste. La haute concurrence dépend de la qualité du serveur, du déploiement multi-instance et des architectures cloud-native comme Kubernetes.

7. Le coût d'adoption du MCP est-il élevé ?

Le codage est relativement simple, mais il nécessite une compréhension architecturale des systèmes d'agents et de la gouvernance des outils. Il convient mieux aux équipes construisant des applications IA de taille moyenne à grande.

8. Le MCP est-il "stable" ?

La conception fondamentale est stable, mais l'écosystème est toujours en évolution. C'est un protocole d'infrastructure prospectif plutôt qu'une solution "unique et figée".

9. Le MCP convient-il aux développeurs individuels ?

Oui, s'il y a un besoin d'évolutivité. Pour des projets très simples, cela peut être "excessif", mais cela évite des coûts de refactoring élevés à mesure qu'un système grandit.

10. Quel problème le MCP résout-il le mieux ?

Il excelle dans la standardisation de l'accès à plusieurs outils/services, le découplage de la découverte des capacités de l'exécution, et la réutilisation des capacités sur différents modèles et équipes.

Série d'articles MCP:

- Analyse Complète du Serveur MCP : Le Hub de Communication pour le Contexte et les Outils à l'Ère des Agents IA

- Quels Problèmes Clés le Serveur MCP Résout-il ? Pourquoi les Agents IA en Ont-ils Besoin ?

- Architecture et principes de fonctionnement du serveur MCP : Du protocole au flux d'exécution

- Guide Pratique du Serveur MCP : Construction, Test et Déploiement de A à Z

- Évaluation des Scénarios d'Application du Serveur MCP et Guide de Sélection Technique

À propos de l'auteur

Ce contenu est compilé et publié par l'équipe éditoriale de contenu NavGood. NavGood est une plateforme axée sur les outils IA et les écosystèmes d'applications, suivant le développement et la mise en œuvre des agents IA, des workflows automatisés et de l'IA générative.

Avertissement: Cet article représente la compréhension et l'expérience personnelles de l'auteur. Il ne représente pas la position officielle d'un quelconque framework ou entreprise et ne constitue pas un conseil commercial ou d'investissement.

Références : [1]: https://json-rpc.dev/learn/mcp-basics "Understanding JSON-RPC for AI Integration" [2]: https://modelcontextprotocol.io/docs/learn/architecture "Architecture overview - Model Context Protocol" [3]: https://json-rpc.org/specification "JSON-RPC 2.0 Specification" [4]: https://modelcontextprotocol.io/docs/learn/architecture "About MCP: Architecture overview"