DeepSeek V3

Vue d'ensemble de DeepSeek V3

Qu'est-ce que DeepSeek V3 ?

DeepSeek V3 est un modèle de langage à grande échelle open-source révolutionnaire comptant 671 milliards de paramètres impressionnants, avec 37 milliards activés par token pour un traitement efficace. Développé comme une solution d'IA de pointe, il permet aux utilisateurs d'exploiter la compréhension et la génération avancées du langage naturel sans les barrières de coût ou de restrictions propriétaires. Que vous exploriez l'IA pour la recherche, le développement ou des projets commerciaux, DeepSeek V3 se distingue par son accessibilité et ses performances, ce qui en fait un choix de premier plan parmi les modèles d'IA gratuits dans le paysage en évolution rapide des outils d'apprentissage automatique.

Ce modèle n'est pas juste une autre itération—il est conçu pour rivaliser avec les systèmes propriétaires leaders tout en restant entièrement open-source. Publié avec un accent sur l'évolutivité et la facilité d'utilisation, DeepSeek V3 supporte une longueur de contexte généreuse de 128K, permettant de gérer des entrées extensives comme de longs documents ou des conversations complexes. Son architecture optimise à la fois la profondeur et l'efficacité, garantissant des sorties de haute qualité même sur du matériel modeste lors d'une exécution locale.

Comment fonctionne DeepSeek V3 ?

À son cœur, DeepSeek V3 fonctionne sur une architecture basée sur les transformateurs, un pilier des modèles de langage à grande échelle modernes. Les 671 milliards de paramètres du modèle lui permettent de capturer des motifs complexes dans de vastes ensembles de données, des tâches de traitement du langage naturel à la génération de contenu créatif. Pour chaque token traité, seulement 37 milliards de paramètres sont activés, ce qui est une approche intelligente de mixture of experts (MoE) réduisant la surcharge computationnelle sans sacrifier les capacités. Cela signifie des temps d'inférence plus rapides et des demandes de ressources plus faibles comparé aux modèles denses de taille similaire.

Les utilisateurs peuvent interagir avec DeepSeek V3 de deux manières principales : via une démo en ligne intuitive ou en téléchargeant le code source complet pour un déploiement local. La version en ligne s'exécute directement dans votre navigateur, tirant parti de l'infrastructure cloud pour un accès instantané—aucune configuration requise. Côté local, l'implémentation open-source sur GitHub fournit tout le nécessaire : poids du modèle, code et documentation. L'intégration est simple via des endpoints API, supportant des frameworks populaires comme la bibliothèque Hugging Face Transformers de Python. Par exemple, les développeurs peuvent charger le modèle avec une simple commande et commencer à générer du texte, de l'assistance au codage ou même des traductions.

L'entraînement du modèle met l'accent sur des sources de données diversifiées, incluant des textes multilingues, des dépôts de code et de la littérature scientifique, résultant en des performances robustes across domains. Sa nature open-source invite également les contributions communautaires, favorisant des améliorations continues via des forks et pull requests sur GitHub.

Comment utiliser DeepSeek V3 ?

Commencer avec DeepSeek V3 est remarquablement simple, s'alignant sur son éthos d'accès à l'IA sans barrières.

Démo en ligne : Rendez-vous sur la plateforme DeepSeek Online et cliquez sur 'Essayer maintenant'. Aucune inscription ou carte de crédit n'est nécessaire—tapez simplement votre prompt et recevez des réponses en secondes. C'est idéal pour des tests rapides, des brainstormings d'idées ou évaluer les forces du modèle en temps réel.

Installation locale : Visitez le dépôt GitHub pour télécharger les modèles DeepSeek-V3-Base ou DeepSeek-V3 complets. Les exigences système varient : un GPU avec au moins 24GB de VRAM est recommandé pour des performances optimales, bien que le mode CPU seul fonctionne pour des tâches plus légères. L'installation implique de cloner le repo, d'installer les dépendances via pip et d'exécuter des scripts d'inférence. Une documentation complète vous guide à travers les techniques de quantification pour adapter le modèle sur du matériel grand public.

Intégration API : Pour les applications de production, utilisez les wrappers API fournis. Intégrez DeepSeek V3 dans des chatbots, des outils de contenu ou des pipelines d'analyse. Des exemples de snippets de code dans le repo démontrent comment gérer les requêtes, manager les contextes et fine-tuner pour des cas d'usage spécifiques.

L'accès illimité signifie que vous pouvez expérimenter librement, sans limites de débit sur la démo en ligne. Pour un usage commercial, la licence permissive autorise redistribution et modification, tant que l'attribution est donnée.

Pourquoi choisir DeepSeek V3 ?

Dans un marché inondé de services d'IA payants, DeepSeek V3 brille par son modèle à coût zéro et une ouverture incomparable. Voici pourquoi c'est un changeur de jeu :

Puissance inégalée sans coût : Avec 671 milliards de paramètres, il produit des sorties comparables aux modèles de premier plan comme GPT-4 dans des benchmarks de raisonnement, codage et tâches multilingues. Pourtant, il est entièrement gratuit, même pour les entreprises faisant évoluer des solutions d'IA.

Liberté commerciale : Contrairement à nombreux niveaux gratuits qui restreignent l'usage, DeepSeek V3 permet une application commerciale complète. Les startups et entreprises peuvent construire des produits générateurs de revenus sans frais de licence.

Excellence pilotée par la communauté : Soutenu par une communauté GitHub vibrante, le modèle bénéficie de mises à jour rapides, corrections de bugs et extensions. Les contributions utilisateurs ont déjà amélioré ses capacités de fine-tuning pour des domaines de niche comme le texte juridique ou médical.

Polyvalent et efficace : La fenêtre de contexte de 128K supporte la génération long format, tandis que l'activation MoE maintient une basse consommation d'énergie—crucial pour le développement durable de l'IA.

Comparé aux concurrents, DeepSeek V3 surpasse souvent dans les métriques d'efficacité. Par exemple, dans des benchmarks de codage, il génère des scripts Python fonctionnels avec moins d'erreurs que des modèles open plus petits, et son support multilingue dépasse les alternatives centrées sur l'anglais.

À qui s'adresse DeepSeek V3 ?

DeepSeek V3 répond à un large public dans l'écosystème de l'IA :

Développeurs et chercheurs : Idéal pour prototyper des applications d'IA, expérimenter avec le fine-tuning ou faire avancer des projets d'apprentissage automatique. Son code open-source accélère l'innovation sans verrouillage vendor.

Entreprises et startups : Parfait pour une intégration d'IA rentable dans des bots de service client, l'automatisation de contenu ou des outils d'analyse de données. La licence commerciale supprime les obstacles légaux à la monétisation.

Éducateurs et étudiants : Utilisez la démo en ligne pour un apprentissage pratique sur les modèles de langage à grande échelle. C'est une façon pratique d'enseigner les concepts de NLP sans abonnements coûteux.

Créateurs de contenu et amateurs : Générez des articles, snippets de code ou écriture créative sans effort. L'accès gratuit illimité le rend accessible aux utilisateurs occasionnels explorant le potentiel de l'IA.

Si vous cherchez le meilleur modèle d'IA gratuit pour des tâches comme la rédation automatique de rapports, le débogage de code ou la traduction multilingue, DeepSeek V3 s'intègre parfaitement.

Cas d'usage principaux et valeur pratique

La polyvalence de DeepSeek V3 débloque de nombreuses applications :

Génération de langage naturel : Rédigez des emails, blogs ou copies marketing avec une précision contextuelle. Par exemple, entrez un plan de sujet et obtenez un article poli de 1000 mots.

Assistance au codage : Agit comme un compagnon de programmation IA, suggérant des complétions, revoyant le code ou expliquant des algorithmes. Les développeurs rapportent des workflows 30-50% plus rapides en l'utilisant alongside IDEs.

Recherche et analyse : Résumez des articles, générez des hypothèses ou analysez des jeux de données. Son long contexte gère des documents de recherche complets, aidant les académiques dans les revues de littérature.

Applications multilingues : Supporte plus de 20 langues, le rendant valuable pour des équipes globales en traduction, localisation ou support client international.

La valeur pratique réside dans la démocratisation de l'IA haut de gamme. En éliminant les paywalls, il nivelle le terrain de jeu, permettant aux petites équipes de rivaliser avec les géants tech. Les utilisateurs louent sa fiabilité dans les FAQs, notant une configuration rapide et des résultats constants. Une question commune : "Est-ce vraiment gratuit pour un usage commercial ?" Oui—téléchargez et déployez sans conditions.

Pour les exigences système, les runs locaux need robust hardware (par ex., GPUs NVIDIA A100 pour pleine vitesse), mais les versions quantifiées run sur laptops. Les FAQs d'intégration couvrent le troubleshooting, comme gérer les clés API ou optimiser pour edge devices.

Foire aux questions

Quelles sont les exigences système pour exécuter DeepSeek V3 ?

Pour un usage local, une machine avec 80+ GB de RAM et un GPU haut de gamme est idéal. Les options cloud via la démo en ligne contournent cela.

Puis-je intégrer DeepSeek V3 dans mes applications existantes ?

Absolument—utilisez la documentation GitHub pour la configuration API. C'est compatible avec les principaux frameworks ML.

Comment DeepSeek V3 se compare-t-il à d'autres modèles d'IA ?

Il égale ou dépasse beaucoup dans les benchmarks d'efficacité et de qualité de sortie, le tout en étant gratuit et open.

En résumé, DeepSeek V3 représente le futur de l'IA accessible, mélangeant puissance brute et design convivial. Que vous soyez un ingénieur IA chevronné ou un débutant curieux, ce modèle délivre une valeur tangible en simplifiant les capacités avancées. Téléchargez dès aujourd'hui depuis GitHub ou essayez la démo en ligne pour voir pourquoi il est salué comme le modèle d'IA gratuit le plus puissant disponible.

Meilleurs outils alternatifs à "DeepSeek V3"

ProxyAI est un copilote IA pour les IDE JetBrains offrant des fonctionnalités telles que la saisie semi-automatique de code, l'édition en langage naturel et l'intégration avec les LLM de premier plan. Il prend en charge le développement hors ligne et divers modèles via des clés API.

Promptfoo est un outil de sécurité LLM open source utilisé par plus de 200 000 développeurs pour le red-teaming et les évaluations de l'IA. Il aide à trouver les vulnérabilités, à maximiser la qualité de la production et à détecter les régressions dans les applications d'IA.

ProxyAI est un assistant de code alimenté par l’IA pour les IDE JetBrains, offrant la saisie semi-automatique du code, l’édition en langage naturel et la prise en charge hors ligne avec les LLM locaux. Améliorez votre codage avec l’IA.

Aicado.ai fournit un outil de comparaison de modèles d'IA côte à côte, incluant GPT-4o, Claude, Llama et bien plus encore. Testez les invites en temps réel et analysez les performances de l'IA.

Plateforme IA ultra-rapide pour les développeurs. Déployez, affinez et exécutez plus de 200 LLMs et modèles multimodaux optimisés avec des API simples - SiliconFlow.

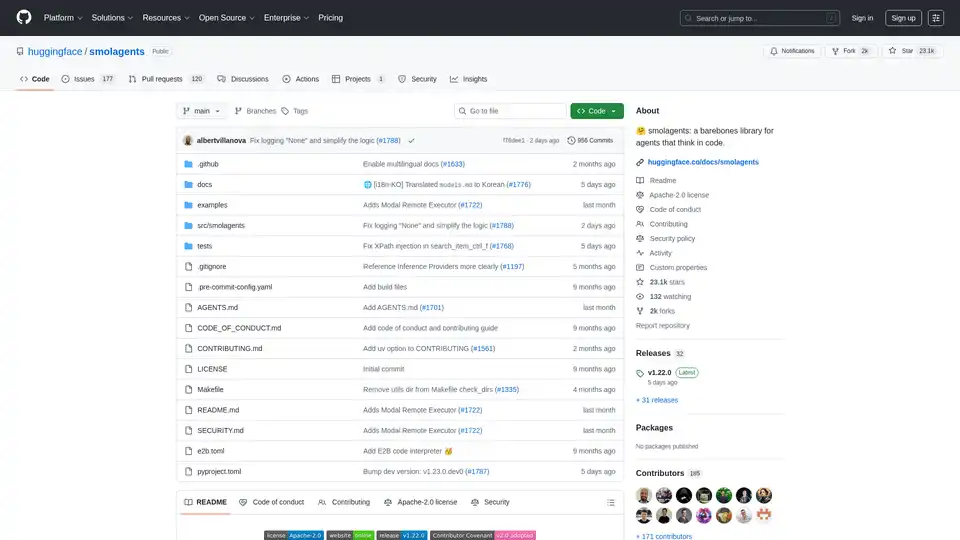

Smolagents est une bibliothèque Python minimaliste pour créer des agents IA qui raisonnent et agissent via du code. Elle prend en charge les modèles LLM agnostiques, les sandboxes sécurisées et une intégration fluide avec Hugging Face Hub pour des flux de travail d'agents basés sur le code efficaces.

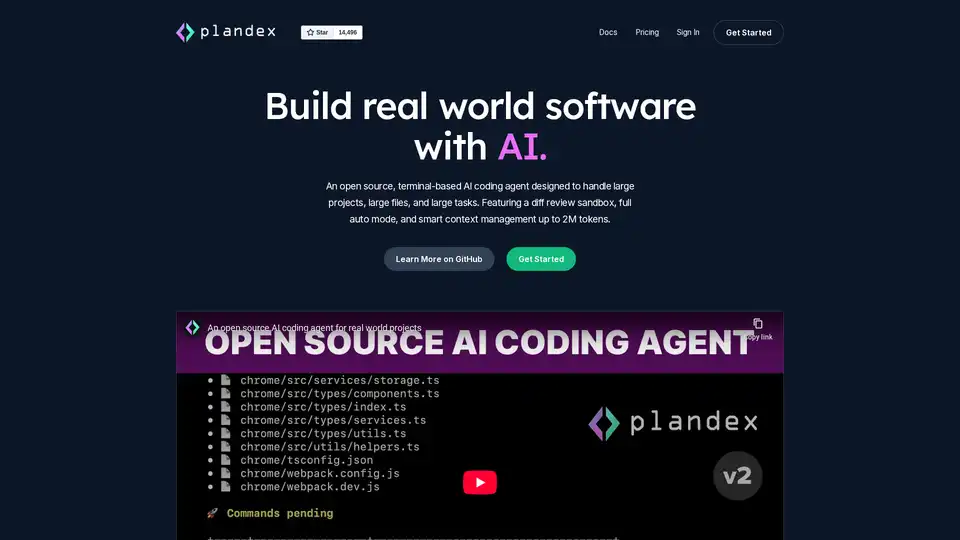

Plandex est un agent de codage IA open source et basé sur terminal conçu pour les grands projets et les tâches du monde réel. Il propose une révision de diffs, un mode automatique complet et une gestion de contexte jusqu'à 2M tokens pour un développement logiciel efficace avec les LLMs.

Xander est une plateforme de bureau open source qui permet l'entraînement de modèles IA sans code. Décrivez les tâches en langage naturel pour des pipelines automatisés en classification de texte, analyse d'images et fine-tuning LLM, assurant la confidentialité et les performances sur votre machine locale.

xTuring est une bibliothèque open source qui permet aux utilisateurs de personnaliser et d'ajuster finement les Modèles de Langage Large (LLMs) de manière efficace, en se concentrant sur la simplicité, l'optimisation des ressources et la flexibilité pour la personnalisation de l'IA.

GitHub Copilot est un assistant de codage alimenté par IA qui s'intègre dans votre IDE, suggérant des lignes de code, gérant les problèmes via le mode agent et fournissant des revues pour booster la productivité des développeurs.

Sagify est un outil Python open-source qui rationalise les pipelines d'apprentissage automatique sur AWS SageMaker, offrant une passerelle LLM unifiée pour intégrer de manière transparente les modèles de langage large propriétaires et open-source.

Explorez Qwen3 Coder, le modèle de génération de code IA avancé d'Alibaba Cloud. Découvrez ses fonctionnalités, benchmarks de performance et comment utiliser cet outil open-source puissant pour le développement.

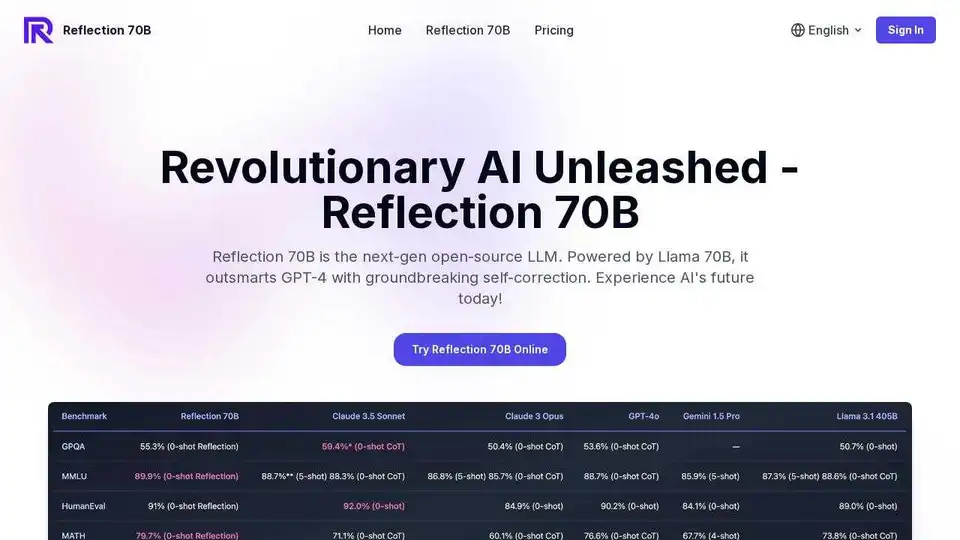

Découvrez Reflection 70B, le principal modèle d'IA open source au monde. Entraîné avec Reflection-Tuning, il détecte et corrige les erreurs de raisonnement en temps réel, ce qui le rend parfait pour les tâches complexes.

Essayez Reflection 70B en ligne, un LLM open source basé sur Llama 70B. Surpasse GPT-4 avec une auto-correction innovante. Essai gratuit en ligne disponible.