Robots.txt Generator

Vue d'ensemble de Robots.txt Generator

Générateur de Robots.txt : Créez le fichier robots.txt parfait

Qu'est-ce qu'un fichier robots.txt ?

Un fichier robots.txt est un fichier texte qui indique aux robots d'exploration des moteurs de recherche les pages ou les fichiers qu'ils peuvent ou ne peuvent pas demander à votre site. Il est important pour le SEO car il vous aide à contrôler les parties de votre site Web qui sont indexées, empêchant les robots d'exploration d'accéder à du contenu sensible ou dupliqué.

Comment fonctionne le générateur de Robots.txt ?

Cet outil gratuit de générateur et de validateur de Robots.txt aide les webmasters, les experts en SEO et les marketeurs à créer rapidement et facilement ce fichier requis. Vous pouvez personnaliser le fichier en configurant des directives (autoriser ou interdire l'exploration), le chemin d'accès (pages et fichiers spécifiques) et les robots qui doivent suivre les directives. Vous pouvez également choisir un modèle de robots.txt prêt à l'emploi contenant un ensemble des directives générales et CMS les plus courantes. Vous pouvez également ajouter un plan de site au fichier.

Principales caractéristiques :

- Configurations par défaut:

- Autoriser tous les robots à accéder à l'ensemble du site.

- Empêcher tous les robots d'accéder à l'ensemble du site.

- Bloquer un répertoire ou un fichier spécifique.

- Autoriser uniquement un robot spécifique (par exemple, Googlebot) et bloquer tous les autres.

- Bloquer les paramètres d'URL spécifiques.

- Autoriser l'exploration d'un répertoire spécifique et bloquer tout le reste.

- Bloquer les images d'un répertoire spécifique.

- Bloquer l'accès aux fichiers CSS et JS.

- Modèles CMS: Modèles de robots.txt prêts à l'emploi pour les plateformes CMS populaires, notamment :

- WordPress

- Shopify

- Magento

- Drupal

- Joomla

- PrestaShop

- Wix

- BigCommerce

- Squarespace

- Weebly

- Blocage des robots d'IA: Configurations facultatives pour bloquer ou autoriser des robots d'IA spécifiques, tels que :

- GPTBot

- ChatGPT-User

- Google-Extended

- PerplexityBot

- Amazonbot

- ClaudeBot

- Omgilibot

- FacebookBot

- Applebot

- et bien d'autres.

- Intégration du plan de site: Possibilité d'ajouter l'URL de votre plan de site au fichier robots.txt.

Comment utiliser le générateur de Robots.txt :

- Commencez par une configuration par défaut: Choisissez une configuration de base qui correspond à vos besoins. Les options incluent l'autorisation de tous les robots, le blocage de tous les robots ou le blocage de répertoires ou de fichiers spécifiques.

- Personnalisez les directives: Définissez des directives pour autoriser ou interdire l'exploration, spécifiez les chemins d'accès (pages et fichiers spécifiques) et identifiez les robots qui doivent suivre les directives.

- Sélectionnez un modèle: Choisissez un modèle de robots.txt prêt à l'emploi pour les plateformes CMS courantes.

- Ajoutez un plan de site: Incluez l'URL de votre plan de site pour aider les robots à explorer plus efficacement le contenu de votre site Web.

- Téléchargez et implémentez: Téléchargez le fichier robots.txt généré et ajoutez-le au dossier racine de votre site Web.

Comment ajouter le fichier robots.txt généré à votre site Web ?

Les moteurs de recherche et autres robots d'exploration recherchent un fichier robots.txt dans le répertoire principal de votre site Web. Après avoir généré le fichier robots.txt, ajoutez-le au dossier racine de votre site Web, que vous trouverez à l'adresse https://yoursite.com/robots.txt.

La méthode d'ajout d'un fichier robots.txt dépend du serveur et du CMS que vous utilisez. Si vous ne pouvez pas accéder au répertoire racine, contactez votre hébergeur Web.

Avantages de l'utilisation du générateur de Robots.txt :

- Optimisation SEO: Contrôlez les parties de votre site Web qui sont indexées par les moteurs de recherche, améliorant ainsi les performances SEO de votre site.

- Personnalisation: Adaptez le fichier robots.txt à vos besoins spécifiques grâce à diverses directives et modèles.

- Contrôle des robots d'IA: Bloquez ou autorisez des robots d'IA spécifiques à explorer votre site.

- Intégration facile du plan de site: Ajoutez l'URL de votre plan de site pour aider les robots à explorer efficacement le contenu de votre site Web.

- Contribution Open Source: Contribuez au projet sur GitHub pour ajouter de nouvelles fonctionnalités, corriger des bogues ou améliorer le code existant.

Contribution au projet :

Il s'agit d'un projet open source, et tout le monde est invité à participer. Vous pouvez contribuer à ce projet en ajoutant de nouvelles fonctionnalités, en corrigeant des bogues ou en améliorant le code existant en créant une demande d'extraction ou un problème sur notre dépôt GitHub.

FAQ

Comment soumettre un fichier robots.txt aux moteurs de recherche ?

Vous n'avez pas besoin de soumettre un fichier robots.txt aux moteurs de recherche. Les robots d'exploration recherchent un fichier robots.txt avant d'explorer un site. S'ils en trouvent un, ils le lisent d'abord avant d'analyser votre site.

Si vous apportez des modifications à votre fichier robots.txt et que vous souhaitez en informer Google, vous pouvez le soumettre à Google Search Console. Utilisez le testeur de Robots.txt pour coller le fichier texte et cliquez sur Envoyer.

Meilleurs outils alternatifs à "Robots.txt Generator"

Firecrawl est l'API de crawling, scraping et recherche web leader conçue pour les applications IA. Elle transforme les sites web en données propres, structurées et prêtes pour LLM à grande échelle, alimentant les agents IA avec une extraction web fiable sans proxies ni tracas.

Rush Analytics : plateforme SEO avec suivi du classement, recherche de mots clés, audit de site et outils PBN. Surveillez, découvrez et optimisez pour un meilleur classement.

Flexbe.AI est un constructeur de site web alimenté par l'IA qui génère des sites web en moins de 60 secondes. Il offre des études de marché, une conception et une création de contenu pilotées par l'IA, ainsi qu'un éditeur professionnel et des outils de commerce électronique.

Skills.ai : moteur d'analyse de données IA sans code pour les chefs d'entreprise et les créateurs de contenu. Générez instantanément des articles et des présentations basés sur les données pour les réunions clients et les médias sociaux.

Transformez n'importe quel site Web en données propres et structurées avec Skrape.ai. Notre API basée sur l'IA extrait les données dans votre format préféré pour l'entraînement à l'IA.

ScrapeStorm est un outil de web scraping visuel basé sur l'IA qui permet aux utilisateurs d'extraire des données de sites web sans codage. Il offre une identification intelligente des données, de multiples options d'exportation et prend en charge divers systèmes d'exploitation.

FYRAN est un créateur de chatbot IA gratuit qui prend en charge les réponses humaines numériques. Créez des chatbots personnalisés à l'aide de fichiers PDF, texte, MP3 et docx. Intégrez-le facilement via site web, API, JS ou HTML.

CoverLetterAI est un outil alimenté par IA qui génère des lettres de motivation personnalisées et optimisées ATS en quelques secondes pour seulement 5 $ par lettre. Téléchargez votre CV et les détails du poste pour obtenir des lettres professionnelles sur mesure aidant les chercheurs d'emploi à décrocher des entretiens.

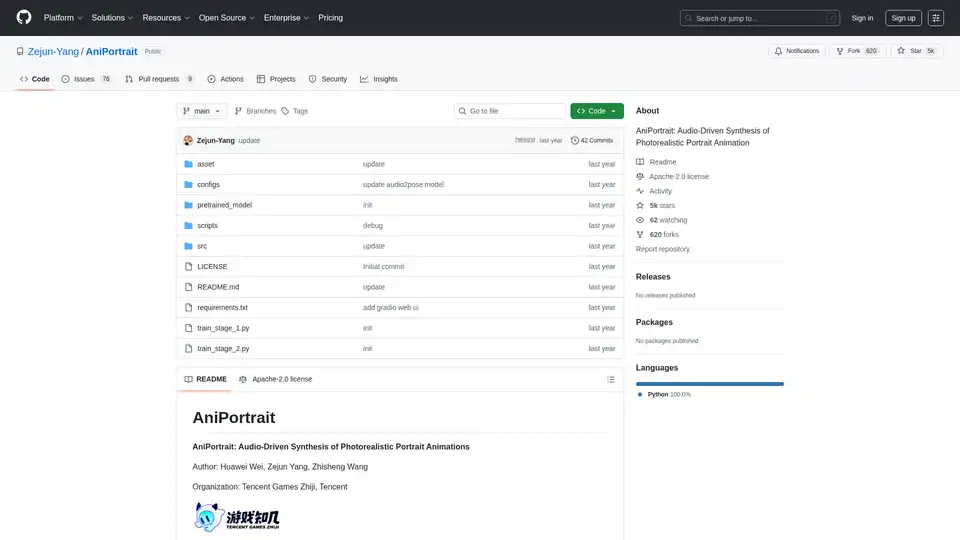

AniPortrait est un framework IA open-source pour générer des animations de portrait photoréalistes pilotées par audio ou vidéo. Il prend en charge les modes auto-conduits, reenactment facial et audio pour une synthèse vidéo de haute qualité.

Explorez la robotique et l'IA : découvrez des robots, des outils d'IA, des événements et des emplois dans la robotique et l'IA. Optimisez la productivité et la créativité avec des outils d'IA de premier plan.

Améliorez les conversations Telegram avec les robots et agents d’IA. Invoquez-les pour répondre à des questions, vous aider dans vos tâches ou créer du contenu sans quitter Telegram. Découvrez AI Inline Assistant, Llama 3.1, DALL·E, Gemini et plus encore !

Teragon Robotics développe des robots humanoïdes auto-répliquants utilisant la planification de l'IA et du matériel modulaire. Ces robots fabriquent des composants de manière autonome et assemblent de nouvelles unités,解决遥远地区和遭受灾难地区的制造瓶颈。

Lucky Robots génère des données synthétiques infinies pour l'entraînement de modèles d'IA robotique. Entraînez-vous plus rapidement et à moindre coût avec des simulations réalistes. Itérez, entraînez-vous et testez avant le déploiement dans le monde réel.

Starving Robots propose l'impression d'art IA personnalisée et des impressions d'art IA personnalisées. Créez des affiches et des toiles uniques à l'aide de l'IA.