Fireworks AI

Vue d'ensemble de Fireworks AI

Fireworks AI : Le moteur d'inférence le plus rapide pour l'IA générative

Qu'est-ce que Fireworks AI ? Fireworks AI est une plateforme conçue pour fournir les vitesses d'inférence les plus rapides pour les modèles d'IA générative. Elle permet aux utilisateurs de créer, d'ajuster et de mettre à l'échelle des applications d'IA avec facilité, en tirant parti de modèles open source optimisés pour divers cas d'utilisation.

Comment fonctionne Fireworks AI ? Fireworks AI atteint des performances élevées grâce à son moteur d'inférence, qui est optimisé pour une faible latence, un débit élevé et la concurrence. La plateforme prend en charge les modèles populaires tels que DeepSeek, Llama, Qwen et Mistral, ce qui permet aux développeurs d'expérimenter et d'itérer rapidement à l'aide des SDK Fireworks.

Principales caractéristiques et avantages

- Inférence ultrarapide: Offre des performances en temps réel avec une latence minimale, adaptée aux applications stratégiques.

- Réglage avancé: Fournit des outils permettant d'optimiser la qualité du modèle grâce à des techniques telles que l'apprentissage par renforcement et le réglage tenant compte de la quantification.

- Mise à l'échelle transparente: Provisionne automatiquement les derniers GPU sur plusieurs clouds et régions, garantissant une haute disponibilité et des performances constantes.

- Modèles open source: Prend en charge un large éventail de modèles open source, offrant flexibilité et options de personnalisation.

- Prêt pour l'entreprise: Inclut des fonctionnalités de collaboration sécurisée en équipe, de surveillance et de conformité (SOC2 Type II, RGPD, HIPAA).

Cas d'utilisation

Fireworks AI convient à diverses applications, notamment :

- Agents vocaux: Alimentation d'interactions vocales en temps réel avec une faible latence.

- Assistants de code: Amélioration de la génération et de la saisie semi-automatique de code avec des vitesses d'inférence rapides.

- Outils de développement d'IA: Activation du réglage précis, de la recherche de code alimentée par l'IA et du contexte de code approfondi pour améliorer les flux de travail de développement.

Pourquoi Fireworks AI est-il important ?

Fireworks AI répond au besoin de rapidité et d'évolutivité des applications d'IA générative. En optimisant l'inférence et en assurant une mise à l'échelle transparente, elle permet aux entreprises de déployer des fonctionnalités d'IA à grande échelle sans sacrifier les performances ni la rentabilité.

À qui s'adresse Fireworks AI ?

Fireworks AI est idéale pour :

- Les entreprises: qui cherchent à déployer des solutions d'IA avec une sécurité et une conformité de niveau entreprise.

- Les développeurs: à la recherche d'une plateforme rapide et flexible pour expérimenter des modèles open source.

- Les chercheurs en IA: qui ont besoin d'une infrastructure robuste pour l'entraînement et le déploiement de modèles d'IA.

Témoignages de clients

Plusieurs entreprises ont connu le succès avec Fireworks AI :

- Cursor: Sualeh Asif, directeur des produits, a salué Fireworks pour ses performances et la dégradation minimale de la qualité des modèles quantifiés.

- Quora: Spencer Chan, chef de produit, a souligné que Fireworks était la meilleure plateforme pour servir les LLM open source et mettre à l'échelle les adaptateurs LoRA.

- Sourcegraph: Beyang Liu, directeur de la technologie, a souligné l'inférence de modèle rapide et fiable de Fireworks pour la création d'outils de développement d'IA comme Cody.

- Notion: Sarah Sachs, responsable de l'IA, a signalé une réduction significative de la latence grâce à son partenariat avec Fireworks pour affiner les modèles.

Tarification

Fireworks AI offre des options de tarification flexibles pour répondre à différents besoins. Vous trouverez des informations détaillées sur leur page Tarification.

Mise en route

Pour commencer à créer avec Fireworks AI, visitez leur site Web et explorez les modèles et la documentation disponibles. Vous pouvez également contacter leur équipe commerciale pour obtenir des solutions d'entreprise.

Quelle est la meilleure façon de tirer parti de Fireworks AI ? Pour maximiser les avantages de Fireworks AI, commencez par identifier votre cas d'utilisation spécifique et sélectionnez le modèle open source approprié. Utilisez les SDK Fireworks pour affiner le modèle et l'optimiser pour votre application. Tirez parti des capacités de mise à l'échelle de la plateforme pour déployer vos fonctionnalités d'IA à l'échelle mondiale sans gérer l'infrastructure.

En fournissant un moteur d'inférence robuste et évolutif, Fireworks AI permet aux développeurs et aux entreprises d'exploiter la puissance de l'IA générative avec une rapidité et une efficacité sans précédent.

Meilleurs outils alternatifs à "Fireworks AI"

Friendli Inference est le moteur d'inférence LLM le plus rapide, optimisé pour la vitesse et la rentabilité, réduisant les coûts GPU de 50 à 90 % tout en offrant un débit élevé et une faible latence.

vLLM est un moteur d'inférence et de service à haut débit et à faible consommation de mémoire pour les LLM, doté de PagedAttention et d'un traitement par lots continu pour des performances optimisées.

Spice.ai est un moteur d'inférence de données et d'IA open source pour créer des applications d'IA avec la fédération de requêtes SQL, l'accélération, la recherche et la récupération basées sur les données d'entreprise.

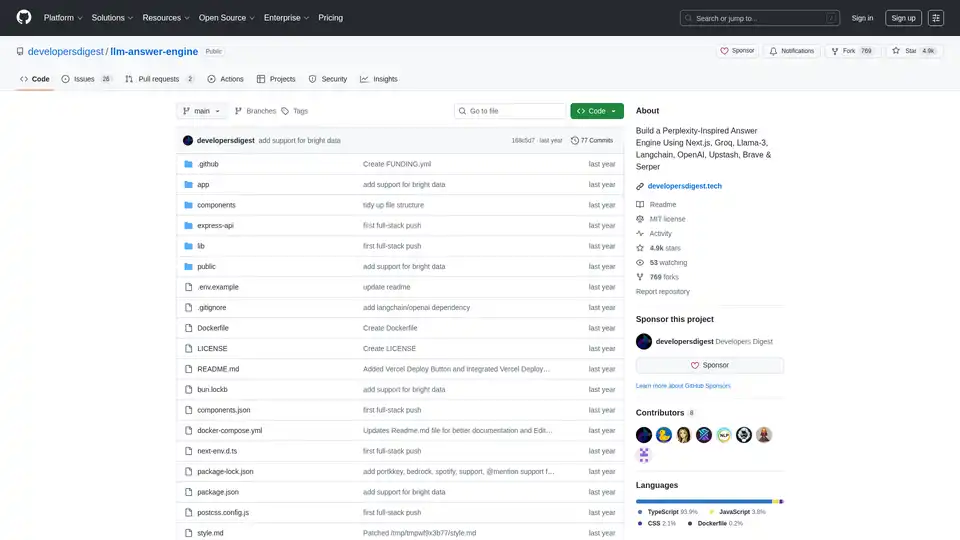

Construisez un moteur de réponses IA inspiré de Perplexity en utilisant Next.js, Groq, Llama-3 et Langchain. Obtenez des sources, des réponses, des images et des questions de suivi efficacement.

Plateforme IA ultra-rapide pour les développeurs. Déployez, affinez et exécutez plus de 200 LLMs et modèles multimodaux optimisés avec des API simples - SiliconFlow.

AI Runner est un moteur d'inférence d'IA hors ligne pour l'art, les conversations vocales en temps réel, les chatbots alimentés par LLM et les flux de travail automatisés. Exécutez la génération d'images, le chat vocal et plus encore localement !

Xander est une plateforme de bureau open source qui permet l'entraînement de modèles IA sans code. Décrivez les tâches en langage naturel pour des pipelines automatisés en classification de texte, analyse d'images et fine-tuning LLM, assurant la confidentialité et les performances sur votre machine locale.

mistral.rs est un moteur d'inférence LLM ultra-rapide écrit en Rust, prenant en charge les flux de travail multimodaux et la quantification. Offre des API Rust, Python et serveur HTTP compatible OpenAI.

Botpress est une plateforme complète d'agents IA alimentée par les derniers LLM. Il vous permet de créer, de déployer et de gérer des agents d'IA pour le support client, l'automatisation interne, etc., avec des capacités d'intégration transparentes.

UsageGuard propose une plateforme IA unifiée pour un accès sécurisé aux LLMs d'OpenAI, Anthropic et plus, avec des sauvegardes intégrées, optimisation des coûts, surveillance en temps réel et sécurité de niveau entreprise pour rationaliser le développement IA.

PocketLLM est un moteur de recherche de connaissances IA privé de ThirdAI. Recherchez dans les PDF, les documents et les URL localement sur votre appareil. Affinez les résultats et résumez pour une compréhension facile.

Rierino est une plateforme low-code puissante qui accélère l'ecommerce et la transformation numérique avec des agents IA, un commerce composable et des intégrations fluides pour une innovation évolutive.

HUMAIN fournit des solutions d'IA complètes, couvrant l'infrastructure, les données, les modèles et les applications. Accélérez les progrès et libérez un impact concret à grande échelle grâce aux plateformes natives d'IA de HUMAIN.

Advacheck est un outil alimenté par l'IA qui détecte avec précision le contenu généré par l'IA et le plagiat. Idéal pour les étudiants, les chercheurs, les référenceurs et les spécialistes du marketing qui garantissent l'intégrité et l'originalité du contenu.