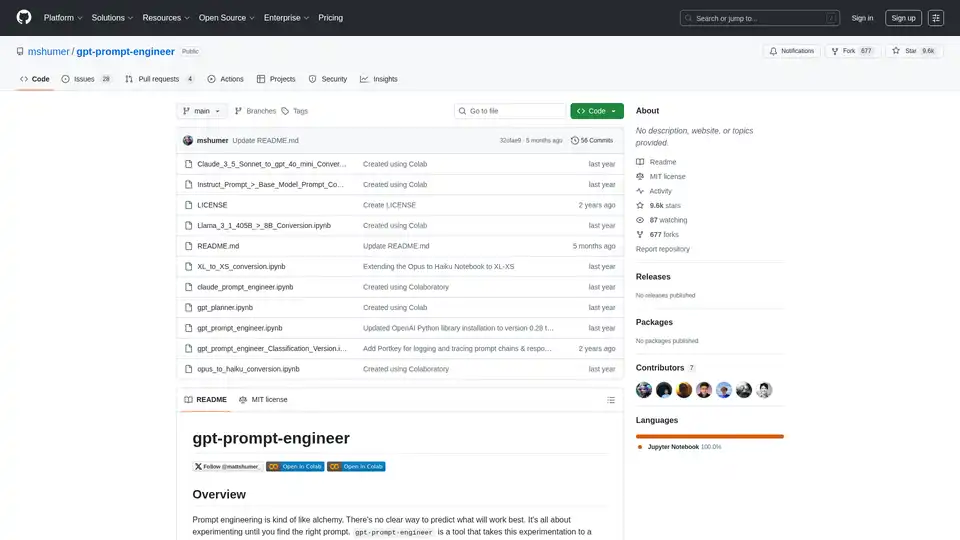

gpt-prompt-engineer

Vue d'ensemble de gpt-prompt-engineer

Qu'est-ce que gpt-prompt-engineer ?

gpt-prompt-engineer est un outil open-source conçu pour automatiser le processus d'ingénierie des prompts pour les grands modèles de langage (LLM) comme GPT-4, GPT-3.5-Turbo et Claude 3. Il aide les utilisateurs à découvrir des prompts optimaux en générant, testant et classant plusieurs prompts en fonction de cas de test définis par l'utilisateur.

Comment fonctionne gpt-prompt-engineer ?

- Génération de prompts: L'outil utilise des LLM pour générer un éventail diversifié de prompts basés sur une description de cas d'utilisation fournie et des cas de test associés.

- Test de prompts: Chaque prompt généré est testé par rapport aux cas de test fournis pour évaluer ses performances.

- Système de notation ELO: Un système de notation ELO est utilisé pour classer les prompts en fonction de leurs performances. Chaque prompt commence avec une notation ELO initiale, et les notations sont ajustées en fonction des performances du prompt par rapport aux cas de test. Cela permet aux utilisateurs d'identifier facilement les prompts les plus efficaces.

Principales caractéristiques de gpt-prompt-engineer

- Génération automatisée de prompts: Génère automatiquement une multitude de prompts potentiels basés sur un cas d'utilisation et des cas de test donnés.

- Test et classement des prompts: Teste systématiquement chaque prompt par rapport aux cas de test et les classe à l'aide d'un système de notation ELO afin d'identifier les plus efficaces.

- Prise en charge de Claude 3 Opus: Une version spécialisée tire pleinement parti du modèle Claude 3 Opus d'Anthropic, permettant la génération automatisée de cas de test et de multiples variables d'entrée.

- Conversion Claude 3 Opus → Haiku: Cette fonctionnalité permet aux utilisateurs d'exploiter Claude 3 Opus pour définir l'espace latent et Claude 3 Haiku pour une génération de sortie efficace, réduisant ainsi la latence et les coûts.

- Version de classification: Conçue pour les tâches de classification, cette version évalue l'exactitude d'un cas de test en le comparant à la sortie attendue ('true' ou 'false') et fournit un tableau avec les scores de chaque prompt.

- Journalisation des poids et biais: Journalisation facultative vers Weights & Biases pour le suivi des configurations, des prompts système et utilisateur, des cas de test et des notes ELO finales.

- Intégration de Portkey: Offre une intégration facultative avec Portkey pour la journalisation et le suivi des chaînes de prompts et de leurs réponses.

Comment utiliser gpt-prompt-engineer ?

- Configuration: Ouvrez le notebook souhaité dans Google Colab ou un notebook Jupyter local. Choisissez entre la version standard, la version de classification ou la version Claude 3 en fonction de votre cas d'utilisation.

- Configuration de la clé API: Ajoutez votre clé API OpenAI ou votre clé API Anthropic à la ligne désignée dans le notebook.

- Définir le cas d'utilisation et les cas de test: Pour la version GPT-4, définissez votre cas d'utilisation et vos cas de test. Le cas d'utilisation est une description de ce que vous voulez que l'IA fasse, et les cas de test sont des prompts spécifiques auxquels vous aimeriez que l'IA réponde.

- Configurer les variables d'entrée (pour la version Claude 3): Définissez les variables d'entrée en plus de la description du cas d'utilisation, en spécifiant le nom de la variable et sa description.

- Générer des prompts optimaux: Appelez la fonction

generate_optimal_promptavec la description du cas d'utilisation, les cas de test et le nombre de prompts souhaité à générer. - Évaluer les résultats: Les notes ELO finales seront affichées dans un tableau, triées par ordre décroissant. Plus la note est élevée, meilleur est le prompt. Pour la version de classification, les scores de chaque prompt seront affichés dans un tableau.

À qui s'adresse gpt-prompt-engineer ?

gpt-prompt-engineer est idéal pour :

- Les développeurs et chercheurs en IA cherchant à optimiser les prompts pour les LLM.

- Les entreprises cherchant à améliorer les performances des applications alimentées par l'IA.

- Les personnes intéressées par l'exploration des techniques d'ingénierie des prompts.

- Toute personne cherchant à réduire les coûts et la latence des applications basées sur les LLM.

Cas d'utilisation :

- Automatiser la génération de titres de pages de destination (landing page).

- Créer des réponses d'e-mails personnalisées.

- Optimiser les prompts pour la génération de contenu.

- Construire des systèmes d'IA rentables à l'aide de Claude 3 Opus et Haiku.

Pourquoi choisir gpt-prompt-engineer ?

- Gain de temps: Automatise le processus d'ingénierie des prompts, ce qui permet de gagner beaucoup de temps et d'efforts.

- Amélioration des performances: Aide à découvrir des prompts optimaux qui conduisent à une amélioration des performances des LLM.

- Réduction des coûts: Permet la création de systèmes d'IA rentables en tirant parti de modèles efficaces comme Claude 3 Haiku.

- Flexibilité: Prend en charge divers LLM et cas d'utilisation, y compris les tâches de classification.

Licence

gpt-prompt-engineer est sous licence MIT.

Lien du projet

Meilleurs outils alternatifs à "gpt-prompt-engineer"

Freshly.ai est un accélérateur de découverte de l'IA offrant des outils et des perspectives d'IA pour l'ingénierie prompt, le développement de jeux et d'applications alimenté par l'IA et la génération d'art par l'IA. Explorez des techniques prompt avancées et les secrets de l'IA.

Promptimize AI est une extension de navigateur qui améliore les prompts d'IA, permettant à quiconque d'utiliser l'IA de manière fiable pour augmenter sa productivité. Elle offre des améliorations en un clic, des variables personnalisées et une intégration sur toutes les plateformes d'IA.

Xander est une plateforme de bureau open source qui permet l'entraînement de modèles IA sans code. Décrivez les tâches en langage naturel pour des pipelines automatisés en classification de texte, analyse d'images et fine-tuning LLM, assurant la confidentialité et les performances sur votre machine locale.

PromptLayer est une plateforme d'ingénierie IA pour la gestion des invites, l'évaluation et l'observabilité LLM. Collaborez avec des experts, surveillez les agents IA et améliorez la qualité des invites grâce à des outils puissants.

Prompt Engine est un outil basé sur l'IA qui transforme des idées simples en invites de qualité professionnelle pour obtenir des résultats de qualité constante à partir de LLM tels que ChatGPT et Gemini, ce qui permet de gagner du temps et de maximiser la valeur de l'IA.

PromptPerfect est un générateur et optimiseur d'invites alimenté par l'IA, conçu pour améliorer les performances de modèles tels que GPT-4, ChatGPT et Midjourney. Il aide les utilisateurs à créer, analyser et affiner les invites pour obtenir de meilleurs résultats en quelques secondes.

Langtail est une plateforme à faible code pour tester et déboguer les applications d'IA en toute confiance. Testez les prompts LLM avec des données du monde réel, corrigez les bugs et assurez la sécurité de l'IA. Essayez-le gratuitement !

ModelFusion : Boîte à outils LLM complète pour 2025 avec des calculateurs de coûts, une bibliothèque de prompts et des outils d'observabilité de l'IA pour GPT-4, Claude, etc.

Livrez un logiciel propulsé par l'IA impactant en quelques minutes, sans compromettre la qualité. Expédiez, surveillez, testez et itérez sans perdre de vue l'essentiel.

Parea AI est une plateforme d'expérimentation et d'annotation d'IA qui aide les équipes à déployer en toute confiance des applications LLM. Elle offre des fonctionnalités pour le suivi des expériences, l'observabilité, la révision humaine et le déploiement rapide.

Promethia orchestre des agents d'IA spécialisés en équipes collaboratives, reproduisant les flux de travail humains pour relever des défis complexes. Améliorez la stratégie d'entreprise, automatisez la réponse aux incidents et accélérez la recherche avec l'IA.

PromptBuilder est une plateforme d'ingénierie d'invites d'IA conçue pour aider les utilisateurs à générer, optimiser et organiser des invites de haute qualité pour divers modèles d'IA tels que ChatGPT, Claude et Gemini, garantissant ainsi des résultats d'IA cohérents et efficaces.

Parea AI est la plateforme ultime d'expérimentation et d'annotation humaine pour les équipes d'IA, permettant une évaluation fluide des LLM, des tests de prompts et un déploiement en production pour construire des applications d'IA fiables.

Athina est une plateforme collaborative d'IA qui aide les équipes à construire, tester et surveiller les fonctionnalités basées sur LLM 10 fois plus rapidement. Avec des outils pour la gestion de prompts, les évaluations et l'observabilité, elle assure la confidentialité des données et prend en charge les modèles personnalisés.