Llama Family

Vue d'ensemble de Llama Family

Famille Llama : L’écosystème des modèles d’IA open source

Qu’est-ce que la famille Llama ? La famille Llama est une communauté open source dédiée à la promotion du développement de l’intelligence artificielle générale (IAG) par le biais d’efforts de collaboration axés sur les modèles Llama et les technologies connexes. Elle vise à créer une plateforme où les développeurs et les passionnés peuvent contribuer à un écosystème open source couvrant divers aspects de l’IA, des modèles à grande échelle aux modèles plus petits, du texte aux capacités multimodales et des logiciels aux optimisations d’algorithmes matériels.

Composants clés de la famille Llama

Modèles: La communauté se concentre sur divers modèles Llama open source par Meta, notamment Llama, Llama 2, Llama 3, Code Llama et Atom. Ces modèles couvrent une gamme de tailles de paramètres et d’ensembles de données d’apprentissage, répondant à différents cas d’utilisation et orientations de recherche.

Calcul: La communauté encourage la collaboration et le partage des ressources pour la formation et l’expérimentation des modèles. Cela comprend l’utilisation de ressources GPU telles que la série GeForce RTX, NVIDIA H100 et A100 Tensor Core GPU.

Communauté: La famille Llama repose sur sa communauté dynamique de développeurs, de chercheurs et de passionnés. La communauté favorise la collaboration, le partage des connaissances et la cocréation de ressources et d’outils.

Modèles Llama

Meta Llama

Le modèle Llama open source par Meta est largement utilisé dans l’industrie et le milieu universitaire. Les versions incluent 1B, 3B, 8B, 70B et 405B, avec des données d’apprentissage dépassant 15,0 T de jetons. Les modèles de vision incluent 11B et 90B, formés sur plus de 6 milliards de paires image-texte.

| Model | Training Data | Params | Tokens | Release Date |

|---|---|---|---|---|

| LLaMA | English CommonCrawl, C4, Github, Wikipedia, Gutenberg and Books3, ArXiv, Stack Exchange | 7B (6.7B) | 1.0T | 2023/02/24 |

| 13B (13.0B) | 1.0T | |||

| 33B (32.5B) | 1.4T | |||

| 65B (65.2B) | 1.4T | |||

| Llama 2 | A new mix of publicly available online data | 7B | 2.0T | 2023/07/18 |

| 13B | 2.0T | |||

| 34B | 2.0T | |||

| 70B | 2.0T | |||

| Llama 3 | A new mix of publicly available online data | 8B | 15.0T | 2024/04/18 |

| 70B | 15.0T | |||

| Llama 3.1 | Collected from publicly available sources, over 5% of the Llama 3 pretraining dataset consists of high-quality non-English data that covers over 30 languages | 8B | 15.0T | 2024/07/23 |

| 70B | 15.0T | |||

| 405B | 15.0T | |||

| Llama 3.2 | Llama 3.2-Text: A new mix of publicly available online data | 1B (1.23B) | 9.0T | 2024/09/25 |

| 3B (3.21B) | 9.0T | |||

| Llama 3.2-Vision | Pretrained on image and text pairs. The instruction tuning data includes publicly available vision instruction datasets, as well as over 3M synthetically generated examples | 11B (10.6B) | 6B (image, text) pairs | |

| 90B (88.8B) | 6B (image, text) pairs |

Code Llama

Code Llama est formé sur Llama 2 à l’aide de données de code et est classé en modèle de base, modèle Python et modèle Instruct, avec des tailles de paramètres de 7B, 13B, 34B et 70B. Il prend en charge la continuation, le remplissage et la programmation basée sur les instructions de code.

| Model | Training Data | Params | Type |

|---|---|---|---|

| Code Llama | Based on Llama 2, trained using a public code dataset of 500B tokens. To help the model retain natural language understanding skills, 8% of the sample data comes from natural language datasets related to code. | 7B | Base Model: a foundational model for code generation tasks |

| Python: a version specialized for Python | |||

| Instruct: a fine-tuned version with human instructions and self-instruct code synthesis data | |||

| 13B | |||

| 34B | |||

| 70B |

Atom

Atom, développé conjointement par AtomEcho et la famille Llama, est basé sur l’architecture Llama et formé sur 2,7 T de corpus chinois et multilingues, avec des tailles de paramètres incluant 1B, 7B et 13B. Atom améliore les capacités de langue chinoise du modèle Llama.

| Model | Training Data | Params | Tokens | Release Date |

|---|---|---|---|---|

| Atom | Chinese and multilingual encyclopedias, books, blogs, news, novels, financial data, legal data, medical data, code, paper, Chinese NLP competition datasets, etc. | 1B | 2.7T | 2023/12/20 |

| 7B | 2.7T | 2023/08/28 | ||

| 13B | 2.7T | 2023/07/31 |

Comment contribuer à la famille Llama

- Rejoignez la communauté: Engagez-vous avec d’autres développeurs et passionnés par le biais de forums, de groupes de discussion et d’événements.

- Contribuez au code: Soumettez des requêtes d’extraction avec des correctifs de bogues, de nouvelles fonctionnalités ou des améliorations de modèle.

- Partagez des ressources: Partagez des ensembles de données, des scripts de formation et des modèles préformés avec la communauté.

- Fournissez des commentaires: Offrez des commentaires sur les modèles et outils existants pour aider à améliorer leur qualité et leur convivialité.

Pourquoi la famille Llama est-elle importante ?

La famille Llama est importante, car elle favorise la collaboration et accélère le développement de modèles d’IA open source. En fournissant une plateforme aux développeurs et aux chercheurs pour partager des ressources et des connaissances, la famille Llama contribue à démocratiser l’accès à la technologie de l’IA et à promouvoir l’innovation.

Conclusion

La famille Llama est une communauté en pleine croissance dédiée à l’avancement de l’IA grâce à la collaboration open source. Rejoignez la famille Llama dès aujourd’hui pour contribuer à l’avenir de l’IA!

Meilleurs outils alternatifs à "Llama Family"

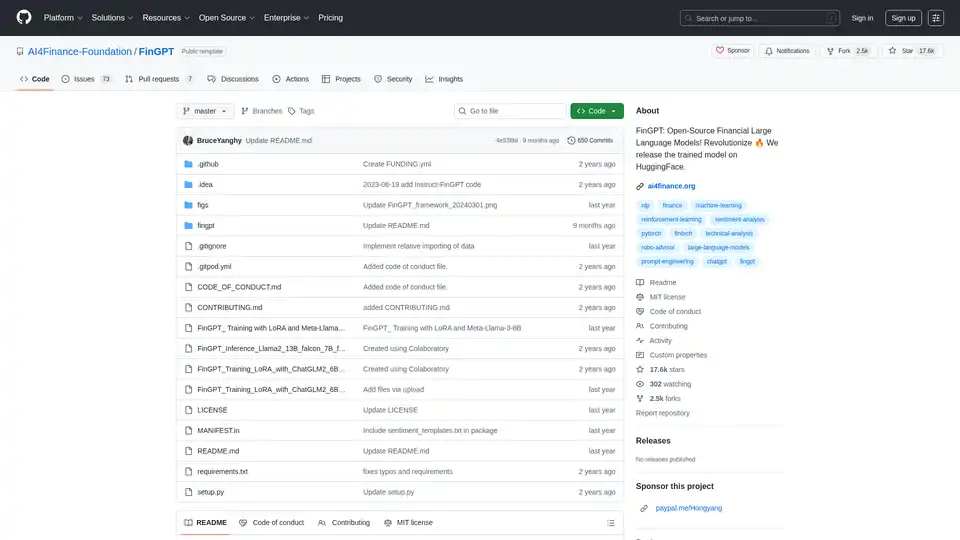

FinGPT : Un grand modèle linguistique financier open source pour démocratiser les données financières, l’analyse des sentiments et les prévisions. Affinez rapidement pour obtenir des informations à jour sur le marché.

Replicate vous permet d'exécuter et d'affiner des modèles d'apprentissage automatique open source avec une API cloud. Créez et faites évoluer facilement des produits d'IA.

Falcon LLM est une famille de modèles de langage grands génératifs open-source de TII, incluant des modèles comme Falcon 3, Falcon-H1 et Falcon Arabic pour des applications d'IA multilingues et multimodales qui s'exécutent efficacement sur des appareils quotidiens.

Jan est un client d'IA open source, axé sur le hors ligne. Exécutez des modèles de langage volumineux (LLM) localement avec confidentialité et sans frais d'API. Connectez-vous à divers modèles et services.

Activez l'inférence LLM efficace avec llama.cpp, une bibliothèque C/C++ optimisée pour divers matériels, prenant en charge la quantification, CUDA et les modèles GGUF. Idéal pour un déploiement local et cloud.

ChatLLaMA est un assistant IA entraîné avec LoRA basé sur les modèles LLaMA, permettant des conversations personnalisées sur votre GPU local. Inclut une interface graphique de bureau, entraîné sur le dataset HH d'Anthropic, disponible pour les modèles 7B, 13B et 30B.

LM Studio est une application de bureau conviviale pour exécuter et télécharger localement des grands modèles de langage (LLM) open source comme LLaMa et Gemma. Elle offre une interface de chat intégrée et un serveur compatible OpenAI pour une interaction IA hors ligne, rendant l'IA accessible sans compétences en programmation.

OpenUI est un outil open source qui vous permet de décrire des composants UI en langage naturel et de les rendre en direct avec des LLMs. Convertissez des descriptions en HTML, React ou Svelte pour un prototypage rapide.

Unsloth AI offre un fine-tuning open source et un apprentissage par renforcement pour les LLM comme gpt-oss et Llama, avec une formation 30 fois plus rapide et une utilisation réduite de la mémoire, ce qui rend la formation à l'IA accessible et efficace.

xTuring est une bibliothèque open source qui permet aux utilisateurs de personnaliser et d'ajuster finement les Modèles de Langage Large (LLMs) de manière efficace, en se concentrant sur la simplicité, l'optimisation des ressources et la flexibilité pour la personnalisation de l'IA.

Explorez le repo Awesome ChatGPT Prompts, une collection curée de prompts pour optimiser ChatGPT et d'autres LLMs comme Claude et Gemini pour des tâches de l'écriture à la codification. Améliorez les interactions AI avec des exemples éprouvés.

Sesame AI vise à atteindre une « présence vocale » dans l’IA, afin que les interactions orales soient réelles et comprises. Découvrez leur modèle de parole conversationnelle (CSM) pour un dialogue naturel.

TextGen est un plugin d'IA open source pour Obsidian, améliorant la prise de notes avec des modèles basés sur l'IA et la génération de contenu intelligent.

PearAI est un éditeur de code IA open source avec chat IA, codage automatisé avec PearAI Agent et débogage intelligent pour aider les développeurs à construire des projets efficacement.