LMQL

Vue d'ensemble de LMQL

Qu'est-ce que LMQL ?

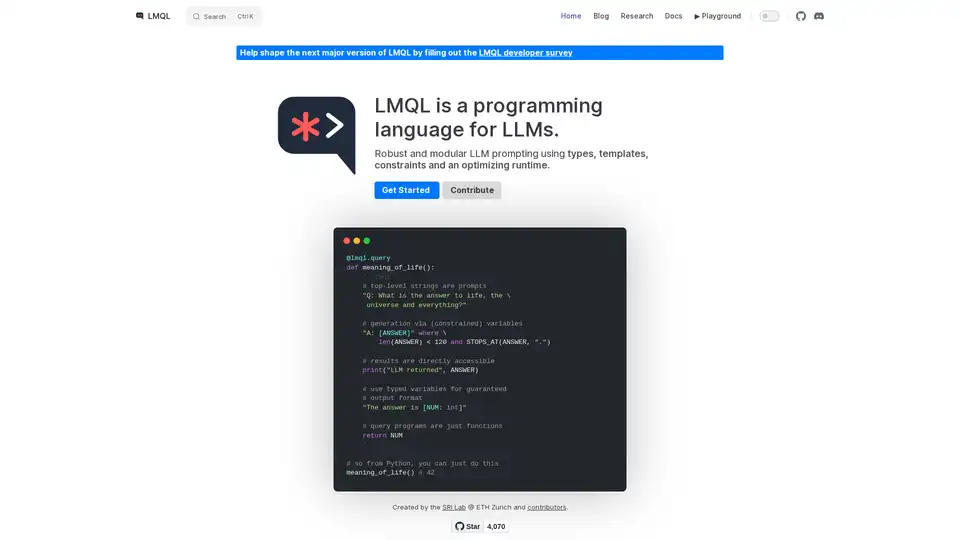

LMQL (Language Model Query Language) est un langage de programmation spécialement conçu pour interagir avec les grands modèles de langage (LLM). Il offre une approche robuste et modulaire de l'incitation des LLM, en tirant parti des types, des modèles, des contraintes et d'un runtime d'optimisation pour garantir des résultats fiables et contrôlables. LMQL vise à combler le fossé entre les paradigmes de programmation traditionnels et la nature probabiliste des LLM, permettant aux développeurs de créer des applications d'IA plus sophistiquées et prévisibles.

Comment fonctionne LMQL ?

LMQL fonctionne en permettant aux développeurs de définir des invites sous forme de code, en incorporant des variables, des contraintes et un flux de contrôle. Cette approche contraste avec l'incitation traditionnelle basée sur des chaînes de caractères, qui peut être moins structurée et plus difficile à gérer. Voici une ventilation des principales fonctionnalités de LMQL :

- Variables typées: LMQL vous permet de définir des variables avec des types de données spécifiques (par exemple,

int,str), garantissant que la sortie du LLM est conforme au format attendu. Cette fonctionnalité est essentielle pour créer des applications qui nécessitent des données structurées. - Modèles: LMQL prend en charge les modèles, permettant la création de composants d'invite réutilisables. Les modèles peuvent être paramétrés avec des variables, ce qui facilite la génération d'invites dynamiques.

- Contraintes: LMQL vous permet de spécifier des contraintes sur la sortie du LLM, telles que la longueur maximale ou des mots clés spécifiques. Ces contraintes sont appliquées par le runtime LMQL, garantissant que la réponse du LLM répond à vos exigences.

- Requêtes imbriquées: LMQL prend en charge les requêtes imbriquées, vous permettant de modulariser vos invites et de réutiliser les composants d'invite. Cette fonctionnalité est particulièrement utile pour les tâches complexes qui nécessitent plusieurs étapes d'interaction avec le LLM.

- Plusieurs Backends : LMQL peut rendre automatiquement votre code LLM portable sur plusieurs backends. Vous pouvez basculer entre eux avec une seule ligne de code.

Exemple

@lmql.query

def meaning_of_life():

'''lmql

# top-level strings are prompts

"Q: What is the answer to life, the \

universe and everything?"

# generation via (constrained) variables

"A: [ANSWER]" where \

len(ANSWER) < 120 and STOPS_AT(ANSWER, ".")

# results are directly accessible

print("LLM returned", ANSWER)

# use typed variables for guaranteed

# output format

"The answer is [NUM: int]"

# query programs are just functions

return NUM

'''

## so from Python, you can just do this

meaning_of_life() # 42

Comment utiliser LMQL ?

Installation:

Installez LMQL à l'aide de pip :

pip install lmqlDéfinir des requêtes:

Écrivez des requêtes LMQL à l'aide du décorateur

@lmql.query. Ces requêtes peuvent inclure des invites, des variables et des contraintes.Exécuter des requêtes:

Exécutez des requêtes LMQL comme des fonctions Python régulières. Le runtime LMQL gérera l'interaction avec le LLM et appliquera les contraintes spécifiées.

Accéder aux résultats:

Accédez à la sortie du LLM via les variables définies dans votre requête LMQL.

Pourquoi choisir LMQL ?

- Robustesse: Les types et les contraintes de LMQL permettent de garantir que la sortie du LLM est fiable et cohérente.

- Modularité: Les modèles et les requêtes imbriquées de LMQL favorisent la réutilisation du code et la modularité.

- Portabilité: LMQL fonctionne sur plusieurs backends LLM, ce qui vous permet de basculer facilement entre différents modèles.

- Expressivité: L'intégration de LMQL avec Python vous permet de tirer parti de toute la puissance de Python pour la construction d'invites et le post-traitement.

À qui s'adresse LMQL ?

LMQL convient aux développeurs qui souhaitent créer des applications d'IA nécessitant un contrôle précis du comportement du LLM. Il est particulièrement utile pour les tâches telles que :

- Extraction de données: Extraction de données structurées à partir de texte.

- Génération de code: Génération de code basée sur des descriptions en langage naturel.

- Chatbots: Création de chatbots avec des réponses prévisibles et cohérentes.

- Réponse aux questions: Répondre aux questions sur la base de connaissances structurées.

En utilisant LMQL, les développeurs peuvent créer des applications d'IA plus fiables, modulaires et portables qui tirent parti de la puissance des LLM.

La meilleure façon d'utiliser LMQL est de consulter la documentation et de commencer par un exemple simple, puis d'augmenter progressivement la complexité des invites en fonction de vos besoins.

Tags Liés à LMQL