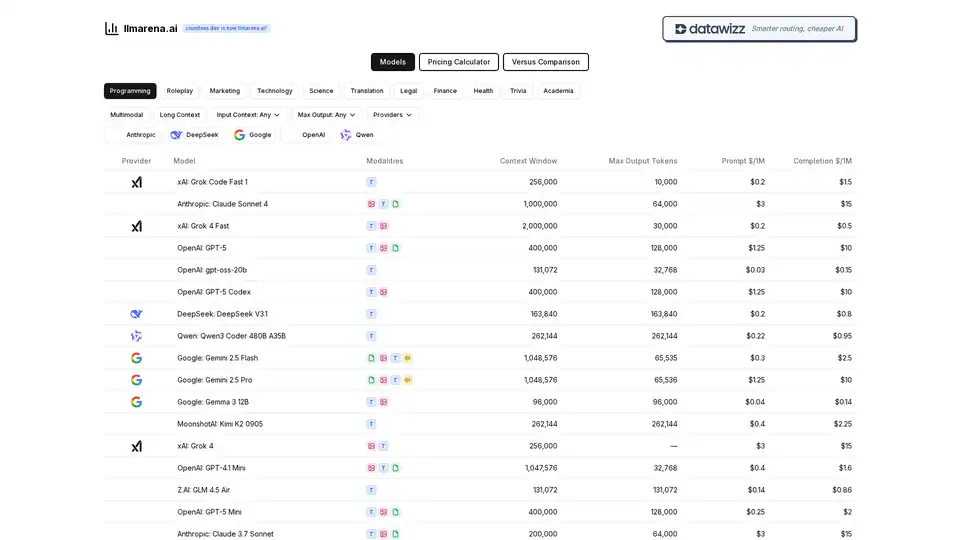

llmarena.ai

Vue d'ensemble de llmarena.ai

Qu'est-ce que llmarena.ai ?

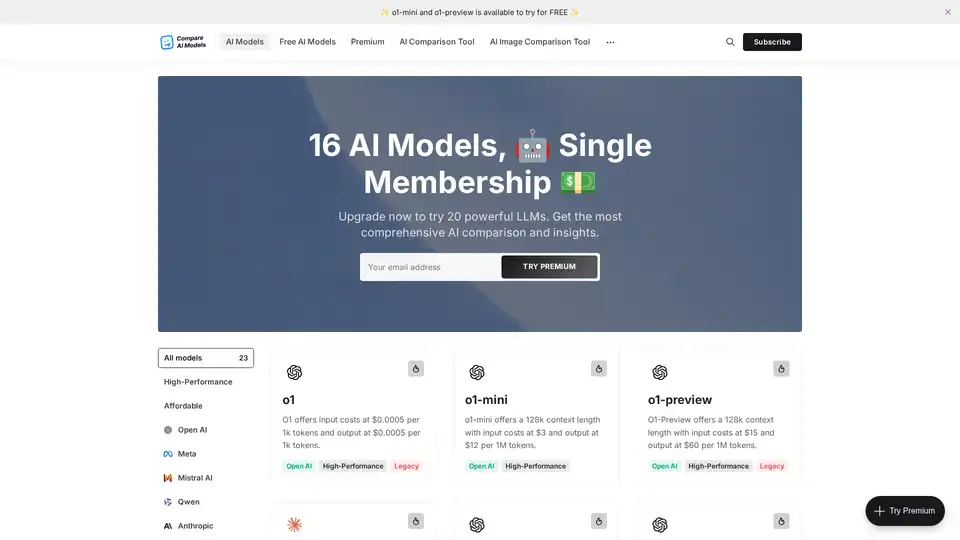

llmarena.ai est une plateforme en ligne puissante conçue pour simplifier le processus de comparaison de modèles de langage large (LLM) provenant de divers fournisseurs d'IA. Anciennement connue sous le nom de countless.dev, elle a évolué vers un outil plus intelligent et plus efficace pour le routage et l'optimisation de l'utilisation de l'IA tout en contrôlant les coûts. Que vous soyez développeur, chercheur ou professionnel des affaires, llmarena.ai rassemble les modèles des principaux fournisseurs comme OpenAI, Anthropic, Google, xAI, DeepSeek, Qwen et d'autres dans un hub centralisé. Cela facilite plus que jamais l'évaluation des options basées sur des métriques clés telles que les prix, les fenêtres de contexte, les capacités de sortie et les modalités, aidant les utilisateurs à prendre des décisions éclairées sans fouiller dans une documentation dispersée.

Au cœur de llmarena.ai, elle aborde un point de douleur courant dans le paysage en rapide expansion de l'IA : la complexité du choix du bon LLM. Avec les modèles d'IA progressant rapidement, les fournisseurs mettent fréquemment à jour les fonctionnalités et les prix, rendant les comparaisons une tâche chronophage. Cet outil rationalise cela en offrant des insights en temps réel sur les performances des modèles, assurant que vous sélectionnez l'option la plus rentable et adaptée à vos besoins spécifiques, qu'il s'agisse de tâches de programmation, de génération de contenu ou d'analyse de données.

Comment fonctionne llmarena.ai ?

La plateforme opère comme un comparateur web intuitif, extrayant les données directement des fournisseurs pour afficher des informations à jour. Les utilisateurs peuvent accéder à plusieurs sections clés, y compris une Calculatrice de Prix, un outil de Comparaison Versus, et des explorations de modèles catégorisés comme Programmation, Roleplay, Marketing, Technologie, Science, Traduction, Légale, Finance, Santé, Trivia, Académique, Multimodal et modèles de Contexte Long.

Voici un aperçu de ses fonctionnalités principales :

- Listes de Modèles et Spécifications : Le tableau principal catégorise les modèles par fournisseur et met en évidence les spécifications essentielles. Par exemple, il montre les modalités (principalement Texte, ou 'T'), les fenêtres de contexte (p. ex., jusqu'à 2 000 000 tokens pour Grok 4 Fast de xAI), les tokens de sortie maximaux, et les prix par million de tokens pour les prompts et les complétions. Cela permet un scan rapide des capacités—comme Claude Sonnet 4 d'Anthropic offrant une massive fenêtre de contexte de 1 000 000 tokens à $3/$15 par million de tokens.

- Calculatrice de Prix : Un outil interactif où les utilisateurs saisissent leurs scénarios d'utilisation (p. ex., volumes de tokens d'entrée/sortie) pour estimer les coûts à travers les modèles. Cela est invaluable pour le budget, surtout lors de la comparaison d'options abordables comme Gemma 3 12B de Google ($0.04/$0.14) contre des premium comme Claude Opus 4.1 d'Anthropic ($15/$75).

- Comparaison Versus : Évaluations côte à côte de deux ou plus modèles, se concentrant sur des fonctionnalités comme la flexibilité de contexte d'entrée (Any) et les limites de sortie maximales. C'est parfait pour des confrontations directes, comme opposer GPT-5 d'OpenAI (400 000 contexte, $1.25/$10) à Gemini 2.5 Pro de Google (1 048 576 contexte, $1.25/$10).

- Cas d'Utilisation Catégorisés : Les modèles sont étiquetés pour des domaines spécifiques, aidant les utilisateurs à filtrer pour des applications pertinentes. Par exemple, sous Programmation, vous pourriez explorer Grok Code Fast 1 de xAI ou GPT-5 Codex d'OpenAI, tous deux optimisés pour la génération de code avec des prix compétitifs.

La plateforme met l'accent sur le 'routage plus intelligent'—suggérant des modèles optimaux basés sur votre tâche—tout en priorisant la 'IA moins chère' grâce à des analyses de coûts transparentes. Toutes les données sont présentées dans un format tabulaire clair pour une lecture facile, sans besoin de calculs manuels.

Fonctionnalités Clés et Points Saillants des Modèles

llmarena.ai se distingue par sa couverture complète des LLM leaders. Voici un aperçu de certains modèles en vedette :

| Provider | Model | Context Window | Max Output Tokens | Prompt $/1M | Completion $/1M |

|---|---|---|---|---|---|

| xAI | Grok Code Fast 1 | 256,000 | 10,000 | $0.2 | $1.5 |

| Anthropic | Claude Sonnet 4 | 1,000,000 | 64,000 | $3 | $15 |

| OpenAI | GPT-5 | 400,000 | 128,000 | $1.25 | $10 |

| Gemini 2.5 Flash | 1,048,576 | 65,535 | $0.3 | $2.5 | |

| DeepSeek | DeepSeek V3.1 | 163,840 | 163,840 | $0.2 | $0.8 |

| Qwen | Qwen3 Coder 480B A35B | 262,144 | 262,144 | $0.22 | $0.95 |

Ces exemples illustrent la diversité : modèles budget comme gpt-oss-20b d'OpenAI ($0.03/$0.15) pour des tâches légères, ou haute capacité comme Grok 4 Fast de xAI pour des contextes étendus. Des fonctionnalités comme le support multimodal (bien que principalement axé sur le texte ici) et la gestion de contexte long répondent à des cas d'utilisation avancés, comme le traitement de grands documents dans des contextes légaux ou académiques.

L'outil supporte également des entrées (Any) et sorties flexibles, le rendant adaptable pour tout, des requêtes trivia rapides à des analyses scientifiques approfondies.

Scénarios d'Utilisation et Valeur Pratique

llmarena.ai excelle dans les scénarios où la sélection de modèles impacte l'efficacité et les dépenses :

- Développeurs et Codeurs : Utilisez la catégorie Programmation pour comparer des modèles axés sur le code comme Qwen3 Coder Plus ou GPT-5 Codex d'OpenAI. Calculez rapidement les coûts pour des sessions de codage itératives, économisant sur les appels API.

- Créateurs de Contenu et Marketeurs : Pour des tâches Marketing ou Roleplay, évaluez des modèles comme Claude 3.7 Sonnet pour l'écriture créative, assurant des sorties de haute qualité sans dépenser excessivement.

- Chercheurs et Académiciens : Dans les sections Science ou Académique, sélectionnez des modèles de contexte long pour analyser des articles ou datasets, avec des outils comme Gemini 2.5 Pro gérant des entrées de million de tokens.

- Applications Commerciales : Les catégories Finance, Légale et Santé aident les professionnels à choisir des modèles conformes et rentables—p. ex., GLM 4.5 Air pour une traduction abordable dans des opérations multilingues.

- Expérimentation Générale avec l'IA : Les filtres Trivia ou Multimodal permettent aux utilisateurs occasionnels de tester des capacités diverses, des prompts amusants aux intégrations multimodales complexes.

La valeur pratique réside dans son agrégation économisant du temps : au lieu de visiter plusieurs sites de fournisseurs (OpenAI, Anthropic, Google, etc.), tout est au même endroit. Les utilisateurs peuvent éviter le verrouillage fournisseur en repérant des alternatives—p. ex., passer de Claude Opus coûteux à DeepSeek V3.1 moins cher pour des performances similaires. Pour les équipes, la calculatrice de prix aide à prévoir les budgets API, potentiellement réduisant les coûts de 50 % ou plus grâce à des choix optimisés.

Pour qui est llmarena.ai ?

Cet outil est idéal pour :

- Enthousiastes et Hobbyistes de l'IA : Ceux expérimentant avec des LLM sur un budget.

- Ingénieurs Logiciels : Ayant besoin d'assistants de codage fiables sans frais élevés.

- Scientifiques des Données : Comparant des modèles pour des pipelines de machine learning.

- Utilisateurs Entreprise : Dans les domaines finance ou légal nécessitant une IA précise et scalable.

- Éducateurs et Étudiants : Explorant des modèles axés sur l'académie pour la recherche.

Il n'est pas adapté pour ceux cherchant des plateformes complètes d'entraînement de modèles mais parfait pour les phases de déploiement et de sélection.

Pourquoi choisir llmarena.ai ?

Dans un marché de l'IA encombré, llmarena.ai se distingue par son focus sur la transparence et l'utilisabilité. Aucune inscription n'est requise pour les comparaisons de base, et l'interface est responsive pour des vérifications rapides sur mobile. Des mises à jour régulières assurent que les spécifications reflètent les dernières sorties, comme les modèles émergents de MoonshotAI ou Z.AI. En favorisant un routage plus intelligent, il ne réduit pas seulement les coûts mais améliore la productivité—les utilisateurs rapportent des démarrages de projets plus rapides et une meilleure allocation de ressources.

Pour les meilleurs résultats, commencez par la Calculatrice de Prix pour votre charge de travail, puis utilisez Versus pour affiner. Que vous optimisiez pour la vitesse, le coût ou la longueur de contexte, llmarena.ai transforme la complexité des LLM en clarté, rendant l'IA avancée accessible à tous.

Meilleurs outils alternatifs à "llmarena.ai"

Joythee AI est une application compagnon d'IA conçue pour des conversations engageantes et édifiantes. Il offre des fonctionnalités telles que le chat avec plusieurs agents d'IA, le mode incognito, des expériences personnalisées et des mises à jour continues.

ChatOrDie.ai offre une discussion anonyme avec les meilleurs modèles d'IA tels que Grok, ChatGPT, Gemini et Deepseek. Comparez les réponses, repérez les biais et profitez d'interactions d'IA privées et non filtrées.

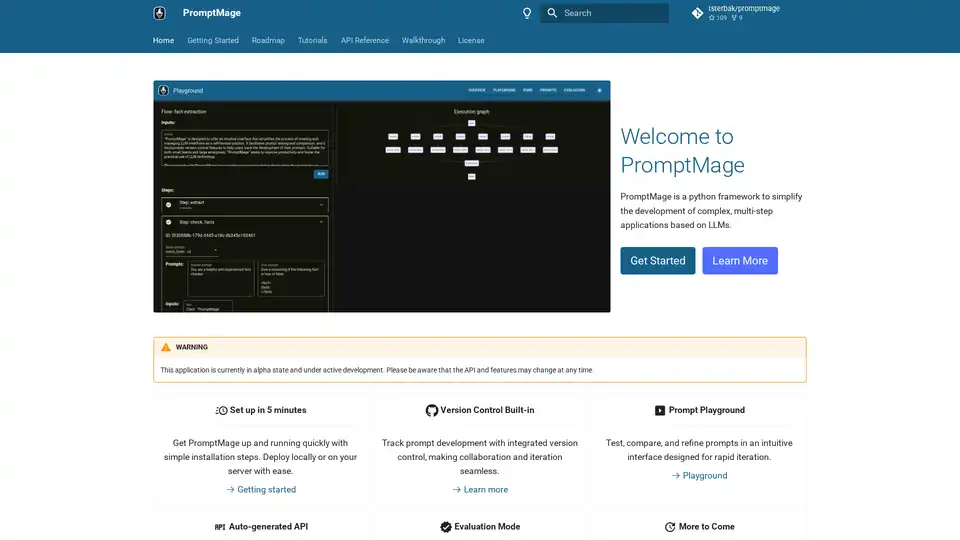

PromptMage est un framework Python simplifiant le développement d'applications LLM. Il offre des tests de prompts, un contrôle de version et une API auto-générée pour une intégration et un déploiement faciles.

Aicado.ai fournit un outil de comparaison de modèles d'IA côte à côte, incluant GPT-4o, Claude, Llama et bien plus encore. Testez les invites en temps réel et analysez les performances de l'IA.

Stable Code Alpha est le premier produit d’IA générative LLM de Stability AI pour le codage, conçu pour aider les programmeurs et fournir un outil d’apprentissage aux nouveaux développeurs.

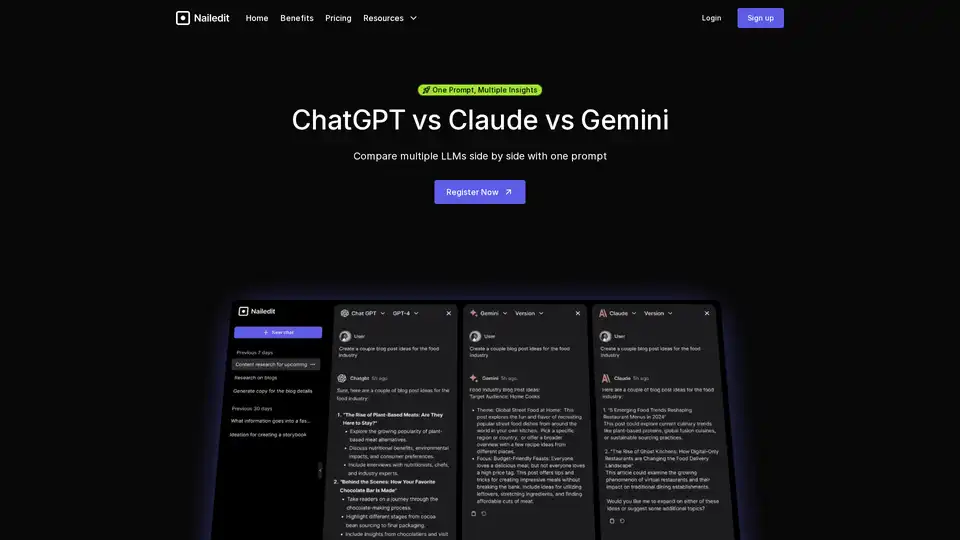

NailedIt vous permet de comparer instantanément les réponses de ChatGPT, Claude et Gemini. Rationalisez votre flux de travail et trouvez les meilleures idées de plusieurs modèles d'IA avec une seule invite.

Athina est une plateforme collaborative d'IA qui aide les équipes à construire, tester et surveiller les fonctionnalités basées sur LLM 10 fois plus rapidement. Avec des outils pour la gestion de prompts, les évaluations et l'observabilité, elle assure la confidentialité des données et prend en charge les modèles personnalisés.

Améliorez APM avec OpenLIT, une plateforme open source sur OpenTelemetry. Simplifiez le développement de l'IA avec des traces et des métriques unifiées dans une interface puissante, optimisant ainsi l'observabilité de LLM et GenAI.

Product Prompt simplifie l'ingénierie des invites LLM avec une plateforme sans code. Expérimentez, testez et optimisez les invites GPT à l'aide des données de vos produits pour améliorer les fonctionnalités d'IA. Inscrivez-vous gratuitement !

Comparez les prix des modèles d'IA pour ChatGPT, Claude, Gemini et plus encore avec AI Models Pricing. Calculez les coûts et trouvez la solution d'IA la plus rentable pour vos besoins.

SuperTechFans propose des outils tels que MultiAI-Chat, une extension Chrome pour comparer les résultats de chat LLM et PacGen pour la gestion des proxies.

16x Prompt est un outil de codage IA permettant de gérer le contexte du code, de personnaliser les invites et de livrer des fonctionnalités plus rapidement grâce aux intégrations d'API LLM. Idéal pour les développeurs à la recherche d'un codage efficace assisté par l'IA.

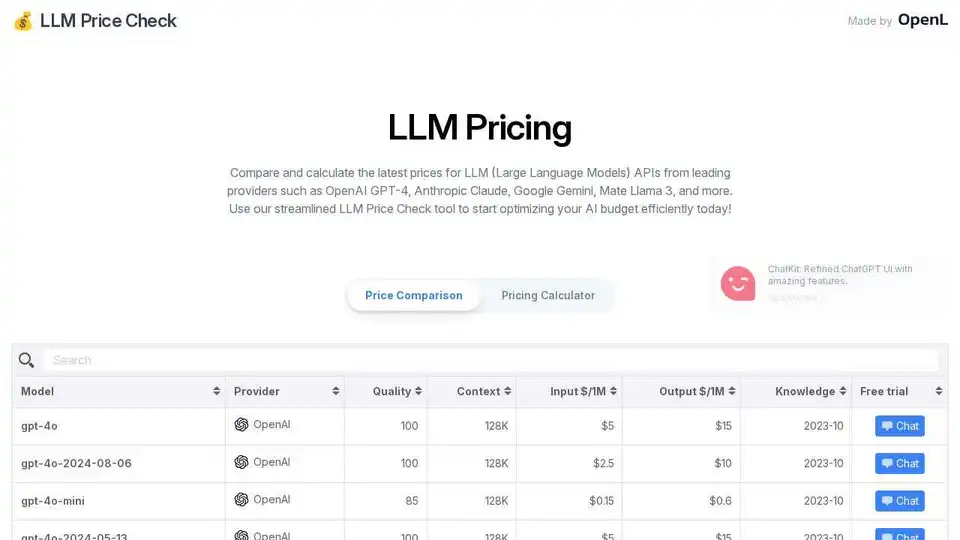

Comparez les prix des API LLM d'OpenAI, Anthropic, Google et plus encore. Optimisez votre budget IA avec le calculateur de prix simplifié de LLM Price Check.

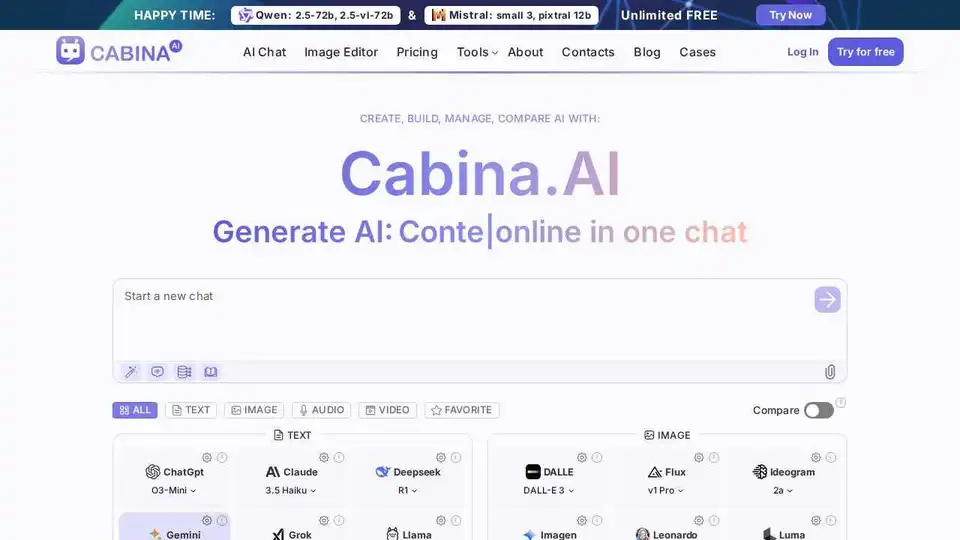

Cabina.AI offre un accès à GPT-4, Claude, LLama et plus encore, le tout au même endroit. Discutez avec PDF, analysez des fichiers, transcrivez de l'audio, générez des vidéos et des images. Commencez gratuitement !