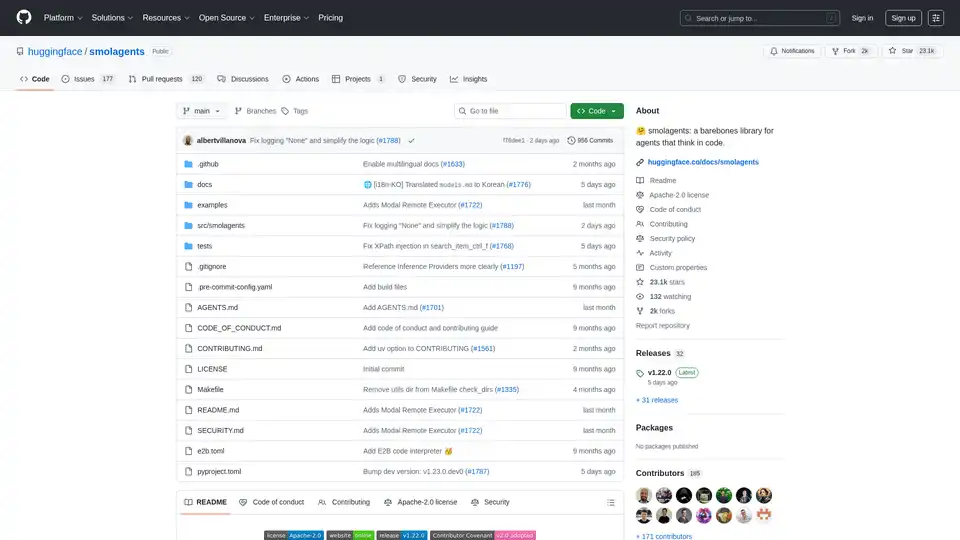

smolagents

Vue d'ensemble de smolagents

Qu'est-ce que Smolagents ?

Smolagents est une bibliothèque légère et open-source en Python conçue pour simplifier la création d'agents IA qui raisonnent et exécutent des actions principalement via du code. Développée par l'équipe Hugging Face, elle se distingue par son approche minimaliste, intégrant des capacités agentiques puissantes en seulement environ 1 000 lignes de code principal. Contrairement aux frameworks surchargés, smolagents élimine les abstractions inutiles, en se concentrant sur une efficacité brute tout en supportant des fonctionnalités avancées comme l'exécution sécurisée de code et l'intégration fluide avec des modèles de langage large (LLMs).

Au cœur de smolagents, les développeurs peuvent construire des agents qui "pensent en code", ce qui signifie que l'IA génère des extraits Python pour accomplir des tâches plutôt que de s'appuyer sur des appels d'outils JSON rigides. Ce paradigme centré sur le code s'est avéré réduire les étapes jusqu'à 30 % dans des workflows complexes, le rendant idéal pour des tâches nécessitant un raisonnement multi-étapes, comme les recherches web, l'analyse de données ou la planification d'itinéraires. Que vous soyez un chercheur expérimentant avec des modèles ouverts ou un ingénieur déployant des agents de production, smolagents offre une base flexible pour les systèmes IA agentiques.

Comment fonctionne Smolagents ?

Smolagents opère sur une boucle inspirée de ReAct (Reasoning and Acting), mais avec une twist : le LLM génère des extraits de code Python comme actions au lieu de sorties structurées. Voici un breakdown de son mécanisme principal :

Initialisation de l'Agent : Vous commencez par définir un agent, comme le flagship

CodeAgent, et l'équiper d'outils (par ex., recherche web, E/S fichiers) et d'un backend de modèle.Phase de Raisonnement : Le LLM (n'importe quel modèle supporté) reçoit le prompt de tâche, les observations passées et les outils disponibles. Il raisonne étape par étape et produit un bloc de code Python décrivant l'action prévue.

Phase d'Exécution : L'extrait de code est exécuté dans un environnement contrôlé. Pour la sécurité, smolagents supporte des sandboxes comme E2B, Modal, Docker, ou même Pyodide basé sur navigateur avec Deno WebAssembly. Cela empêche le code arbitraire de nuire à votre système.

Observation et Itération : Les résultats de l'exécution alimentent le boucle, permettant à l'agent d'affiner son approche jusqu'à ce que la tâche soit terminée.

Par exemple, pour répondre à une requête comme "Combien de secondes faudrait-il à un léopard à pleine vitesse pour traverser le Pont des Arts ?", l'agent pourrait générer du code pour rechercher la vitesse du léopard, la longueur du pont et effectuer le calcul, tout en un seul extrait efficace. Cela contraste avec les agents traditionnels qui pourraient nécessiter plusieurs appels d'outils, menant à plus d'invocations LLM et des coûts plus élevés.

Smolagents inclut aussi ToolCallingAgent pour des actions classiques basées sur JSON, offrant de la flexibilité aux utilisateurs. Les hiérarchies multi-agents sont supportées, où un agent délègue à d'autres, améliorant la scalabilité pour des applications complexes.

Fonctionnalités Principales de Smolagents

Smolagents frappe fort malgré sa petite empreinte. Les fonctionnalités clés incluent :

Simplicité et Minimalisme : La logique principale dans

agents.pyfait moins de 1 000 lignes, la rendant facile à comprendre, modifier et étendre. Pas de courbe d'apprentissage abrupte, juste du Python pur.Conception Agnostic de Modèles : Fonctionne avec n'importe quel LLM via des intégrations comme InferenceClient de Hugging Face, LiteLLM (plus de 100 fournisseurs), OpenAI, Anthropic, Transformers locaux, Ollama, Azure ou Amazon Bedrock. Changez de modèles sans effort sans réécrire de code.

Support de Modalités : Gère les entrées texte, vision, vidéo et audio. Par exemple, les agents habilités pour la vision peuvent traiter des images aux côtés de prompts texte, comme montré dans des tutoriels dédiés.

Flexibilité des Outils : Intégrez des outils de n'importe où : bibliothèques LangChain, serveurs MCP ou même Hugging Face Spaces. Le toolkit par défaut inclut l'essentiel comme la recherche web et l'exécution de code.

Intégration Hub : Partagez et chargez des agents directement depuis le Hugging Face Hub. Poussez votre agent personnalisé comme un dépôt Space pour collaboration :

agent.push_to_hub("username/my_agent").Exécution Sécurisée : Priorise la sécurité avec des options de sandbox. E2B et Modal fournissent une isolation basée sur le cloud, tandis que Docker convient aux setups locaux. Un interpréteur Python sécurisé intégré ajoute une couche supplémentaire pour des environnements moins risqués.

Outils CLI : Exécutez des agents via ligne de commande avec

smolagentpour des tâches générales (par ex., planification de voyages avec recherche web et imports de données) ouwebagentpour l'automatisation de navigateur utilisant Helium.

Ces fonctionnalités rendent smolagents polyvalent pour le prototypage et la production, en mettant l'accent sur les performances sans complexité.

Comment Utiliser Smolagents : Guide Étape par Étape

Commencer est simple. Installez via pip : pip install "smolagents[toolkit]" pour inclure les outils par défaut.

Exemple Basique de Code Agent

from smolagents import CodeAgent, WebSearchTool, InferenceClientModel

model = InferenceClientModel(model_id="microsoft/DialoGPT-medium") # Ou n'importe quel LLM

agent = CodeAgent(tools=[WebSearchTool()], model=model, stream_outputs=True)

result = agent.run("Plan a trip to Tokyo, Kyoto, and Osaka between Mar 28 and Apr 7.")

print(result)

Ce setup exploite la génération de code pour des actions multi-outils, comme des recherches en batch ou des calculs.

Utilisation CLI

Pour des exécutions rapides sans scripting :

smolagent "Query here" --model-type InferenceClientModel --model-id Qwen/Qwen2.5-Coder-32B-Instruct --tools web_search --imports pandas numpy- Spécifique au web :

webagent "Navigate to site and extract details" --model-type LiteLLMModel --model-id gpt-4o

Avancé : Exécution en Sandbox

Pour activer le sandbox E2B :

agent = CodeAgent(..., executor="e2b") # Ou "modal", "docker"

Cela assure que le code s'exécute en isolation, crucial pour les sorties LLM non fiables.

Partage et Chargement d'Agents

Exportez vers le Hub pour réutilisation :

agent.push_to_hub("my_agent_space")

loaded_agent = CodeAgent.from_hub("my_agent_space")

Idéal pour les projets d'équipe ou les benchmarks publics.

Les benchmarks montrent que les modèles ouverts comme Qwen2.5-Coder rivalisent avec les fermés (par ex., GPT-4) dans les tâches agentiques, les agents de code surpassant les LLMs vanilla en gérant des défis divers comme les maths, la recherche et la planification.

Cas d'Utilisation Principaux et Valeur Pratique

Smolagents excelle dans les scénarios demandant une automatisation efficace pilotée par code :

Recherche et Développement : Prototyper des workflows agentiques avec des LLMs ouverts. Les chercheurs peuvent benchmarker des modèles sur des tâches personnalisées, en tirant parti de la transparence de la bibliothèque.

Analyse de Données et Planification : Les agents gèrent le scraping web, les calculs et la construction d'itinéraires, par ex., planification de voyages avec recherches en temps réel et pandas pour le crunching de données.

Automatisation Web : Utilisez

webagentpour l'e-commerce, l'extraction de contenu ou les tests, en simulant des interactions utilisateur de manière sécurisée.Tâches Multi-Modales : Combinez des modèles de vision pour l'analyse d'images avec l'exécution de code, comme traiter des frames vidéo ou générer des rapports à partir de visuels.

Déploiement en Production : Intégrez dans des apps via Hub Spaces ou CLI pour des agents scalables et faible latence.

La valeur pratique réside dans son efficacité : moins d'appels LLM signifie des coûts inférieurs et des réponses plus rapides. Par exemple, les extraits de code permettent des actions parallèles (par ex., plusieurs recherches en une fois), boostant le throughput de 30 %. Il est sous licence Apache-2.0, favorisant les contributions communautaires : plus de 185 contributeurs ont ajouté des fonctionnalités comme des docs multilingues et des exécuteurs remotes.

La sécurité est intégrée, adressant les risques d'exécution de code avec des sandboxes et les meilleures pratiques, le rendant adapté à l'usage entreprise.

Pour Qui est Smolagents ?

Développeurs et Ingénieurs IA : Ceux fatigués des frameworks sur-ingénierés apprécieront le cœur hackable. Personnalisez des agents pour des outils spécifiques ou des hiérarchies.

Chercheurs : Testez les modèles ouverts vs. fermés dans des benchmarks agentiques ; citez-le dans des papiers avec le BibTeX fourni.

Startups et Équipes : Setup rapide pour prototypes, partage Hub pour collaboration.

Amateurs : Les outils CLI abaissent la barrière pour expérimenter avec des agents IA.

Si vous construisez des systèmes agentiques et valorisez la simplicité sur le bloat, smolagents est votre choix principal. Pourquoi le choisir ? Il démocratise les agents avancés, prouvant que les modèles ouverts peuvent égaler la puissance propriétaire tout en gardant les choses légères et sécurisées.

Pour plus, consultez la doc complète sur huggingface.co/docs/smolagents ou plongez dans le repo GitHub. Contribuez via le guide pour façonner son avenir !

Meilleurs outils alternatifs à "smolagents"

GitHub Next explore l'avenir du développement logiciel en protégeant des outils et des technologies qui modifieront notre métier. Ils identifient de nouvelles approches pour constituer des équipes d'ingénierie logicielle saines et productives.

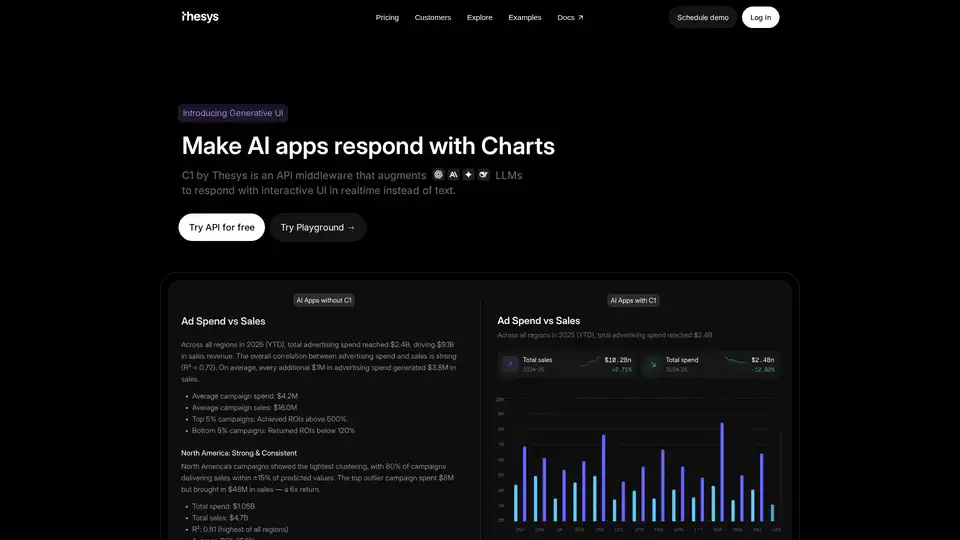

C1 par Thesys est un middleware API qui augmente les LLM pour répondre avec une interface utilisateur interactive en temps réel au lieu de texte, transformant les réponses de votre modèle en interfaces en direct à l'aide de React SDK.

PyGPT est un assistant IA de bureau open source et gratuit pour Windows, macOS et Linux. Il offre des fonctionnalités de chat, de vision, d'agents, de génération d'images, de contrôle vocal, etc., alimentées par des modèles tels que GPT-5, GPT-4, Google Gemini et autres.

Zep est une plateforme d'ingénierie de contexte pour la construction d'agents IA personnalisés. Elle comprend la mémoire de l'agent, le graphe RAG et l'assemblage automatisé du contexte, ce qui permet aux agents de se souvenir des détails importants et d'accéder aux données pertinentes.

Hunch est un espace de travail axé sur l’IA qui permet aux équipes d’utiliser les meilleurs modèles d’IA, de gérer des projets complexes et d’accroître leur productivité. Les fonctionnalités incluent des modèles, le traitement par lots, le web scraping et l’exécution de code.

Botpress est une plateforme complète d'agents IA alimentée par les derniers LLM. Il vous permet de créer, de déployer et de gérer des agents d'IA pour le support client, l'automatisation interne, etc., avec des capacités d'intégration transparentes.

Moveworks est un assistant d'IA agentique conçu pour accélérer les flux de travail dans les systèmes d'entreprise, automatiser les tâches, augmenter la productivité et permettre la création d'agents d'IA pour une assistance complète.

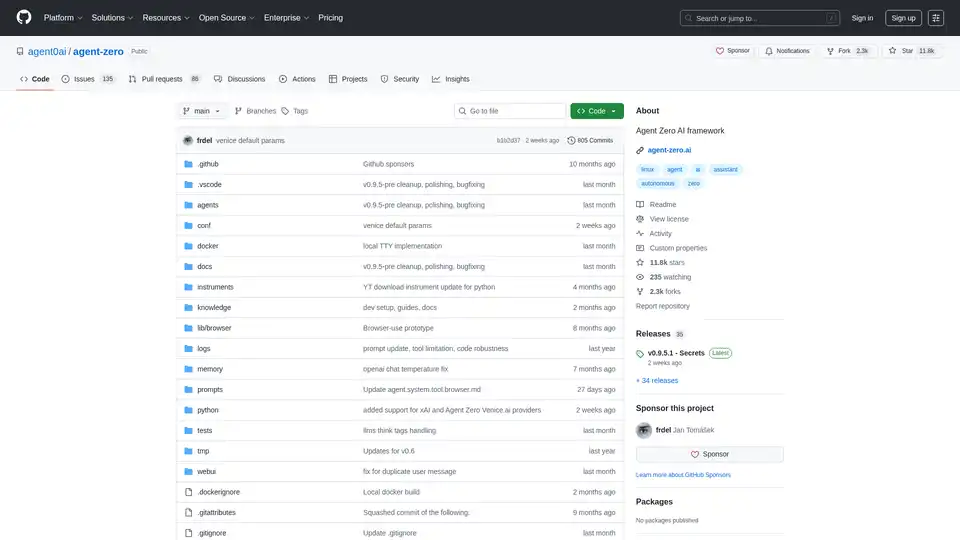

Agent Zero est un framework IA open source pour construire des agents autonomes qui apprennent et grandissent organiquement. Il propose une coopération multi-agents, l'exécution de code et des outils personnalisables.

Flowise est une plateforme de développement d'IA générative open source permettant de créer visuellement des agents d'IA et une orchestration LLM. Créez des applications LLM personnalisées en quelques minutes grâce à une interface utilisateur de type glisser-déposer.

Transformez votre flux de travail avec BrainSoup ! Créez des agents IA personnalisés pour gérer les tâches et automatiser les processus via un langage naturel. Améliorez l'IA avec vos données tout en priorisant la confidentialité et la sécurité.

Soverin est le marché ultime d'IA pour découvrir, acheter et exploiter les meilleures apps et agents d'IA. Automatisez plus de 10 000 tâches, de la construction d'agents à l'extension du support client, et boostez la productivité avec des outils d'automatisation tendance.

Créez des agents personnalisés orientés tâches pour votre base de code qui exécutent des tâches d'ingénierie avec une grande précision, alimentées par l'intelligence et le contexte de vos données. Créez des agents pour des cas d'utilisation comme la conception de systèmes, le débogage, les tests d'intégration, l'intégration, etc.

Roo Code est un assistant de codage open-source propulsé par IA pour VS Code, avec des agents IA pour l'édition multi-fichiers, le débogage et l'architecture. Il prend en charge divers modèles, assure la confidentialité et se personnalise pour un développement efficace.

Warp est une plateforme d’agents d’IA qui vous permet d’exécuter plusieurs agents en parallèle pour effectuer n’importe quelle tâche de développement. L’agent de codage numéro 1.