Stable Diffusion

Vue d'ensemble de Stable Diffusion

Qu'est-ce que Stable Diffusion AI ?

Stable Diffusion est un système d'IA open-source révolutionnaire qui transforme les descriptions textuelles en images époustouflantes et réalistes. Développé par le groupe CompVis de l'Université Ludwig Maximilian de Munich, en collaboration avec Runway ML et Stability AI, il exploite des modèles de diffusion pour permettre la génération d'images à partir de texte, l'édition d'images et plus encore. Contrairement aux outils propriétaires, le code, les modèles pré-entraînés et la licence de Stable Diffusion sont entièrement open-source, permettant aux utilisateurs de l'exécuter sur une seule GPU directement sur leurs appareils. Cette accessibilité a démocratisé la créativité alimentée par l'IA, rendant la génération d'images de haute qualité accessible aux artistes, designers et amateurs sans nécessiter de ressources de niveau entreprise.

Au cœur de Stable Diffusion, il excelle dans la production de visuels détaillés à partir de prompts simples, supportant des résolutions jusqu'à 1024x1024 pixels. Il est particulièrement réputé pour sa polyvalence dans la génération de paysages, portraits, art abstrait et même designs conceptuels. Pour ceux qui s'aventurent dans l'art IA, Stable Diffusion se distingue comme un point d'entrée fiable, offrant une liberté créative tout en étant conscient de l'utilisation éthique pour éviter les biais de ses données d'entraînement.

Comment fonctionne Stable Diffusion ?

Stable Diffusion repose sur une architecture de Modèle de Diffusion Latente (LDM), qui compresse et traite efficacement les images dans un espace latent plutôt que dans l'espace complet des pixels, réduisant les exigences computationnelles. Le système comprend trois composants clés :

- Variational Autoencoder (VAE) : Cela compresse les images d'entrée en une représentation latente compacte, préservant les détails sémantiques essentiels tout en éliminant le bruit.

- U-Net : Le noyau de débruitage, construit sur une structure ResNet, supprime itérativement le bruit gaussien ajouté pendant le processus de diffusion avant. Il utilise des mécanismes d'attention croisée pour incorporer les prompts textuels, guidant la génération vers les sorties décrites par l'utilisateur.

- Text Encoder (Optionnel) : Convertit les descriptions textuelles en embeddings qui influencent les étapes de débruitage.

Le processus commence par l'ajout de bruit à une image latente (ou en partant de bruit pur pour la génération). La U-Net inverse ensuite ce processus de diffusion étape par étape, affinant la sortie jusqu'à ce qu'une image cohérente émerge. Une fois débruitée, le décodeur VAE reconstruit l'image finale basée sur les pixels. Ce flux de travail élégant assure des résultats de haute fidélité, même pour des prompts complexes impliquant des styles, compositions ou sujets.

Entraîné sur le massif ensemble de données LAION-5B —comprenant des milliards de paires image-texte de sources web— permet à Stable Diffusion d'apprendre des concepts visuels divers. Les données sont filtrées pour la qualité, la résolution et l'esthétique, avec des techniques comme Classifier-Free Guidance améliorant l'adhésion aux prompts. Cependant, ces données issues du web introduisent des biais culturels, principalement vers l'anglais et le contenu occidental, que les utilisateurs devraient considérer lors de la génération de représentations diverses.

Fonctionnalités Principales et Capacités de Stable Diffusion

Stable Diffusion ne se limite pas à la création d'images basique ; il offre une suite de fonctionnalités avancées :

- Génération d'Images à partir de Texte : Saisissez un prompt descriptif comme « un paysage serein de montagne au coucher du soleil » et générez une œuvre originale en quelques secondes.

- Outils d'Édition d'Images : Utilisez l'inpainting pour remplir ou modifier des parties d'une image (par exemple, changer les arrière-plans) et l'outpainting pour étendre au-delà des bordures originales.

- Traduction Image-à-Image : Redessinez des photos existantes avec une nouvelle guidance textuelle, préservant la structure tout en modifiant les styles ou éléments.

- Intégration ControlNet : Maintenez les structures géométriques, poses ou bords d'images de référence tout en appliquant des changements stylistiques.

- Support Haute Résolution : La variante XL (Stable Diffusion XL 1.0) booste les capacités avec un modèle dual de 6 milliards de paramètres, permettant des sorties 1024x1024, un meilleur rendu de texte dans les images et une simplification des prompts pour des résultats plus rapides et réalistes.

Des améliorations comme les LoRAs (Adaptations de Rang Faible) permettent un affinage pour des détails spécifiques —tels que les visages, vêtements ou styles anime— sans réentraîner tout le modèle. Les embeddings capturent des styles visuels pour des sorties cohérentes, tandis que les prompts négatifs excluent les éléments indésirables comme les distorsions ou membres supplémentaires, affinant la qualité.

Comment Utiliser Stable Diffusion AI

Commencer avec Stable Diffusion est simple, en ligne ou hors ligne.

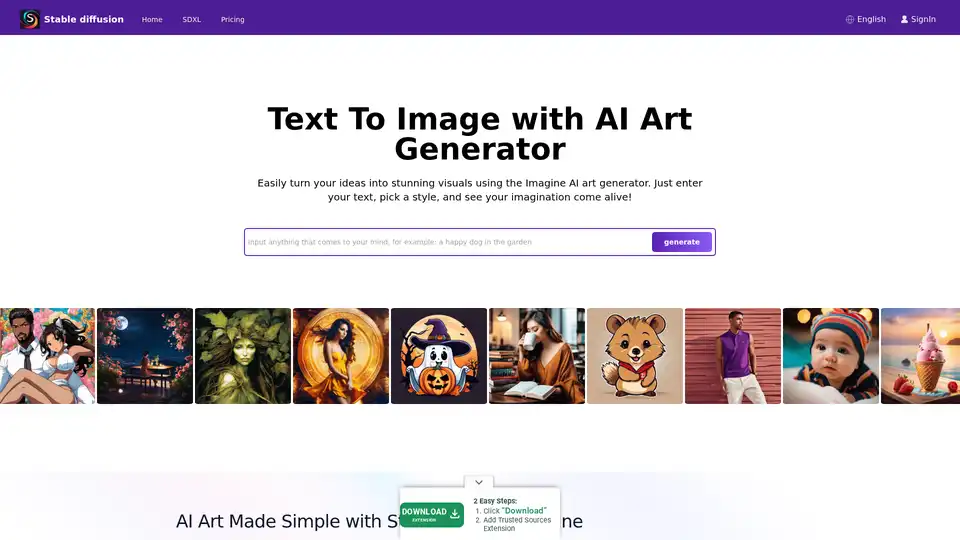

Accès en Ligne via des Plateformes

Pour les débutants, des plateformes comme Stablediffusionai.ai offrent une interface web conviviale :

- Visitez stablediffusionai.ai et connectez-vous.

- Entrez votre prompt textuel dans le champ d'entrée.

- Sélectionnez des styles, résolutions (par exemple, SDXL pour haute résolution) et ajustez des paramètres comme les étapes d'échantillonnage.

- Cliquez sur « Generate » ou « Dream » pour créer des images.

- Affinez avec des prompts négatifs (par exemple, « flou, basse qualité ») et téléchargez les favoris.

Cette option sans installation est idéale pour des expérimentations rapides, bien qu'elle nécessite une connexion internet.

Installation Locale et Téléchargement

Pour un contrôle total et une utilisation hors ligne :

- Téléchargez depuis GitHub (github.com/CompVis/stable-diffusion) en cliquant sur « Code » > « Download ZIP » (nécessite ~10GB d'espace).

- Installez les prérequis : Python 3.10+, Git et une GPU avec 4GB+ VRAM (NVIDIA recommandé).

- Extrayez le ZIP, placez les checkpoints de modèle (par exemple, depuis Hugging Face) dans le dossier models.

- Exécutez webui-user.bat (Windows) ou script équivalent pour lancer l'UI locale.

- Entrez des prompts, ajustez des paramètres comme les étapes d'inférence (20-50 pour l'équilibre) et générez.

Des extensions comme l'UI web d'Automatic1111 ajoutent des fonctionnalités telles que le traitement par lots. Une fois configuré, il fonctionne entièrement hors ligne, priorisant la confidentialité.

Entraîner Votre Propre Modèle Stable Diffusion

Les utilisateurs avancés peuvent personnaliser Stable Diffusion :

- Rassemblez un ensemble de données de paires image-texte (par exemple, pour des styles de niche).

- Préparez les données en nettoyant et en légendant.

- Modifiez les configs pour votre ensemble de données et hyperparamètres (taille de lot, taux d'apprentissage).

- Entraînez les composants séparément (VAE, U-Net, encodeur de texte) à l'aide de scripts —louez des GPUs cloud pour les tâches lourdes.

- Évaluez et affinez itérativement.

Ce processus exige des compétences techniques mais débloque des modèles adaptés pour des domaines spécifiques comme la mode ou l'architecture.

Stable Diffusion XL : La Version Améliorée

Lancé en juillet 2023 par Stability AI, SDXL s'appuie sur l'original avec un nombre de paramètres plus élevé pour un détail supérieur. Il simplifie les prompts (moins de mots nécessaires), inclut des styles intégrés et excelle dans le texte lisible au sein des images. Pour les professionnels, SDXL Online via des plateformes dédiées délivre des sorties ultra-haute résolution pour des visuels marketing, actifs de jeux ou impressions. C'est un pas en avant pour ceux cherchant du photoréalisme ou des designs complexes sans compromettre la vitesse.

Utiliser LoRAs, Embeddings et Prompts Négatifs

- LoRAs : Téléchargez des fichiers spécialisés (par exemple, pour portraits) et activez-les via des prompts comme « lora:portrait_style:1.0 ». Ils améliorent les détails efficacement.

- Embeddings : Entraînez sur des ensembles de données de styles, puis invoquez avec « 😒tyle_name: » dans les prompts pour une cohérence thématique.

- Prompts Négatifs : Spécifiez des évitements comme « déformé, laid » pour minimiser les défauts, améliorant la précision globale de la sortie.

Applications Pratiques et Cas d'Utilisation

Stable Diffusion brille dans divers scénarios :

- Artistes et Designers : Prototyper des concepts, générer des références ou expérimenter des styles pour l'art numérique, illustrations ou mockups UI/UX.

- Marketing et Médias : Créer des visuels personnalisés pour publicités, réseaux sociaux ou contenu sans photos stock —idéal pour rendus de produits e-commerce.

- Éducation et Passionnés : Enseigner des concepts IA ou créer de l'art personnalisé comme hobby, comme des portraits familiaux dans des décors fantastiques.

- Développement de Jeux : Création d'actifs pour personnages, environnements ou textures, surtout avec ControlNet pour le contrôle de poses.

Sa capacité hors ligne convient aux créateurs distants, tandis que l'accès API (via Dream Studio ou Hugging Face) s'intègre dans les workflows.

À qui s'adresse Stable Diffusion ?

Cet outil cible les professionnels créatifs, des artistes numériques novices aux développeurs expérimentés. Les débutants apprécient les interfaces intuitives, tandis que les experts valorisent les options de personnalisation comme l'affinage. Il est parfait pour ceux priorisant l'éthique open-source et la confidentialité locale sur les dépendances cloud. Cependant, il est moins adapté aux tâches non créatives ou aux utilisateurs sans configuration technique de base.

Limites et Meilleures Pratiques

Malgré ses forces, Stable Diffusion présente des obstacles :

- Biais : Les sorties peuvent favoriser des esthétiques occidentales ; des prompts divers et un affinage aident à atténuer.

- Défis Anatomiques : Les mains et visages peuvent se déformer —utilisez des prompts négatifs ou LoRAs.

- Besoins en Ressources : Les exécutions locales requièrent un hardware décent ; des alternatives cloud comme Stablediffusionai.ai comblent les lacunes.

Toujours vérifier les questions éthiques, comme les droits d'auteur dans les données d'entraînement. Les communautés sur Civitai ou Reddit offrent des modèles et conseils pour surmonter les défauts.

Pourquoi Choisir Stable Diffusion ?

Dans un paysage IA encombré, la nature open-source de Stable Diffusion favorise l'innovation, avec des mises à jour constantes de la communauté. Comparé à des outils fermés comme DALL-E, il offre des générations illimitées sans quotas et une propriété totale des sorties. Pour des besoins haute résolution, SDXL délivre une qualité pro de manière abordable. Que ce soit pour stimuler des idées ou finaliser des projets, il permet aux utilisateurs de combiner l'ingéniosité humaine avec l'efficacité IA.

Tarification et Accès

Le cœur de Stable Diffusion est gratuit à télécharger et utiliser. Des plateformes comme Stablediffusionai.ai peuvent offrir des niveaux gratuits avec des mises à niveau payantes pour des générations plus rapides ou fonctionnalités avancées. Les crédits API Dream Studio commencent bas, s'échelonnant pour un usage intensif. Les configurations locales éliminent les coûts récurrents, le rendant viable économiquement pour une créativité soutenue.

En essence, Stable Diffusion redéfinit la génération d'art IA en mettant le pouvoir entre les mains des utilisateurs. Plongez dans son écosystème via GitHub ou des démos en ligne, et débloquez des possibilités infinies pour la narration visuelle.

Tags Liés à Stable Diffusion