MCPサーバーはどのような課題を解決するのか? AIエージェントに不可欠な理由

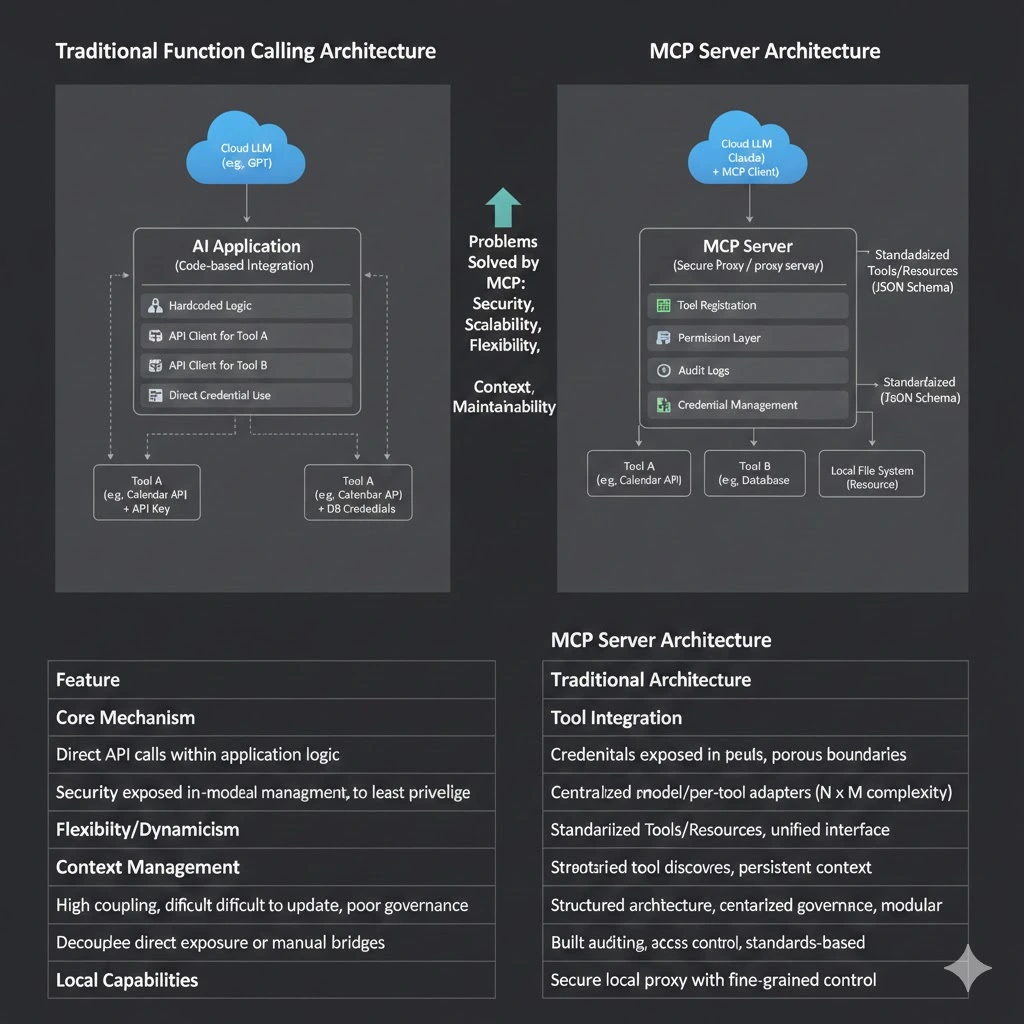

AIアプリケーションの初期段階では、単純な自動化ニーズに対しては「Function Calling(関数呼び出し)」を介したAPI呼び出しだけで十分でした。しかし、AIが単なる「対話ツール」から、自律的な計画・実行能力を備えた「エージェント(Agent)」へと進化するにつれ、一連のシステム工学的な課題に直面するようになりました。ツールの統合や安全な接続の難しさ、そしてモデルのアップデートに合わせて柔軟に進化させることが困難なアーキテクチャの問題です。

これらの問題の根本的な原因は、AIのインタラクションパターンに特化して設計された 標準化された機能レイヤー(Standardized Capability Layer) が不足していることにあります。このような背景から登場したのが、Model Context Protocol(MCP)とその中核となる実装であるMCPサーバーです。これは、モデルを外部データソース、ツール、サービスと接続するための標準化された手法を定義し、スケーラブルなAIエージェントシステムを支えます。

この記事では、MCPサーバーの登場がもたらす核心的な価値と、それが解決する主要な課題について解説します。

ターゲット層:

- テック愛好家および初学者

- 効率改善を求める専門家やマネージャー

- 企業の意思決定者および事業部門責任者

- AIの将来のトレンドに関心がある一般ユーザー

目次:

- 1. LLMに「行動能力」が必要な時:現実世界へ安全にアクセスするには?

- 2. タスクがオープンエンドになる時:ハードコードされたワークフローが失敗する理由

- 3. モデルが変わり続ける時:ツールとモデルの結合を避けるには?

- 4. タスクが長期化する時:コンテキストが断片化するのはなぜか?

- 5. 機能がローカルにある時:クラウドモデルに安全に接続するには?

- 6. エージェントの規模が拡大する時:システムをどう保守するか?

- 7. AIが企業に導入される時:内部システムを安全に再利用するには?

- MCPサーバーは単なるプロトコルではなく、AIエージェント時代の重要なインフラである

1. LLMに「行動能力」が必要な時:現実世界へ安全にアクセスするには?

背景

大規模言語モデル(LLM)は本質的にテキスト生成器ですが、外部システムに直接アクセスしたり、アクションを実行したりする能力を本来備えてはいません。LLMを現実世界に接続するには、API、データベース、またはファイルシステムへのアクセスを提供する必要があります。これは即座にセキュリティと適応のハードルをもたらします。統一された安全な実行レイヤーがなければ、各ツールを個別に適応させる作業は退屈で、かつ不安定なものになります。

MCPサーバーがない場合

開発者はすべてのツールに対して特定の統合コードを記述する必要があり、APIキーなどの機密性の高い資格情報や内部システムをAIアプリケーションに直接露出させなければなりません。その結果、セキュリティ境界が曖昧になり、高いリスクが生じます。まとめ:

- LLMは「テキストを生成」することしかできず、物理的なアクションをトリガーできません。

- すべての外部システムに対し、モデルの種類ごとに固有の適応コードを書く必要があります。

- APIキーや内部資格情報を呼び出し元に公開する必要があり、セキュリティリスクが生じます。

MCPサーバーによるソリューション

MCPサーバーの核心的な役割の一つは、セキュリティプロキシ(Security Proxy)として機能することです。これは信頼できる環境で実行され、すべての機密資格情報の保持と管理に責任を持ちます。公式のMCP定義によれば、サーバーは標準化されたTools(ツール)を公開します。これらは明確なJSON Schemaを通じてその機能と必要なパラメータを記述します。AIアプリケーション(MCPクライアント)はtools/listを介してツールの説明を取得し、モデルはそれらの説明に基づいていつツールを呼び出すかを決定します。権限の検証や監査ログを含む具体的な実行は、すべてMCPサーバーによって制御されます。この設計は、最小権限の原則(Principle of Least Privilege)の確実な実装を保証します。

MCPサーバーは、MCPプロトコルに従うサーバー側のプログラムです。外部機能を標準的にツールインターフェース(Tools)またはリソースインターフェース(Resources)としてカプセル化し、セキュリティメカニズムを通じてアクセスを制御できます。

- データベース、API、ファイルシステムなどの多様な現実世界の機能を標準的なツールにカプセル化します。

- モデルはツールの機能説明とパラメータ構造を理解するだけで済みます。

- 実際の権限確認、実行、およびセキュリティ境界はMCPサーバーが処理します。

これにより、LLMはコアシステムを直接さらすリスクなしに、「単なるチャット」からタスク実行型のAIエージェントへと進化し、現実世界と安全に対話できるようになります。MCPプロトコルは機能の公開と呼び出しの標準を定義しますが、セキュリティ制御と権限モデルは特定のMCPサーバー実装によって処理される点に注意が必要です。

2. タスクがオープンエンドになる時:ハードコードされたワークフローが失敗する理由

背景

AIエージェントの価値は、実行パスが動的で非決定的なことが多い、オープンドメインかつ多段階の複雑なタスクを処理できる点にあります。従来のAPI統合モデルは、開発者が固定された呼び出しロジックを事前に記述する方式に依存しており、このような柔軟性に適応できません。

従来のAPI / Function Callingの限界

タスクのワークフローが変更されたりツールが追加されたりするたびに、アプリケーションコードを修正して再デプロイする必要があります。これは、急速に変化するニーズに対応しにくい硬直したシステムを生みます。主な問題点:

- 呼び出しロジックがアプリケーションにハードコードされている。

- ツールの追加やプロセスの変更に、コードの修正と再デプロイが必要。

- オープンエンドで動的な意思決定タスクには不向き。

MCPサーバーによるソリューション

MCPプロトコルは、動的なツールの発見(Dynamic Tool Discovery)をサポートしています。AIアプリケーションに統合されたMCPクライアントは、起動時に接続されたサーバーが提供するツールを自動的に検出できます。つまり、ツールセットはAIアプリケーションとは独立して更新・拡張が可能です。エージェントは、リアルタイムで発見された機能に基づいて、どのツールをどの順序で呼び出すかを自律的に推論し、計画できます。これは、「人間が定義したワークフロー」から「モデル主導の動的計画」への根本的なシフトを意味します。

MCPプロトコルはツールとリソースの標準スキーマを定義し、それらが「動的に発見され、呼び出される」ことを可能にします。

- ツールは標準化されたスキーマを通じてその機能を公開します。

- 呼び出しの決定と実行順序は、ハードコードではなくモデルの推論によって決定されます。

- MCPは、自律的なエージェント計画に必要な機能露出とコンテキストの基盤を提供します。

本質的な変化

システムのインテリジェンスの核は、固定されたコードロジックから、ツールの機能理解に基づいたモデルによるリアルタイムの推論へと移ります。「人間が定義したプロセス」から「セマンティクスに基づくモデル計画プロセス」へと変化するのです。

3. モデルが変わり続ける時:ツールとモデルの結合を避けるには?

背景

AI分野のモデルは急速に進化を繰り返します。組織はOpenAI、Anthropic、Google、またはその他のオープンソース提供元のモデルを同時に使用する可能性があります。もしツールの統合コードが特定のモデルのSDKや呼び出し方法に深く依存している場合、モデルの切り替えや追加のたびに、膨大な重複開発とメンテナンスコストが発生します。

MCPサーバーがない場合

各モデルに対して独立したツール適応レイヤーが必要となり、N個のモデル × M個のツール(N x M)という統合の複雑さが生じます。メンテナンスコストは指数関数的に増加します。

- 各モデルが独自のツール定義セットを持つ。

- 開発者は異なるモデルごとに互換性ロジックを個別に書かなければならない。

- システムのメンテナンスコストが大幅に増大する。

MCPサーバーによるソリューション

オープンプロトコルであるMCPは、ユニバーサルな中間言語(Universal Intermediate Language) として機能します。MCPクライアントを実装したAIアプリケーション(Claude Desktop、Cursor IDEなど)は、MCPプロトコルに従うあらゆるサーバーと通信できます。ツール開発者は、標準に従ってMCPサーバーを一度実装するだけで、異なるバックエンドを持つ複数のAIアプリケーションでその機能を利用可能にできます。これによりツールが特定のAIモデルから完全に分離され、単一のMCPサーバーを複数の異なるLLMから同時に利用できるようになります。

MCPサーバーの登場は、開発者を特定のモデルのための「アダプター作成」という反復作業から解放し、持続可能で再利用可能な、モデルに依存しないAI機能インフラの構築を可能にします。

4. タスクが長期化する時:コンテキストが断片化するのはなぜか?

背景

複雑なマルチターンのエージェントタスクでは、情報は異なるツールの実行結果、読み取られたファイルの内容、会話履歴などに散らばっています。従来の手法では、これらの非構造化情報を効果的に整理してモデルに継続的に提供することが大きな課題であり、その結果、モデルが重要な情報を「忘れる」ことや、矛盾した決定を下すことが頻繁に起こります。

一般的な問題点

- ツール呼び出しの結果を再利用するのが難しい。

- 多段階のタスク間で状態(State)が一貫しない。

- モデルに全体的なコンテキスト把握能力が不足している。

MCPサーバーによるソリューション

MCPプロトコルは、**Resources(リソース)**をコアプリミティブとして定義しています。リソースは、ファイル、APIドキュメント、データベーススキーマなどの読み取り専用の構造化データソースです。MCPサーバーはリソースを公開でき、MCPクライアントは必要に応じてそれらを読み取り(resources/read)、その内容をモデルにコンテキストとして提供できます。これによりエージェントに継続的かつ構造化された外部知識が提供され、コンテキスト断片化の問題が効果的に緩和されます。

MCPサーバーにより、エージェントは情報を「一時的に記憶」するのではなく、多段階のタスク全体を通じて継続的かつ構造化されたコンテキストを維持できるようになります。

5. 機能がローカルにある時:クラウドモデルに安全に接続するには?

多くのコアな企業機能(ローカルファイルシステムへのアクセス、Gitリポジトリ、内部開発ツールチェーンなど)は、ユーザーのローカルマシンや企業イントラネット内に存在します。ユーザーはこれらの機能を動かすために強力なクラウドベースのLLMを使いたいと考えますが、ローカルの権限をクラウドモデルに直接与えることは非常に危険です。

MCPサーバーがない場合

- ファイルシステムやバージョン管理システムに安全にアクセスできない。

- 呼び出しを有効にするために過度に高い権限を付与しなければならない。

- 資格情報の漏洩や悪用のリスクが高い。

MCPサーバーによるソリューション

MCPサーバーはローカル環境で軽量なプロセスとして実行され、承認された機能のみを公開できます。したがって、モデルは境界を越えることなく必要なリソースに安全にアクセスできます。例えばClaude Desktopでは、ユーザーはローカルファイルシステムやGitのMCPサーバーを設定できます。これらのサーバーは、特定のディレクトリのファイルを読み取ることやgitログを取得することなど、厳密に定義された無害な操作のみをクラウドベースのClaudeに公開します。すべてのリクエストは安全なローカルチャネルを通過し、クラウドモデルからの指示はローカルサーバーによって検証・実行されます。機能露出の範囲が精密に制御されるのです。 これこそが、IDEのインテリジェントなコーディングアシスタントのシナリオにおいて、MCPアーキテクチャが強力な機能とセキュリティのバランスを維持できる核心的な理由です。

この設計は、IDEやローカル開発シナリオでMCPが急速に採用された主な理由となっています。

6. エージェントの規模が拡大する時:システムをどう保守するか?

大規模システムでは、エージェントが数十のツールにアクセスする必要があるかもしれません。複雑な権限ポリシーと散在した呼び出しロジックは、メンテナンスを困難にします。

従来のアーキテクチャの課題

- ツールが統一されたガバナンスなしに各所に散らばっている。

- エージェントのロジックが複雑になりすぎて維持できない。

- 権限管理や監査が断片化されている。

MCPサーバーによるソリューション

MCPは、ツールとデータアクセスに対する中央集権的な管理レイヤーを提供します。

- ツールの集中登録と管理。

- エージェントは利用可能な機能のみを気にすればよい。

- MCPサーバーがエージェントにとっての「機能抽象化レイヤー」となる。

この階層化されたガバナンスは、エンタープライズレベルのシステムアーキテクチャをアップグレードするのに理想的です。

7. AIが企業に導入される時:内部システムを安全に再利用するには?

企業はAIを活用して業務効率を高めたいと考えていますが、内部システム(CRM、ERP、データベースなど)は通常、非標準のインターフェース、複雑な権限モデル、厳格なコンプライアンスおよび監査要件を持っています。これらのシステムを直接モデルにさらすのは安全ではありません。

MCPサーバーによるソリューション

エンタープライズアーキテクチャにおいて、MCPサーバーはAI専用の「Capability Gateway(機能ゲートウェイ)」 として機能できます。あらゆる主要な内部システム(Salesforce、Jira、内部データベースなど)は、専用のMCPサーバーによってカプセル化されます。このサーバーは以下の役割を担います。

- 適応と抽象化:複雑な内部APIを標準化されたMCPツールに変換し、内部APIの複雑さを隠蔽します。

- 権限の集約:企業のアイデンティティ認証(SSOなど)と統合し、ツールレベルでアクセス制御を実装します。

- 監査ログ:コンプライアンス要件を満たすために、AIが開始したすべての操作の詳細なログを中央で記録します。

このように、MCPサーバーは企業アーキテクチャにおけるAI機能レイヤーの「ファイアウォール兼アダプター」と見なすことができます。異なるエージェントやモデルに対して一貫した安全なアクセス方法を提供し、安全で制御可能な条件下でAIがビジネスを強化することを可能にします。

MCPサーバーは単なるプロトコルではなく、AIエージェント時代の重要なインフラである

要約すると、MCPサーバーは単一の技術的な問題を解決するものではありません。むしろ、AIエージェントが大規模なエンジニアリングアプリケーションへと向かう際に直面する一連の構造的課題を解決するものです。

- セキュリティの課題:プロキシモデルを通じて最小権限アクセスを実装する。

- 統合の課題:標準化されたプロトコルを通じてツールとモデルをデカップリングし、

N x Mの統合の複雑さを軽減する。 - 柔軟性の課題:動的な発見を通じて自律的なエージェント計画をサポートし、オープンドメインのタスクに適応する。

- コンテキストの課題:Resourcesのようなプリミティブを通じて構造化された外部メモリを提供する。

- エンタープライズの課題:ゲートウェイモデルを通じて権限、監査、およびコンプライアンスの要件を満たす。

MCP (Model Context Protocol)は、モデルが外部システムと通信するための標準化された手法を定義するだけでなく、スケーラブルで安全なAIエージェントプラットフォームを構築するためのインフラを提供します。

それは「機能の露出」や「ツールのガバナンス」から、「モデルのデカップリング」、「コンテキスト管理」、「安全なアクセス」に至るまで、一連のシステム的な問題を解決し、マルチモデル、マルチツール、複雑なタスクのシナリオにおけるAIエージェント開発を持続可能、保守可能、かつ安全なものにします。

AnthropicがMCPをLinux Foundationに寄贈し、Agentic AI Foundationを設立すると発表した際に述べたように、この動きはAIエージェントの相互運用性標準のオープンな発展を促進することを目的としています。MCPサーバーはこのビジョンの鍵となるコンポーネントであり、異なるAIとツールが安全かつ効率的に連携する未来に向けた、強固で信頼できるインフラレイヤーを提供します。AIがデモから本番環境へ、単一点のアプリケーションから複雑なシステムへと移行する中で、MCPサーバーは熟考されたスケーラブルな工学的回答を提示しています。

MCP記事シリーズ:

- MCPサーバーの包括的分析:AIエージェント時代のコンテキストとツール通信ハブ

- MCPサーバーはどのような課題を解決するのか? AIエージェントに不可欠な理由

- MCPサーバーアーキテクチャと動作原理:プロトコルから実行フローまで

- MCPサーバー実践ガイド:ゼロからの構築、テスト、デプロイ

- MCPサーバーのアプリケーションシナリオ評価と技術選定ガイド

著者について

このコンテンツは、NavGood コンテンツ編集チームによって作成・公開されました。 NavGoodは、AIツールとAIアプリケーションエコシステムに焦点を当てたプラットフォームであり、AIエージェント、自動化ワークフロー、生成AI技術の開発と実践的な実装に関する長期的な追跡情報を提供しています。

免責事項: この記事は著者の個人的な理解と実践的な経験に基づくものです。いかなるフレームワーク、組織、企業の公式な見解を代表するものではなく、また商業的、財務的、あるいは投資のアドバイスを構成するものでもありません。すべての情報は公開情報と著者の独立した調査に基づいています。

参考文献:

[1]: https://modelcontextprotocol.io/docs/learn/server-concepts "Understanding MCP servers - Model Context Protocol"

[2]: https://modelcontextprotocol.io/docs/learn/architecture "Architecture overview - Model Context Protocol"

[3]: https://cloud.google.com/blog/products/ai-machine-learning/announcing-official-mcp-support-for-google-services "Announcing Model Context Protocol (MCP) support for Google services"

[4]: https://developer.pingidentity.com/identity-for-ai/agents/idai-what-is-mcp.html "What is Model Context Protocol (MCP)?"