Robots.txt Generator の概要

Robots.txt ジェネレーター:完璧な robots.txt ファイルを作成する

robots.txt ファイルとは何ですか?

robots.txt ファイルは、検索エンジンのクローラーに、あなたのサイトからどのページやファイルをリクエストできるか、またはリクエストできないかを伝えるテキストファイルです。ウェブサイトのどの部分をインデックスさせるかを制御し、クローラーが機密性の高いコンテンツや重複コンテンツにアクセスするのを防ぐのに役立つため、SEO にとって重要です。

Robots.txt ジェネレーターはどのように機能しますか?

この無料の Robots.txt ジェネレーターおよびバリデーターツールは、ウェブマスター、SEO の専門家、およびマーケターが、この必要なファイルをすばやく簡単に作成するのに役立ちます。ディレクティブ(クロールを許可または禁止)、パス(特定のページとファイル)、およびディレクティブに従う必要があるボットを設定することにより、ファイルをカスタマイズできます。または、最も一般的な一般的な CMS ディレクティブのセットを含む、既製の robots.txt テンプレートを選択することもできます。サイトマップをファイルに追加することもできます。

主な機能:

- デフォルト構成:

- すべてのロボットにサイト全体へのアクセスを許可する。

- すべてのロボットによるサイト全体へのアクセスをブロックする。

- 特定のディレクトリまたはファイルをブロックする。

- 特定のロボット(例:Googlebot)のみを許可し、他のすべてのロボットをブロックする。

- 特定の URL パラメーターをブロックする。

- 特定のディレクトリのクロールを許可し、その他すべてをブロックする。

- 特定のディレクトリからの画像をブロックする。

- CSS および JS ファイルへのアクセスをブロックする。

- CMS テンプレート: 一般的な CMS プラットフォーム用の既製の robots.txt テンプレート。以下が含まれます。

- WordPress

- Shopify

- Magento

- Drupal

- Joomla

- PrestaShop

- Wix

- BigCommerce

- Squarespace

- Weebly

- AI Bot のブロック: 特定の AI bots をブロックまたは許可するためのオプションの構成。以下が含まれます。

- GPTBot

- ChatGPT-User

- Google-Extended

- PerplexityBot

- Amazonbot

- ClaudeBot

- Omgilibot

- FacebookBot

- Applebot

- その他多数。

- サイトマップの統合: サイトマップの URL を robots.txt ファイルに追加するオプション。

Robots.txt ジェネレーターの使用方法:

- デフォルト構成から始める: 要件に一致する基本構成を選択します。オプションには、すべてのロボットを許可する、すべてのロボットをブロックする、または特定のディレクトリまたはファイルをブロックすることが含まれます。

- ディレクティブをカスタマイズする: クロールを許可または禁止するためのディレクティブを設定し、パス(特定のページとファイル)を指定し、ディレクティブに従う必要があるボットを特定します。

- テンプレートを選択する: 一般的な CMS プラットフォーム用の既製の robots.txt テンプレートを選択します。

- サイトマップを追加する: ボットがウェブサイトのコンテンツをより効率的にクロールできるように、サイトマップの URL を含めます。

- ダウンロードして実装する: 生成された robots.txt ファイルをダウンロードし、ウェブサイトのルートフォルダーに追加します。

生成された robots.txt ファイルをウェブサイトに追加する方法

検索エンジンやその他のクロールボットは、ウェブサイトのメインディレクトリにある robots.txt ファイルを探します。robots.txt ファイルを生成したら、https://yoursite.com/robots.txt にあるウェブサイトのルートフォルダーに追加します。

robots.txt ファイルの追加方法は、使用しているサーバーと CMS によって異なります。ルートディレクトリにアクセスできない場合は、ウェブホスティングプロバイダーにお問い合わせください。

Robots.txt ジェネレーターを使用する利点:

- SEO の最適化: 検索エンジンがインデックスするウェブサイトの部分を制御し、サイトの SEO パフォーマンスを向上させます。

- カスタマイズ: さまざまなディレクティブとテンプレートを使用して、robots.txt ファイルを特定のニーズに合わせて調整します。

- AI Bot の制御: 特定の AI bots がサイトをクロールするのをブロックまたは許可します。

- 簡単なサイトマップの統合: サイトマップの URL を追加して、ボットがウェブサイトのコンテンツを効率的にクロールできるようにします。

- オープンソースへの貢献: GitHub でプロジェクトに貢献して、新機能を追加したり、バグを修正したり、既存のコードを改善したりします。

プロジェクトへの貢献:

これはオープンソースプロジェクトであり、誰でも参加できます。新機能を追加したり、バグを修正したり、GitHub repository でプルリクエストまたは issue を作成して既存のコードを改善したりすることで、このプロジェクトに貢献できます。

よくある質問

robots.txt ファイルを検索エンジンに送信するにはどうすればよいですか?

robots.txt ファイルを検索エンジンに送信する必要はありません。クローラーは、サイトをクロールする前に robots.txt ファイルを探します。見つかった場合、サイトをスキャンする前に最初にそれを読みます。

robots.txt ファイルに変更を加えて Google に通知する場合は、Google Search Console に送信できます。Robots.txt Tester を使用してテキストファイルを貼り付け、「送信」をクリックします。

"Robots.txt Generator" のベストな代替ツール

Rush Analytics:ランキング追跡、キーワード調査、サイト監査、PBNツールを備えたSEOプラットフォーム。 より良いランキングのために、監視、発見、最適化を行います。

Flexbe.AI は、60 秒以内にウェブサイトを生成する AI 搭載のウェブサイトビルダーです。AI 駆動のマーケティング調査、設計、コンテンツ作成、およびプロフェッショナルなエディターと e コマースツールを提供します。

Firecrawl は、AI アプリケーション向けに設計された领先のウェブクローリング、スクラッピング、検索 API です。ウェブサイトをクリーンで構造化された LLM 対応データに変換し、スケールで AI エージェントをプロキシなしで信頼性の高いウェブ抽出で強化します。

Skills.ai:ビジネスリーダーやコンテンツクリエイター向けのノーコードAIデータ分析エンジン。クライアントとの会議やソーシャルメディア用に、データに基づいた記事やプレゼンテーションを即座に生成します。

Skrape.aiを使用して、あらゆるWebサイトをクリーンで構造化されたデータに変換します。 AIを活用したAPIは、AIトレーニング用に優先形式でデータを抽出します。

ScrapeStormは、AIを搭載したビジュアルウェブスクレイピングツールで、コーディングなしでウェブサイトからデータを抽出できます。スマートなデータ識別、複数のエクスポートオプションを提供し、さまざまなオペレーティングシステムをサポートしています。

FYRANは、デジタルヒューマンの応答をサポートする無料のAIチャットボットビルダーです。PDF、テキスト、MP3、docxファイルを使用してカスタムチャットボットを作成します。ウェブサイト、API、JS、HTML経由で簡単に統合できます。

CoverLetterAI は、秒単位でパーソナライズされたATS最適化カバーレターを生成するAI駆動ツールで、手紙あたりわずか$5。履歴書と求人詳細をアップロードして、業界横断的に面接を獲得するのに役立つテーラーメイドのプロフェッショナルレターを取得。

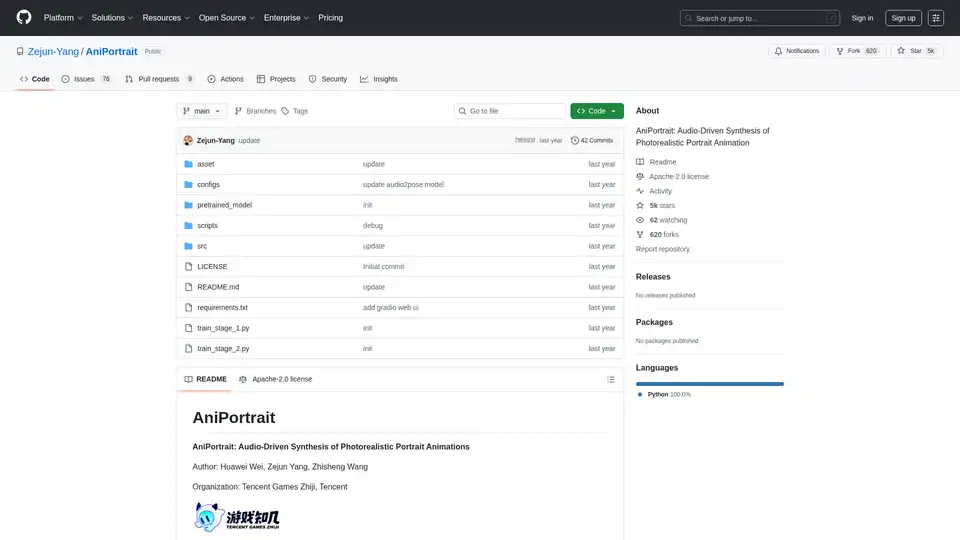

AniPortraitは、オープンソースのAIフレームワークで、音声またはビデオ入力によって駆動されるフォトリアリスティックなポートレートアニメーションを生成します。自駆動、顔再現、オーディオ駆動モードをサポートし、高品質なビデオ合成を実現します。

ロボット工学とAIを探索:ロボット、AIツール、イベント、ロボット工学とAIの分野の仕事を発見。トップレベルのAIツールで生産性と創造性を高めましょう。

AIボットとエージェントでTelegramの会話を強化しましょう。Telegramを離れることなく、質問に答えたり、タスクを支援したり、コンテンツを作成したりするために呼び出します。AI Inline Assistant、Llama 3.1、DALL·E、Geminiなどを発見してください!

Teragon Roboticsは、AI計画とモジュール式ハードウェアを使用して、自己複製ヒューマノイドロボットを開発しています。 これらのロボットは、コンポーネントを自律的に製造し、新しいユニットを組み立て、遠隔地や被災地の製造ボトルネックに対処します。

Lucky Robotsは、ロボットAIモデルのトレーニング用に無限の合成データを生成します。 リアルなシミュレーションでより速く、より安価にトレーニングできます。 実際の展開の前に、反復、トレーニング、およびテストを行います。

Starving Robotsは、カスタムAIアートプリントとパーソナライズされたAIアートプリントを提供しています。AIを使用してユニークなアートポスターとキャンバスを作成します。