ChatLLaMA の概要

ChatLLaMA とは?

ChatLLaMA は、アクセス可能な AI 技術における画期的な一歩を表しており、LLaMA モデルに対する LoRA(Low-Rank Adaptation)ファインチューニングによって駆動されるパーソナル AI アシスタントとして設計されています。このオープンソースツールは、ユーザーが自分の GPU でカスタマイズされた会話型 AI を直接実行できるようにし、クラウド依存を排除し、プライバシーを強化します。Anthropic の高品質な HH データセットで特別に訓練されており、このデータセットは役立つ誠実な対話を重視しており、ChatLLaMA はユーザーと AI アシスタント間のシームレスで自然な会話をモデリングする点で優れています。ローカル AI セットアップを試す開発者であれ、カスタマイズされたチャットボットを求めるエンスージアストであれ、ChatLLaMA は先進的な言語モデル機能をデスクトップに持ち込みます。

現在、30B、13B、7B LLaMA モデルのバージョンが利用可能で、最大 2048 トークンのシーケンス長をサポートしており、拡張されたインタラクションに多用途です。このツールにはユーザー friendly なデスクトップ GUI が含まれており、非専門家にとってセットアップと使用を簡素化します。わずか 3 ドルという手頃な価格で、2,011 件以上の販売と 127 人のユーザーからの堅実な 4.8 つ星評価を獲得しており、92% が五つ星を付けています。ユーザーはその革新的なアプローチを称賛していますが、一部はまだ完全にテストしていないと指摘しており、その潜在力への興奮を強調しています。

ChatLLaMA はどのように動作する?

その核心では、ChatLLaMA は LoRA を活用し、これは大規模言語モデル(例: LLaMA)のような事前訓練モデルを適応させる効率的なファインチューニング手法です。大量の計算リソースを必要とせずに、LoRA はモデル全体を再訓練するのではなく、低ランク行列をモデルの重みに導入し、主要パラメータの更新に焦点を当てます。これにより、軽量の適応器——LoRA 重み——が生まれ、ベース LLaMA モデルにロードして会話タスクに特化させることができます。

訓練プロセスでは、Anthropic の HH(Helpful and Harmless)データセットを使用し、これは倫理的で有用な応答を強調した対話例のコレクションです。これにより、ChatLLaMA は魅力的なだけでなく、安全で文脈に適した応答を生成します。例えば、現実的な往復のやり取りをシミュレートし、汎用チャットボットに比べてインタラクションをより人間らしく感じさせます。

今後リリース予定の RLHF(Reinforcement Learning from Human Feedback)バージョンは、ユーザー好みとのさらなる調整を約束し、人間による評価による洗練で応答品質を潜在的に向上させます。それを実行するには、選択したモデルサイズの LoRA 重みをダウンロードし、ローカル LLaMA 推論セットアップに統合します。デスクトップ GUI はこれを簡素化します: インターフェースを起動し、モデルを選択、重みをロードし、チャットを開始——すべて GPU 駆動で低遅延のパフォーマンスを実現します。

基礎モデル重みは提供されず、ChatLLaMA は研究目的で設計されており、ユーザーがベース LLaMA モデル(公開利用可能)にアクセスできることを前提としています。このモジュール式設計は柔軟性を提供します; 例えば、異なるベースモデルを試したり、将来の訓練イテレーションのためのデータセットを寄稿したりできます。

ChatLLaMA の使い方?

ChatLLaMA の始め方は簡単で、特にデスクトップ GUI を使えば特にそうです。以下はステップバイステップのガイドです:

ベースモデルを取得: Hugging Face などの公式ソースから LLaMA 7B、13B、または 30B モデル重みをダウンロードしてください。システムに互換性のある GPU(NVIDIA を推奨、十分な VRAM——7B で少なくとも 8GB、より大きなモデルではさらに必要)があることを確認してください。

LoRA 重みを購入・ダウンロード: 3 ドルで、モデルサイズに合わせた ChatLLaMA LoRA 重みを取得します。これらは標準版と 2048 シーケンス版があり、より長いコンテキストを扱えます。

デスクトップ GUI をインストール: オープンソースの GUI はパッケージの一部として提供されます。Python、PyTorch、および LLaMA 互換ライブラリ(例: 効率的な推論のための llama.cpp)などの依存関係をインストールします。GUI 実行ファイルを起動して環境を設定します。

ロードして起動: GUI でベースモデルと LoRA 重みを指定します。応答の創造性を制御する温度や出力長の最大トークンなどの設定を構成します。会話フローをテストするためにチャットセッションを開始します。

カスタマイズと実験: プロンプトを入力して対話をシミュレートします。高度なユーザー向けに、LoRA 適応器を調整したり、スクリプトと統合して自動化したりできます。セットアップに問題がある場合、アクティブな Discord コミュニティがリアルタイムサポートを提供します。

GUI は多くの重労働を処理するため、AI 展開の初心者でもアクセスしやすくなっています。有能なハードウェアでは応答時間が速く、1 ターンあたり通常 1 秒未満です。

なぜ ChatLLaMA を選ぶ?

ChatGPT のようなクラウドベースの AI が支配する風景の中で、ChatLLaMA はローカル実行の強調で際立っています。これはサブスクリプション料金なし、外部サーバーへのデータ送信なし、AI インタラクションの完全制御を意味します——プライバシーを意識したユーザーやインターネットが限られた地域に理想的です。その LoRA ベースのアプローチはリソース効率が高く、フルモデル訓練のオーバーヘッドなしにファインチューニングされたパフォーマンスを提供し、数千ドルの計算コストを避けられます。

ユーザーからのフィードバックはその価値を強調しています: あるレビューアはコンセプトを「甘い」と呼び、他の人はカスタムアシスタントの可能性を評価しています。高評価と強い販売により、ChatLLaMA が AI コミュニティで共鳴しているのは明らかです。また、プロジェクトのオープンソース精神はコラボレーションを招待します; 開発者はコードを寄稿することを奨励され、Discord 経由で GPU リソースが交換提供されます。

代替品と比較して、ChatLLaMA の HH などの対話データセットへの焦点は自然な会話モデリングで優位性を持ちます。それは単なるチャットボットではなく、研究ツールからパーソナル生産性支援まで、専門アシスタント構築の基盤です。

ChatLLaMA は誰向け?

ChatLLaMA は多様なオーディエンス向けに調整されています:

AI 研究者と開発者: LoRA ファインチューニング、RLHF 統合、またはデータセット寄稿の実験に最適です。オープンソース AI アプリを構築する場合、このツールは準備された会話バックボーンを提供します。

テックエンスージアストとホビイスト: オフラインで自分の AI コンパニオンを走らせ、カスタマイズして楽しんだり学んだりできます。GUI のおかげで高度なコーディングは不要です。

プライバシー重視のユーザー: クラウド AI に慎重なビジネスや個人は、内部チャットやプロトタイピングのためのセキュアでローカルなインスタンスを展開できます。

教育者と学生: 大規模言語モデルをハンズオンで探求し、インフラ障壁なしに倫理的 AI 対話をシミュレートします。

中間レンジの GPU を持つ人に特に適しており、7B モデルは控えめなハードウェアで動作します。ただし、研究指向なので、ベースモデルを自分で扱うことを期待してください——絶対初心者向けのプラグアンドプレイではありません。

ChatLLaMA の潜在力を最大化する最良の方法

ChatLLaMA を最大限に活用するために:

高品質データセットを統合: チームと対話データセットを共有し、コミュニティ駆動の改善を実現します。これにより、業界特化型アシスタントのような専門バージョンが生まれる可能性があります。

他のツールと組み合わせ: ハイブリッドセットアップのためのボイスインターフェースとペアリングしたり、API を通じてアプリに埋め込んでより広範なアプリケーションを実現したりします。

パフォーマンスを監視: 会話のコヒーレンスや関連性などのメトリクスを追跡します。即将の RLHF 更新はこれらをさらに向上させるでしょう。

コミュニティに参加: Discord は最適化のヒントからコラボレーションの機会まで賑わっています。開発者: GPU 支援プロジェクトのために @devinschumacher に連絡してください。

要約すると、ChatLLaMA は LoRA 駆動のローカル会話モデルをアクセスしやすくカスタマイズ可能にすることで、先進 AI を民主化します。パーソナル AI を革新するかオープンソースイノベーションに貢献するかにかかわらず、このツールは大規模言語モデルの進化する世界で莫大な実用的価値を提供します。飛び込んで、その能力を探求しながら funky に保ってください。

"ChatLLaMA" のベストな代替ツール

LoRA Tag は、LoRA トレーニング用の詳細な画像キャプションを生成する AI 搭載ツールで、手作業による時間を節約します。バッチ処理、さまざまな品質レベルを提供し、複数の LoRA タイプをサポートしています。

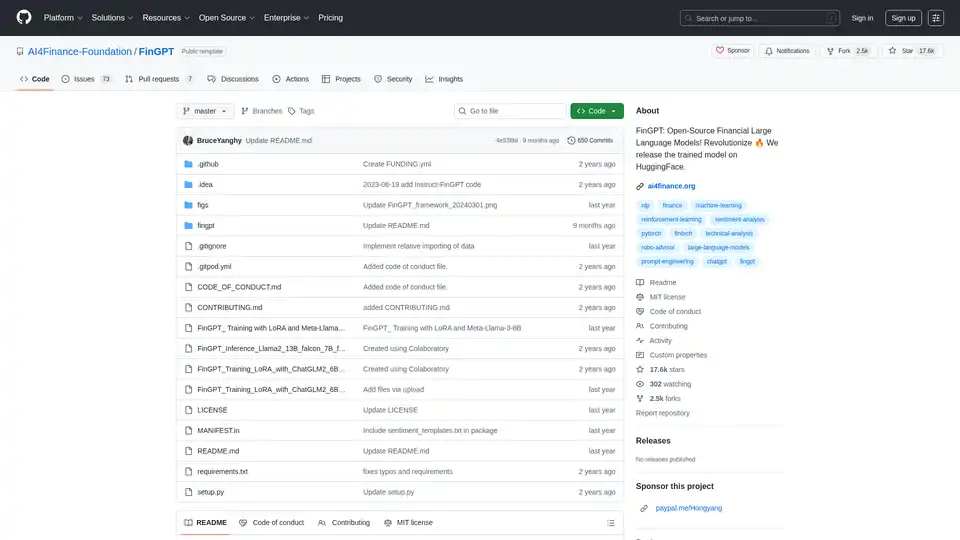

FinGPT:金融データ、センチメント分析、予測を民主化するためのオープンソースの金融大規模言語モデル。 迅速な市場の洞察を得るために迅速に微調整。

Scade.proは、技術スキルがなくてもAI機能を構築し、ワークフローを自動化し、1500以上のAIモデルを統合できる包括的なノーコードAIプラットフォームです。

Stable Cascadeは、Würstchenアーキテクチャ上に構築された効率的なテキストから画像へのモデルであり、高速な推論と費用対効果の高いトレーニングを提供します。画像生成などの機能を探求してください。

Pykaso AIを発見してください。超現実的なAI画像、ビデオ、カスタムキャラクターを作成するための究極のプラットフォームです。LoRaモデルを訓練し、スキンを強化し、ソーシャルメディアの成功のためのウイルスコンテンツを簡単に生成します。

高度信頼性のクラウドベース ComfyUI、ComfyUI ワークフローをオンラインで編集・実行し、収益を生む AI アプリとして公開。毎日数百の新しい AI アプリ。

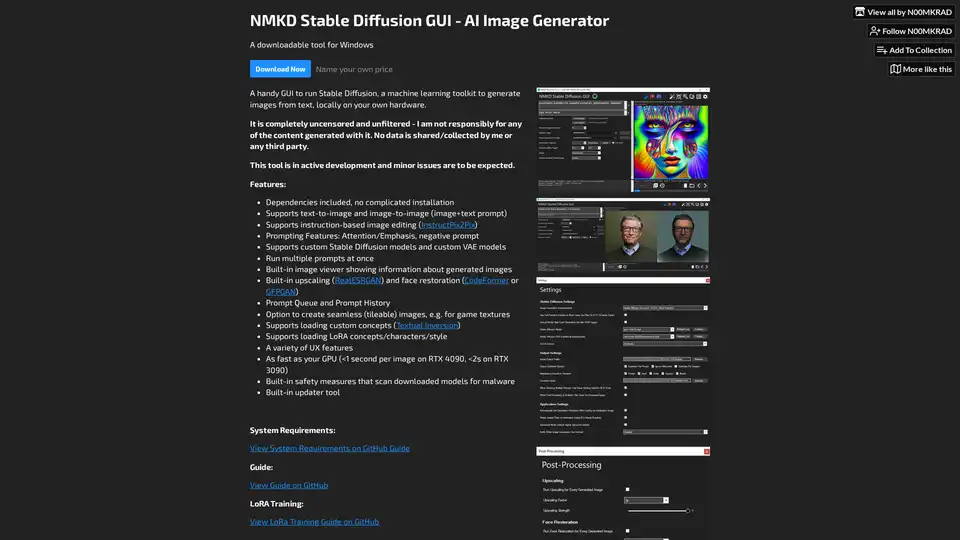

NMKD Stable Diffusion GUI は、Stable Diffusion を使用して GPU でローカルに AI 画像を生成する無料のオープンソースツールです。テキストから画像、画像編集、上スケーリング、LoRA モデルをサポートし、検閲やデータ収集はありません。

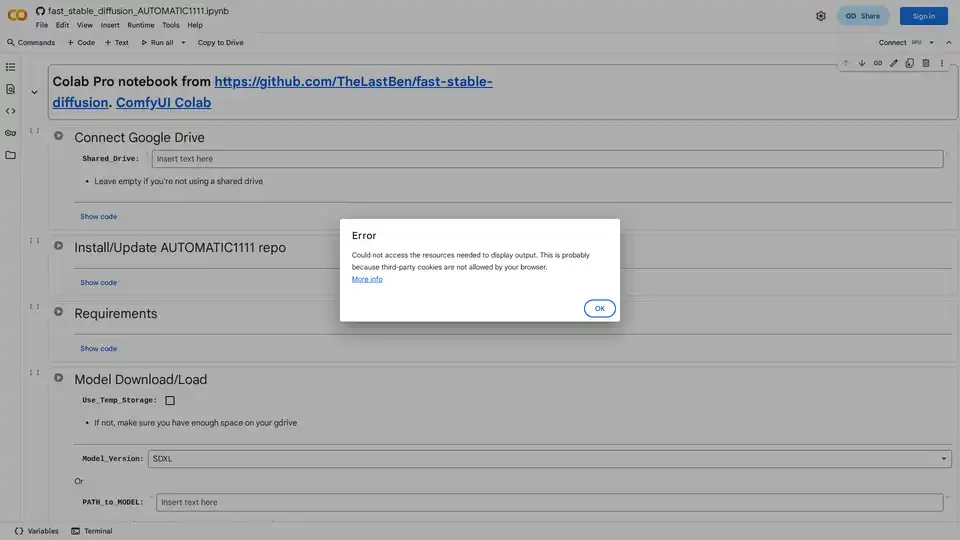

AUTOMATIC1111 の Web UI を使用して Google Colab で Stable Diffusion を簡単に実行する方法を紹介します。モデル、LoRA、ControlNet をインストールして、ローカルハードウェアなしで高速 AI 画像生成を実現。

xTuring は、オープンソースのライブラリで、ユーザーが大規模言語モデル(LLM)を効率的にカスタマイズおよび微調整できるようにし、シンプルさ、リソース最適化、AI パーソナライゼーションのための柔軟性に焦点を当てています。

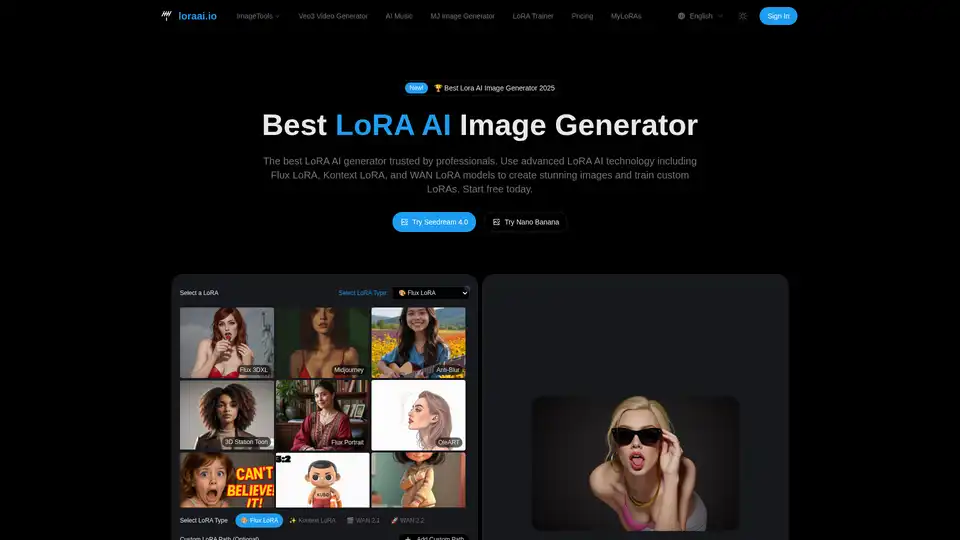

LoRA AIは最高のLoRA AI画像ジェネレーターです。 Flux LoRAを含む高度なLoRA AIテクノロジーを使用して、素晴らしい画像を作成し、カスタムLoRAをトレーニングします。 今日から無料で始めましょう!

Flux LoRA モデルライブラリで最新の Flux LoRA モデルを閲覧および比較します。AI画像作成のために、Flux モデル生成エクスペリエンスを向上させる完璧な Flux LoRA を見つけてください。

dreamlook.ai は、超高速の Stable Diffusion 微調整を提供し、ユーザーが 2.5 倍高速にモデルをトレーニングし、高品質の画像を迅速に生成できるようにします。LoRA ファイルを抽出して、ダウンロード サイズを削減します。

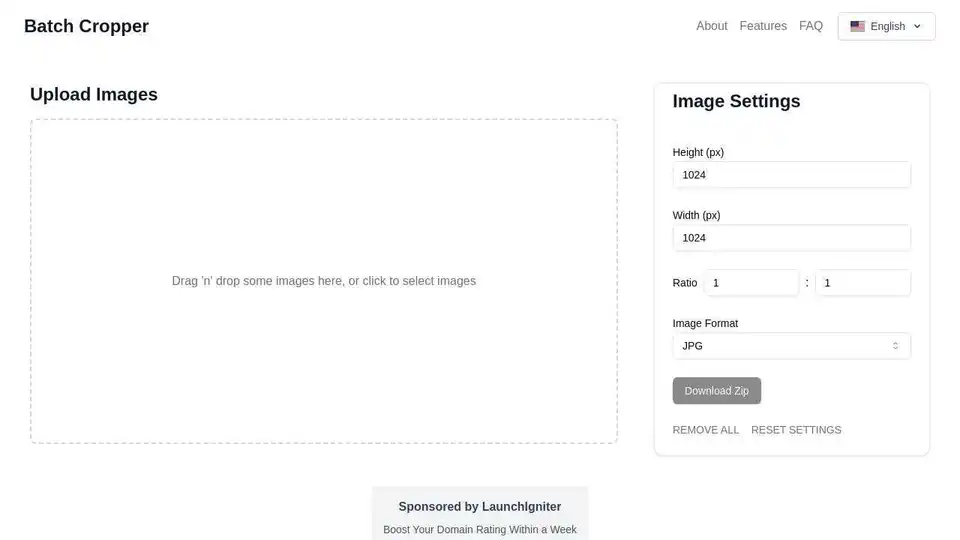

BatchCropperは、AIトレーニングデータの準備やLoRAトレーニングの品質向上に最適な、バッチ画像サイズ変更、トリミング、および形式変換のための多用途ツールです。

Predibaseは、オープンソースLLMを微調整して提供するための開発者向けプラットフォームです。強化学習機能を備えた、エンドツーエンドのトレーニングおよびサービスインフラストラクチャにより、比類のない精度と速度を実現します。