SiliconFlow の概要

SiliconFlow とは?

SiliconFlow は、大規模言語モデル (LLM) およびマルチモーダルモデル向けに特化して設計された最先端の AI インフラストラクチャプラットフォームです。開発者や企業が、200 以上の最適化されたモデルを雷のような推論速度でデプロイ、ファインチューニング、実行できるようにします。テキスト生成、画像処理、動画分析のいずれに取り組んでいるかに関わらず、SiliconFlow はサーバーレス、予約済み、またはプライベートクラウドのセットアップにわたる断片化を排除する統一ソリューションを提供します。このプラットフォームは、シンプルで OpenAI 互換の API を通じたシームレスな統合により、AI 推論の分野で際立っており、通常のインフラの頭痛を伴わずに AI アプリケーションをスケーリングするのに理想的です。

AI モデルがますます複雑化する時代において、SiliconFlow は遅延、スループット、コストの予測可能性といった主要な痛みに対応します。小規模開発チームから大企業まで、幅広いユースケースをサポートし、オープンソースおよび商用 LLM の両方で高いパフォーマンスを保証します。速度と効率に焦点を当てることで、SiliconFlow はユーザーが AI 開発を加速し、革新的なアイデアをこれまで以上に迅速にデプロイ可能なソリューションに変えるのを支援します。

SiliconFlow のコア機能

SiliconFlow は、AI 実践者向けに調整された堅牢な機能セットを備えています。以下がそれを首選択肢とする理由です:

最適化モデルライブラリ:DeepSeek-V3.1、GLM-4.5、Qwen3 シリーズなどの人気 LLM を含む 200 以上のモデルにアクセス可能。Qwen-Image や FLUX.1 などのマルチモーダルオプションも。自然言語処理から視覚理解までのタスクをサポートするよう、推論速度を高めるために事前最適化されています。

高速推論:低い遅延と高いスループットで驚異的なパフォーマンスを実現。プラットフォームのスタックは、言語およびマルチモーダルワークロードを効率的に処理するよう設計されており、リアルタイムアプリケーションに適しています。

柔軟なデプロイメントオプション:即時スケーラビリティのためのサーバーレス推論、予測可能なパフォーマンスのための予約 GPU、またはカスタムプライベートクラウドセットアップを選択。インフラ管理は不要—SiliconFlow が重い作業を担います。

ファインチューニング機能:組み込みの監視とエラスティックコンピュートリソースを使用して、ベースモデルを特定のデータに適応。モデルトレーニングの深い専門知識なしに AI 動作をカスタマイズするのに不可欠な機能です。

プライバシーとコントロール:データはプラットフォームに保存されず、あなたのものです。モデルデプロイメント、スケーリング、ファインチューニングの完全なコントロールを享受し、ベンダーロックインを回避。

統合のシンプルさ:OpenAI 標準と完全に互換性のある単一の API エンドポイントが開発を簡素化。開発者はモデルを簡単に切り替えたり統合したりでき、オンボーディング時間を短縮します。

これらの機能により、SiliconFlow は単なるホスティングサービスではなく、信頼性とコスト効率を優先する AI 推論のための包括的なエコシステムとなります。

SiliconFlow の仕組みは?

SiliconFlow の開始は簡単で、現代の DevOps 慣行に沿っています。プラットフォームは、モデルサービングの複雑さを抽象化する統一推論エンジン上で動作します。

まず、無料アカウントにサインアップし、モデルカタログを探索。テキストベースタスクのための LLM または画像・動画生成のためのマルチモーダルモデルを選択。例えば、DeepSeek-V3 などの LLM を実行するには、プロンプトで API を呼び出すだけ—サーバーレスモードではセットアップ不要。

ステップバイステップの内訳:

モデル選択:Kimi-K2-Instruct や Qwen3-Coder などの高度なモデルを含む広範なライブラリを閲覧。専門コーディングタスク向け。

デプロイメント:プロトタイピングに適した従量課金サーバーレス、または安定した遅延を確保する生産ワークロードのための GPU 予約を選択。

推論実行:OpenAI 互換 API を通じてリクエストを送信。プラットフォームがルーティングを最適化し、最小遅延で結果を配信。

ファインチューニングプロセス:データセットをアップロードし、ダッシュボードでパラメータを設定。SiliconFlow のエラスティックコンピュートがトレーニングを処理。統合ツールで進捗を監視し、迅速にイテレーション。

スケーリングと監視:需要が増大しても中断なくスケール。スループットとコストのメトリクスを提供し、意思決定を支援。

このワークフローは摩擦を最小限に抑え、イノベーションに集中できるようにします。マルチモーダルタスクの場合、Qwen-Image-Edit で画像生成など、LLM 推論を反映しつつ視覚入力に拡張。プラットフォームの高速機能をテキストを超えたモダリティで活用。

主なユースケースと実用的価値

SiliconFlow は、迅速で信頼性の高い AI 推論が不可欠な多様なシナリオで輝きます。チャットボット、コンテンツジェネレータ、推薦システムを構築する開発者は、正確で低遅延のレスポンスを得るために LLM を活用。メディアや e コマースの企業は、Wan2.2 モデルによる動画から画像変換などのマルチモーダル機能から利益を得、巨額のコンピュート投資なしにユーザーエクスペリエンスを向上。

主なユースケース:

- AI 駆動アプリケーション:仮想アシスタントや自動化カスタマーサポートなどのリアルタイム自然言語理解に LLM をアプリに統合。

- クリエイティブワークフロー:画像生成、編集、動画合成にマルチモーダルモデルを使用し、アーティストやマーケターのデザインプロセスを加速。

- 研究開発:金融分析や医療画像などのドメイン特化 AI に、独自データでモデルをファインチューニング。

- 高ボリューム推論:機械学習パイプラインのための大規模データセットのバッチ処理など、スケジュールされたジョブに予約オプションが適する。

実用的価値は、サーバーレスモードでの使用量のみの課金によるコスト効果と、パフォーマンス向上にあります。伝統的なセットアップを上回る場合が多く、ユーザーは推論時間を最大 50% 短縮したと報告。AI 駆動市場で競争力を維持したい予算意識の高いチームに賢い選択です。

SiliconFlow は誰向け?

このプラットフォームは幅広いオーディエンスに対応:

- 開発者とスタートアップ:インフラコストなしで迅速なプロトタイピングを必要とする人々。

- AI 研究者:実験のためのエラスティックリソースを必要とするファインチューニング専門家。

- 企業:プライバシー保証付きの高スケール推論を扱う大規模チーム。

- マルチモーダルイノベーター:コンピュータビジョンや生成 AI のクリエイターで、画像・動画技術の限界を押し広げる。

断片化されたツールに疲れ、信頼性が高くスケーラブルな AI バックボーンを求めるなら、SiliconFlow が味方です。特にローカルセットアップからクラウドベース推論への移行チームに価値があり、緩やかな学習曲線を提供。

競合他社より SiliconFlow を選ぶ理由は?

混雑した AI インフラ空間で、SiliconFlow は開発者中心のデザインで差別化。硬直的なクラウドプロバイダーとは異なり、ロックインなしの柔軟性と、マルチモーダルタスクの優れた速度を組み合わせ。価格は透明で使用量ベース、サプライズ請求を回避。OpenAI 互換性で既存ワークフローの移行を容易に。

ユーザー反馈では信頼性が強調:「API のシンプルさが統合で数週間を節約した」と一開発者。信頼性のために 99.9% のアップタイムを保証し、内蔵冗長性。GDPR や企業基準に準拠したデータ非保存などのセキュリティ機能で信頼を築く。

よくある質問

SiliconFlow でデプロイ可能なモデルタイプは?

SiliconFlow は DeepSeek、Qwen3 などの多数の LLM と、FLUX.1(画像用)、Wan2.2(動画用)などのマルチモーダルモデルをサポート。テキスト、画像、動画領域をカバー。

価格設定はどう機能する?

柔軟:サーバーレスはトークン/使用量課金、予約 GPU はボリューム向け固定レートで予測可能なコストを確保。

モデルをファインチューニングできる?

はい、簡単なデータアップロードと監視で—インフラ管理不要。

どのようなサポートがある?

包括的なドキュメント、API リファレンス、企業向け営業連絡、プラスコミュニティリソース。

OpenAI と互換性がある?

完全に—同じ SDK とエンドポイントでシームレス統合。

AI プロジェクトをスーパーチャージする準備は?SiliconFlow の無料ティアから今日開始し、速度とシンプルさの違いを体験。

"SiliconFlow" のベストな代替ツール

DaveAI は、AI エージェント、アバター、および視覚化を使用して、顧客のジャーニーをパーソナライズし、Web、キオスク、WhatsApp、およびエッジ展開全体でエンゲージメントを高める会話型エクスペリエンス クラウドです。

Nexa SDK は、LLM、マルチモーダル、ASR および TTS モデルの高速かつプライベートなデバイス上 AI 推論を可能にします。NPU、GPU、CPU を介して、モバイル、PC、自動車、IoT デバイスに本番環境対応のパフォーマンスでデプロイ。

AI Library を探索し、2150 以上のニューラルネットワークと生成コンテンツ作成のための AI ツールの包括的なカタログをご覧ください。テキストから画像、ビデオ生成などのトップ AI アートモデルを発見し、クリエイティブプロジェクトを強化します。

OpenUI はオープンソースツールで、自然言語で UI コンポーネントを記述し、LLM を使用してライブでレンダリングします。説明を HTML、React、または Svelte に変換して高速プロトタイピングを実現。

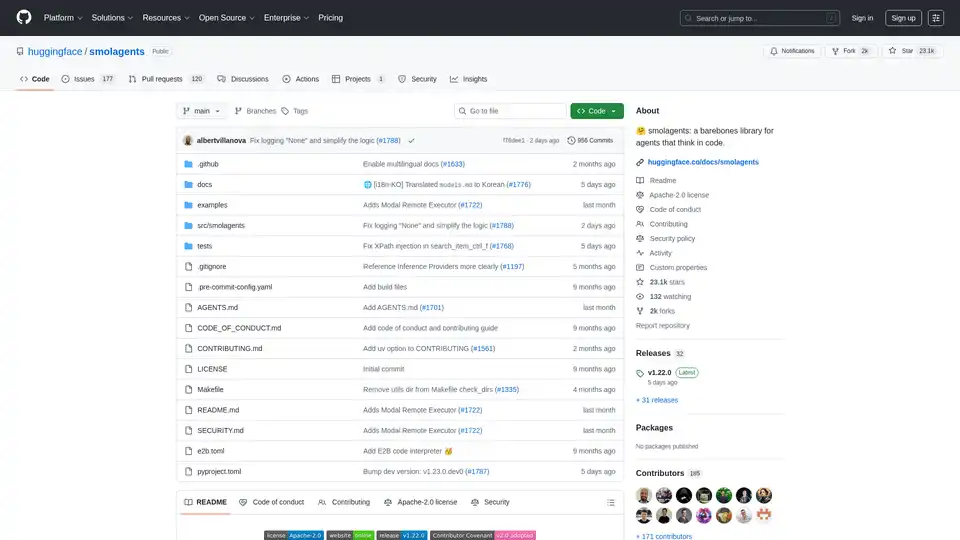

smolagents は、コードを通じて推論し行動する AI エージェントを作成するためのミニマリスト Python ライブラリです。LLM 無関係のモデル、安全なサンドボックス、Hugging Face Hub とのシームレスな統合をサポートし、高効率のコードベースのエージェントワークフローを実現します。

Agent TARS は、オープンソースのマルチモーダル AI エージェントで、ブラウザ操作、コマンドライン、ファイルシステムをシームレスに統合し、ワークフロー自動化を強化します。高度な視覚解釈と洗練された推論でタスクを効率的に処理します。

Falcon LLM は TII のオープンソース生成大規模言語モデルファミリーで、Falcon 3、Falcon-H1、Falcon Arabic などのモデルを備え、多言語・多モード AI アプリケーションを日常デバイスで効率的に実行します。

mistral.rsは、Rustで記述された非常に高速なLLM推論エンジンであり、マルチモーダルワークフローと量子化をサポートしています。Rust、Python、およびOpenAI互換のHTTPサーバーAPIを提供します。

Google の Gemini Pro と OpenAI の ChatGPT でプロンプトを並べて比較・共有し、最適な AI モデルを見つけましょう。

Jina AIは、最高クラスの埋め込み、リランカー、ウェブリーダー、ディープサーチ、および小規模言語モデルを提供します。多言語およびマルチモーダルデータ用の検索AIソリューション。

Oda Studioは、複雑なデータ分析のためのAI駆動のソリューションを提供し、建設、金融、メディア業界向けの非構造化データを実用的な洞察に変換します。ビジョン言語AIとナレッジグラフの専門家。

Mindgardの自動レッドチームとセキュリティテストでAIシステムを保護します。 AI固有のリスクを特定して解決し、堅牢なAIモデルとアプリケーションを保証します。

ハイブリッドAIを搭載したBeyond Limitsの産業用エンタープライズAIをご覧ください。石油・ガス、製造、ヘルスケアなどの産業向けに、運用を最適化し、データに基づいた意思決定を推進する、安全でスケーラブルなAIソリューションを提供します。

Jeda.aiは、アイデアを見事なビジュアルに変え、データを戦略的な洞察に変えるマルチモーダル生成ビジュアルAIワークスペースであり、アイデア出しや意思決定に最適です。