xMem の概要

xMemとは?

xMemは、長期的な知識とリアルタイムのコンテキストを組み合わせて、よりスマートで関連性の高いAIアプリケーションを作成するLLM(大規模言語モデル)用のメモリオーケストレーターです。

xMemの使い方?

APIまたはダッシュボードを使用して、xMemをLLMアプリケーションに統合します。 xMemは、LLM呼び出しごとに最適なコンテキストを自動的に組み立てるため、手動で調整する必要はありません。

const orchestrator = new xmem({

vectorStore: chromadb,

sessionStore: in-memory,

llmProvider: mistral

});

const response = await orchestrator.query({

input: "Tell me about our previous discussion"

});

xMemが重要な理由?

LLMはセッション間で情報を忘れることが多く、ユーザーエクスペリエンスが低下します。 xMemは、各ユーザーに永続的なメモリを提供することでこれに対処し、AIが常に最新で正確であることを保証します。

主な機能:

- 長期記憶: ベクトル検索を使用して、知識、メモ、ドキュメントを保存および取得します。

- セッションメモリ: 最近のチャット、指示、コンテキストを追跡して、鮮度とパーソナライズを行います。

- RAGオーケストレーション: LLM呼び出しごとに最適なコンテキストを自動的に組み立てます。 手動調整は不要です。

- ナレッジグラフ: 概念、事実、およびユーザーコンテキスト間の接続をリアルタイムで視覚化します。

利点:

- セッション間で知識やコンテキストを失うことはありません。

- オーケストレーションされたコンテキストでLLMの精度を高めます。

- オープンソースのLLMおよびベクトルデータベースで動作します。

- シームレスな統合と監視のための簡単なAPIとダッシュボード。

"xMem" のベストな代替ツール

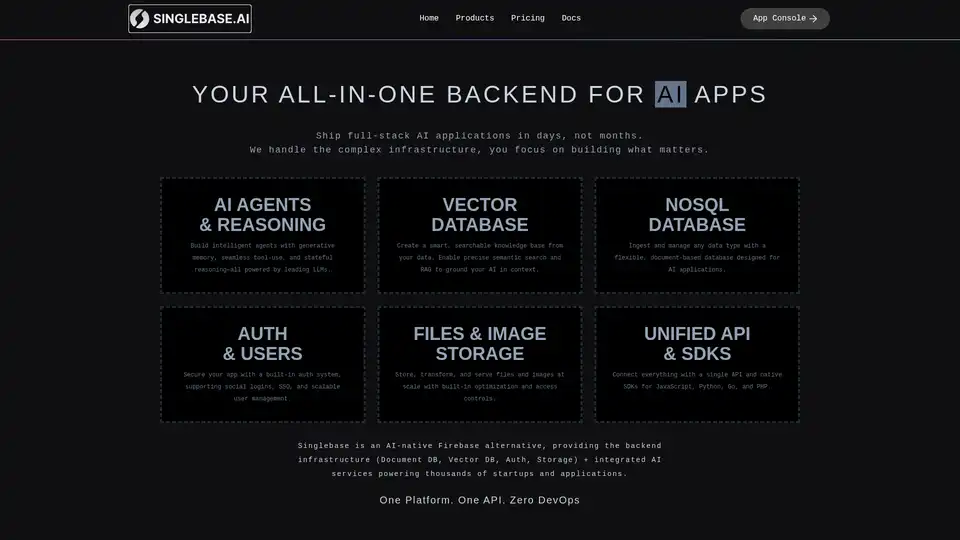

Singlebase は、AI ネイティブの Firebase の代替であり、AI アプリケーションに統合バックエンドを提供します。 ベクトル DB、NoSQL DB、認証、ストレージ、統合 AI サービスを 1 つのプラットフォームで提供します。

Akooda は、AI を活用したエンタープライズインテリジェンスプラットフォームであり、企業データを安全に検索し、実用的な洞察を提供し、データサイロを一元化されたナレッジハブに変換します。

Botpress は、最新の LLM を搭載した完全な AI エージェント プラットフォームです。 シームレスな統合機能により、カスタマーサポート、社内自動化などのための AI エージェントを構築、展開、管理できます。

Scoopikaは、LLMとAIエージェントを使用してマルチモーダルAIアプリを構築するためのオープンソースプラットフォームであり、エラー回復、ストリーミング、データ検証機能を備えています。

vLLMは、LLM のための高スループットかつメモリ効率の良い推論およびサービングエンジンであり、最適化されたパフォーマンスのためにPagedAttentionと継続的なバッチ処理を備えています。

Langbaseは、メモリとツールを備えたAIエージェントを構築、デプロイ、および拡張できるサーバーレスAI開発者プラットフォームです。250以上のLLM用の統一APIと、RAG、コスト予測、オープンソースAIエージェントなどの機能を備えています。

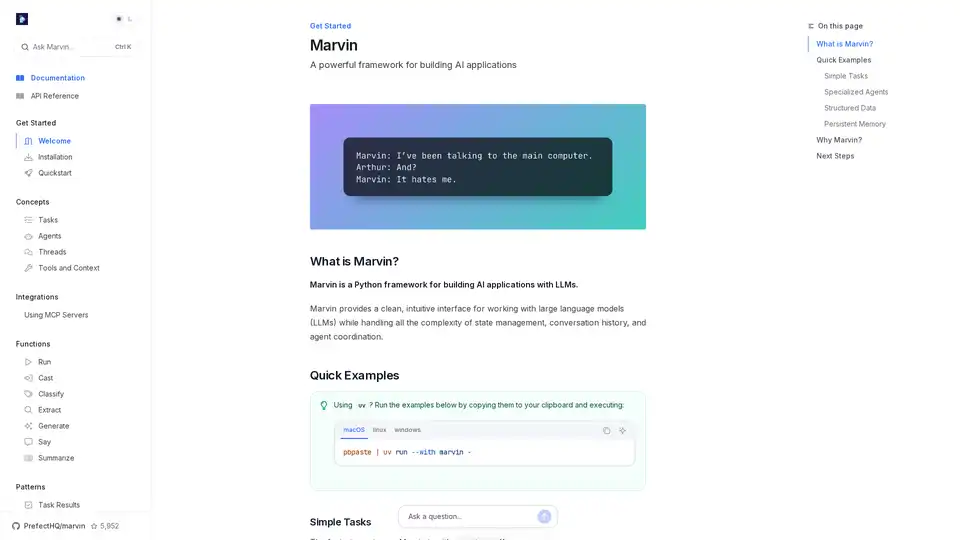

Marvin は、大規模言語モデル (LLM) を使用した AI アプリケーション構築のための強力な Python フレームワークです。状態管理、エージェント調整、構造化出力を簡素化し、インテリジェントなアプリを作成する開発者に適しています。

xTuring は、オープンソースのライブラリで、ユーザーが大規模言語モデル(LLM)を効率的にカスタマイズおよび微調整できるようにし、シンプルさ、リソース最適化、AI パーソナライゼーションのための柔軟性に焦点を当てています。

Janは、オープンソースのオフライン優先AIクライアントです。プライバシーを保護し、API料金なしで大規模言語モデル(LLM)をローカルで実行します。さまざまなモデルやサービスに接続します。

Supermemory は、LLM アプリに長期記憶を追加する高速メモリ API およびルーターです。Supermemory SDK および MCP を使用して、ミリ秒単位で保存、リコール、パーソナライズします。

Toolhouse は、LLM にアクションと知識を装備するためのクラウドインフラストラクチャです。わずか 3 行のコードで、スクレーパー、Web 検索などを備えた AI エージェントを構築およびデプロイします。

Superlinked:高性能な検索および推奨アプリケーションを構築するAIエンジニア向けのPythonフレームワークおよびクラウドインフラストラクチャ。

Agents-Flexは、LangChainのようなJavaで開発されたシンプルで軽量なLLMアプリケーション開発フレームワークです。