DeepSeek v3 개요

DeepSeek v3: 고급 AI 언어 모델

DeepSeek v3란 무엇입니까?

DeepSeek v3는 AI 언어 모델 영역에서 획기적인 발전을 의미합니다. 총 6,710억 개의 파라미터를 자랑하며 각 토큰에 대해 370억 개가 활성화되어 혁신적인 MoE(Mixture-of-Experts) 아키텍처를 활용하여 효율적인 추론을 유지하면서 광범위한 벤치마크에서 최첨단 성능을 제공합니다.

DeepSeek v3의 주요 특징

- 고급 MoE 아키텍처: DeepSeek v3는 총 671B 파라미터로 혁신적인 MoE(Mixture-of-Experts) 아키텍처를 활용하여 각 토큰에 대해 37B 파라미터를 활성화하여 최적의 성능을 제공합니다.

- 광범위한 훈련: DeepSeek v3는 14.8조 개의 고품질 토큰에 대해 사전 훈련되어 다양한 영역에 걸쳐 포괄적인 지식을 보여줍니다.

- 탁월한 성능: DeepSeek v3는 수학, 코딩 및 다국어 작업 등 여러 벤치마크에서 최첨단 결과를 달성합니다.

- 효율적인 추론: DeepSeek v3는 큰 크기에도 불구하고 혁신적인 아키텍처 설계를 통해 효율적인 추론 기능을 유지합니다.

- 긴 컨텍스트 창: 128K 컨텍스트 창을 통해 DeepSeek v3는 광범위한 입력 시퀀스를 효과적으로 처리하고 이해할 수 있습니다.

- 다중 토큰 예측: DeepSeek v3는 성능 향상 및 추론 가속화를 위해 고급 다중 토큰 예측을 통합합니다.

DeepSeek v3는 어떻게 작동합니까?

DeepSeek v3는 MoE(Mixture-of-Experts) 아키텍처를 활용합니다. 즉, 모든 작업에 대해 6,710억 개의 파라미터를 모두 사용하는 대신 각 입력 토큰에 대해 가장 관련성이 높은 370억 개의 파라미터만 지능적으로 활성화합니다. 이 접근 방식을 통해 모델은 계산 효율성을 유지하면서 높은 정확도와 성능을 달성할 수 있습니다.

DeepSeek v3 사용 방법

- 작업 선택: 텍스트 생성, 코드 완성 및 수학적 추론을 포함한 다양한 작업 중에서 선택합니다. DeepSeek v3는 여러 영역에서 뛰어납니다.

- 쿼리 입력: 프롬프트 또는 질문을 입력합니다. DeepSeek v3의 고급 아키텍처는 671B 파라미터 모델을 통해 고품질 응답을 보장합니다.

- AI 기반 결과 얻기: 고급 추론 및 이해를 보여주는 응답으로 DeepSeek v3의 뛰어난 성능을 경험해 보십시오.

성능 및 벤치마크

DeepSeek v3는 여러 벤치마크에서 최첨단 결과를 달성하여 다양한 영역에서 뛰어난 기능을 보여줍니다. 뛰어난 분야:

- 수학: 복잡한 수학 문제 해결.

- 코딩: 코드 생성 및 이해.

- 추론: 고급 논리적 추론 기술을 시연합니다.

- 다국어 작업: 여러 언어로 텍스트를 처리하고 생성합니다.

DeepSeek v3는 다른 오픈 소스 모델보다 성능이 뛰어나며 다양한 벤치마크에서 주요 폐쇄 소스 모델과 비교할 수 있는 성능을 달성합니다.

기술 세부 사항

- 아키텍처: MoE(Mixture-of-Experts)

- 총 파라미터: 671B

- 토큰당 활성화된 파라미터: 37B

- 컨텍스트 창: 128K

- 훈련 데이터: 14.8조 개의 토큰

배포 옵션

DeepSeek v3는 다음을 포함한 다양한 배포 옵션을 지원합니다.

- NVIDIA GPUs

- AMD GPUs

- Huawei Ascend NPUs

또한 다음을 포함한 여러 프레임워크를 지원합니다.

- SGLang

- LMDeploy

- TensorRT-LLM

- vLLM

DeepSeek v3는 FP8 및 BF16 추론 모드를 모두 지원하여 다양한 하드웨어 구성에서 최적의 성능을 제공합니다.

자주 묻는 질문

- DeepSeek v3의 고유한 점은 무엇입니까? DeepSeek v3는 대규모 671B 파라미터 MoE 아키텍처와 다중 토큰 예측 및 보조 손실 없는 로드 밸런싱과 같은 혁신적인 기능을 결합하여 다양한 작업에서 뛰어난 성능을 제공합니다.

- DeepSeek v3에 어떻게 액세스할 수 있습니까? DeepSeek v3는 온라인 데모 플랫폼 및 API 서비스를 통해 사용할 수 있습니다. 로컬 배포를 위해 모델 가중치를 다운로드할 수도 있습니다.

- DeepSeek v3는 어떤 작업에 능숙합니까? DeepSeek v3는 수학, 코딩, 추론 및 다국어 작업에서 뛰어난 성능을 보여주며 벤치마크 평가에서 지속적으로 최고 결과를 달성합니다.

- DeepSeek v3를 상업적으로 사용할 수 있습니까? 예, DeepSeek v3는 모델 라이선스 조건에 따라 상업적 사용을 지원합니다.

- DeepSeek v3의 컨텍스트 창 크기는 얼마입니까? DeepSeek v3는 128K 컨텍스트 창을 특징으로 하므로 복잡한 작업 및 장문 콘텐츠를 위해 광범위한 입력 시퀀스를 효과적으로 처리하고 이해할 수 있습니다.

- DeepSeek v3는 어떻게 훈련되었습니까? DeepSeek v3는 14.8조 개의 다양하고 고품질 토큰에 대해 사전 훈련되었으며 그 후 감독된 미세 조정 및 강화 학습 단계를 거쳤습니다.

결론

DeepSeek v3는 AI 언어 모델의 획기적인 발전을 의미하며 광범위한 작업에서 최첨단 성능을 제공합니다. 혁신적인 MoE(Mixture-of-Experts) 아키텍처, 광범위한 훈련 데이터 및 효율적인 추론 기능을 갖춘 DeepSeek v3는 다양한 산업 및 응용 분야에서 혁신을 주도할 수 있는 좋은 위치에 있습니다. 코드 생성, 수학적 추론 또는 다국어 작업을 수행하든 DeepSeek v3는 성공에 필요한 성능과 유연성을 제공합니다. 지금 온라인 데모 또는 API에 액세스하여 AI 언어 모델의 미래를 경험해 보십시오.

"DeepSeek v3"의 최고의 대체 도구

Friendli Inference는 가장 빠른 LLM 추론 엔진으로, 속도와 비용 효율성을 위해 최적화되어 높은 처리량과 짧은 대기 시간을 제공하면서 GPU 비용을 50~90% 절감합니다.

mistral.rs는 Rust로 작성된 매우 빠른 LLM 추론 엔진으로, 멀티모달 워크플로우와 양자화를 지원합니다. Rust, Python 및 OpenAI 호환 HTTP 서버 API를 제공합니다.

Groq은 빠르고, 고품질이며 에너지 효율적인 AI 추론을 위한 하드웨어 및 소프트웨어 플랫폼(LPU 추론 엔진)을 제공합니다. GroqCloud는 AI 애플리케이션을 위한 클라우드 및 온프레미스 솔루션을 제공합니다.

DeepSeek V3를 등록 없이 무료로 온라인에서 사용해 보세요. 이 강력한 오픈소스 AI 모델은 671B 매개변수를 가지고 있으며, 상업적 사용을 지원하며, 브라우저 데모 또는 GitHub 로컬 설치로 무제한 액세스를 제공합니다.

Nebius AI Studio Inference Service는 호스팅된 오픈소스 모델을 제공하여 독점 API보다 더 빠르고 저렴하며 정확한 추론 결과를 제공합니다. MLOps 없이 원활하게 확장 가능하며, RAG 및 생산 워크로드에 이상적입니다。

Qwen3 Coder, Alibaba Cloud의 고급 AI 코드 생성 모델을 탐구하세요. 기능, 성능 벤치마크, 그리고 이 강력한 오픈 소스 개발 도구를 사용하는 방법에 대해 알아보세요.

규모 있는 머신러닝은 최고의 머신러닝 엔지니어가 되기 위한 통찰력과 리소스를 제공합니다. RAG, LLM 최적화 및 ML 시스템 설계에 대한 심층 분석.

Translated.BEST는 원래 레이아웃을 보존하면서 80개 이상의 언어로 AI 기반 문서 번역을 제공합니다. 보안 로컬 LLM은 데이터 개인 정보를 보장합니다. 지금 번역하세요!

Cerebrium은 낮은 지연 시간, 제로 DevOps 및 초당 청구로 실시간 AI 애플리케이션 배포를 간소화하는 서버리스 AI 인프라 플랫폼입니다. LLM 및 비전 모델을 전 세계적으로 배포하십시오.

Jina AI는 최고 수준의 임베딩, 리랭커, 웹 리더, 딥 서치 및 소규모 언어 모델을 제공합니다. 다국어 및 멀티모달 데이터를 위한 검색 AI 솔루션입니다.

Confident AI는 DeepEval 기반의 LLM 평가 플랫폼으로, 엔지니어링 팀이 LLM 애플리케이션 성능을 테스트, 벤치마킹, 보호 및 향상시킬 수 있도록 지원합니다. AI 시스템을 최적화하고 회귀를 포착하기 위한 최고의 지표, 보호 장치 및 관측성을 제공합니다.

Keywords AI는 AI 스타트업을 위해 설계된 선도적인 LLM 모니터링 플랫폼입니다. 단 2줄의 코드로 LLM 애플리케이션을 쉽게 모니터링하고 개선하세요. 디버깅, 프롬프트 테스트, 로그 시각화, 성능 최적화를 통해 사용자 만족도를 높입니다.

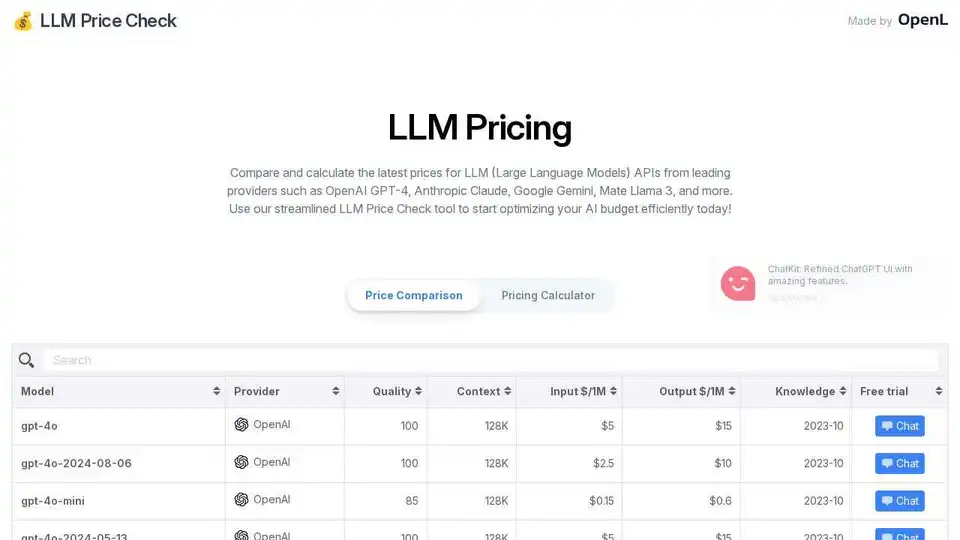

OpenAI, Anthropic, Google 등의 LLM API 가격을 비교하십시오. LLM Price Check의 간소화된 가격 계산기로 AI 예산을 최적화하십시오.