EvalsOne 개요

EvalsOne이란 무엇입니까?

EvalsOne은 생성형 AI 애플리케이션을 반복적으로 개발하고 최적화하도록 설계된 포괄적인 플랫폼입니다. LLMOps 워크플로를 간소화하고, 신뢰를 구축하고, AI 환경에서 경쟁 우위를 확보할 수 있는 직관적인 평가 툴박스를 제공합니다.

EvalsOne 사용 방법

EvalsOne은 LLM 프롬프트 제작, RAG 프로세스 미세 조정, AI 에이전트 평가에 적합한 원스톱 평가 툴박스를 제공합니다. 사용 방법은 다음과 같습니다.

- 평가 샘플을 쉽게 준비: 템플릿을 사용하고 변수 값을 생성하고 OpenAI Evals에서 평가 샘플 세트를 실행하거나 Playground에서 코드를 복사하여 붙여넣습니다.

- 포괄적인 모델 통합: OpenAI, Claude, Gemini, Mistral, Azure, Bedrock, Hugging Face, Groq, Ollama, Coze, FastGPT, Dify를 포함한 다양한 클라우드 및 로컬 환경에 배포된 모델을 기반으로 생성 및 평가를 지원합니다.

- 즉시 사용 가능한 평가자: 업계 최고의 평가자를 통합하고 복잡한 시나리오에 적합한 개인화된 평가자를 만들 수 있습니다.

EvalsOne이 중요한 이유

EvalsOne은 AI 라이프사이클 전반에 걸쳐 팀이 LLMOps 워크플로를 간소화하는 데 도움이 되므로 중요합니다. 개발자에서 연구원, 도메인 전문가에 이르기까지 EvalsOne은 다음을 가능하게 하는 직관적인 프로세스 및 인터페이스를 제공합니다.

- 평가 실행을 쉽게 생성하고 레벨별로 구성

- 포크된 실행을 통한 빠른 반복 및 심층 분석

- 비교 및 최적화를 위한 여러 프롬프트 버전 생성

- 명확하고 직관적인 평가 보고서

EvalsOne을 어디에서 사용할 수 있습니까?

개발에서 프로덕션 환경에 이르기까지 다양한 LLMOps 단계에서 EvalsOne을 사용할 수 있습니다. 다음 사항에 적용할 수 있습니다.

- LLM 프롬프트 제작

- RAG 프로세스 미세 조정

- AI 에이전트 평가

생성형 AI 앱을 평가하는 가장 좋은 방법은 무엇입니까?

EvalsOne으로 생성형 AI 앱을 평가하는 가장 좋은 방법은 규칙 기반 접근 방식과 LLM 기반 접근 방식을 함께 사용하고 전문가의 판단을 위해 인적 평가를 원활하게 통합하는 것입니다. EvalsOne은 평가, 점수 매기기, 합격/불합격과 같은 여러 판단 방법을 지원하며 판단 결과뿐만 아니라 추론 과정도 제공합니다.

"EvalsOne"의 최고의 대체 도구

Langbase는 메모리 및 도구를 사용하여 AI 에이전트를 구축, 배포 및 확장할 수 있는 서버리스 AI 개발자 플랫폼입니다. 250개 이상의 LLM을 위한 통합 API와 RAG, 비용 예측 및 오픈 소스 AI 에이전트와 같은 기능을 제공합니다.

HoneyHive는 LLM 애플리케이션을 구축하는 팀을 위한 AI 평가, 테스트 및 관찰 가능성 도구를 제공합니다. 통합 LLMOps 플랫폼을 제공합니다.

UpTrain은 LLM 애플리케이션을 평가, 실험, 모니터링 및 테스트하기 위한 엔터프라이즈급 도구를 제공하는 풀 스택 LLMOps 플랫폼입니다. 자체 보안 클라우드 환경에서 호스팅하고 AI를 자신 있게 확장하십시오.

Tryolabs는 맞춤형 AI 솔루션, 데이터 엔지니어링 및 MLOps를 제공하여 기업이 가치를 창출하도록 돕는 AI 및 머신러닝 컨설팅 회사입니다.

Weights & Biases는 모델을 훈련하고 미세 조정하며, 모델을 관리하고 GenAI 애플리케이션을 추적하는 AI 개발자 플랫폼입니다. 자신감 있게 AI 에이전트와 모델을 구축하십시오.

FinetuneDB는 데이터셋을 생성하고 관리하여 맞춤 LLM을 빠르고 저비용으로 훈련하는 AI 미세 조정 플랫폼으로, 생산 데이터와 협업 도구를 통해 모델 성능을 향상시킵니다.

UBIAI를 사용하면 강력하고 정확한 맞춤형 LLM을 몇 분 안에 구축할 수 있습니다. AI 개발 프로세스를 간소화하고 신뢰할 수 있는 AI 솔루션을 위해 LLM을 미세 조정하십시오.

AI Dev Assess는 개발자를 위한 기술 기술 평가를 간소화합니다. 역할별 평가 매트릭스와 면접 질문을 빠르게 생성하여 시간을 절약하고 채용 자신감을 높입니다.

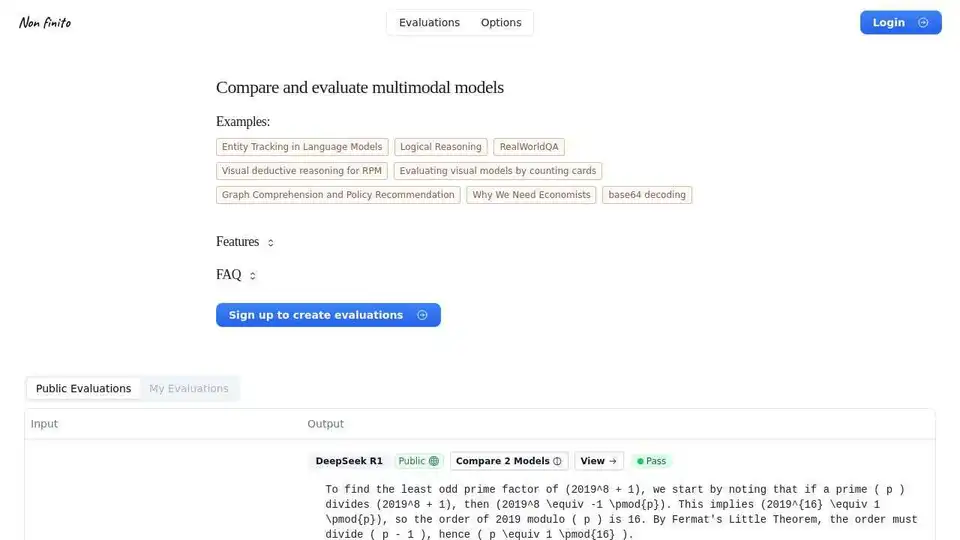

Non finito는 엔터티 추적, 논리적 추론 및 시각적 이해와 같은 예제를 제공하는 멀티모달 AI 모델을 비교하고 평가하는 플랫폼입니다. 가입하여 자신만의 평가를 만드십시오.

Quizdom AI는 AI 기반 정확도로 고품질 평가, 퀴즈 및 테스트를 생성, 사용자 정의 및 채점할 수 있는 AI 기반 플랫폼입니다. AI 저항성 질문을 생성하고 정확한 채점을 보장합니다.

InterviewQueue는 간편한 후보자 심사를 위한 AI 기반 온라인 평가 도구입니다. 사용자 정의 가능한 코딩 과제 및 AI 분석 기능을 통해 채용 프로세스를 최적화합니다.

RubricPro는 AI를 사용하여 루브릭을 기반으로 채점을 자동화합니다. 에세이, 이력서 등을 쉽게 평가하세요. 무료 평가판을 사용할 수 있습니다. AI의 두 번째 의견으로 정확성을 확인하세요.

Maxim AI는 포괄적인 테스트, 모니터링 및 품질 보증 도구를 갖춘 end-to-end 평가 및 관찰 가능성 플랫폼으로, 팀이 AI 에이전트를 안정적으로 5배 더 빠르게 출시할 수 있도록 지원합니다.

Freeplay는 프롬프트 관리, 평가, 관찰 가능성 및 데이터 검토 워크플로를 통해 팀이 AI 제품을 구축, 테스트 및 개선할 수 있도록 설계된 AI 플랫폼입니다. AI 개발을 간소화하고 고품질 제품을 보장합니다.