Robots.txt Generator

Visão geral de Robots.txt Generator

Gerador de Robots.txt: Crie o arquivo robots.txt perfeito

O que é um arquivo robots.txt?

Um arquivo robots.txt é um arquivo de texto que informa aos rastreadores de mecanismos de busca quais páginas ou arquivos o rastreador pode ou não solicitar do seu site. É importante para SEO porque ajuda você a controlar quais partes do seu site são indexadas, impedindo que os rastreadores acessem conteúdo sensível ou duplicado.

Como funciona o Gerador de Robots.txt?

Esta ferramenta gratuita de Gerador e validador de Robots.txt ajuda webmasters, especialistas em SEO e profissionais de marketing a criar de forma rápida e fácil este arquivo obrigatório. Você pode personalizar o arquivo configurando diretivas (permitir ou não permitir rastreamento), o caminho (páginas e arquivos específicos) e os bots que devem seguir as diretivas. Ou você pode escolher um modelo de robots.txt pronto que contenha um conjunto das diretivas gerais e de CMS mais comuns. Você também pode adicionar um sitemap ao arquivo.

Principais Características:

- Configurações Padrão:

- Permitir que todos os robots acessem todo o site.

- Bloquear que todos os robots acessem todo o site.

- Bloquear um diretório ou arquivo específico.

- Permitir apenas um robot específico (por exemplo, Googlebot) e bloquear todos os outros.

- Bloquear parâmetros de URL específicos.

- Permitir o rastreamento de um diretório específico e bloquear todo o resto.

- Bloquear imagens de um diretório específico.

- Bloquear o acesso a arquivos CSS e JS.

- Templates de CMS: Templates de robots.txt prontos para plataformas de CMS populares, incluindo:

- WordPress

- Shopify

- Magento

- Drupal

- Joomla

- PrestaShop

- Wix

- BigCommerce

- Squarespace

- Weebly

- Bloqueio de Bots de AI: Configurações opcionais para bloquear ou permitir bots de AI específicos, como:

- GPTBot

- ChatGPT-User

- Google-Extended

- PerplexityBot

- Amazonbot

- ClaudeBot

- Omgilibot

- FacebookBot

- Applebot

- e muitos mais.

- Integração de Sitemap: Opção para adicionar o URL do seu sitemap ao arquivo robots.txt.

Como usar o Gerador de Robots.txt:

- Comece com uma Configuração Padrão: Escolha uma configuração base que corresponda aos seus requisitos. As opções incluem permitir todos os robots, bloquear todos os robots ou bloquear diretórios ou arquivos específicos.

- Personalize as Diretivas: Configure as diretivas para permitir ou não permitir o rastreamento, especifique os caminhos (páginas e arquivos específicos) e identifique os bots que devem seguir as diretivas.

- Selecione um Template: Escolha um template de robots.txt pronto para plataformas de CMS comuns.

- Adicione um Sitemap: Inclua o URL do seu sitemap para ajudar os bots a rastrear o conteúdo do seu site de forma mais eficiente.

- Baixe e Implemente: Baixe o arquivo robots.txt gerado e adicione-o à pasta raiz do seu site.

Como adicionar o arquivo robots.txt gerado ao seu site?

Os mecanismos de busca e outros bots de rastreamento procuram um arquivo robots.txt no diretório principal do seu site. Depois de gerar o arquivo robots.txt, adicione-o à pasta raiz do seu site, que pode ser encontrada em https://yoursite.com/robots.txt.

O método de adicionar um arquivo robots.txt depende do servidor e do CMS que você está usando. Se você não conseguir acessar o diretório raiz, entre em contato com seu provedor de hospedagem na web.

Benefícios de usar o Gerador de Robots.txt:

- Otimização de SEO: Controle quais partes do seu site são indexadas pelos mecanismos de busca, melhorando o desempenho de SEO do seu site.

- Personalização: Adapte o arquivo robots.txt às suas necessidades específicas com várias diretivas e templates.

- Controle de Bots de AI: Bloqueie ou permita que bots de AI específicos rastreiem seu site.

- Fácil Integração de Sitemap: Adicione o URL do seu sitemap para ajudar os bots a rastrear o conteúdo do seu site de forma eficiente.

- Contribuição de Código Aberto: Contribua para o projeto no GitHub para adicionar novos recursos, corrigir bugs ou melhorar o código existente.

Contribuindo para o Projeto:

Este é um projeto de código aberto, e todos são bem-vindos a participar. Você pode contribuir para este projeto adicionando novos recursos, corrigindo bugs ou melhorando o código existente criando uma solicitação pull ou problema em nosso repositório do GitHub.

FAQs

Como envio um arquivo robots.txt para os mecanismos de busca?

Você não precisa enviar um arquivo robots.txt para os mecanismos de busca. Os rastreadores procuram um arquivo robots.txt antes de rastrear um site. Se eles encontrarem um, eles o leem primeiro antes de escanear seu site.

Se você fizer alterações no seu arquivo robots.txt e quiser notificar o Google, você pode enviá-lo para o Google Search Console. Use o Testador de Robots.txt para colar o arquivo de texto e clique em Enviar.

Melhores ferramentas alternativas para "Robots.txt Generator"

Rush Analytics: plataforma SEO com rastreamento de classificação, pesquisa de palavras-chave, auditoria de site e ferramentas PBN. Monitore, descubra e otimize para uma melhor classificação.

Flexbe.AI é um construtor de sites com tecnologia de IA que gera sites em menos de 60 segundos. Ele oferece pesquisa de mercado, design e criação de conteúdo com tecnologia de IA, juntamente com um editor profissional e ferramentas de comércio eletrônico.

Firecrawl é a API líder de rastreamento, raspagem e busca na web projetada para aplicativos de IA. Ela transforma sites em dados limpos, estruturados e prontos para LLM em escala, alimentando agentes de IA com extração web confiável sem proxies ou dores de cabeça.

Skills.ai: mecanismo de análise de dados de IA sem código para líderes empresariais e criadores de conteúdo. Gere artigos e apresentações baseados em dados instantaneamente para reuniões com clientes e mídia social.

Transforme qualquer site em dados limpos e estruturados com Skrape.ai. Nossa API baseada em IA extrai dados em seu formato preferido para treinamento de IA.

ScrapeStorm é uma ferramenta de web scraping visual com tecnologia de IA que permite aos usuários extrair dados de sites sem codificação. Oferece identificação inteligente de dados, múltiplas opções de exportação e suporta vários sistemas operacionais.

FYRAN é um criador de chatbot de IA gratuito que suporta respostas humanas digitais. Crie chatbots personalizados usando arquivos PDF, texto, MP3 e docx. Integre facilmente através do site, API, JS ou HTML.

CoverLetterAI é uma ferramenta alimentada por IA que gera cartas de apresentação personalizadas e otimizadas para ATS em segundos por apenas $5 por carta. Faça upload do seu currículo e detalhes da vaga para obter cartas profissionais sob medida que ajudam candidatos a conseguirem entrevistas.

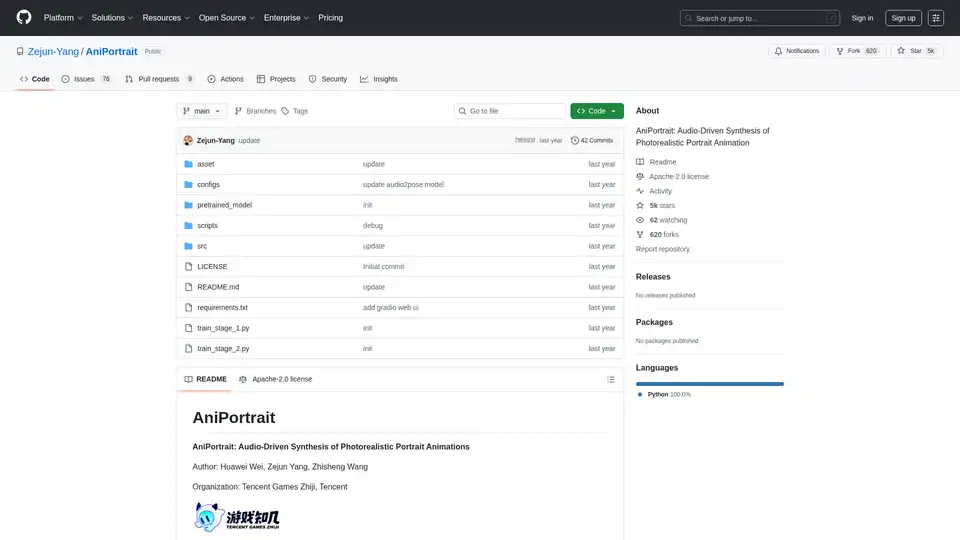

AniPortrait é um framework de IA de código aberto para gerar animações de retrato fotorrealistas impulsionadas por áudio ou vídeo. Suporta modos autoimpulsionados, reencenação facial e por áudio para síntese de vídeo de alta qualidade.

Explore robótica e IA: descubra robôs, ferramentas de IA, eventos e empregos em robótica e IA. Aumente a produtividade e a criatividade com ferramentas de IA de primeira linha.

Melhore as conversas do Telegram com Bots e Agentes de IA. Invoque-os para responder a perguntas, ajudar com tarefas ou criar conteúdo sem sair do Telegram. Descubra o AI Inline Assistant, Llama 3.1, DALL·E, Gemini e muito mais!

Teragon Robotics está desenvolvendo robôs humanóides auto-replicantes usando planejamento de IA e hardware modular. Esses robôs fabricam componentes de forma autónoma e montam novas unidades, resolvendo gargalos de fabricação em áreas remotas e devastadas por desastres.

Lucky Robots gera dados sintéticos infinitos para treinamento de modelos de IA robótica. Treine mais rápido e barato com simulações realistas. Itere, treine e teste antes da implantação no mundo real.

Starving Robots oferece impressão de arte de IA personalizada e impressões de arte de IA personalizadas. Crie pôsteres e telas exclusivos usando IA.