ChatLLaMA

Visão geral de ChatLLaMA

O que é ChatLLaMA?

ChatLLaMA representa um passo inovador na tecnologia de IA acessível, projetado como um assistente de IA pessoal alimentado por fine-tuning LoRA (Low-Rank Adaptation) em modelos LLaMA. Esta ferramenta de código aberto permite que os usuários executem uma IA conversacional personalizada diretamente em suas próprias GPUs, eliminando a necessidade de dependências na nuvem e melhorando a privacidade. Treinado especificamente no dataset HH de alta qualidade da Anthropic, que foca em diálogos úteis e honestos, o ChatLLaMA se destaca na modelagem de conversas fluidas e naturais entre usuários e assistentes de IA. Seja você um desenvolvedor experimentando com configurações de IA locais ou um entusiasta em busca de um chatbot personalizado, o ChatLLaMA traz capacidades avançadas de modelos de linguagem para sua área de trabalho.

Atualmente disponível em versões para modelos LLaMA de 30B, 13B e 7B, ele suporta comprimentos de sequência de até 2048 tokens, tornando-o versátil para interações estendidas. A ferramenta inclui uma GUI de desktop amigável ao usuário, simplificando a configuração e o uso para não especialistas. Com preço acessível de apenas $3, acumulou mais de 2.011 vendas e uma sólida classificação de 4,8 estrelas de 127 usuários, com 92% dando cinco estrelas. Os usuários elogiam sua abordagem inovadora, embora alguns notem que ainda não o testaram completamente — destacando o entusiasmo em torno de seu potencial.

Como o ChatLLaMA Funciona?

Em seu núcleo, o ChatLLaMA aproveita o LoRA, um método eficiente de fine-tuning que adapta grandes modelos de linguagem pré-treinados como o LLaMA sem exigir recursos computacionais massivos. Em vez de re-treinar todo o modelo, o LoRA introduz matrizes de baixo rank nos pesos do modelo, focando atualizações em parâmetros chave. Isso resulta em um adaptador leve — os pesos LoRA — que pode ser carregado em modelos base LLaMA para especializá-los em tarefas conversacionais.

O processo de treinamento usa o dataset HH (Helpful and Harmless) da Anthropic, uma coleção de exemplos de diálogo enfatizando respostas éticas e úteis. Isso garante que o ChatLLaMA gere respostas que não sejam apenas envolventes, mas também seguras e contextualmente apropriadas. Por exemplo, ele simula trocas realistas de ida e volta, tornando as interações mais humanas em comparação com chatbots genéricos.

Uma versão futura de RLHF (Reinforcement Learning from Human Feedback) promete melhor alinhamento com as preferências dos usuários, potencialmente melhorando a qualidade das respostas por meio de refinamentos avaliados por humanos. Para executá-lo, os usuários baixam os pesos LoRA para o tamanho de modelo escolhido e os integram a uma configuração de inferência LLaMA local. A GUI de desktop simplifica isso: inicie a interface, selecione seu modelo, carregue os pesos e comece a conversar — tudo alimentado pela sua GPU para desempenho de baixa latência.

Nenhum peso de modelo fundacional é fornecido, pois o ChatLLaMA é destinado à pesquisa e assume que os usuários têm acesso aos modelos base LLaMA (que estão disponíveis abertamente). Esse design modular permite flexibilidade; por exemplo, você pode experimentar com diferentes modelos base ou até contribuir datasets para iterações futuras de treinamento.

Como Usar o ChatLLaMA?

Começar com o ChatLLaMA é direto, especialmente com sua GUI de desktop. Aqui vai um guia passo a passo:

Adquirir o Modelo Base: Baixe os pesos do modelo LLaMA 7B, 13B ou 30B de fontes oficiais como o Hugging Face. Certifique-se de que seu sistema tenha uma GPU compatível (recomendado NVIDIA com VRAM suficiente — pelo menos 8 GB para 7B, mais para modelos maiores).

Comprar e Baixar Pesos LoRA: Por $3, obtenha os pesos LoRA do ChatLLaMA adaptados ao seu tamanho de modelo. Eles estão disponíveis em variantes padrão e de sequência 2048 para lidar com contextos mais longos.

Instalar a GUI de Desktop: A GUI de código aberto é fornecida como parte do pacote. Instale dependências como Python, PyTorch e bibliotecas compatíveis com LLaMA (ex.: llama.cpp para inferência eficiente). Execute o executável da GUI para configurar seu ambiente.

Carregar e Iniciar: Na GUI, aponte para seu modelo base e pesos LoRA. Configure configurações como temperatura para criatividade de respostas ou tokens máximos para comprimento de saída. Inicie uma sessão de chat para testar o fluxo conversacional.

Personalizar e Experimentar: Insira prompts para simular diálogos. Para usuários avançados, ajuste o adaptador LoRA ou integre com scripts para automação. Se encontrar problemas de configuração, a comunidade ativa no Discord oferece suporte em tempo real.

A GUI cuida de grande parte do trabalho pesado, tornando-a acessível mesmo se você for novo no deployment de IA. Os tempos de resposta são rápidos em hardware capaz, muitas vezes em menos de um segundo por turno.

Por Que Escolher o ChatLLaMA?

Em um cenário dominado por IA baseada em nuvem como o ChatGPT, o ChatLLaMA se destaca por seu foco na execução local. Isso significa sem taxas de assinatura, sem dados enviados para servidores externos e controle total sobre suas interações com IA — ideal para usuários preocupados com privacidade ou aqueles em regiões com internet limitada. Sua abordagem baseada em LoRA é eficiente em recursos, permitindo desempenho fine-tuned sem o overhead do treinamento completo do modelo, que pode custar milhares em computação.

O feedback dos usuários reforça seu valor: um revisor o chamou de "sweet" pelo conceito, enquanto outros apreciam o potencial para assistentes personalizados. Com classificações altas e vendas fortes, fica claro que o ChatLLaMA ressoa na comunidade de IA. Além disso, o ethos de código aberto do projeto incentiva a colaboração; desenvolvedores são encorajados a contribuir código, com recursos de GPU oferecidos em troca via Discord.

Comparado a alternativas, o foco do ChatLLaMA em datasets de diálogo como o HH lhe dá uma vantagem na modelagem de conversas naturais. Não é apenas um chatbot — é uma base para construir assistentes especializados, de ferramentas de pesquisa a auxílios de produtividade pessoal.

Para Quem é o ChatLLaMA?

O ChatLLaMA é adaptado para um público diversificado:

Pesquisadores e Desenvolvedores de IA: Perfeito para experimentar com fine-tuning LoRA, integração RLHF ou contribuições de datasets. Se você está construindo apps de IA open-source, esta ferramenta fornece uma espinha dorsal conversacional pronta.

Entusiastas e Hobbyistas de Tecnologia: Execute seu próprio companheiro de IA offline, personalizando-o para diversão ou aprendizado. Sem codificação avançada necessária graças à GUI.

Usuários Focados em Privacidade: Empresas ou indivíduos cautelosos com IA na nuvem podem implantar instâncias seguras e locais para chats internos ou prototipagem.

Educadores e Estudantes: Use-o para explorar modelos de linguagem grandes de forma hands-on, simulando diálogos de IA éticos sem barreiras de infraestrutura.

É especialmente adequado para aqueles com GPUs de médio porte, pois o modelo 7B roda em hardware modesto. No entanto, é orientado para pesquisa, então espere gerenciar os modelos base você mesmo — não é plug-and-play para iniciantes absolutos.

Melhores Maneiras de Maximizar o Potencial do ChatLLaMA

Para tirar o máximo do ChatLLaMA:

Integrar Datasets de Alta Qualidade: Compartilhe datasets de diálogo com a equipe para melhorias impulsionadas pela comunidade. Isso poderia levar a versões especializadas, como assistentes específicos de indústria.

Combinar com Outras Ferramentas: Combine com interfaces de voz para setups híbridos ou incorpore em apps via APIs para aplicações mais amplas.

Monitorar o Desempenho: Acompanhe métricas como coerência e relevância em conversas. A atualização RLHF futura provavelmente impulsionará isso ainda mais.

Junte-se à Comunidade: O Discord está agitado com dicas, desde tweaks de otimização a oportunidades de colaboração. Desenvolvedores: Entre em contato com @devinschumacher para projetos assistidos por GPU.

Em resumo, o ChatLLaMA democratiza a IA avançada ao tornar modelos conversacionais locais alimentados por LoRA acessíveis e personalizáveis. Seja revolucionando a IA pessoal ou contribuindo para a inovação open-source, esta ferramenta oferece um valor prático imenso no mundo em evolução dos grandes modelos de linguagem. Mergulhe e mantenha o groove enquanto explora suas capacidades.

Melhores ferramentas alternativas para "ChatLLaMA"

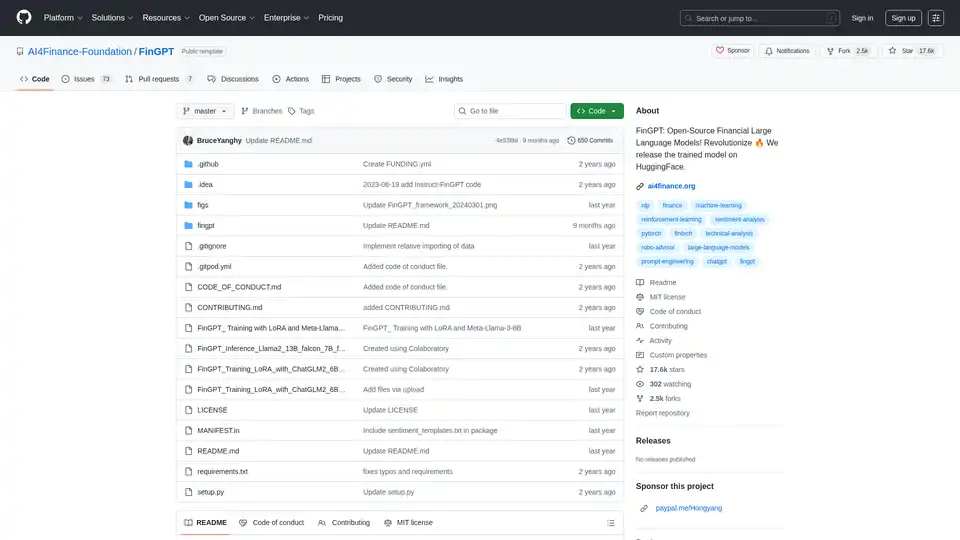

FinGPT: Um grande modelo de linguagem financeira de código aberto para democratizar dados financeiros, análise de sentimento e previsão. Ajuste fino rapidamente para obter insights de mercado oportunos.

Scade.pro é uma plataforma de IA sem código abrangente que permite aos usuários criar recursos de IA, automatizar fluxos de trabalho e integrar mais de 1500 modelos de IA sem habilidades técnicas.

Descubra o Pykaso AI, a plataforma definitiva para criar imagens, vídeos e personagens IA ultra-realistas. Treine modelos LoRa, aprimore peles e gere conteúdo viral facilmente para o sucesso nas redes sociais.

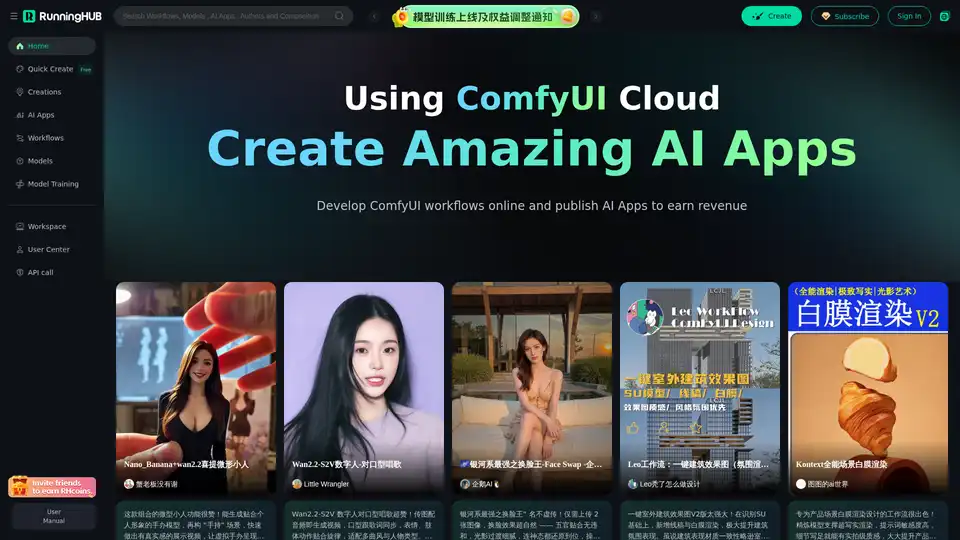

ComfyUI Baseado em Nuvem Altamente Confiável, Edite e Execute Fluxos de Trabalho ComfyUI Online, Publique-os como Apps de IA para Ganhar Receita, Centenas de Novos Apps de IA Diários.

NMKD Stable Diffusion GUI é uma ferramenta gratuita e de código aberto para gerar imagens AI localmente no seu GPU com Stable Diffusion. Suporta texto para imagem, edição de imagem, upscaling e modelos LoRA sem censura ou coleta de dados.

xTuring é uma biblioteca open-source que capacita os usuários a personalizar e fazer fine-tuning de Modelos de Linguagem Grandes (LLMs) de forma eficiente, focando em simplicidade, otimização de recursos e flexibilidade para personalização de IA.

Navegue e compare os modelos Flux LoRA mais recentes na Biblioteca de modelos Flux LoRA. Encontre o Flux LoRA perfeito para melhorar sua experiência de geração de modelos Flux para a criação de imagens AI.

A API Stable Diffusion permite que você gere e ajuste imagens de IA sem esforço. Acesse as APIs de texto para imagem, imagem para imagem e pintura interna sem precisar de GPUs caras.

dreamlook.ai oferece ajuste fino Stable Diffusion extremamente rápido, permitindo que os usuários treinem modelos 2,5 vezes mais rápido e gerem imagens de alta qualidade rapidamente. Extraia arquivos LoRA para reduzir o tamanho do download.

Replicate permite que você execute e ajuste modelos de aprendizado de máquina de código aberto com uma API na nuvem. Construa e dimensione produtos de IA com facilidade.

Predibase é uma plataforma de desenvolvedores para ajustar e servir LLMs de código aberto. Alcance precisão e velocidade incomparáveis com a infraestrutura de treinamento e serviço de ponta a ponta, com ajuste fino de reforço.

Image Pipeline permite que você crie visuais de IA com qualidade de produção com o máximo de controle usando a tecnologia mais recente, como Stable Diffusion, ControlNets e modelos personalizados. Concentre-se na construção de produtos de IA sem manutenção de GPU.

Crie histórias visuais personalizadas com TheFluxTrain. Treine a IA em suas próprias imagens para gerar personagens consistentes e transformá-los em narrativas visuais atraentes, influenciadores de IA e maquetes de produtos.

Fireworks AI oferece inferência incrivelmente rápida para IA generativa usando modelos de código aberto de última geração. Ajuste e implemente seus próprios modelos sem custo extra. Escale as cargas de trabalho de IA globalmente.