Fireworks AI

Visão geral de Fireworks AI

Fireworks AI: O motor de inferência mais rápido para IA generativa

O que é Fireworks AI? Fireworks AI é uma plataforma projetada para fornecer as velocidades de inferência mais rápidas para modelos de IA generativa. Ele permite que os usuários construam, ajustem e dimensionem aplicativos de IA com facilidade, aproveitando modelos de código aberto otimizados para vários casos de uso.

Como funciona o Fireworks AI? O Fireworks AI alcança alto desempenho por meio de seu mecanismo de inferência, que é otimizado para baixa latência, alto rendimento e concorrência. A plataforma suporta modelos populares como DeepSeek, Llama, Qwen e Mistral, permitindo que os desenvolvedores experimentem e iterem rapidamente usando os SDKs do Fireworks.

Principais recursos e benefícios

- Inferência incrivelmente rápida: Oferece desempenho em tempo real com latência mínima, adequado para aplicações de missão crítica.

- Ajuste avançado: Fornece ferramentas para maximizar a qualidade do modelo por meio de técnicas como aprendizado por reforço e ajuste com reconhecimento de quantização.

- Escalonamento contínuo: Provisiona automaticamente as GPUs mais recentes em várias nuvens e regiões, garantindo alta disponibilidade e desempenho consistente.

- Modelos de código aberto: Suporta uma ampla gama de modelos de código aberto, oferecendo flexibilidade e opções de personalização.

- Pronto para empresas: Inclui recursos para colaboração segura em equipe, monitoramento e conformidade (SOC2 Type II, GDPR, HIPAA).

Casos de uso

Fireworks AI é adequado para uma variedade de aplicações, incluindo:

- Agentes de voz: Potencializando interações de voz em tempo real com baixa latência.

- Assistentes de código: Aprimorando a geração e conclusão de código com velocidades de inferência rápidas.

- Ferramentas de desenvolvimento de IA: Permitindo ajuste fino, pesquisa de código alimentada por IA e contexto de código profundo para fluxos de trabalho de desenvolvimento aprimorados.

Por que o Fireworks AI é importante?

Fireworks AI aborda a necessidade de velocidade e escalabilidade em aplicações de IA generativa. Ao otimizar a inferência e fornecer escalonamento contínuo, ele permite que as empresas implementem recursos de IA em escala sem sacrificar o desempenho ou a relação custo-benefício.

Para quem é o Fireworks AI?

Fireworks AI é ideal para:

- Empresas: Que buscam implementar soluções de IA com segurança e conformidade de nível empresarial.

- Desenvolvedores: Buscando uma plataforma rápida e flexível para experimentar modelos de código aberto.

- Pesquisadores de IA: Precisando de infraestrutura robusta para treinar e implementar modelos de IA.

Depoimentos de clientes

Várias empresas tiveram sucesso com o Fireworks AI:

- Cursor: Sualeh Asif, CPO, elogiou o Fireworks por seu desempenho e degradação mínima na qualidade do modelo quantizado.

- Quora: Spencer Chan, líder de produto, destacou o Fireworks como a melhor plataforma para servir LLMs de código aberto e dimensionar adaptadores LoRA.

- Sourcegraph: Beyang Liu, CTO, observou a inferência de modelo rápida e confiável do Fireworks para construir ferramentas de desenvolvimento de IA como Cody.

- Notion: Sarah Sachs, líder de IA, relatou uma redução significativa na latência ao fazer parceria com o Fireworks para ajustar os modelos.

Preços

Fireworks AI oferece opções de preços flexíveis para atender a diferentes necessidades. Os detalhes podem ser encontrados em sua página de Preços.

Começando

Para começar a construir com o Fireworks AI, visite seu site e explore os modelos e a documentação disponíveis. Você também pode entrar em contato com sua equipe de vendas para soluções empresariais.

Qual é a melhor maneira de aproveitar o Fireworks AI? Para maximizar os benefícios do Fireworks AI, comece identificando seu caso de uso específico e selecionando o modelo de código aberto apropriado. Utilize os SDKs do Fireworks para ajustar o modelo e otimizá-lo para sua aplicação. Aproveite os recursos de escalonamento da plataforma para implementar seus recursos de IA globalmente sem gerenciar a infraestrutura.

Ao fornecer um mecanismo de inferência robusto e escalonável, o Fireworks AI capacita desenvolvedores e empresas a aproveitar o poder da IA generativa com velocidade e eficiência sem precedentes.

Melhores ferramentas alternativas para "Fireworks AI"

Friendli Inference é o mecanismo de inferência LLM mais rápido, otimizado para velocidade e custo-benefício, reduzindo os custos de GPU em 50-90%, oferecendo alto rendimento e baixa latência.

Firecrawl é a API líder de rastreamento, raspagem e busca na web projetada para aplicativos de IA. Ela transforma sites em dados limpos, estruturados e prontos para LLM em escala, alimentando agentes de IA com extração web confiável sem proxies ou dores de cabeça.

vLLM é um mecanismo de inferência e serviço de alto rendimento e com eficiência de memória para LLMs, apresentando PagedAttention e processamento em lote contínuo para desempenho otimizado.

Private LLM é um chatbot de IA local para iOS e macOS que funciona offline, mantendo suas informações completamente no dispositivo, seguras e privadas. Desfrute de bate-papo sem censura no seu iPhone, iPad e Mac.

AI Runner é um mecanismo de inferência de IA offline para arte, conversas de voz em tempo real, chatbots alimentados por LLM e fluxos de trabalho automatizados. Execute geração de imagens, chat de voz e muito mais localmente!

OpenUI é uma ferramenta de código aberto que permite descrever componentes de UI em linguagem natural e renderizá-los ao vivo usando LLMs. Converta descrições em HTML, React ou Svelte para prototipagem rápida.

Groq oferece uma plataforma de hardware e software (LPU Inference Engine) para inferência de IA rápida, de alta qualidade e com baixo consumo de energia. GroqCloud fornece soluções de nuvem e on-premise para aplicações de IA.

Botpress é uma plataforma completa de agentes de IA alimentada pelos LLMs mais recentes. Ele permite que você construa, implemente e gerencie agentes de IA para suporte ao cliente, automação interna e muito mais, com recursos de integração perfeitos.

mistral.rs é um motor de inferência LLM incrivelmente rápido escrito em Rust, com suporte a fluxos de trabalho multimodais e quantização. Oferece APIs Rust, Python e servidor HTTP compatível com OpenAI.

PocketLLM é um mecanismo de busca de conhecimento de IA privado da ThirdAI. Pesquise em PDFs, documentos e URLs localmente em seu dispositivo. Ajuste os resultados e resuma para facilitar a compreensão.

Spice.ai é um mecanismo de inferência de dados e IA de código aberto para construir aplicativos de IA com federação de consultas SQL, aceleração, busca e recuperação baseadas em dados empresariais.

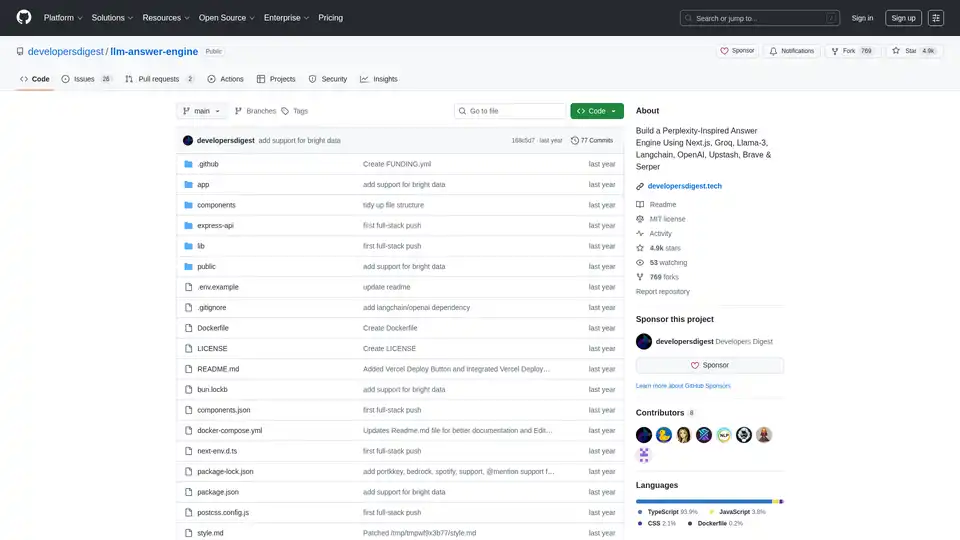

Construa um mecanismo de resposta de IA inspirado no Perplexity usando Next.js, Groq, Llama-3 e Langchain. Obtenha fontes, respostas, imagens e perguntas de acompanhamento de forma eficiente.

ExLlama é uma implementação Python/C++/CUDA independente e com eficiência de memória de Llama para inferência rápida com pesos quantizados GPTQ de 4 bits em GPUs modernas.

SaladCloud oferece nuvem GPU distribuída, acessível, segura e orientada pela comunidade para inferência de IA/ML. Economize até 90% nos custos de computação. Ideal para inferência de IA, processamento em lote e muito mais.