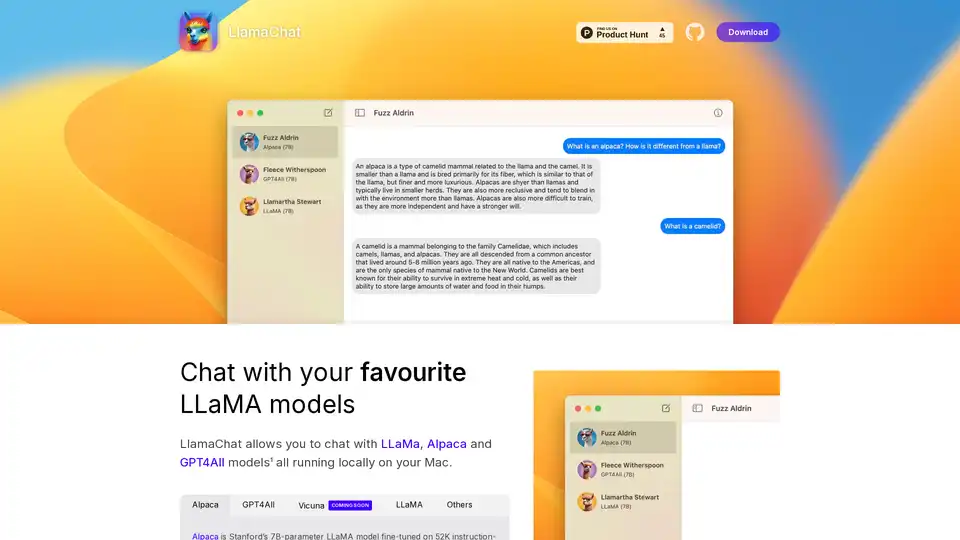

LlamaChat

Visão geral de LlamaChat

LlamaChat: Converse com Modelos LLaMA Locais no Seu Mac

O que é o LlamaChat? LlamaChat é um aplicativo para macOS que permite aos usuários interagir com vários Modelos de Linguagem Grandes (LLMs) como LLaMA, Alpaca e GPT4All diretamente no seu Mac, sem depender de serviços baseados na nuvem. Isso significa que os modelos são executados localmente, oferecendo maior privacidade e controle.

Principais Recursos e Funcionalidades

- Suporte Local para LLM: LlamaChat suporta múltiplos LLMs, incluindo LLaMA, Alpaca e GPT4All, todos executados localmente no seu Mac.

- Conversão de Modelo: LlamaChat pode importar pontos de verificação de modelo PyTorch brutos ou arquivos de modelo .ggml pré-convertidos para facilitar o uso.

- Código Aberto: Impulsionado por bibliotecas de código aberto como llama.cpp e llama.swift, garantindo transparência e desenvolvimento orientado pela comunidade.

- Gratuito e de Código Aberto: LlamaChat é completamente gratuito e de código aberto, garantindo acessibilidade e contribuição da comunidade.

Modelos Suportados

- Alpaca: Modelo LLaMA de 7B parâmetros da Stanford, ajustado em 52 mil demonstrações de seguimento de instruções geradas a partir do text-davinci-003 da OpenAI.

- GPT4All: Um LLM de código aberto.

- Vicuna: Um LLM de código aberto.

- LLaMA: O LLM fundamental da Meta.

Como o LlamaChat funciona?

LlamaChat utiliza bibliotecas de código aberto para executar LLMs diretamente na sua máquina. Ele é construído usando llama.cpp e llama.swift. Isso permite que você converta e importe pontos de verificação de modelo PyTorch brutos ou arquivos de modelo .ggml pré-convertidos.

Como usar o LlamaChat?

- Baixar: Baixe o LlamaChat do site oficial ou usando

brew install --cask llamachat. - Instalar: Instale o aplicativo no seu macOS 13 ou posterior.

- Importar Modelos: Importe seus modelos LLaMA, Alpaca ou GPT4All para o aplicativo.

- Conversar: Comece a conversar com seus modelos LLM favoritos localmente.

Por que escolher o LlamaChat?

- Privacidade: Execute modelos localmente sem enviar dados para servidores externos.

- Controle: Controle total sobre os modelos e dados utilizados.

- Custo-Efetivo: Sem taxas de assinatura ou encargos de uso.

- Código Aberto: Beneficie-se das melhorias orientadas pela comunidade e da transparência.

Para quem é o LlamaChat?

LlamaChat é ideal para:

- Desenvolvedores: Experimentar com LLMs em máquinas locais.

- Pesquisadores: Realizar pesquisas sem depender de serviços externos.

- Usuários Conscientes da Privacidade: Usuários que desejam manter seus dados locais e privados.

Instalação

LlamaChat pode ser instalado via:

- Download: Diretamente da página do GitHub do projeto ou Product Hunt.

- Homebrew: Usando o comando

brew install --cask llamachat.

Bibliotecas de Código Aberto

LlamaChat é construído em:

- llama.cpp: Para inferência eficiente de LLMs em CPU.

- llama.swift: Fornecendo uma interface macOS nativa para LLMs.

Isenção de Responsabilidade

LlamaChat não é afiliado à Meta Platforms, Inc., Leland Stanford Junior University ou Nomic AI, Inc. Os usuários são responsáveis por obter e integrar os arquivos de modelo apropriados de acordo com os respectivos termos e condições estabelecidos por seus fornecedores.

Melhores ferramentas alternativas para "LlamaChat"

Private LLM é um chatbot de IA local para iOS e macOS que funciona offline, mantendo suas informações completamente no dispositivo, seguras e privadas. Desfrute de bate-papo sem censura no seu iPhone, iPad e Mac.

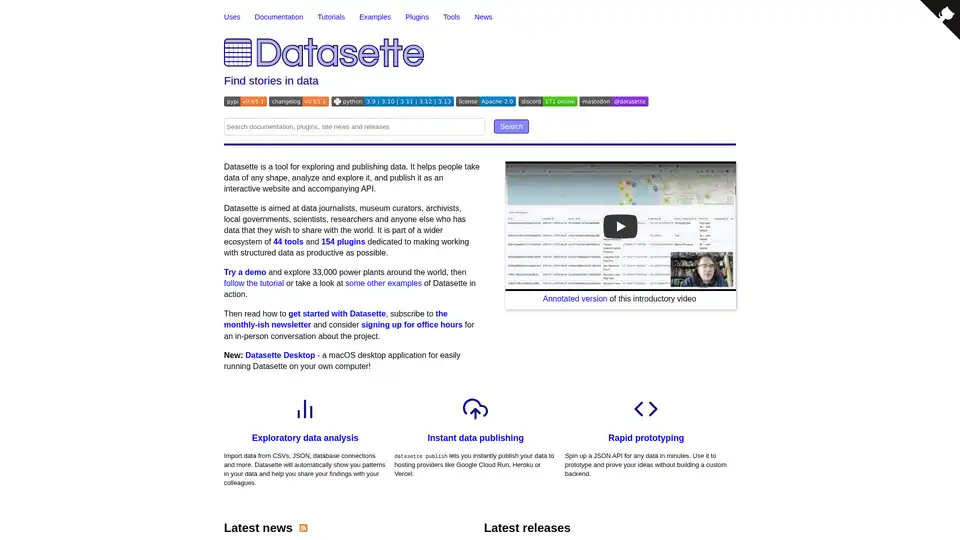

Datasette é uma ferramenta de código aberto para explorar e publicar dados. Ajuda a analisar dados, criar sites interativos e APIs, e é ideal para jornalistas de dados, pesquisadores e qualquer pessoa que compartilhe dados.

Nexa SDK permite inferência de IA rápida e privada no dispositivo para modelos LLM, multimodais, ASR e TTS. Implante em dispositivos móveis, PCs, automotivos e IoT com desempenho pronto para produção em NPU, GPU e CPU.

Enclave AI é um assistente de IA com foco na privacidade para iOS e macOS que é executado completamente offline. Ele oferece processamento LLM local, conversas seguras, chat de voz e interação com documentos sem a necessidade de uma conexão com a Internet.

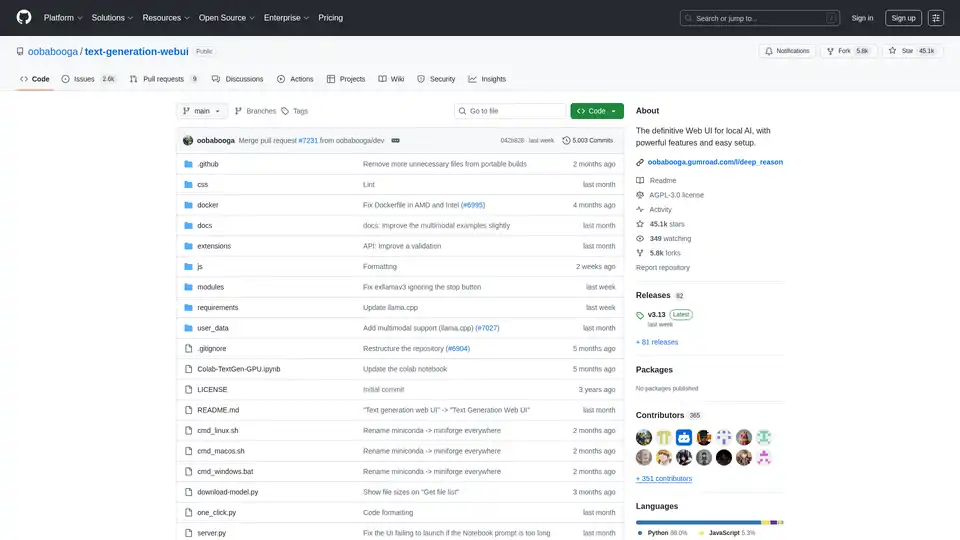

Text Generation Web UI é uma interface web Gradio poderosa e fácil de usar para modelos de linguagem grandes de IA local. Suporta múltiplos backends, extensões e oferece privacidade offline.

Repo Prompt aprimora a codificação assistida por IA com engenharia de contexto visual, mapas de código e integração do servidor MCP, permitindo interações de IA mais rápidas e precisas com sua base de código. Perfeito para desenvolvedores que usam ferramentas de IA.

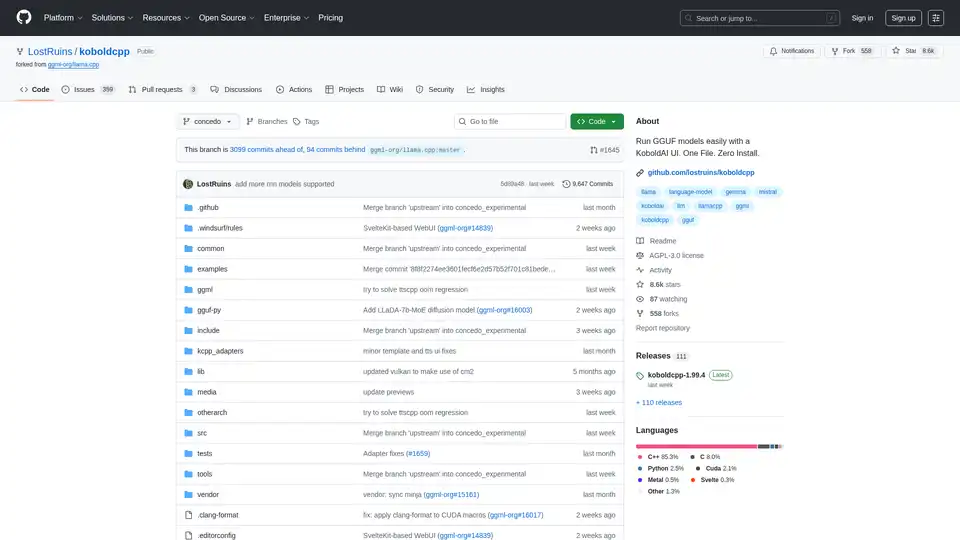

KoboldCpp: Execute modelos GGUF facilmente para geração de texto e imagem com IA usando uma interface KoboldAI. Arquivo único, instalação zero. Suporta CPU/GPU, STT, TTS e Stable Diffusion.

Remind AI é uma ferramenta de memória artificial local de código aberto que captura suas atividades digitais usando IA avançada, aumentando a produtividade sem dependência de nuvem. Baixe e personalize para uso pessoal.

GrammarBot é um verificador de gramática e ortografia com IA para MacOS que funciona offline. Baixe o aplicativo e o modelo de IA uma vez e melhore seu inglês para sempre. Licença pessoal $12.

AnythingLLM é um aplicativo de IA tudo-em-um que permite que você converse com seus documentos, melhore sua produtividade e execute LLMs de última geração localmente e de forma privada. Aproveite os agentes de IA e modelos personalizados sem qualquer configuração.

Warp é uma plataforma de agentes de IA que permite executar vários agentes em paralelo para concluir qualquer tarefa de desenvolvimento, oferecendo um agente de codificação e terminal que dobra sua produção.

LM Studio: Execute LLaMa, MPT, Gemma e outros LLMs localmente em seu laptop. Baixe modelos compatíveis do Hugging Face e use-os offline.

RecurseChat: Um aplicativo de IA pessoal que permite conversar com IA local, offline e conversar com arquivos PDF e markdown.

MacCopilot: Copilot AI nativo para macOS. Interaja com qualquer conteúdo da tela usando GPT-4o, ClaudeAI e Google Gemini.