Mindgard

Visão geral de Mindgard

Mindgard: Red Teaming e Testes de Segurança de IA Automatizados

O que é Mindgard?

Mindgard é uma solução de teste de segurança de IA que ajuda as organizações a proteger seus sistemas de IA contra ameaças emergentes. As ferramentas tradicionais de segurança de aplicativos não conseguem lidar com os riscos exclusivos associados à IA, tornando o Mindgard uma camada de proteção necessária.

Como o Mindgard funciona?

A solução Offensive Security for AI da Mindgard usa red teaming automatizado para identificar e resolver riscos específicos de IA que só são detectáveis durante o tempo de execução. Ela se integra à automação CI/CD existente e a todas as etapas do SDLC. Conectar o Mindgard ao seu sistema de IA requer apenas um endpoint de inferência ou API para integração do modelo. A plataforma suporta uma ampla gama de modelos de IA, incluindo Generative AI, LLMs, NLP, áudio, imagem e sistemas multi-modais.

Por que o Mindgard é importante?

A implantação e o uso de IA introduzem novos riscos que as ferramentas de segurança tradicionais não conseguem lidar. Muitos produtos de IA são lançados sem segurança adequada, deixando as organizações vulneráveis. A pesquisa do Gartner indica que 29% das empresas com sistemas de IA já relataram violações de segurança, mas apenas 10% dos auditores internos têm visibilidade sobre o risco de IA.

Principais Características e Benefícios

- Red Teaming Automatizado: Simula ataques a sistemas de IA para identificar vulnerabilidades sem intervenção manual.

- Identificação de Riscos Específicos de IA: Identifica e resolve riscos específicos de IA, como jailbreaking, extração, evasão, inversão, envenenamento e injeção de prompt.

- Testes de Segurança Contínuos: Fornece testes de segurança contínuos em todo o AI SDLC.

- Integração com Sistemas Existentes: Integra-se aos sistemas de relatórios e SIEM existentes.

- Cobertura Extensa: Funciona com vários modelos de IA e guardrails, incluindo LLMs como OpenAI, Claude e Bard.

Casos de Uso

- Protegendo Sistemas de IA: Protege sistemas de IA contra novas ameaças que as ferramentas tradicionais de segurança de aplicativos não conseguem lidar.

- Identificando Vulnerabilidades de IA: Descobre e mitiga vulnerabilidades de IA, permitindo que os desenvolvedores construam sistemas seguros e confiáveis.

- Garantia de Segurança Contínua: Fornece testes de segurança contínuos e red teaming de IA automatizado em todo o ciclo de vida da IA.

Que tipos de riscos o Mindgard descobre?

O Mindgard identifica vários riscos de segurança de IA, incluindo:

- Jailbreaking: Manipulação de entradas para fazer com que os sistemas de IA executem ações não intencionais.

- Extração: Reconstrução de modelos de IA para expor informações confidenciais.

- Evasão: Alteração de entradas para enganar modelos de IA em saídas incorretas.

- Inversão: Engenharia reversa de modelos para descobrir dados de treinamento.

- Envenenamento: Adulteração de dados de treinamento para manipular o comportamento do modelo.

- Prompt Injection: Inserção de entradas maliciosas para enganar sistemas de IA em respostas não intencionais.

Prêmios e Reconhecimento

- Vencedor de Melhor Solução de IA e Melhor Nova Empresa no SC Awards Europe 2025.

- Destaque no TechCrunch, Sifted e outras publicações.

FAQs

- O que diferencia o Mindgard de outras empresas de segurança de IA? O Mindgard possui mais de 10 anos de pesquisa rigorosa em segurança de IA, garantindo acesso aos mais recentes avanços e talentos qualificados.

- O Mindgard consegue lidar com diferentes tipos de modelos de IA? Sim, o Mindgard é agnóstico em relação a redes neurais e suporta uma ampla gama de modelos de IA.

- Como o Mindgard garante a segurança e privacidade dos dados? O Mindgard segue as melhores práticas do setor para desenvolvimento e operação de software seguro, incluindo o uso de nossa própria plataforma para testar componentes de IA. Estamos em conformidade com o GDPR e esperamos a certificação ISO 27001 no início de 2025.

- O Mindgard consegue trabalhar com os LLMs que uso hoje? Absolutamente. O Mindgard foi projetado para proteger IA, Generative AI e LLMs, incluindo modelos populares como ChatGPT.

- Que tipos de organizações usam o Mindgard? O Mindgard atende a uma gama diversificada de organizações, incluindo aquelas em serviços financeiros, saúde, manufatura e segurança cibernética.

- Por que as ferramentas tradicionais de AppSec não funcionam para modelos de IA? A implantação e o uso de IA introduzem novos riscos que as ferramentas tradicionais não conseguem lidar. Muitos desses novos riscos, como injeção de prompt LLM e jailbreaks, exploram a natureza probabilística e opaca dos sistemas de IA, que só se manifestam em tempo de execução. Proteger esses riscos requer uma abordagem fundamentalmente nova.

Conclusão

O Mindgard é uma solução abrangente de teste de segurança de IA que ajuda as organizações a proteger seus sistemas de IA contra ameaças emergentes. Com seus recursos automatizados de red teaming, identificação de riscos específicos de IA e testes de segurança contínuos, o Mindgard permite que os desenvolvedores construam sistemas de IA seguros e confiáveis. Ao integrar o Mindgard ao AI SDLC, as organizações podem garantir que seus modelos e aplicativos de IA operem de forma segura e confiável.

Gestão de Tarefas e Projetos com IA Resumo de Documentos e Leitura com IA Pesquisa Inteligente com IA Análise de Dados com IA Fluxo de Trabalho Automatizado

Melhores ferramentas alternativas para "Mindgard"

Autoblocks AI é uma plataforma que permite que as equipes construam, testem e implementem aplicativos de IA confiáveis, particularmente em setores de alto risco, com recursos como geração dinâmica de casos de teste e métricas de avaliação alinhadas com PMEs.

Autoblocks AI ajuda as equipes a construir, testar e implantar aplicativos de IA confiáveis com ferramentas para colaboração perfeita, avaliações precisas e fluxos de trabalho simplificados. Forneça soluções de IA com confiança.

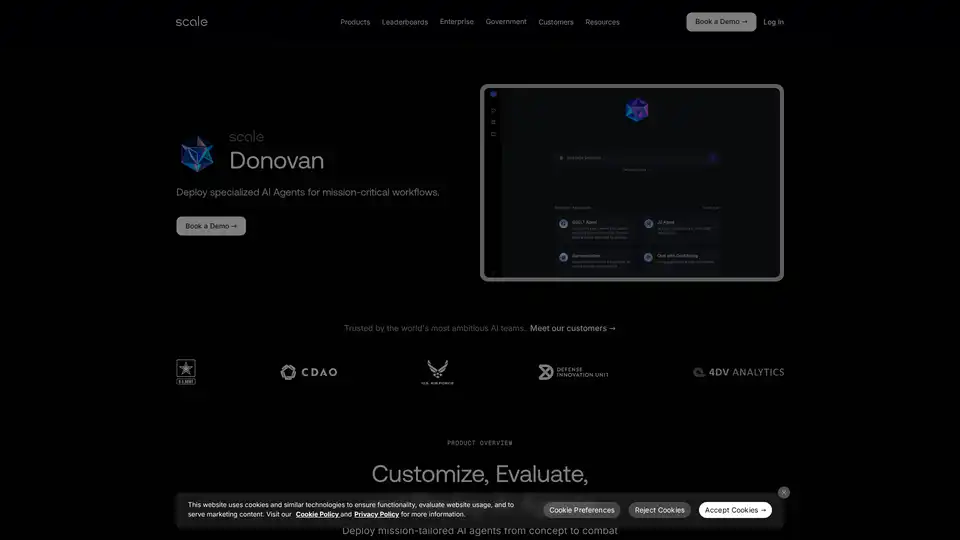

Scale Donovan implanta agentes de IA especializados para fluxos de trabalho críticos do setor público com personalização sem código, testes rigorosos e implantação segura em redes classificadas.

Hamming AI oferece testes automatizados, análise de chamadas e governança para agentes de voz de IA. Simule chamadas, audite conversas e detecte regressões com facilidade.