Deploud 概述

Deploud:简化您的 Docker 镜像部署到 Google Cloud Run

什么是 Deploud?

Deploud 是一款旨在简化 Docker 镜像部署到 Google Cloud Run 的工具。它面向希望通过单一简单命令自动化云部署的个人开发者及中小型团队。Deploud 让您无需翻阅复杂文档或处理晦涩错误,即可搭建、定制并拥有自己的部署脚本,确保完全控制并未来验证您的云服务。

Deploud 如何工作?

Deploud 通过生成一个包含所有必要部署文件的 .zip 文件来工作,其中包括:

- cli: 命令行界面工具。

- pulumi: 用于管理云资源的基础设施即代码工具。

- scripts: 部署和删除脚本。

- gen.bash: 安装 CLI 工具和配置权限的脚本。

- del.bash: 删除云资源的脚本。

- config.json: 配置文件。

这些脚本自动化以下操作:

- 安装所需的 CLI 工具(gcloud、expect、docker、jq、pulumi、golang)。

- 在 GCloud 中配置必要权限。

- 搭建用于基础设施部署的 Pulumi 脚本。

生成的脚本是幂等的,意味着您可以多次运行它们而不会创建重复资源。

如何使用 Deploud?

- 创建新项目: 提供您的项目名称,并选择要部署到的服务(Cloud Run、AWS Lambda 或 Azure Functions)。

- 创建脚本: 下载生成的

.zip文件并将其解压到您的项目目录中。 - 运行代码: 导航到解压文件的目录并执行

bash gen.bash。 - 运行 Pulumi: 导航到 Pulumi 文件夹并运行

pulumi up以部署您的应用程序。 - 删除云资源: 要移除已部署的资源,请运行

bash del.bash。

为什么 Deploud 很重要?

Deploud 解决了云部署中的常见痛点,例如:

- 节省工程时间: 自动化基础设施设置,让开发者专注于交付价值。

- 避免文档过载: 提供简化的部署流程,无需零散的文档。

- 处理云服务细节: 管理云服务 API 和安全限制的复杂性。

- 确保控制权: 提供完全可定制的脚本,确保您保留对部署过程的完全控制。

Deploud 适合谁?

Deploud 非常适合:

- 个人及中小型团队: 希望自动化云部署的用户。

- 开发者: 希望节省工程时间并避免基础设施麻烦的用户。

- 团队: 希望完全控制其云服务并能够自定义部署脚本的用户。

主要功能与优势:

- 自动化部署: 通过单一命令将 Docker 镜像部署到 Google Cloud Run。

- 可定制脚本: 提供对部署脚本的完全控制,可修改并保留。

- 基础设施即代码: 使用 Pulumi 进行基础设施管理,确保一致性和可重复性。

- 幂等脚本: 防止创建重复资源,确保可靠部署。

- 多云支持: 支持部署到 Google Cloud Run、AWS Lambda 和 Azure Functions。

简单定价

Deploud 提供免费层和具有额外功能的付费层。免费层包括已验证脚本、与云提供商的项目创建、设置具有最小权限的服务账户、搭建 Pulumi 基础设施代码、内置幂等性以及支持一个环境(暂存)。

Deploud 的不同之处?

与其他服务不同,Deploud 让您完全控制部署脚本,允许您根据特定需求进行定制。它通过提供简化且自动化的部署流程,与使用 Pulumi 和 Terraform 等基础设施即代码(IaaC)工具有所不同。Deploud 生成已验证脚本并确保最小权限,其已验证脚本可处理晦涩的错误消息。

系统要求

Deploud 需要支持 bash 的环境,例如 Windows Subsystem for Linux (WSL)、Linux 或 MacOS。

- Windows Subsystem for Linux (WSL)

- MacOS

- Linux

客户反馈

Deploud 致力于持续改进并重视用户反馈。您可以通过 GitHub 仓库或直接联系 Deploud 团队提供反馈。

通过自动化部署流程并提供完全可定制的脚本,Deploud 使开发者能够专注于构建并为客户交付价值。

"Deploud"的最佳替代工具

ClawCloud Run是一个高性能云原生部署平台,具有集成GitOps工作流、Docker/Kubernetes支持、GitHub集成和AI自动化工具。

使用 llama.cpp 实现高效的 LLM 推理,这是一个为各种硬件优化的 C/C++ 库,支持量化、CUDA 和 GGUF 模型。 非常适合本地和云部署。

AutoGPT是一个开源平台,用于构建、部署和管理自动化复杂工作流程的AI代理。自定义代理或使用预配置的代理。是AI工作流程自动化的理想选择。

Bytebot 是一款开源 AI 桌面代理,通过使用虚拟计算机自动执行跨多个应用程序的任务。 可将代理从一个扩展到数百个并行运行,并与任何软件集成。

Lunary 是一个开源 LLM 工程平台,提供可观测性、提示管理和分析功能,用于构建可靠的 AI 应用程序。它提供调试、跟踪性能和确保数据安全的工具。

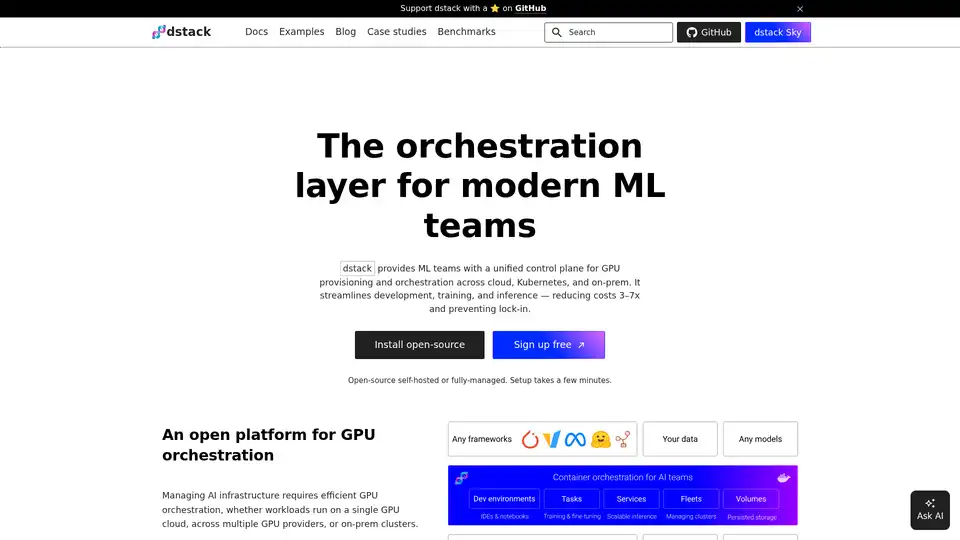

dstack 是一个开源 AI 容器编排引擎,为 ML 团队提供统一的控制平面,用于在云、Kubernetes 和本地环境中进行 GPU 资源调配和编排。简化开发、训练和推理。

Phala Cloud 提供了一个无信任的开源云基础设施,用于部署 AI 代理和 Web3 应用程序,由 TEE 提供支持。 它确保隐私、可扩展性,并由代码管理。

Denvr Dataworks 提供高性能 AI 计算服务,包括按需 GPU 云、AI 推理和私有 AI 平台。 使用 NVIDIA H100、A100 和 Intel Gaudi HPU 加速您的 AI 开发。

Inferless提供快速的无服务器GPU推理,用于部署ML模型。它具有自动扩展、动态批处理和企業级安全等功能,可实现可扩展、轻松的自定义机器学习模型部署。