Deployo 概述

Deployo:几分钟内将模型部署为 API

什么是 Deployo?

Deployo 是一个 AI 基础设施平台,旨在简化机器学习工作流程,使用户能够在几分钟内部署 AI 模型,将其作为实时、可扩展的 API 投入生产。它抽象化了部署的复杂性,使数据科学家和机器学习工程师能够专注于构建和改进他们的模型。

Deployo 如何工作?

Deployo 通过一个直观、云无关且安全的平台简化了部署过程。用户可以从任何框架引入任何 ML 模型,只需点击几下即可部署。Deployo 自动化了部署脚本的创建,管理网络策略,优化 GPU 性能,并提供 Swagger 终端文档。

主要特性和优势:

- 轻松部署: 只需点击几下即可部署模型,无需复杂的部署脚本或 DevOps 技能。

- 云无关: 部署到任何云提供商或本地环境,而不会被供应商锁定。

- 通用: 支持任何 ML 模型,并与 Weights & Biases 和 Hugging Face 等常用工具集成。

- 可扩展: 根据使用情况自动向上或向下扩展计算资源,优化资源分配和成本。

- 安全: 提供具有自动网络策略管理的安全环境。

核心功能:

- 模型到 API: 自动将您的模型转换为实时、可扩展的 API。

- GPU 优化性能: 优化 GPU 加速模型的性能。

- Swagger 终端文档: 自动生成 API 文档。

- 自动网络策略管理: 提供安全的网络配置。

- 部署策略: 提供各种部署策略以适应不同的需求。

- 自动版本兼容性: 确保您的模型不同版本之间的兼容性。

- 云无关部署: 部署到任何地方,无论是公有云还是内部服务器。

- 对本地 VM 友好: 轻松部署到本地虚拟机。

- 企业就绪环境: 适合企业级部署。

- 多模型链接: 支持将多个模型链接在一起。

- 自定义 Python 包支持: 允许使用自定义 Python 包。

- 水平和垂直自动缩放: 根据需求自动缩放资源。

- 无服务器部署选项: 提供无服务器部署选项。

- 负载感知分配: 根据负载分配流量。

- 请求批处理支持: 支持批处理请求以提高性能。

使用案例:

- 快速原型设计: 快速部署模型以进行测试和验证。

- 生产部署: 部署模型以用于生产,具有可扩展性和可靠性。

- 内部工具: 部署模型以供组织内部使用。

如何开始使用 Deployo?

Deployo 即将推出。您可以联系他们的销售团队以获取更多信息和提前访问权限。

常见问题解答:

- 我可以使用 Deployo 做什么? 您可以快速将 AI 模型部署到生产中,作为可扩展的 API。

- 使用 Deployo 我能获得什么好处? 您可以通过自动化部署过程来节省时间和资源。

- Deployo 如何帮助我与我的团队协作? Deployo 提供了用于协作和版本控制的工具。

- 我可以信任 Deployo 的数据吗? 是的,Deployo 为您的数据提供了一个安全的环境。

- 我可以使用 Deployo 将我的 AI 模型部署到任何地方吗? 是的,Deployo 是云无关的,并支持本地部署。

- Deployo 如何帮助我实现更好的业务成果? Deployo 帮助您更快地部署模型,从而使您可以更快地迭代和改进您的模型。

"Deployo"的最佳替代工具

Nebius AI Studio Inference Service 提供托管开源模型,实现比专有 API 更快、更便宜、更准确的推理结果。无需 MLOps,即可无缝扩展,适用于 RAG 和生产工作负载。

新一代企业级AI构建工作室,用于训练、验证、调优和部署AI模型。探索IBM watsonx.ai的集成工具,实现可扩展的生成式AI开发。

Labellerr 是一款数据标注和图像注释软件,为人工智能和机器学习提供高质量、可扩展的数据标注。它提供自动化注释、高级分析和智能质量保证,以帮助 AI 团队更快、更准确地准备数据。

LandingAI 是一个视觉 AI 平台,通过先进的 AI 和深度学习来改变计算机视觉。使用 LandingLens 自动化文档处理并构建计算机视觉模型。

Kortical是一个专为数据科学家设计的AI平台,提供AutoML和ML Ops功能,可快速构建和部署企业级AI解决方案。 它支持代码和UI界面,从而促进更快的迭代和更好的模型性能。

Union.ai 通过编排工作流程、优化成本和大规模管理非结构化数据,简化您的 AI 开发生命周期。它基于 Flyte 构建,可帮助您构建可用于生产的 AI 系统。

Batteries Included是一个自托管的AI平台,简化了LLM、向量数据库和Jupyter Notebook的部署。在您的基础设施上构建世界一流的AI应用。

deepsense.ai 提供定制AI软件开发和咨询服务,专注于LLM、MLOps、计算机视觉和AI驱动的自动化,以推动业务增长。与值得信赖的AI专家合作。

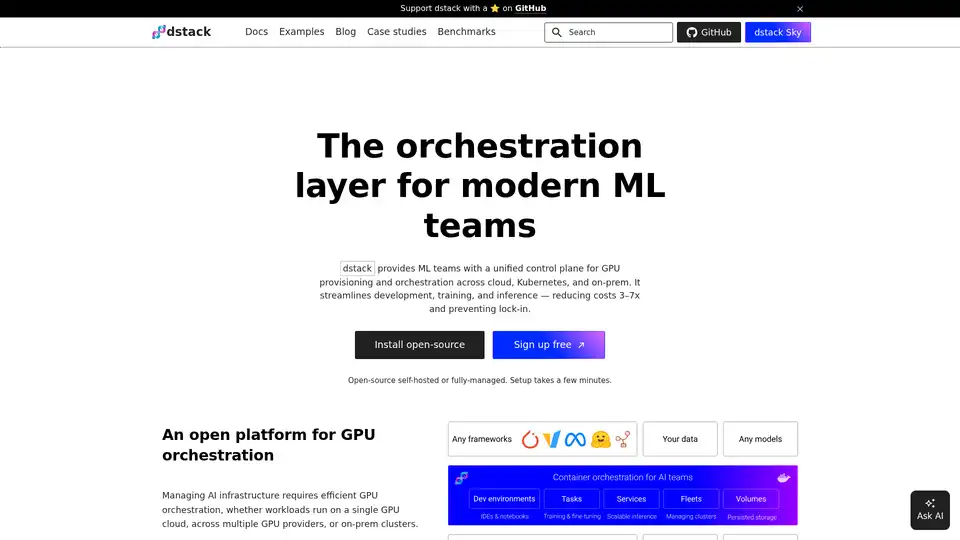

dstack 是一个开源 AI 容器编排引擎,为 ML 团队提供统一的控制平面,用于在云、Kubernetes 和本地环境中进行 GPU 资源调配和编排。简化开发、训练和推理。