Nebius AI Studio Inference Service 概述

Nebius AI Studio Inference Service 是什么?

Nebius AI Studio Inference Service 是一个强大的平台,旨在帮助开发者和企业使用企业级性能运行最先进的开源 AI 模型。作为 Nebius 的关键产品推出,它简化了大型语言模型 (LLM) 在推理任务中的部署,消除了复杂的 MLOps 设置需求。无论您是在构建 AI 应用、原型,还是扩展到生产,这个服务都为热门模型如 Meta 的 Llama 系列、DeepSeek-R1 和 Mistral 变体提供端点,确保高准确性、低延迟和成本效率。

在其核心,该服务在欧洲(芬兰)的优化基础设施上托管这些模型,利用高效的 serving 管道。这种设置保证了超低延迟,特别是首次令牌响应时间,使其适合实时应用,如聊天机器人、RAG(Retrieval-Augmented Generation)和上下文 AI 场景。用户受益于无限可扩展性,这意味着您可以从初始测试无缝过渡到高负载生产,而不会遇到性能瓶颈或隐藏限制。

Nebius AI Studio Inference Service 如何工作?

该服务通过一个简单的 API 运行,与熟悉的库如 OpenAI 的 SDK 兼容,使已经使用类似工具的开发者的集成无缝。要开始,请注册免费积分并访问 Playground——一个用户友好的 Web 界面,用于无代码测试模型。从那里,您可以切换到 API 调用以进行程序化使用。

以下是使用 Python 与其交互的基本示例:

import openai

import os

client = openai.OpenAI(

api_key=os.environ.get("NEBIUS_API_KEY"),

base_url='https://api.studio.nebius.com/v1'

)

completion = client.chat.completions.create(

messages=[{'role': 'user', 'content': 'What is the answer to all questions?'}],

model='meta-llama/Meta-Llama-3.1-8B-Instruct-fast'

)

此代码片段演示了查询如 Meta-Llama-3.1-8B-Instruct 的模型在 'fast' 模式下,提供快速响应。该服务支持两种变体:'fast' 用于速度关键任务的付费模式,以及 'base' 用于经济型处理,适合批量工作负载。所有模型都经过严格测试以验证质量,确保输出在 Llama-405B 的基准测试中媲美专有模型如 GPT-4o,并可节省高达 3 倍的输入令牌。

数据安全是首要考虑,位于芬兰的服务器遵守严格的欧洲法规。数据不会不必要地离开基础设施,用户可以通过自助控制台或支持团队请求专用实例以增强隔离。

核心功能和主要优势

Nebius AI Studio 以几项关键功能脱颖而出,这些功能解决了 AI 推理中的常见痛点:

无限可扩展性保证:无配额或节流运行模型。从原型无缝扩展到生产,轻而易举处理多样化工作负载。

成本优化:仅为使用付费,比竞争对手输入令牌便宜高达 3 倍。灵活计划从 1 美元免费积分开始,'base' 变体等选项为 RAG 和长上下文应用保持低成本。

超低延迟:优化管道提供快速首次令牌时间,尤其在欧洲。基准结果显示即使在复杂推理任务中也优于竞争对手。

验证的模型质量:每个模型在数学、代码、推理和多语言能力方面进行准确性测试。可用模型包括:

- Meta Llama-3.3-70B-Instruct:128k 上下文,增强文本性能。

- Meta Llama-3.1-405B-Instruct:128k 上下文,与 GPT-4 相当的强大。

- DeepSeek-R1:MIT 许可,在数学和代码中表现出色(128k 上下文)。

- Mixtral-8x22B-Instruct-v0.1:MoE 模型用于编码/数学,多语言支持(65k 上下文)。

- OLMo-7B-Instruct:完全开源,带有已发布训练数据(2k 上下文)。

- Phi-3-mini-4k-instruct:推理强大(4k 上下文)。

- Mistral-Nemo-Instruct-2407:紧凑但优于更大模型(128k 上下文)。

更多模型定期添加——请在 Playground 检查最新模型。

无需 MLOps:预配置基础设施意味着您专注于构建,而不是管理服务器或部署。

简单 UI 和 API:Playground 提供无代码环境用于实验,而 API 支持轻松集成到应用中。

这些功能使服务不仅高效,而且易于访问,并有基准测试支持显示如 Llama-405B 模型的更好速度和成本。

Nebius AI Studio Inference Service 适合谁?

此服务针对广泛用户,从原型化 AI 应用的个人开发者到处理大规模生产工作负载的企业。它非常适合:

应用构建者和初创公司:简化基础模型集成,无需高额基础设施成本。免费积分和 Playground 降低了入门门槛。

Gen AI、RAG 和 ML 推理企业:完美适用于生物技术、媒体、娱乐和金融等行业,需要可靠、可扩展的 AI 用于数据准备、微调或实时处理。

研究者和 ML 工程师:访问顶级开源模型,具有验证质量,支持推理、编码、数学和多语言应用任务。Research Cloud Credits 等程序为学术追求增添价值。

寻求成本效率的团队:厌倦昂贵专有 API 的企业将欣赏 3 倍令牌节省和灵活定价,尤其适用于上下文场景。

如果您处理生产工作负载,该服务确认它为此而建,提供通过请求表单自定义模型和专用实例的选项。

为什么选择 Nebius AI Studio 而非竞争对手?

在拥挤的 AI 景观中,Nebius 通过专注于开源卓越而脱颖而出。与将您锁定在供应商生态系统的专有 API 不同,Nebius 提供使用 Apache 2.0、MIT 和 Llama 特定条款等许可的模型自由——同时匹配或超过性能。用户在不牺牲速度或准确性的前提下节省成本,正如基准所示:在欧洲更快的首次令牌时间,并与 GPT-4o 相当的质量。

通过 X/Twitter、LinkedIn 和 Discord 的社区参与提供更新、技术支持和讨论,培养协作环境。对于注重安全的用户,欧洲托管确保合规,该服务避免不必要的数据跟踪。

如何开始使用 Nebius AI Studio

快速上手:

- 注册:创建账户并领取 1 美元免费积分。

- 探索 Playground:通过 Web UI 交互测试模型。

- 通过 API 集成:使用您的 API 密钥与 OpenAI 兼容端点。

- 扩展和优化:选择变体、请求模型,或联系销售处理企业需求。

- 监控和调整:跟踪使用以保持预算,选项包括专用资源。

对于自定义请求,登录并使用表单建议额外开源模型。定价透明——请查看 AI Studio 定价页面,了解基于速度 vs. 经济性的端点成本。

真实世界用例和实际价值

Nebius AI Studio 驱动多样化应用:

RAG 系统:经济型令牌处理用于搜索或知识库中的检索增强查询。

聊天机器人和助手:低延迟响应用于客户服务或虚拟代理。

代码生成和数学求解器:利用如 DeepSeek-R1 或 Mixtral 的模型用于开发者工具。

内容创建:Mistral 模型的多语言支持用于全球应用。

实际价值在于性能和负担能力的平衡,实现更快创新。用户报告无缝扩展和可靠输出,减少开发时间和成本。例如,在媒体和娱乐中,它加速 Gen AI 服务;在生物技术中,它支持无需 MLOps 开销的数据分析。

总之,Nebius AI Studio Inference Service 是寻求高性能开源 AI 推理的首选。它赋能用户轻松构建更智能的应用,通过效率和可扩展性提供真实 ROI。今天切换到 Nebius,体验速度、节省和简单性的不同。

"Nebius AI Studio Inference Service"的最佳替代工具

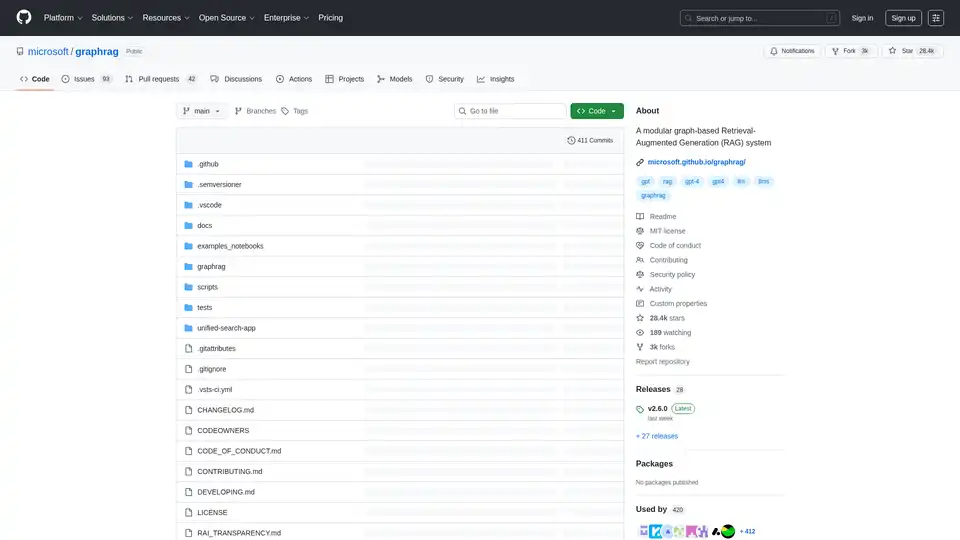

GraphRAG是一个开源的、模块化的基于图的检索增强生成系统,旨在利用大语言模型从非结构化文本中提取结构化数据。使用GraphRAG增强您的大语言模型的推理能力。

GPUX是一个无服务器GPU推理平台,可为StableDiffusionXL、ESRGAN和AlpacaLLM等AI模型实现1秒冷启动,具有优化的性能和P2P功能。

探索 AI Library,这是超过 2150 个神经网络和 AI 工具的综合目录,用于生成式内容创作。发现顶级 AI 艺术模型、文本到图像、视频生成工具等,提升您的创意项目。

OpenUI 是一个开源工具,让您用自然语言描述 UI 组件,并使用大语言模型实时渲染。将描述转换为 HTML、React 或 Svelte,实现快速原型设计。

Firecrawl 是专为 AI 应用设计的领先网页爬取、抓取和搜索 API。它将网站转化为干净、结构化的 LLM 就绪数据,支持大规模 AI 代理使用可靠的网页提取,无需代理或复杂问题。

ChatLLaMA 是基于 LLaMA 模型的 LoRA 训练 AI 助手,可在本地 GPU 上运行自定义个人对话。提供桌面 GUI,使用 Anthropic 的 HH 数据集训练,支持 7B、13B 和 30B 模型。

Falcon LLM 是 TII 的开源生成式大语言模型家族,包括 Falcon 3、Falcon-H1 和 Falcon Arabic 等,支持多语言、多模态 AI 应用,可在日常设备上高效运行。

免费在线试用DeepSeek V3,无需注册。这个强大的开源AI模型拥有671B参数,支持商业使用,并通过浏览器演示或GitHub本地安装提供无限访问。

Batteries Included是一个自托管的AI平台,简化了LLM、向量数据库和Jupyter Notebook的部署。在您的基础设施上构建世界一流的AI应用。