FILM Frame Interpolation 概述

什么是 FILM 帧插值?

FILM,全称为 Frame Interpolation for Large Motion,是 Google Research 开发的一种前沿神经网络,用于生成视频中的平滑中间帧,特别是那些涉及显著场景运动的视频。与依赖预训练网络进行光流或深度估计的传统方法不同,FILM 采用统一的单网络方法。这使得它高效且强大,能够直接从训练期间的帧三元组创建高质量插值。作为开源的 TensorFlow 2 实现,它对希望提升视频流畅度而无需复杂设置的开发者和研究人员来说易于访问。

该模型以其处理大规模场景运动的能力脱颖而出——想象快速移动的对象或动态相机平移——传统插值技术往往在此失败,产生伪影或模糊。通过在多尺度特征提取器中共享卷积权重,FILM 实现了最先进的基准分数,同时保持架构的轻量级,并可从基本输入训练。

FILM 如何工作?

在其核心,FILM 处理两个输入帧(frame1 和 frame2),以预测指定时间戳的中间帧。过程从多尺度特征提取阶段开始,其中卷积层在不同分辨率下分析输入,以捕获细微细节和更广泛的运动模式。然后,这些特征通过一系列上采样和混合操作融合和精炼,以生成输出帧或视频序列。

其创新的关键是避免外部依赖。传统的帧插值可能使用光流计算像素级对应,但 FILM 在其网络内隐式学习这些。在推理期间,您可以通过 'times_to_interpolate' 参数控制插值深度:设置为 1 以获得单个中点帧(在 t=0.5),或更高(最多 8)以获得完整的视频,帧数呈指数增长(总共 2^times_to_interpolate + 1,在 30 FPS)。这种递归调用确保了平滑过渡,即使在遮挡或快速变形等挑战性场景中。

2022 年的底层技术报告详细说明了该模型如何在多样化的视频数据集上训练,优化感知质量而非像素级精确度。这导致视觉上令人愉悦的输出,模仿人类感知,使其理想适用于超出原始合成的应用。

如何使用 FILM 帧插值?

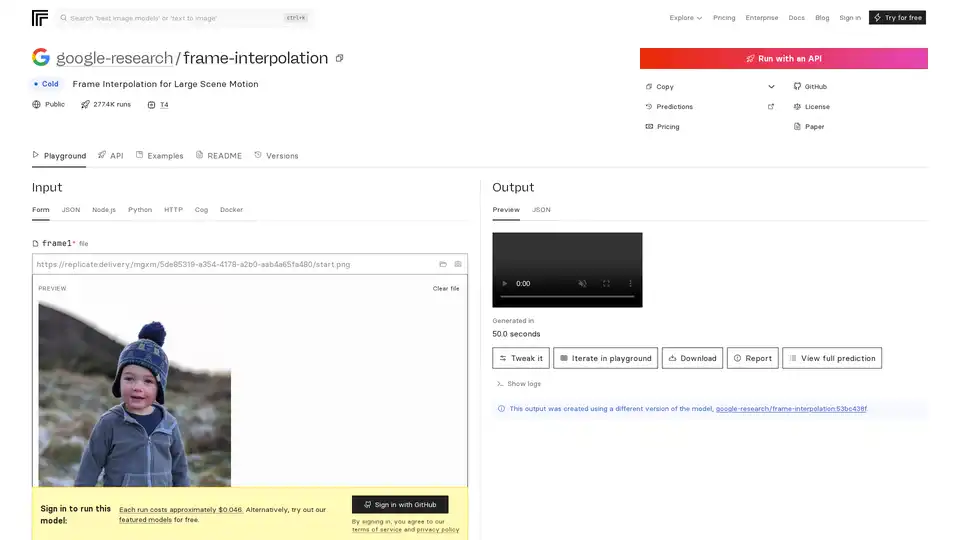

感谢其在 Replicate 等平台上的部署以及 GitHub 仓库用于本地运行,FILM 的入门非常简单。

通过 Replicate API:上传两个图像文件作为 frame1 和 frame2。调整 'times_to_interpolate'(默认 1)以定义输出复杂度。预测在 Nvidia T4 GPU 上运行,通常在 4 分钟内完成,每次运行成本约 $0.046(约 21 次运行每美元)。输出包括预览图像、可下载视频或 JSON 元数据。对于精选模型的免费试用无需登录,但 GitHub 登录可解锁完整访问。

使用 Docker 的本地设置:克隆 GitHub 仓库 https://github.com/google-research/frame-interpolation。使用 Docker 进行简单的环境隔离——拉取镜像并通过命令行运行预测,或集成到 Python/Node.js 脚本中。Cog 框架支持自定义输入,使其可扩展用于批量处理。

输入要求:帧应为顺序图像(例如 JPEG/PNG)。对于视频插值,递归处理对。支持 Webcam 捕获用于快速测试。

Replicate 上的示例展示了真实世界应用,如插值体育镜头或动画序列,演示无伪影结果。

为什么选择 FILM 用于您的项目?

FILM 在其他工具失效的地方表现出色,提供对大规模运动的优越处理,而无需多模型管道的计算开销。ECCV 2022 论文的基准分数突显其在插值 PSNR 和 SSIM 等指标上优于竞争对手。它采用宽松许可的开源,促进社区贡献——如 zsxkib/film-frame-interpolation-for-large-motion 等分支和相关模型将其适应视频特定任务。

成本效益是另一个吸引力:免费本地运行对比负担得起的云预测。此外,其 YouTube 演示和论文提供透明验证,建立对生产使用的信任。如果您处理来自无人机或动作摄像头的抖动低 FPS 视频,FILM 可轻松将其转化为电影般体验。

FILM 帧插值适合谁?

此工具针对 AI 爱好者、视频编辑者和专注于计算机视觉的机器学习从业者。

开发者和研究人员:理想用于在论文或原型中实验神经插值,尤其在视频压缩或动画等领域。

内容创作者:电影制作人和 YouTuber 可以提升帧率以获得更平滑播放,提升移动或网络视频,而无需昂贵硬件。

行业专业人士:在游戏中(例如帧率提升以获得更平滑动画)或监控中(插值稀疏镜头),FILM 的效率闪耀。由于预测时间,它不适合实时应用,但完美用于离线增强。

Replicate 上的相关模型,如 pollinations/rife-video-interpolation 或 zsxkib/st-mfnet,通过提供视频到视频工作流补充 FILM,但 FILM 对大规模运动的关注赋予其利基优势。

实际价值和用例

FILM 的真正力量在于其多功能性。在教育中,它有助于创建物理演示的慢动作分析。对于营销,插值产品镜头以展示流畅旋转。GitHub 的用户反馈赞扬其轻松处理真实镜头中常见的遮挡。

考虑一个案例:一位野生动物摄像师使用晃动的手持相机拍摄的 15 FPS 剪辑。使用 FILM,他们生成 30 FPS 输出,保留快速动物运动中的细节——将原始镜头转化为专业卷轴。

定价方案透明:Replicate 的按运行付费模型随使用量扩展,而自托管消除持续成本。对于常见问题,检查 README 以排查输入或版本差异(例如当前使用 google-research/frame-interpolation:53bc438f)。

总之,FILM 代表 Google 对媒体增强的可访问 AI 的承诺。无论您优化工作流还是推动研究边界,它都是优越帧插值的可靠选择。深入 GitHub 仓库或 Replicate playground 以查看其行动——您的视频将永不相同。

"FILM Frame Interpolation"的最佳替代工具

VideoProc Converter AI 是一款一站式 AI 媒体处理解决方案,支持视频/图像/音频增强、转换、编辑、压缩、下载和录制,并提供 GPU 加速。支持 4K/8K 视频、DVD 和在线媒体。

WinXDVD:用于 DVD 翻录、AI 视频增强和 iPhone 数据管理的多媒体解决方案。增强视频,快速翻录 DVD,轻松传输 iPhone 数据。受到全球数百万用户的信赖。

VIDIO通过AI简化视频编辑,减少编辑时间,使初学者也能轻松上手。功能包括AI驱动的动态图形、高光创建、对象转换和视频增强。兼容云存储和桌面编辑器。

使用HitPaw VikPea将视频质量增强到8K,这是一款AI视频增强器,只需单击一下即可对视频进行去模糊、恢复和着色。 体验快速、稳定和大规模的视频增强。

使用 Topaz Video 增强您的视频,这是一款由 AI 驱动的软件,用于升级、降噪、稳定和流畅素材。深受创意专业人士信赖,可获得电影级效果。

Cascadeur 是一款独立的 3D 动画软件,利用 AI 辅助关键帧动画。它提供自动姿势、自动物理和简易角色绑定等功能,以加快动画制作过程并产生高质量的结果。

Winxvideo AI 是一款综合性的 AI 视频工具包,可将视频/图像升级到 4K,稳定抖动视频,提高 fps,转换、压缩、编辑视频,并使用 GPU 加速录制屏幕。

AVCLabs视频增强AI采用先进AI技术提升视频质量,从标清升级到8K分辨率,修复旧镜头,为黑白视频着色,并稳定抖动镜头,提供专业级效果。

AniPortrait是一个开源AI框架,用于生成由音频或视频输入驱动的逼真肖像动画。它支持自驱动、面部重演和音频驱动模式,实现高质量视频合成。

探索bigmp4,这是一个前沿AI工具,用于无损视频放大至2K/4K/8K,黑白视频彩色化、AI插值实现平滑60-240fps,以及丝滑慢动作。支持MP4、MOV等格式,提供生动增强。

使用 Focal 的 AI 驱动视频创作软件,制作您自己的电视节目和电影。从脚本生成,通过聊天进行编辑,并使用最新的 AI 模型进行视频扩展、帧插值等。

Anvsoft提供人工智能驱动的视频和照片工具,包括AVCLabs Video Enhancer AI,旨在增强多媒体体验。