LangWatch 概述

LangWatch:AI代理测试和LLM评估平台

LangWatch是一个开源平台,专为AI代理测试、LLM评估和LLM可观测性而设计。它可以帮助团队模拟AI代理,跟踪响应并在影响生产之前捕获故障。

主要特点:

- 代理模拟: 使用模拟用户测试AI代理,以捕获边缘情况并防止回归。

- LLM评估: 使用内置的数据选择和测试工具评估LLM的性能。

- LLM可观测性: 跟踪响应并调试生产AI中的问题。

- 框架灵活: 适用于任何LLM应用程序、代理框架或模型。

- OpenTelemetry原生: 与所有LLM和AI代理框架集成。

- 自托管: 完全开源;在本地运行或自托管。

如何使用LangWatch:

- 构建: 通过证据而非猜测来设计更智能的代理。

- 评估: 使用内置工具进行数据选择、评估和测试。

- 部署: 减少返工,管理回归,并建立对AI的信任。

- 监控: 跟踪响应并在影响生产之前捕获故障。

- 优化: 与您的整个团队协作以运行实验,评估数据集并管理提示和流程。

集成:

LangWatch与各种框架和模型集成,包括:

- Python

- Typescript

- OpenAI agents

- LiteLLM

- DSPy

- LangChain

- Pydantic AI

- AWS BedRock

- Agno

- Crew AI

LangWatch适合您吗?

LangWatch适用于希望协作构建更好的AI代理的AI工程师、数据科学家、产品经理和领域专家。

常见问题解答:

- LangWatch如何工作?

- 什么是LLM可观测性?

- 什么是LLM评估?

- LangWatch是否提供自托管?

- LangWatch与Langfuse或LangSmith相比如何?

- LangWatch支持哪些模型和框架,以及如何集成?

- 我可以免费试用LangWatch吗?

- LangWatch如何处理安全性和合规性?

- 我如何为项目做贡献?

LangWatch帮助您自信地发布代理。只需5分钟即可开始使用。

"LangWatch"的最佳替代工具

Elixir 是一个 AI 运维和质量保证平台,旨在监控、测试和调试 AI 语音代理。它提供自动化测试、通话审查和 LLM 追踪,以确保可靠的性能。

PromptLayer 是一个 AI 工程平台,用于提示管理、评估和 LLM 可观察性。与专家协作,监控 AI 代理,并使用强大的工具提高提示质量。

Freeplay 是一个 AI 平台,旨在通过提示管理、评估、可观测性和数据审查工作流程,帮助团队构建、测试和改进 AI 产品。它简化了 AI 开发并确保了高质量的产品。

Athina是一个协作AI平台,帮助团队更快10倍构建、测试和监控基于LLM的功能。提供提示管理、评估和可观察性工具,确保数据隐私并支持自定义模型。

Vivgrid 是一个 AI 代理基础设施平台,帮助开发者构建、观察、评估和部署具有安全防护和低延迟推理的 AI 代理。它支持 GPT-5、Gemini 2.5 Pro 和 DeepSeek-V3。

Lunary 是一个开源 LLM 工程平台,提供可观测性、提示管理和分析功能,用于构建可靠的 AI 应用程序。它提供调试、跟踪性能和确保数据安全的工具。

Pydantic AI 是一个 Python 中的 GenAI 代理框架,旨在构建生产级生成式 AI 应用程序。它支持各种模型,提供无缝的可观察性,并确保类型安全开发。

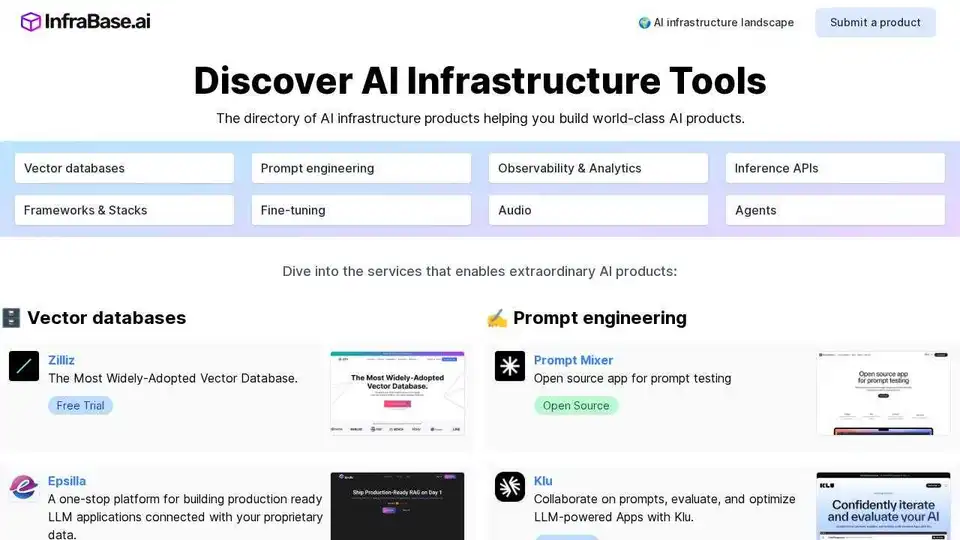

Infrabase.ai 是一个发现 AI 基础设施工具和服务的目录。查找向量数据库、Prompt 工程工具、推理 API 等,以构建世界一流的 AI 产品。