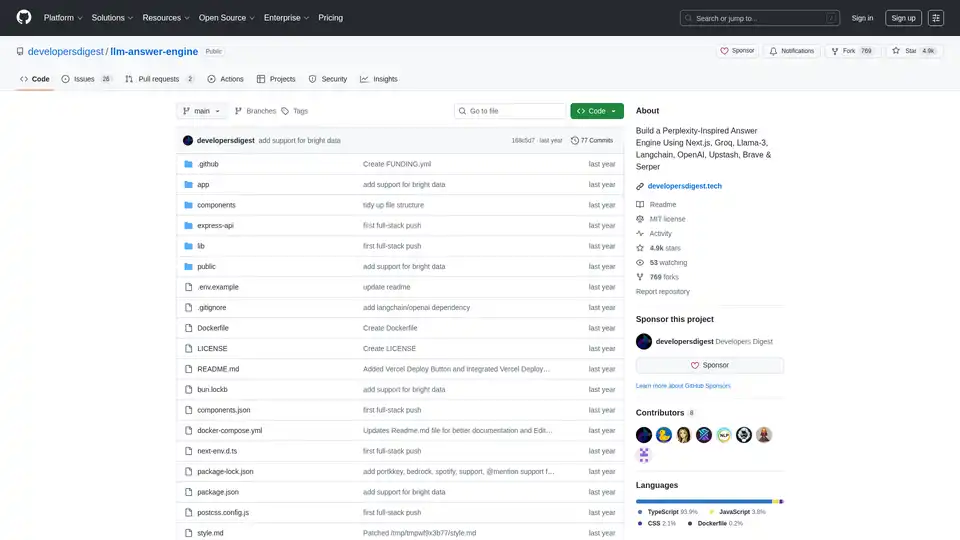

llm-answer-engine 概述

LLM 问答引擎:构建你自己的 AI 驱动的问答系统

这个开源项目 llm-answer-engine 提供了代码和指令,用于构建一个受 Perplexity 启发的、复杂的 AI 问答引擎。它利用了诸如 Groq、Mistral AI 的 Mixtral、Langchain.JS、Brave Search、Serper API 和 OpenAI 等尖端技术,为用户查询提供全面的答案,包括来源、图片、视频和后续问题。

什么是 llm-answer-engine?

llm-answer-engine 是一个起点,适用于对自然语言处理和搜索技术感兴趣的开发者。它允许你创建一个系统,通过以下方式高效地回答问题:

- 从各种来源检索相关信息。

- 生成简洁且信息丰富的答案。

- 提供支持性证据和相关媒体。

- 建议后续问题,以指导进一步探索。

llm-answer-engine 如何工作?

该引擎利用多种技术的组合来处理用户查询并生成相关的响应:

- 查询理解: 使用 Groq 和 Mixtral 等技术来处理和理解用户的问题。

- 信息检索:

- Brave Search: 使用注重隐私的搜索引擎来查找相关内容和图片。

- Serper API: 用于根据用户查询获取相关的视频和图片结果。

- Cheerio: 用于 HTML 解析,允许从网页中提取内容。

- 文本处理:

- Langchain.JS: 一个专注于文本操作(如文本分割和嵌入)的 JavaScript 库。

- OpenAI Embeddings: 用于创建文本块的向量表示。

- 可选组件:

- Ollama: 用于流式推理和嵌入。

- Upstash Redis Rate Limiting: 用于为应用程序设置速率限制。

- Upstash Semantic Cache: 用于缓存数据,以加快响应速度。

主要特性和技术:

- Next.js: 一个用于构建服务器端渲染和静态 Web 应用程序的 React 框架,为用户界面提供强大的基础。

- Tailwind CSS: 一个实用至上的 CSS 框架,用于快速构建自定义用户界面,实现高效的样式设计和定制。

- Vercel AI SDK: 一个用于构建 AI 驱动的流式文本和聊天 UI 的库,通过实时反馈增强用户体验。

- Function Calling Support (Beta): 通过集成地图和位置(Serper Locations API)、购物(Serper Shopping API)、TradingView 股票数据和 Spotify 来扩展功能。

- Ollama Support(部分支持): 提供与 Ollama 的兼容性,用于流式传输文本响应和嵌入,从而允许本地模型执行。

如何使用 llm-answer-engine?

要开始使用 llm-answer-engine,请按照以下步骤操作:

- 准备工作:

- 从 OpenAI、Groq、Brave Search 和 Serper 获取 API 密钥。

- 确保已安装 Node.js 和 npm(或 bun)。

- (可选)安装 Docker 和 Docker Compose 以进行容器化部署。

- 安装:

git clone https://github.com/developersdigest/llm-answer-engine.git cd llm-answer-engine - 配置:

- Docker: 编辑

docker-compose.yml文件并添加你的 API 密钥。 - Non-Docker: 在你的项目根目录中创建一个

.env文件并添加你的 API 密钥。

- Docker: 编辑

- 运行服务器:

- Docker:

docker compose up -d - Non-Docker:

npm install # or bun install npm run dev # or bun run dev

- Docker:

服务器将监听指定的端口。

为什么选择 llm-answer-engine?

- 受 Perplexity 启发: 提供与领先的 AI 问答引擎相似的用户体验。

- 利用强大的技术: 结合了 NLP、搜索和 Web 开发中的最佳技术。

- 开源且可定制: 允许你根据你的特定需求调整引擎。

- Function Calling Support: 通过集成地图和位置、购物、TradingView 股票数据和 Spotify 来扩展功能。

llm-answer-engine 适合谁?

这个项目非常适合:

- 对自然语言处理和搜索技术感兴趣的开发者。

- 探索问答系统的研究人员。

- 任何想要构建自己的 AI 驱动的知识库的人。

路线图:

该项目路线图包括令人兴奋的功能,例如:

- 文档上传 + RAG,用于文档搜索/检索。

- 一个设置组件,允许用户从 UI 中选择模型、嵌入模型和其他参数。

- 在使用 Ollama 时添加对后续问题的支持

贡献:

欢迎贡献!Fork 仓库,进行更改,然后提交 pull request。

本项目根据 MIT 许可证获得许可。

构建你自己的 AI 驱动的问答引擎,并使用 llm-answer-engine 探索自然语言处理的可能性!

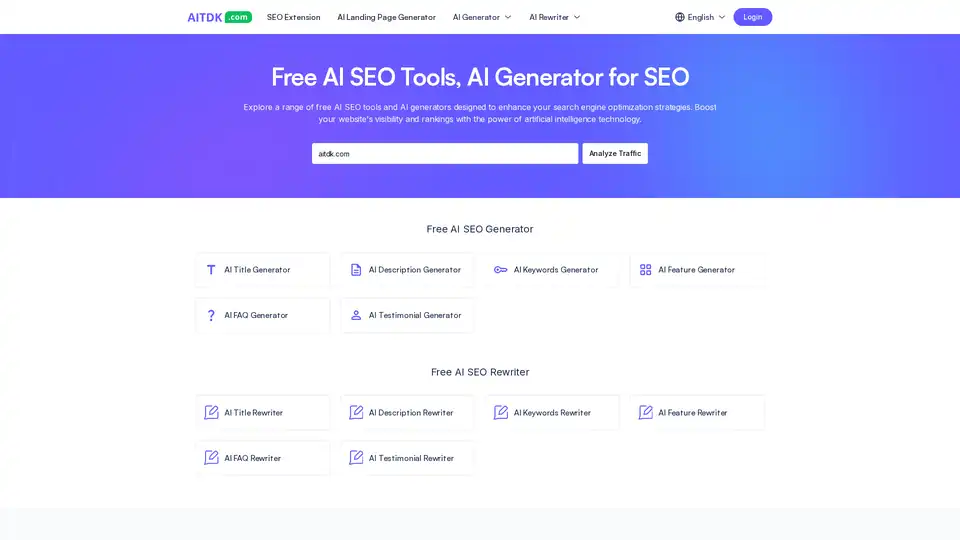

"llm-answer-engine"的最佳替代工具

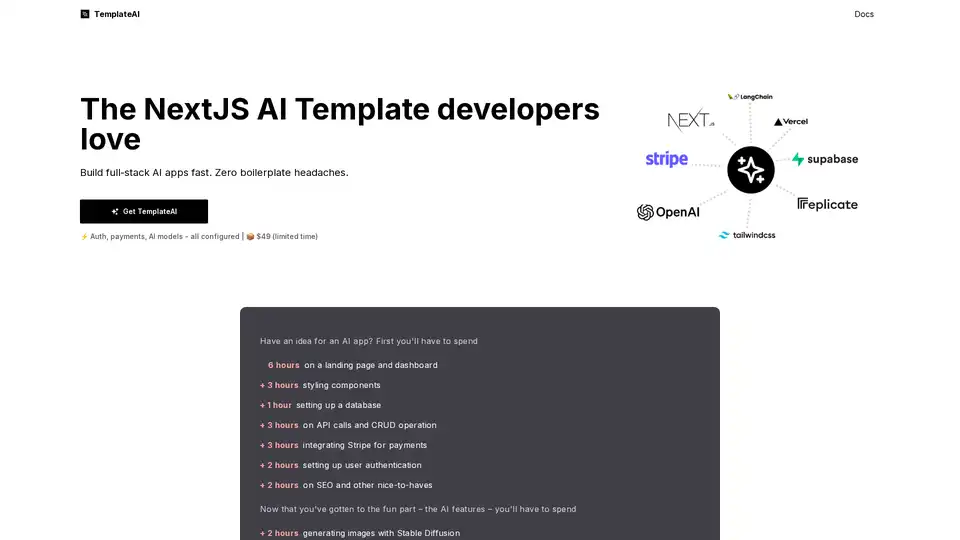

TemplateAI 是领先的 NextJS AI 应用模板,配备 Supabase 认证、Stripe 支付、OpenAI/Claude 集成,以及即用型 AI 组件,用于快速全栈开发。

发现CloudPDF创新的“与您的PDF聊天”功能,它正在改变您与文档交互的方式。了解其益处、独特功能和技术方面,并通过我们的互动示例亲自体验。立即提升生产力和文档导航!

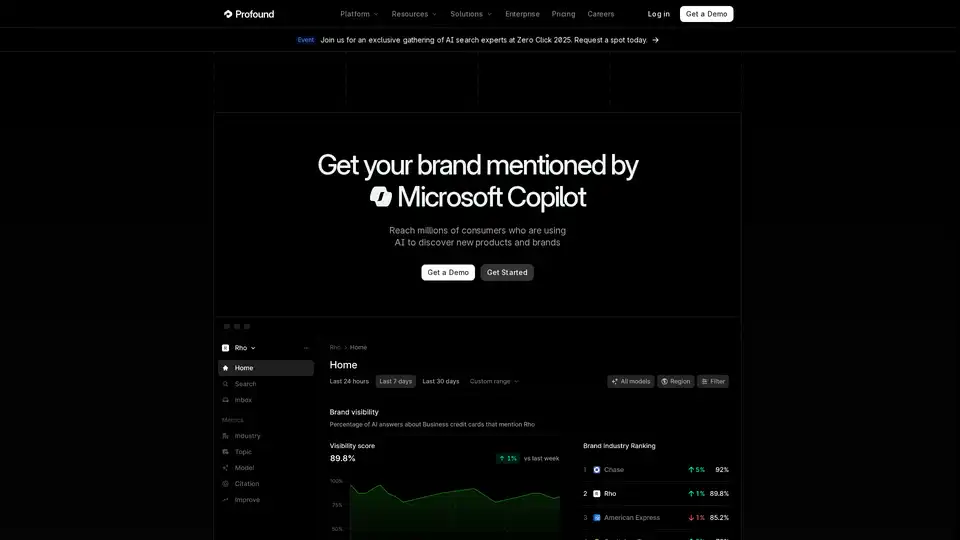

Profound 帮助品牌在人工智能搜索中提高可见性,优化其在基于 LLM 的答案引擎中的存在感,并在零点击世界中保持竞争力。立即分析您的人工智能可见性!

导入文档、网站、PDF、GitHub、Zendesk、Jira、Confluence 和视频,创建自己的 AI 问答助手。可嵌入任意位置或自托管。已用于 130+ 项目。

Vimeo AI是一个完整的视频平台,提供AI驱动的工具,用于视频编辑、翻译和SEO优化。受到数百万用户的信赖,可用于托管、管理和分享高质量视频。

TranslateBase是一个AI驱动的多语言翻译平台,提供100多种语言的免费高质量文本、文档、PDF和网站翻译。立即使用AI翻译!