Local Deep Researcher 概述

什么是 Local Deep Researcher?

Local Deep Researcher 是一款创新的开源网络研究助手,旨在完全在您的机器上本地运行。这款强大的工具通过 Ollama 或 LMStudio 利用大型语言模型 (LLM) 进行全面的网络研究,并生成带有适当来源引用的详细报告。

Local Deep Researcher 如何工作?

系统遵循一个智能的迭代研究过程:

研究循环过程:

- 查询生成:根据用户提供的主题,本地 LLM 生成优化的网络搜索查询

- 来源检索:使用配置的搜索工具 (DuckDuckGo、SearXNG、Tavily 或 Perplexity) 查找相关在线来源

- 内容摘要:LLM 分析并总结网络搜索结果中的发现

- 差距分析:系统反思摘要以识别知识差距和缺失信息

- 迭代优化:生成新搜索查询来解决已识别差距,并重复该过程

- 最终报告生成:经过多个循环(用户可配置)后,生成一个全面的 Markdown 报告,所有来源均正确引用

核心功能和能力

- 完全本地运行:所有处理都在本地进行,确保数据隐私和安全

- 多 LLM 支持:兼容通过 Ollama 或 LMStudio 托管的任何 LLM

- 灵活搜索集成:支持 DuckDuckGo(默认)、SearXNG、Tavily 和 Perplexity 搜索 API

- 可配置研究深度:用户可以设置研究循环次数(默认:3 次迭代)

- 结构化输出:生成格式良好的 Markdown 报告,并包含适当的来源引用

- 可视化工作流监控:与 LangGraph Studio 集成,实现实时过程可视化

技术要求和设置

支持的平台:

- macOS(推荐)

- Windows

- 通过 Docker 的 Linux

所需组件:

- Python 3.11+

- 用于本地 LLM 托管的 Ollama 或 LMStudio

- 高级搜索服务的可选 API 密钥

安装和配置

快速设置过程:

- 从 GitHub 克隆仓库

- 在 .env 文件中配置环境变量

- 选择您首选的 LLM 提供商(Ollama 或 LMStudio)

- 选择搜索 API 配置

- 通过 LangGraph Studio 启动

Docker 部署: 项目包含 Docker 支持,用于容器化部署,但 Ollama 必须单独运行并配置适当的网络。

模型兼容性考虑

系统需要能够生成结构化 JSON 输出的 LLM。有些模型如 DeepSeek R1 (7B 和 1.5B) 在 JSON 模式下可能有限制,但助手包含后备机制来处理这些情况。

谁应该使用 Local Deep Researcher?

理想用户包括:

- 研究人员和学者 需要全面的文献综述

- 内容创作者 需要经过充分研究的基础信息

- 学生 正在撰写研究论文和作业

- 记者 进行调查研究

- 商业专业人士 需要市场研究和竞争分析

- 注重隐私的用户 更喜欢本地处理而非云端解决方案

实际应用和用例

- 学术研究:进行文献综述并为论文收集来源

- 市场分析:研究竞争对手和行业趋势

- 内容研究:为博客文章、文章和报告收集信息

- 尽职调查:彻底调查主题并提供适当的来源文档

- 学习和教育:通过自动化研究协助深入探索主题

为什么选择 Local Deep Researcher?

关键优势:

- 完全隐私:您的研究主题和数据永远不会离开您的本地机器

- 成本效益:基本搜索功能无需 API 费用

- 可定制:根据您的具体需求调整研究深度和来源

- 透明:对研究过程和使用的来源有完全可见性

- 开源:社区驱动的发展和持续改进

获取最佳结果

为获得最佳性能:

- 尽可能使用更大、更强大的 LLM 模型

- 根据您的具体需求配置合适的搜索 API

- 根据主题复杂性调整研究循环次数

- 对于关键研究,手动审查和验证重要来源

Local Deep Researcher 代表了本地 AI 驱动研究工具的重大进步,它结合了大型语言模型的强大功能与实用的网络研究能力,同时保持完全的数据隐私和控制。

"Local Deep Researcher"的最佳替代工具

Lampi AI 为金融专业人士提供 AI 代理,将复杂的金融工作流程转化为几分钟内即可完成的结构化、高质量分析。 适用于并购、投资银行、私募股权和法律部门。

GPT for Work 将 ChatGPT、Gemini 等顶级 AI 集成到 Excel、Word、Sheets 和 Docs 中,自动化翻译、内容生成和数据分析等任务。 非常适合寻求提高生产力的专业人士。

GPT Researcher是一款开源AI研究助手,可以自动进行深入研究。它从可信来源收集信息,整合结果并快速生成综合报告。非常适合寻求公正见解的个人和团队。

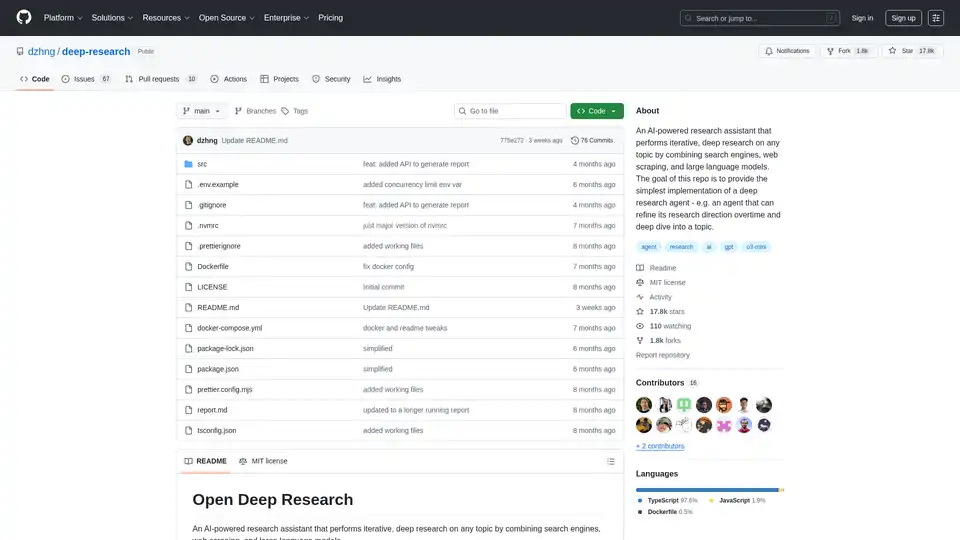

Deep Research是一款AI驱动的研究助手,它结合了搜索引擎、网络抓取和LLM,可以对任何主题进行迭代和深入的研究。通过智能查询生成和综合报告简化深度研究。

使用BrainSoup转变您的工作流程!通过自然语言创建自定义AI代理来处理任务并自动化流程。用您的数据增强AI,同时优先考虑隐私和安全。

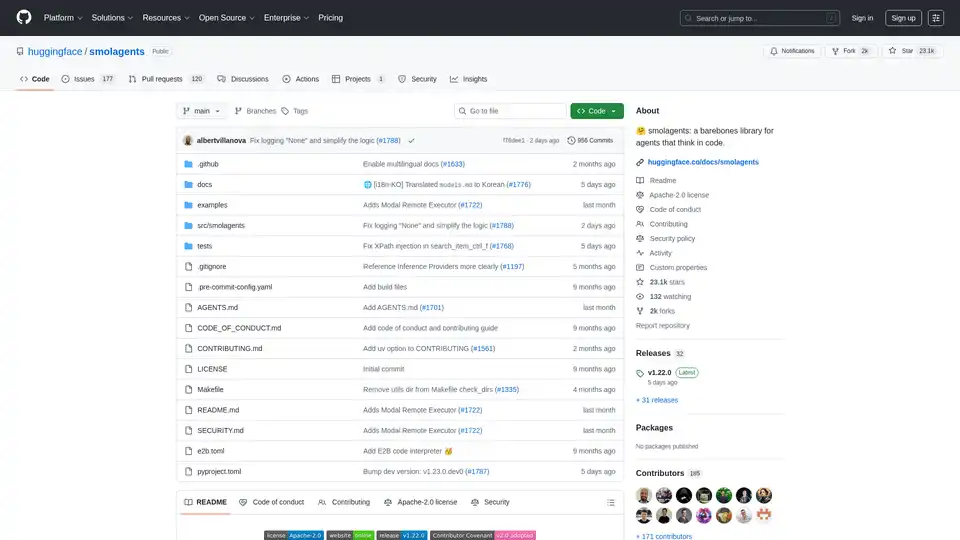

smolagents 是一个简约的 Python 库,用于创建通过代码推理和行动的 AI 代理。它支持模型无关的 LLM、安全沙箱以及与 Hugging Face Hub 的无缝集成,实现高效的基于代码的代理工作流。

探索BrandIdea AI粒度分析平台,利用先进的ML技术和超本地数据,为营销、销售和分销优化提供AI驱动的洞察。

Dynamiq 是一个本地平台,用于构建、部署和监控 GenAI 应用。通过 LLM 微调、RAG 集成和可观测性等功能,简化 AI 开发,降低成本并提升业务 ROI。

#1 应用内调查平台,适用于移动应用和网站。测量 NPS、CES、CSAT 和 PMF。超越基本分析,了解用户行为背后的原因。用更好的洞察构建更好的产品。

“Immersive Translate”提供下一代AI翻译服务,整合全球20多个顶级AI翻译引擎,如OpenAI (ChatGPT)、DeepL、Deepseek和Gemini。它帮助您打破语言障碍,在各种场景中实现更准确和流畅的翻译体验。这包括双语网站翻译、各种文档格式翻译、学术论文和PDF翻译、YouTube/Netflix在线视频字幕翻译、EPUB电子书翻译、Zoom/Google Meet/Microsoft Teams跨语言会议翻译,以及漫画和图像翻译。它支持Chrome、Edge、Firefox和Safari等主要浏览器,并在移动和桌面设备上安装可用。它支持数百种语言的互译,包括中文、英语、日语、韩语、法语、德语、俄语、西班牙语、葡萄牙语、越南语、印尼语、意大利语、荷兰语、泰语等。

EnConvo 是一款适用于 macOS 的 AI 代理启动器,通过即时访问和工作流程自动化彻底改变生产力。 具有 150 多个内置工具、MCP 支持和 AI 代理模式。