Qwen3 Coder 概述

什么是 Qwen3 Coder?

Qwen3 Coder 是阿里巴巴云推出的开创性开源大型语言模型 (LLM),专为代码生成、理解以及软件开发中的代理任务执行而设计。该模型基于 Mixture-of-Experts (MoE) 架构,拥有海量的 4800 亿参数,推动了 AI 辅助编码的边界。训练数据达惊人的 7.5 万亿 tokens,其中 70% 专注于 358 种编程语言的源代码——Qwen3 Coder 的性能可与 GPT-4 等专有巨头匹敌,同时在 Apache 2.0 许可下完全开放。无论您是独自处理快速修复的开发者,还是团队进行仓库级重构,这款工具都能将被动代码建议转化为主动、智能的辅助。

与其他仅能自动完成代码片段的早期模型不同,Qwen3 Coder 代表了 AI 软件代理的新时代。它不仅编写代码,还能推理问题、规划多步解决方案、集成工具并迭代调试。从 Qwen1 的基本补全到 Qwen3 的代理能力,这一演进在 HumanEval 等基准测试中实现了 ~40% 至 ~85% 的跃升,使其成为现代开发者追求高效、高质量代码工作流的重要资源。

Qwen3 Coder 如何工作?

Qwen3 Coder 的核心基于复杂的 MoE 架构,总计 4800 亿参数分布在 160 个专家模块中。在推理过程中,仅激活 35 亿参数,确保高速性能而不压垮硬件。该模型采用 62 层因果 Transformer,配备分组查询注意力,原生支持 256K tokens 上下文窗口——使用阿里巴巴的 YaRN 技术可扩展至 1M。这允许它一次性处理整个代码库、长文档或复杂项目历史,对于大规模软件项目而言,这是一场变革。

训练过程革命性十足。预训练利用 Qwen2.5-Coder 清理语料库,过滤噪声数据并合成高质量示例,强调编码最佳实践。其独特之处在于执行驱动的强化学习 (RL):模型在 20,000 个并行环境中经过数百万次代码执行循环进行微调。只有正确运行并通过测试的代码才能获得奖励,不仅关注语法,还确保功能准确性。这种 RL 方法结合多步推理,用于工具使用和调试等工作流,实现了代理行为——想象一个 AI 副驾驶,能预见需求并自主优化输出。

例如,在生成代码时,Qwen3 Coder 首先分析需求,规划结构(例如,在 Python 中概述快速排序算法),然后执行并验证。原生函数调用支持无缝 API 集成,使其非常适合嵌入 IDE 或 CI/CD 管道。

Qwen3 Coder 的核心功能

Qwen3 Coder 的功能使其成为多样化编码任务的强大工具:

- 代理编码工作流:处理多轮交互,从需求收集到迭代调试,模拟人类开发者的过程。

- 最先进性能:在 HumanEval 上实现 ~85% pass@1,超越开源同行如 CodeLlama (67%),并与 GPT-4 匹配,尤其在真实场景中。

- 超长上下文处理:标准 256K tokens,可扩展至 1M,用于分析完整仓库而无上下文丢失。

- 多语言专长:支持 358 种语言,包括 Python、Rust、Haskell、SQL 等,70% 训练重点在代码上。

- 高级 RL 训练:从执行反馈中学习,确保生成代码不仅语法正确,还实用可行。

- 开放且可集成:Apache 2.0 许可,可在 Hugging Face、ModelScope 和阿里巴巴云 API 上获取,用于商业用途。

这些元素解决了开发中的常见痛点,如易出错的手动编码或碎片化工具链,提供了一个统一、智能的平台。

如何使用 Qwen3 Coder?

入门 Qwen3 Coder 非常简单,提供不同设置的灵活性:

- 云 API 访问:利用阿里巴巴云的 ModelStudio 或 DashScope,提供 OpenAI 兼容 API——无需硬件烦恼,按使用付费以实现可扩展性。

- 本地部署:从 Hugging Face 下载(例如 Qwen/Qwen3-Coder-480B-A35B-Instruct),使用 Transformers 库。快速 Python 示例:

这会立即生成功能性代码片段。from transformers import AutoTokenizer, AutoModelForCausalLM device = "cuda" # Adjust for your hardware tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-Coder-480B-A35B-Instruct") model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-Coder-480B-A35B-Instruct", device_map="auto").eval() input_text = "# Write a quick sort algorithm in Python" model_inputs = tokenizer([input_text], return_tensors="pt").to(device) generated_ids = model.generate(model_inputs.input_ids, max_new_tokens=512, do_sample=False)[0] output = tokenizer.decode(generated_ids[len(model_inputs.input_ids[0]):], skip_special_tokens=True) print(output) - IDE 集成:通过如 Claude Code(适配 Qwen)的扩展插件接入 VSCode,或使用 Qwen Code CLI 执行终端命令。

- 量化选项:社区 GGUF 版本(4 位/8 位)可在单个 RTX 4090 GPU 上运行,让个体用户更容易访问。

硬件需求因情况而异:完整模型需要多个 A100/H100 GPU,但量化或 API 版本降低了门槛。主要能力包括代码补全、错误修复、仓库分析和多步求解——完美自动化重复任务。

为什么选择 Qwen3 Coder?

在众多 AI 编码工具中,Qwen3 Coder 以其力量、开放性和实用性的结合脱颖而出。它通过融入代理 RL,超越了 Qwen2.5-Coder(HumanEval 72%),根据用户报告,在复杂项目中将调试时间减少高达 50%。开发者赞赏其在多语言环境中的准确性和长上下文能力,这避免了小型模型常见的上下文丢失错误。

对于商业可行性,Apache 2.0 许可允许无限制使用,不像专有选项收取使用费。基准测试证实其优势:相较 CodeLlama 的 100K 上下文和 67% 准确率,Qwen3 提供 256K+ 和 85%,非常适合企业级开发。其执行驱动训练确保可靠输出,减少生产 bug——这对期限紧迫的团队至关重要。

Qwen3 Coder 适合谁?

这款工具针对软件开发领域的广泛受众:

- 个体开发者与爱好者:快速生成代码并学习 358 种语言。

- 专业团队:仓库级重构、自动化测试,以及敏捷工作流集成。

- AI 研究者:实验 MoE 架构、代理 RL 或在自定义数据集上微调。

- 初创企业和大型公司:付费 API 的成本效益替代品,云端可扩展性适用于高负载任务。

如果您对不完整的建议或仅关注语法的工具感到沮丧,Qwen3 Coder 的代理方法提供更深入的辅助,提升生产力而无需陡峭的学习曲线。

在工作流中最大化 Qwen3 Coder 的最佳方式

要充分利用它:

- 从 API 开始原型设计,然后为隐私敏感项目本地部署。

- 与 Git 等工具结合用于仓库分析,或 Jupyter 用于交互式调试。

- 使用提供的脚本在领域特定代码(如金融算法)上微调。

- 通过 HumanEval 等基准监控性能,跟踪改进。

用户反馈强调其在加速功能开发中的作用——一位开发者表示,将重构任务从几天缩短至数小时。虽然它在结构化任务中表现出色,但与人类监督结合可确保创意编码的最优结果。

性能基准与比较

| 模型 | 参数规模 | 最大上下文 | HumanEval Pass@1 | 许可 |

|---|---|---|---|---|

| Qwen3 Coder | 480B (35B 活跃, MoE) | 256K (至 1M) | ~85% | Apache 2.0 |

| CodeLlama-34B | 34B (稠密) | 100K | ~67% | Meta Custom |

| StarCoder-15B | 15.5B (稠密) | 8K | ~40% | Open RAIL |

| GPT-4 | 专有 | 8K-32K | ~85% | 专有 |

这些数据突显了 Qwen3 在开源 AI 代码生成领域的领导地位,平衡了规模与效率。

常见问题解答 (FAQ)

- Qwen3 Coder 的性能为什么是最先进的? 其执行驱动 RL 和大规模 MoE 架构确保基准准确率达 ~85% 的功能代码。

- 256K 上下文窗口如何帮助开发者? 它启用完整代码库分析,减少大型项目中的错误。

- 什么是“代理编码”,Qwen3 Coder 如何实现? 它是多步、工具使用的开发过程;通过并行环境中的 RL 实现规划和调试。

- 我可以使用 Qwen3 Coder 进行商业项目吗? 是的,Apache 2.0 许可支持无限制商业应用。

- Qwen3 Coder 支持多少编程语言? 358 种,涵盖主流和利基语言如 Haskell 和 SQL。

- 运行 480B 模型需要什么硬件? 完整版需多个高端 GPU;量化版可在单张消费级显卡上运行。

- Qwen3 Coder 与前代相比如何? 在代理功能和准确性上大幅改进,超越 Qwen2.5。

- 有无需自托管的 API 吗? 是的,通过阿里巴巴云服务。

- “执行驱动 RL” 是什么意思? 基于真实代码运行和测试的奖励训练,而非仅模式。

- 在哪里找到文档? Hugging Face、ModelScope 或阿里巴巴云仓库。

Qwen3 Coder 不仅仅是另一个 LLM——它是更智能、更快速软件工程的催化剂,用前沿开源创新赋能全球开发者。

"Qwen3 Coder"的最佳替代工具

Devento 是一个由 AI 驱动的平台,允许您使用 AI 代理和安全的微虚拟机沙箱构建和部署全栈应用程序。它简化了从与 AI 聊天到部署功能性应用程序的开发过程。

使用 Dashwave 更快地构建、测试和部署移动应用程序,这是一个 AI 驱动的平台,通过文本到应用程序的聊天工作区和 Figma 到代码的转换简化了移动开发。

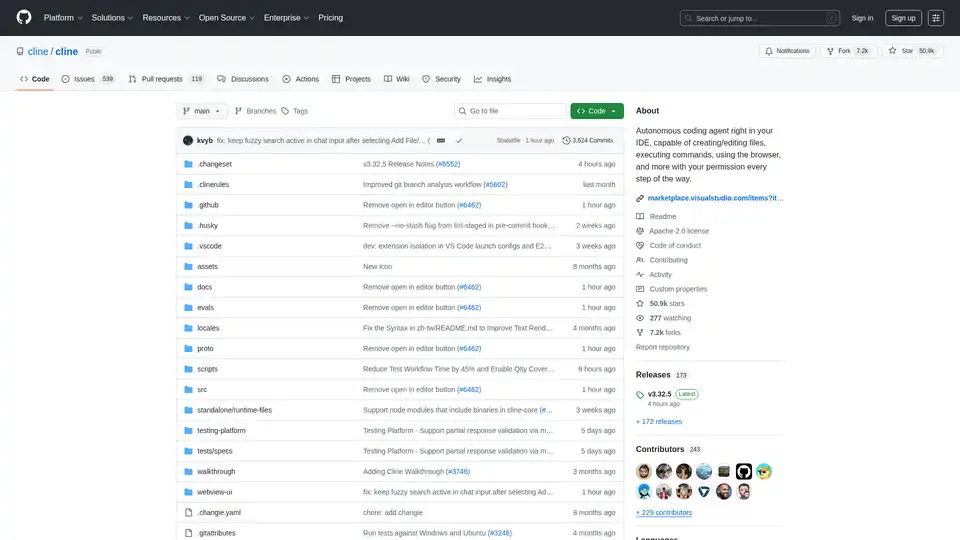

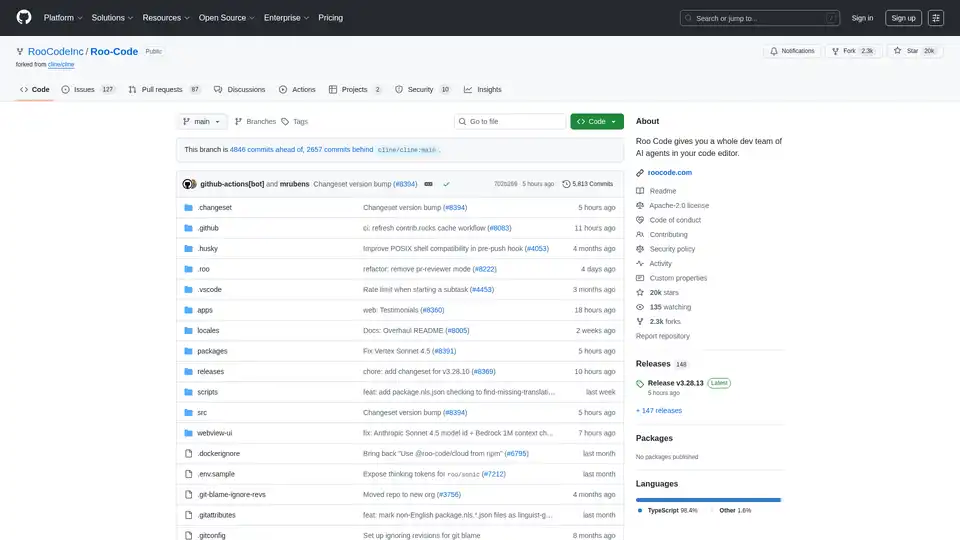

Roo Code 是一款由 AI 驱动的 VSCode 扩展,在您的代码编辑器中提供由 AI 代理组成的完整开发团队。生成代码、调试、重构等。

Substrate 是复合 AI 的终极平台,提供强大的 SDK,包括优化模型、向量存储、代码解释器和代理控制。构建高效的多步骤 AI 工作流——比以往更快,摒弃 LangChain 以实现流畅开发。

Nebius AI Studio Inference Service 提供托管开源模型,实现比专有 API 更快、更便宜、更准确的推理结果。无需 MLOps,即可无缝扩展,适用于 RAG 和生产工作负载。

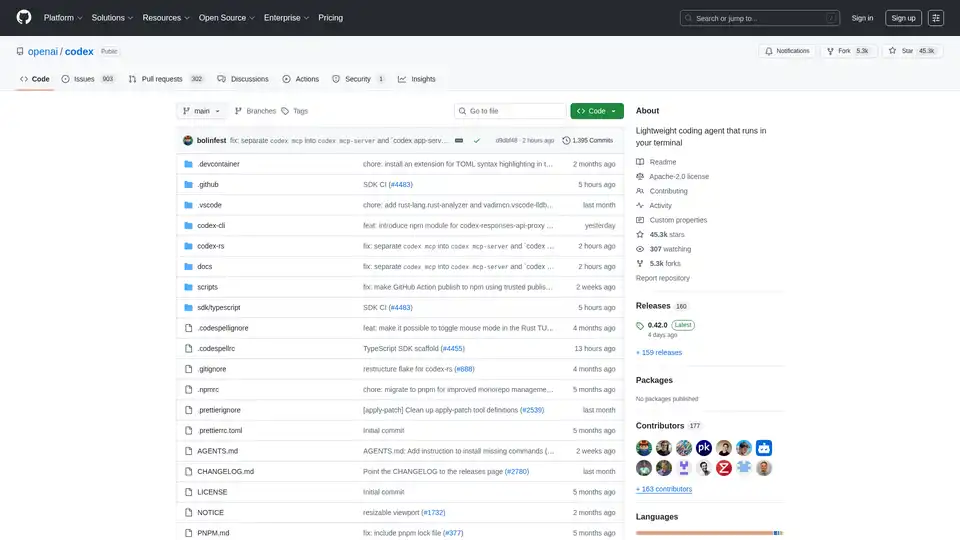

Codex CLI 是 OpenAI 的开源编码代理,在您的终端中运行,提供 AI 驱动的编程任务协助。通过 npm 或 Homebrew 安装,实现无缝集成到您的工作流程中。

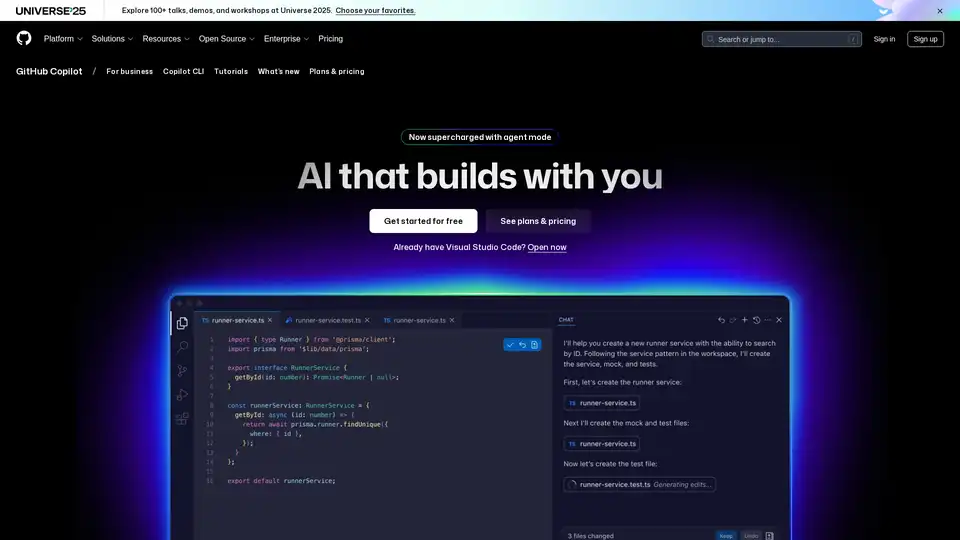

GitHub Copilot 是一款 AI 驱动的编码助手,可集成到您的 IDE 中,建议代码行,通过代理模式处理问题,并提供审查以提升开发人员生产力。

Sally Suite 是一款基于AI代理的Office Copilot,通过与Google Workspace和Microsoft Office集成,提高生产力,提供数据分析、写作辅助和自动演示文稿生成。