DeepSeek V3

Übersicht von DeepSeek V3

Was ist DeepSeek V3?

DeepSeek V3 ist ein bahnbrechendes Open-Source-Großsprachmodell mit beeindruckenden 671 Milliarden Parametern, von denen 37 Milliarden pro Token für eine effiziente Verarbeitung aktiviert werden. Als modernste KI-Lösung entwickelt, ermöglicht es Nutzern, fortschrittliches natürliches Sprachverständnis und -generierung ohne die Barrieren von Kosten oder proprietären Einschränkungen zu nutzen. Ob Sie KI für Forschung, Entwicklung oder kommerzielle Projekte erkunden – DeepSeek V3 zeichnet sich durch seine Zugänglichkeit und Leistung aus und macht es zur Top-Wahl unter kostenlosen KI-Modellen in der sich schnell entwickelnden Landschaft der Machine-Learning-Tools.

Dieses Modell ist nicht nur eine weitere Iteration – es wurde entwickelt, um mit führenden proprietären Systemen zu konkurrieren, während es vollständig Open-Source bleibt. Mit Fokus auf Skalierbarkeit und Benutzerfreundlichkeit veröffentlicht, unterstützt DeepSeek V3 eine großzügige Kontextlänge von 128K, was die Verarbeitung umfangreicher Eingaben wie langer Dokumente oder komplexer Konversationen ermöglicht. Seine Architektur optimiert sowohl Tiefe als auch Effizienz und gewährleistet hochwertige Ausgaben sogar auf bescheidener Hardware bei lokaler Ausführung.

Wie funktioniert DeepSeek V3?

Im Kern operiert DeepSeek V3 auf einer transformerbasierten Architektur, einem Grundpfeiler moderner Großsprachmodelle. Die 671B Parameter des Modells ermöglichen es, intricate Muster in riesigen Datensätzen zu erfassen, von Aufgaben der natürlichen Sprachverarbeitung bis zur Generierung kreativer Inhalte. Für jedes verarbeitete Token werden nur 37B Parameter aktiviert, was einen cleveren Mixture-of-Experts (MoE)-Ansatz darstellt, der Rechenaufwand reduziert, ohne Fähigkeiten zu opfern. Das bedeutet schnellere Inferenzzeiten und geringere Ressourcenanforderungen im Vergleich zu dichten Modellen ähnlicher Größe.

Nutzer können mit DeepSeek V3 auf zwei primäre Weisen interagieren: durch eine intuitive Online-Demo oder durch Herunterladen des vollständigen Quellcodes für lokale Bereitstellung. Die Online-Version läuft direkt in Ihrem Browser und nutzt Cloud-Infrastruktur für sofortigen Zugriff – kein Setup erforderlich. Auf der lokalen Seite bietet die Open-Source-Implementierung auf GitHub alles Nötige: Modellgewichte, Code und Dokumentation. Integration ist unkompliziert über API-Endpunkte, die beliebte Frameworks wie Python's Hugging Face Transformers-Bibliothek unterstützen. Beispielsweise können Entwickler das Modell mit einem einfachen Befehl laden und sofort Textgenerierung, Coding-Unterstützung oder sogar Übersetzungen starten.

Das Training des Modells betont diverse Datenquellen, einschließlich mehrsprachiger Texte, Code-Repositories und wissenschaftlicher Literatur, was zu robuster Leistung across Domains führt. Seine Open-Source-Natur lädt auch Community-Beiträge ein und fördert kontinuierliche Verbesserungen durch Forks und Pull Requests auf GitHub.

Wie verwendet man DeepSeek V3?

Der Einstieg in DeepSeek V3 ist bemerkenswert einfach und entspricht seiner Philosophie der barrierfreien KI-Zugänglichkeit.

Online-Demo: Gehen Sie zur DeepSeek Online-Plattform und klicken Sie auf 'Jetzt testen.' Keine Registrierung oder Kreditkarte erforderlich – geben Sie einfach Ihren Prompt ein und erhalten Sie Antworten in Sekunden. Ideal für schnelle Tests, Brainstorming-Ideen oder Echtzeit-Bewertung der Modellstärken.

Lokale Installation: Besuchen Sie das GitHub-Repository, um die DeepSeek-V3-Base- oder vollständigen DeepSeek-V3-Modelle herunterzuladen. Systemanforderungen variieren: Eine GPU mit mindestens 24GB VRAM wird für optimale Leistung empfohlen, though CPU-only-Modus für leichtere Aufgaben funktioniert. Installation beinhaltet Klonen des Repos, Installieren von Abhängigkeiten via pip und Ausführen von Inferenz-Skripten. Umfassende Dokumente führen Sie durch Quantisierungstechniken, um das Modell auf Consumer-Hardware anzupassen.

API-Integration: Für Produktions-Apps verwenden Sie die bereitgestellten API-Wrapper. Integrieren Sie DeepSeek V3 in Chatbots, Content-Tools oder Analytics-Pipelines. Beispiel-Code-Snippets im Repo demonstrieren, wie Anfragen gehandhabt, Kontexte verwaltet und für spezifische Use Cases feinabgestimmt werden.

Unbegrenzter Zugriff bedeutet, dass Sie frei experimentieren können, ohne Rate Limits in der Online-Demo. Für kommerzielle Nutzung erlaubt die permissive Lizenz Weiterverteilung und Modifikation, solange Attribution gegeben wird.

Warum DeepSeek V3 wählen?

In einem Markt, der mit kostenpflichtigen KI-Diensten überschwemmt ist, glänzt DeepSeek V3 für sein Null-Kosten-Modell und unvergleichliche Offenheit. Hier ist warum es ein Game-Changer ist:

Unübertroffene Leistung ohne Kosten: Mit 671B Parametern liefert es Ausgaben, die mit Top-Modellen wie GPT-4 in Benchmarks für Reasoning, Coding und mehrsprachige Aufgaben vergleichbar sind. Dennoch ist es komplett kostenlos, auch für Unternehmen, die KI-Lösungen skalieren.

Kommerzielle Freiheit: Im Gegensatz zu vielen kostenlosen Stufen, die Nutzung einschränken, erlaubt DeepSeek V3 volle kommerzielle Anwendung. Startups und Unternehmen können revenue-generierende Produkte ohne Lizenzgebühren bauen.

Community-getriebene Exzellenz: Unterstützt von einer lebendigen GitHub-Community profitiert das Modell von schnellen Updates, Bug-Fixes und Erweiterungen. Nutzerbeiträge haben bereits seine Feinabstimmungsfähigkeiten für Nischenbereiche wie juristische oder medizinische Texte verbessert.

Vielseitig und effizient: Das 128K-Kontextfenster unterstützt Long-Form-Generierung, während MoE-Aktivierung Energieverbrauch niedrig hält – entscheidend für nachhaltige KI-Entwicklung.

Im Vergleich zu Wettbewerbern übertrifft DeepSeek V3 oft in Effizienzmetriken. Zum Beispiel generiert es in Coding-Benchmarks funktionierende Python-Skripte mit weniger Fehlern als kleinere Open-Modelle, und seine mehrsprachige Unterstützung übertrifft englisch-zentrische Alternativen.

Für wen ist DeepSeek V3?

DeepSeek V3 spricht ein breites Publikum im KI-Ökosystem an:

Entwickler und Forscher: Ideal für Prototyping von KI-Anwendungen, Experimentieren mit Feinabstimmung oder Vorantreiben von Machine-Learning-Projekten. Sein Open-Source-Code beschleunigt Innovation ohne Vendor-Lock-in.

Unternehmen und Startups: Perfekt für kosteneffektive KI-Integration in Customer-Service-Bots, Content-Automatisierung oder Data-Analysis-Tools. Die kommerzielle Lizenz entfernt rechtliche Hürden für Monetarisierung.

Lehrer und Studenten: Verwenden Sie die Online-Demo für hands-on Lernen über Großsprachmodelle. Es ist eine praktische Weise, NLP-Konzepte ohne teure Abonnements zu lehren.

Content-Creator und Hobbyisten: Generieren Sie mühelos Artikel, Code-Snippets oder kreatives Schreiben. Der unbegrenzte kostenlose Zugriff macht es zugänglich für Gelegenheitsnutzer, die das Potenzial von KI erkunden.

Wenn Sie das beste kostenlose KI-Modell für Aufgaben wie automatisiertes Report-Schreiben, Code-Debugging oder mehrsprachige Übersetzung suchen, passt DeepSeek V3 nahtlos.

Haupt Use Cases und praktischer Wert

DeepSeek V3's Vielseitigkeit erschließt zahlreiche Anwendungen:

Natürliche Sprachgenerierung: Verfassen Sie E-Mails, Blogs oder Marketing-Texte mit kontextbewusster Präzision. Zum Beispiel: Geben Sie eine Themenübersicht ein und erhalten Sie einen polierten 1000-Wörter-Artikel.

Coding-Unterstützung: Agiert als KI-Programmierbegleiter, schlägt Completions vor, reviewed Code oder erklärt Algorithmen. Entwickler berichten von 30-50% schnelleren Workflows bei Nutzung neben IDEs.

Forschung und Analyse: Fassen Sie Papers zusammen, generieren Sie Hypothesen oder analysieren Sie Datensätze. Sein langer Kontext handhabt vollständige Forschungsdokumente und unterstützt Akademiker in Literaturreviews.

Mehrsprachige Anwendungen: Unterstützt über 20 Sprachen, was es wertvoll für globale Teams in Übersetzung, Lokalisierung oder internationalem Customer-Support macht.

Der praktische Wert liegt in der Demokratisierung hochwertiger KI. Durch Eliminierung von Paywalls ebnet es das Spielfeld und ermöglicht kleinen Teams, mit Tech-Giganten zu konkurrieren. Nutzer loben seine Zuverlässigkeit in FAQs, noting schnelles Setup und konsistente Ergebnisse. Eine häufige Frage: "Ist es wirklich kostenlos für kommerzielle Nutzung?" Ja – downloaden und bereitstellen ohne versteckte Bedingungen.

Für Systemanforderungen benötigen lokale Runs robuste Hardware (z.B. NVIDIA A100 GPUs für volle Geschwindigkeit), aber quantisierte Versionen laufen auf Laptops. Integrations-FAQs cover Troubleshooting, wie Handhabung von API-Schlüsseln oder Optimierung für Edge-Geräte.

Häufig gestellte Fragen

Was sind die Systemanforderungen für DeepSeek V3?

Für lokale Nutzung ist ein Rechner mit 80+ GB RAM und einer High-End-GPU ideal. Cloud-Optionen via Online-Demo umgehen dies.

Kann ich DeepSeek V3 in meine bestehenden Apps integrieren?

Absolut – verwenden Sie die GitHub-Docs für API-Setup. Es ist kompatibel mit major ML-Frameworks.

Wie vergleicht sich DeepSeek V3 mit anderen KI-Modellen?

Es matcht oder übertrifft viele in Benchmarks für Effizienz und Ausgabequalität, alles while free und open.

Zusammenfassend repräsentiert DeepSeek V3 die Zukunft zugänglicher KI, vereint rohe Leistung mit benutzerfreundlichem Design. Ob Sie ein erfahrener KI-Ingenieur oder neugieriger Anfänger sind – dieses Modell liefert greifbaren Wert durch Vereinfachung fortgeschrittener Fähigkeiten. Laden Sie es heute von GitHub herunter oder testen Sie die Online-Demo, um zu sehen, warum es als das leistungsstärkste kostenlose KI-Modell gefeiert wird.

Beste Alternativwerkzeuge zu "DeepSeek V3"

Promptfoo ist ein Open-Source-LLM-Sicherheitstool, das von über 200.000 Entwicklern für AI Red-Teaming und Bewertungen verwendet wird. Es hilft, Schwachstellen zu finden, die Ausgabequalität zu maximieren und Regressionen in KI-Anwendungen abzufangen.

CrewAI ist eine Open-Source-Multi-Agenten-Plattform, die den Aufbau und die Orchestrierung von KI-Automatisierungs-Workflows mit jedem LLM und Cloud-Plattform für Unternehmensanwendungen ermöglicht.

ChatTTS ist ein Open-Source-Text-zu-Sprache-Modell, das für Konversationsszenarien optimiert ist und Chinesisch und Englisch mit hochwertiger Sprachsynthese unterstützt, trainiert mit 100.000 Stunden Daten.

PremAI ist ein KI-Forschungslabor, das sichere, personalisierte KI-Modelle für Unternehmen und Entwickler bereitstellt. Zu den Funktionen gehören TrustML-verschlüsselte Inferenz und Open-Source-Modelle.

Aider ist ein Open-Source-KI-Pair-Programming-Tool, das direkt in Ihrem Terminal arbeitet und mehrere LLMs including Claude 3.7 Sonnet, DeepSeek und GPT-4o für Codegenerierung und Zusammenarbeit unterstützt.

Xander ist eine Open-Source-Desktop-Plattform, die No-Code-KI-Modelltraining ermöglicht. Beschreiben Sie Aufgaben in natürlicher Sprache für automatisierte Pipelines in Textklassifikation, Bildanalyse und LLM-Fine-Tuning, mit Garantie für Datenschutz und Leistung auf Ihrem lokalen Gerät.

Falcon LLM ist eine Open-Source-Familie generativer großer Sprachmodelle von TII, mit Modellen wie Falcon 3, Falcon-H1 und Falcon Arabic für mehrsprachige, multimodale KI-Anwendungen, die effizient auf Alltagsgeräten laufen.

Chatbots, Mini-Apps und AI-Infrastruktur. Eine geführte Reise von der Idee zum MVP in nur 4 Wochen.

DeepSeek konzentriert sich auf führende AGI-Modelle. Sie haben mehrere Modelle mit Milliarden von Parametern wie DeepSeek-LLM und DeepSeek-Coder veröffentlicht.

Trainieren, verwalten und evaluieren Sie benutzerdefinierte große Sprachmodelle (LLMs) schnell und effizient auf Entry Point AI, ohne dass Code erforderlich ist.

GPT4All ermöglicht die private, lokale Ausführung großer Sprachmodelle (LLMs) auf alltäglichen Desktops ohne API-Aufrufe oder GPUs. Zugängliche und effiziente LLM-Nutzung mit erweiterter Funktionalität.

Verwandeln Sie komplexe KI-Konversationen in übersichtliche, interaktive Timelines. Universelle Unterstützung für alle LLM-Plattformen.

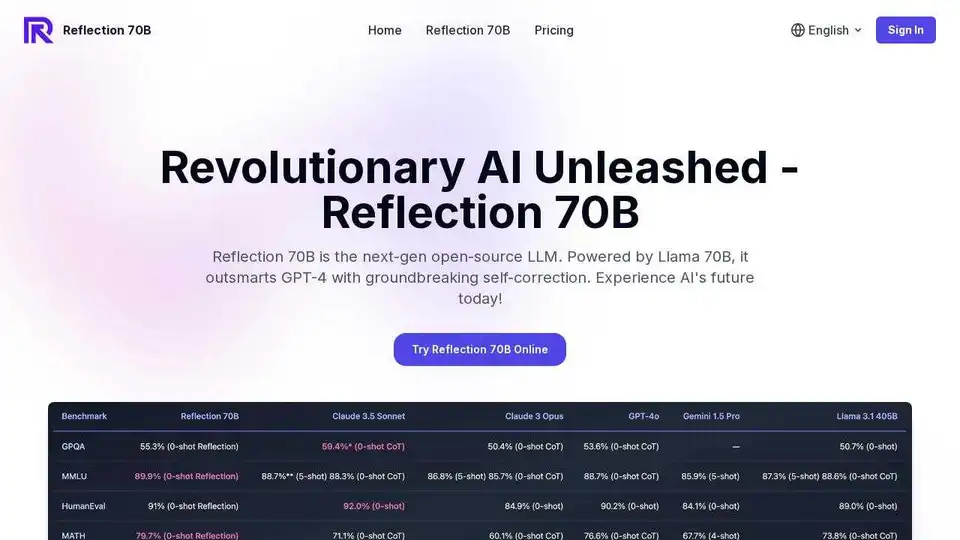

Testen Sie Reflection 70B online, ein Open-Source-LLM, das auf Llama 70B basiert. Übertrifft GPT-4 mit innovativer Selbstkorrektur. Online-Gratis-Testversion verfügbar.

DeepSeek v3 ist ein leistungsstarkes KI-gestütztes LLM mit 671B Parametern, das API-Zugriff und ein Forschungspapier bietet. Testen Sie unsere Online-Demo für hochmoderne Leistung.