Selene

Übersicht von Selene

Selene von Atla AI: Frontier AI Evaluationsmodelle

Was ist Selene?

Selene ist eine Suite von Open-Source-LLM-Judge-Modellen, die von Atla AI entwickelt wurden, um präzise und zuverlässige Bewertungen der Leistung von AI-Anwendungen zu ermöglichen. Es hilft Entwicklern, das Vertrauen ihrer Kunden zu gewinnen, indem es die Zuverlässigkeit ihrer generativen AI-Apps durch detaillierte Bewertungen und umsetzbare Kritikpunkte sicherstellt.

Wie funktioniert Selene?

Selene-Modelle fungieren als LLM-as-a-Judge und analysieren AI-Antworten, um Bewertungen und Kritikpunkte zu liefern. Sie können die Selene-Modelle über Hugging Face Transformers, Ollama oder Github verwenden.

Selene-Modelle

Entdecken Sie die richtige Größe für Ihre Evaluationsbedürfnisse mit zwei Hauptmodellen:

- Selene 1: Das Flaggschiffmodell, das branchenführende Genauigkeit bei einer Vielzahl von Evaluationsaufgaben bietet. Ideal für Pre-Production-Evaluierungen.

- Selene 1 Mini: Eine schlanke, optimierte Version, die sich perfekt für die Durchführung von Evaluierungen zur Inferenzzeit eignet und Geschwindigkeit und Effizienz priorisiert.

Hauptmerkmale und Vorteile

- Hohe Genauigkeit: Selene wurde entwickelt, um die genauesten verfügbaren Bewertungen zu liefern.

- Vielseitige Evaluation: Geeignet für eine Vielzahl von Eval-Aufgaben.

- Optimiert für Geschwindigkeit: Selene 1 Mini ist für die schnelle Durchführung von Evals während der Inferenz optimiert.

- Open Source: Verwenden Sie die Modelle und tragen Sie dazu bei über Hugging Face Transformers.

So verwenden Sie Selene

Um Selene zu verwenden, können Sie die Hugging Face Transformers-Bibliothek nutzen. Hier ist ein einfaches Beispiel:

from transformers import AutoModelForCausalLM, AutoTokenizer

device = "cuda" # the device to load the model onto

model_id = "AtlaAI/Selene-1-Mini-Llama-3.1-8B"

model = AutoModelForCausalLM.from_pretrained(model_id, device_map="auto")

tokenizer = AutoTokenizer.from_pretrained(model_id)

prompt = "I heard you can evaluate my responses?" # replace with your eval prompt

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

model_inputs = tokenizer([text], return_tensors="pt").to(device)

generated_ids = model.generate(model_inputs.input_ids, max_new_tokens=512, do_sample=True)

generated_ids = [output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

Anwendungsfälle

- Evaluierung der Agentenleistung: Verwenden Sie Selene, um die Leistung von AI-Agenten zu evaluieren, Fehler zu verfolgen und sofortige Einblicke zu gewinnen.

- Vertrauensaufbau: Stellen Sie die Zuverlässigkeit Ihrer generativen AI-App sicher, um das Vertrauen Ihrer Kunden zu gewinnen.

- Pre-Production Evals: Verwenden Sie Selene 1 für rigorose Evaluierungen vor der Bereitstellung Ihrer AI-Anwendung.

- Inference-Time Evals: Verwenden Sie Selene 1 Mini für schnelle Evaluierungen während der Inferenz.

Warum ist Selene wichtig?

Da AI-Anwendungen immer weiter verbreitet sind, ist die Gewährleistung ihrer Zuverlässigkeit und Vertrauenswürdigkeit von entscheidender Bedeutung. Selene bietet eine robuste und genaue Möglichkeit zur Evaluierung der AI-Leistung und ermöglicht es Entwicklern, sicherere und zuverlässigere AI-Systeme zu entwickeln. Dies ist besonders wichtig für den Aufbau von Vertrauen bei Kunden, insbesondere bei generativen AI-Anwendungen, bei denen die Ergebnisse unvorhersehbar sein können.

Wo kann ich Selene verwenden?

Sie können Selene mithilfe von Hugging Face Transformers in Ihren AI-Entwicklungs-Workflow integrieren. Außerdem können Sie Agent Evals von Atla erkunden, um Agents zu verbessern und zu verfolgen.

Durch die Bereitstellung von Open-Source-Evaluationsmodellen trägt Atla AI zu einer Zukunft mit sicherer und zuverlässiger AI bei.

Beste Alternativwerkzeuge zu "Selene"

Parea AI ist eine KI-Experimentier- und Annotationsplattform, die Teams dabei unterstützt, LLM-Anwendungen zuverlässig auszuliefern. Sie bietet Funktionen für die Experimentverfolgung, Observability, Human Review und Prompt-Bereitstellung.

ChatOrDie.ai bietet anonymes Chatten mit Top-KI-Modellen wie Grok, ChatGPT, Gemini und Deepseek. Vergleichen Sie Antworten, erkennen Sie Verzerrungen und genießen Sie ungefilterte, private KI-Interaktionen.

UpTrain ist eine Full-Stack-LLMOps-Plattform, die Tools der Enterprise-Klasse zur Bewertung, zum Experimentieren, Überwachen und Testen von LLM-Anwendungen bereitstellt. Hosten Sie in Ihrer eigenen sicheren Cloud-Umgebung und skalieren Sie KI zuverlässig.

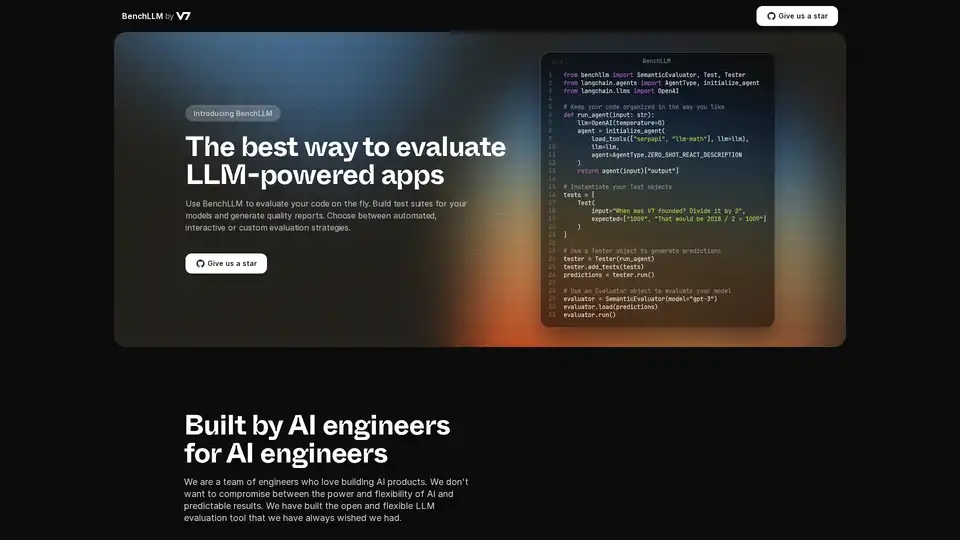

BenchLLM ist ein Open-Source-Tool zur Bewertung von LLM-gestützten Anwendungen. Erstellen Sie Testsuiten, generieren Sie Berichte und überwachen Sie die Modellleistung mit automatisierten, interaktiven oder benutzerdefinierten Strategien.

Coxwave Align ermöglicht modernen Organisationen, Daten aus LLM-basierten konversationellen Produkten einfach zu analysieren und zu bewerten.

Label Studio ist eine flexible Open-Source-Datenkennzeichnungsplattform für die Feinabstimmung von LLMs, die Vorbereitung von Trainingsdaten und die Bewertung von KI-Modellen. Unterstützt verschiedene Datentypen wie Text, Bilder, Audio und Video.

Entdecken und testen Sie mit PromptsLabs eine umfassende Bibliothek von KI-Prompts für neue Large Language Models (LLMs). Verbessern Sie noch heute Ihren LLM-Testprozess!

Bolt Foundry bietet Context-Engineering-Tools, um KI-Verhalten vorhersagbar und testbar zu machen, und hilft Ihnen so, vertrauenswürdige LLM-Produkte zu entwickeln. Testen Sie LLMs wie Sie Code testen.

AI Explorer ist ein umfassendes Verzeichnis von KI-Tools mit über 1000 KI-Tools für verschiedene Anwendungen. Entdecken und finden Sie die besten KI-Lösungen für Produktivität, Kreativität und Innovation.

Erstellen Sie innovative KI-Apps mit der Gemini API unter Verwendung von Gemini 2.0 Flash, 2.5 Pro und Gemma. Erkunden Sie Google AI Studio für die Modellevaluierung und die Entwicklung von Prompts.

Openlayer ist eine KI-Unternehmensplattform, die eine einheitliche KI-Bewertung, Observability und Governance für KI-Systeme von ML bis LLMs bietet. Testen, überwachen und verwalten Sie KI-Systeme während des gesamten KI-Lebenszyklus.

Verdant Forest bietet LLM-gestützte Softwarelösungen für Rapid Prototyping, Videogenerierung und Marketing-Automatisierung. Ermöglicht kostengünstige Innovation.

Peppy Pick revolutioniert die Einstellung mit KI-gestützten Interviews. Optimieren Sie die Einstellung, finden Sie mühelos Top-Talente. Datengesteuerte Einblicke für intelligentere Einstellungen.

EvalsOne: Plattform zur iterativen Entwicklung und Perfektionierung generativer KI-Anwendungen, zur Rationalisierung des LLMOps-Workflows für Wettbewerbsvorteile.