Bolt Foundry

Übersicht von Bolt Foundry

Bolt Foundry: Jedes Mal funktionierende KI ausliefern

Was ist Bolt Foundry? Bolt Foundry ist eine Plattform, die entwickelt wurde, um Entwicklern beim Erstellen und Ausliefern zuverlässiger KI-Anwendungen zu helfen, indem sie Tools für das Context Engineering bereitstellt, die das KI-Verhalten vorhersehbar und testbar machen. Sie ermöglicht es Ihnen, LLMs wie Code zu testen und sicherzustellen, dass Ihre KI-Produkte vertrauenswürdig sind und wie erwartet funktionieren.

Hauptmerkmale und Vorteile:

- Vorhersehbares KI-Verhalten: Tools zum Entwickeln des Kontexts und Sicherstellen konsistenter KI-Antworten.

- Testbare LLMs: LLMs evaluieren und validieren, um Qualität und Zuverlässigkeit zu gewährleisten.

- Vertrauenswürdige KI-Produkte: Bauen Sie Vertrauen in Ihre KI-Anwendungen mit robusten Tests auf.

Wie funktioniert Bolt Foundry?

Bolt Foundry konzentriert sich auf das Testen von Large Language Models (LLMs), um deren Zuverlässigkeit und Vorhersagbarkeit sicherzustellen. So funktioniert es:

- Testfälle definieren: Erstellen Sie spezifische Szenarien, um das Verhalten Ihres LLM zu testen.

- LLM-Antworten bewerten: Verwenden Sie Bolt Foundry, um zu beurteilen, wie Ihr LLM im Vergleich zu diesen Testfällen abschneidet.

- Iterieren und verbessern: Verfeinern Sie Ihr LLM und Ihre Prompts basierend auf den Bewertungsergebnissen.

Warum ist Bolt Foundry wichtig?

Im sich schnell entwickelnden Bereich der KI ist die Gewährleistung der Zuverlässigkeit von LLMs von entscheidender Bedeutung. Bolt Foundry adressiert dieses Bedürfnis, indem es Tools bereitstellt, die es Entwicklern ermöglichen:

- Risiken mindern: Identifizieren und beheben Sie potenzielle Probleme vor der Bereitstellung.

- Leistung verbessern: LLMs kontinuierlich verfeinern, um die Genauigkeit und Konsistenz zu verbessern.

- Vertrauen aufbauen: Erstellen Sie KI-Anwendungen, auf die sich Benutzer verlassen können.

Was die Leute sagen

Hier ist, was Benutzer über Bolt Foundry sagen:

- Joseph Ferro, Head of Product, Velvet: "Das ändert völlig, wie wir über die LLM-Entwicklung denken."

- Daohao Li, Founder, Munch Insights: "Ich habe mich nach einem Evals-Produkt umgesehen, aber nichts davon hat mich überzeugt, und niemand ist so schnell wie ihr."

- Austen Allred, Founder, Gauntlet AI: "Sehr, sehr cool"

- Amjad Masad, CEO, Replit: "Super elegantes Open-Source-Eval-Tool!"

Wo kann ich Bolt Foundry verwenden?

Bolt Foundry kann in verschiedenen Szenarien eingesetzt werden, in denen zuverlässige KI unerlässlich ist, einschließlich:

- KI-Produktentwicklung: Sicherstellung der Qualität von KI-gestützten Funktionen.

- LLM-Evaluierung: Validierung der Leistung von Sprachmodellen.

- Context Engineering: Verbesserung der Konsistenz von KI-Antworten.

Durch die Verwendung von Bolt Foundry können Entwickler KI-Anwendungen mit größerem Vertrauen erstellen und ausliefern, da sie wissen, dass ihre LLMs gründlich getestet und bewertet wurden.

Beste Alternativwerkzeuge zu "Bolt Foundry"

Vivgrid ist eine KI-Agenten-Infrastrukturplattform, die Entwicklern hilft, KI-Agenten mit Sicherheitsvorkehrungen und Inferenz mit niedriger Latenz zu erstellen, zu beobachten, zu bewerten und bereitzustellen. Es unterstützt GPT-5, Gemini 2.5 Pro und DeepSeek-V3.

Freeplay ist eine KI-Plattform, die Teams bei der Entwicklung, dem Testen und der Verbesserung von KI-Produkten durch Prompt-Management, Evaluierungen, Observability und Datenprüfungsworkflows unterstützt. Sie optimiert die KI-Entwicklung und gewährleistet eine hohe Produktqualität.

UpTrain ist eine Full-Stack-LLMOps-Plattform, die Tools der Enterprise-Klasse zur Bewertung, zum Experimentieren, Überwachen und Testen von LLM-Anwendungen bereitstellt. Hosten Sie in Ihrer eigenen sicheren Cloud-Umgebung und skalieren Sie KI zuverlässig.

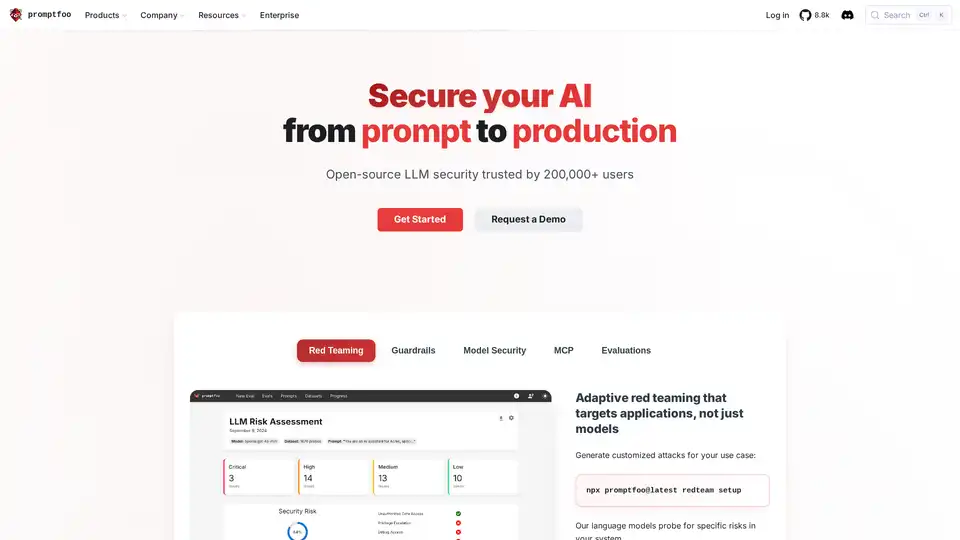

Promptfoo ist ein Open-Source-LLM-Sicherheitstool, das von über 200.000 Entwicklern für AI Red-Teaming und Bewertungen verwendet wird. Es hilft, Schwachstellen zu finden, die Ausgabequalität zu maximieren und Regressionen in KI-Anwendungen abzufangen.

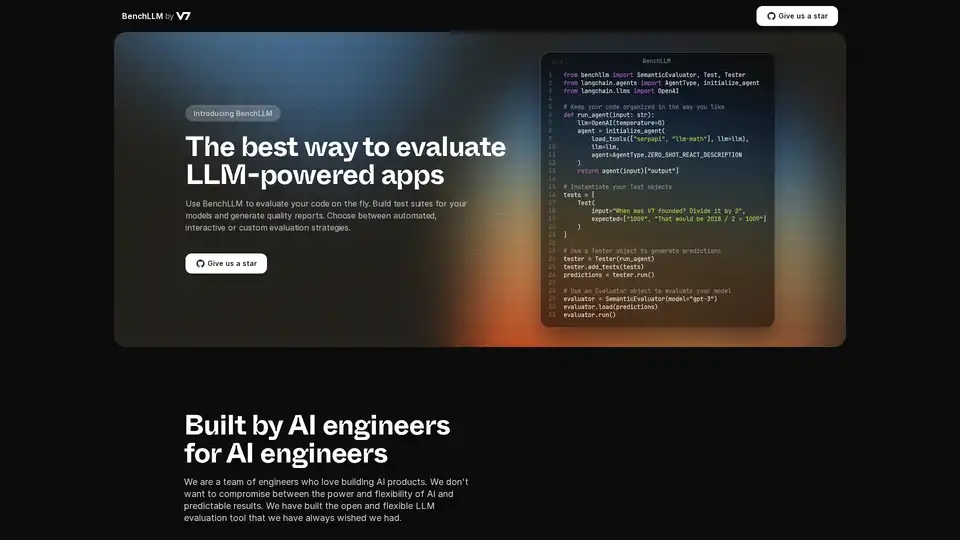

BenchLLM ist ein Open-Source-Tool zur Bewertung von LLM-gestützten Anwendungen. Erstellen Sie Testsuiten, generieren Sie Berichte und überwachen Sie die Modellleistung mit automatisierten, interaktiven oder benutzerdefinierten Strategien.

Maxim AI ist eine End-to-End-Bewertungs- und Observability-Plattform, die Teams dabei unterstützt, KI-Agenten zuverlässig und 5-mal schneller bereitzustellen, mit umfassenden Test-, Überwachungs- und Qualitätssicherungswerkzeugen.

Future AGI ist eine einheitliche LLM-Observability- und KI-Agenten-Evaluierungsplattform, die Unternehmen dabei hilft, durch umfassende Test-, Evaluierungs- und Optimierungswerkzeuge 99% Genauigkeit in KI-Anwendungen zu erreichen.

Athina ist eine kollaborative AI-Plattform, die Teams dabei hilft, LLM-basierte Funktionen 10-mal schneller zu entwickeln, zu testen und zu überwachen. Mit Tools für Prompt-Management, Evaluierungen und Observability gewährleistet sie Datenschutz und unterstützt benutzerdefinierte Modelle.

Openlayer ist eine KI-Unternehmensplattform, die eine einheitliche KI-Bewertung, Observability und Governance für KI-Systeme von ML bis LLMs bietet. Testen, überwachen und verwalten Sie KI-Systeme während des gesamten KI-Lebenszyklus.

Trainieren, verwalten und evaluieren Sie benutzerdefinierte große Sprachmodelle (LLMs) schnell und effizient auf Entry Point AI, ohne dass Code erforderlich ist.

Confident AI: DeepEval LLM-Evaluierungsplattform zum Testen, Benchmarking und zur Verbesserung der Leistung von LLM-Anwendungen.

LangWatch ist eine Plattform für KI-Agenten-Tests, LLM-Evaluierung und LLM-Observability. Testen Sie Agenten, verhindern Sie Regressionen und beheben Sie Probleme.

PromptLayer ist eine KI-Engineering-Plattform für Prompt-Management, -Bewertung und LLM-Observability. Arbeiten Sie mit Experten zusammen, überwachen Sie KI-Agenten und verbessern Sie die Prompt-Qualität mit leistungsstarken Tools.

Future AGI bietet eine einheitliche LLM Observability- und KI-Agenten-Evaluierungsplattform für KI-Anwendungen, die Genauigkeit und verantwortungsvolle KI von der Entwicklung bis zur Produktion gewährleistet.